一 Ollama

1.1 简介

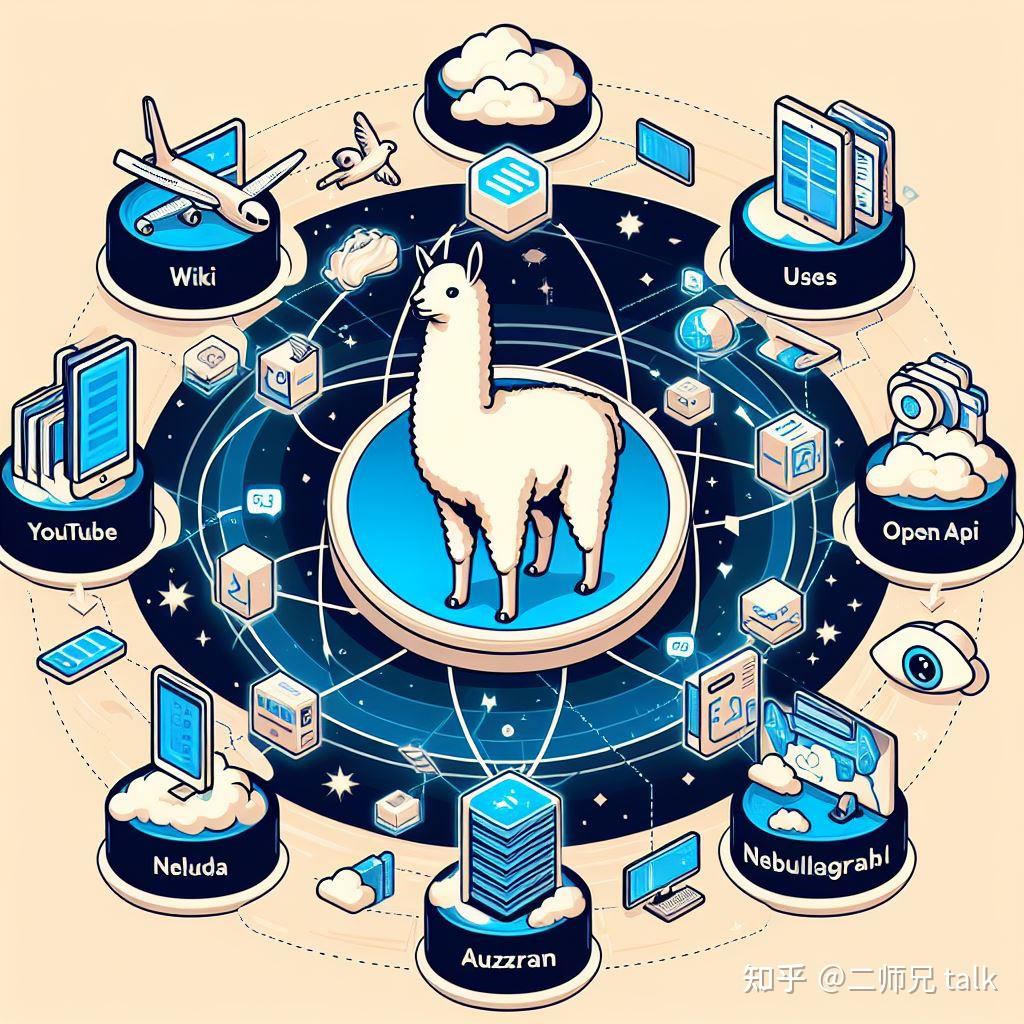

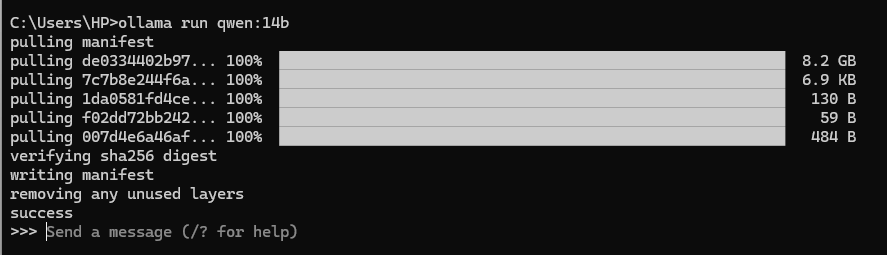

Ollama是一个开源的大型语言模型服务工具,它帮助用户快速在本地运行大模型。通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型语言模型,如Llama 2。Ollama极大地简化了在Docker容器内部署和管理LLM的过程,使得用户能够快速地在本地运行大型语言模型。

关于 Ollama 的详细介绍和安装使用请参考如下文章:

- 打造个性化聊天机器人:用Ollama和Open WebUI搭建你的私有ChatGPT!

- windows 下 docker compose 安装 ollama 和 open-webui ,打造私有GPT

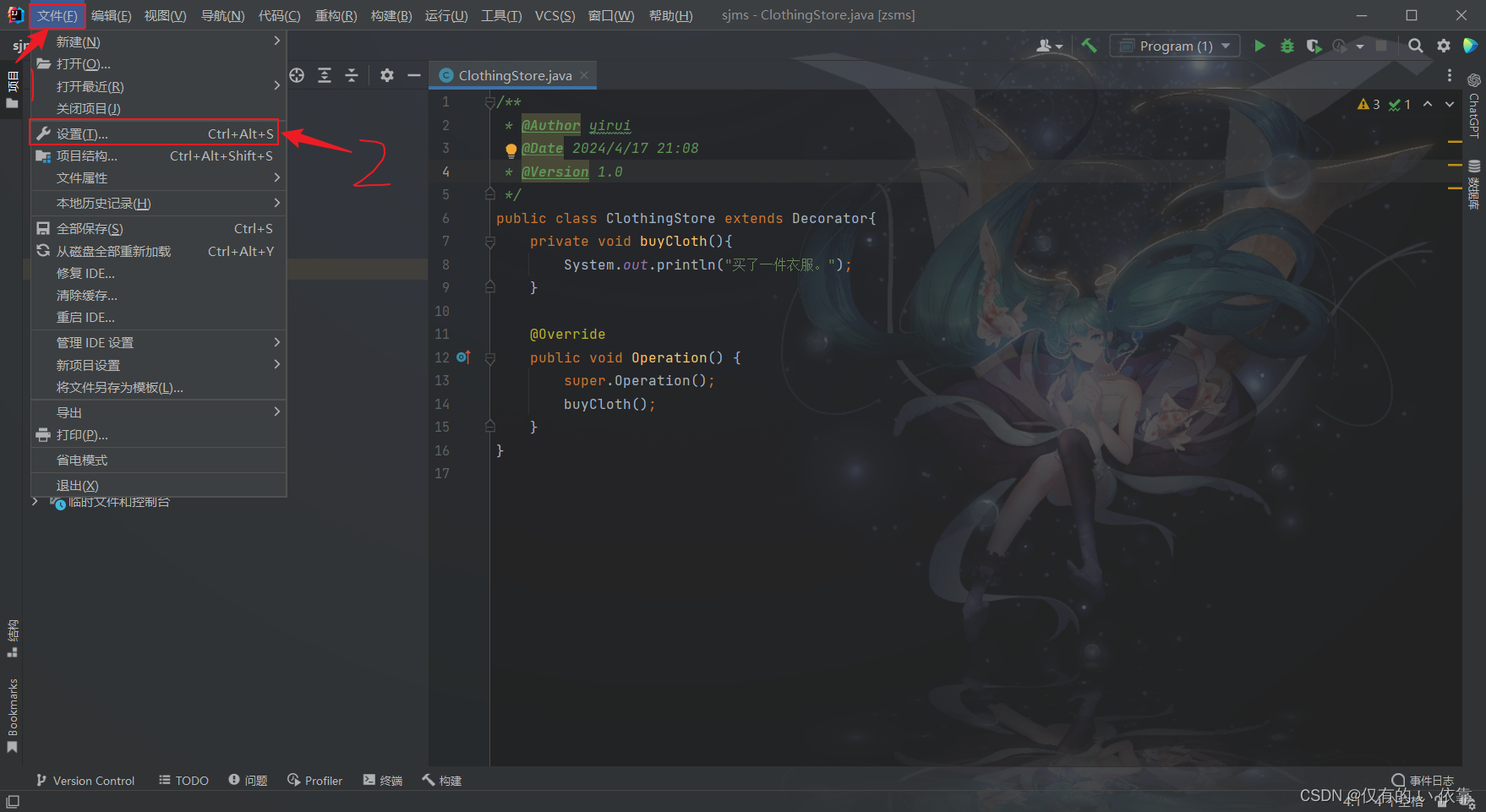

1.2 打开ollama端口

Ollama其实有两种模式:

- 聊天模式

- 服务器模式

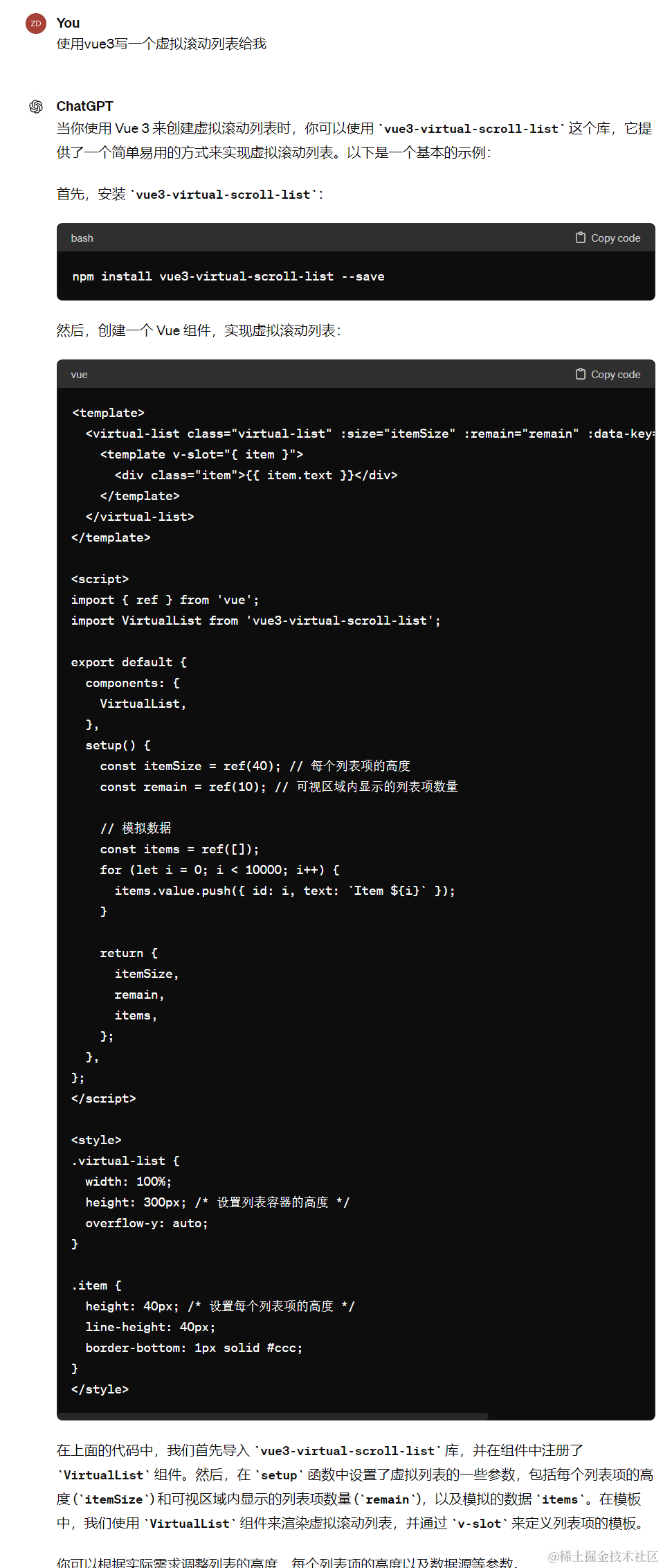

这里使用服务器模式,Ollama在后端运行大模型,开发IP和端口给外部软件使用。

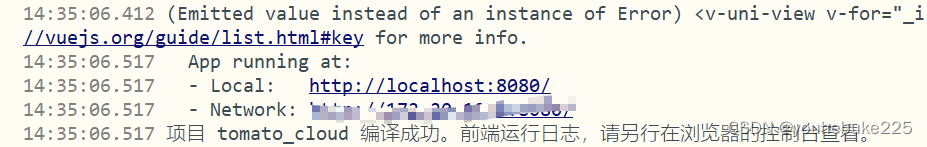

下载AnythingLLM之后开始进入启动的配置阶段,开始之前请确保 ollama serve 运行,或者终端执行 ollama run xxx(任何一个模型)。

通过终端或者命令行,访问 http://127.0.0.1:11434 进行验证: