在人工智能快速发展的今天,大型深度学习模型已成为自然语言处理领域的核心力量。然而,随着这些模型规模的不断扩大和功能的日益增强,一种被称为“说胡话”的现象也愈发引人关注。这种现象不仅影响了模型在实际应用中的效果,也引发了人们对人工智能技术发展路径的深入思考。

【PS:友情链接【新】升级ChatGPT4.0失败的解决方案-CSDN博客】

当我们谈论大型语言模型“说胡话”的时候,我们通常是指这些模型在没有准确理解上下文的情况下生成的不合逻辑、不相关或者完全错误的信息。这种现象可能由几个因素造成:

1. 数据源问题:大型语言模型的训练数据来源于互联网上的海量文本,其中包含了各种质量的内容。如果训练数据包含大量不准确、误导性或有偏见的信息,模型就可能学会并复制这些问题。

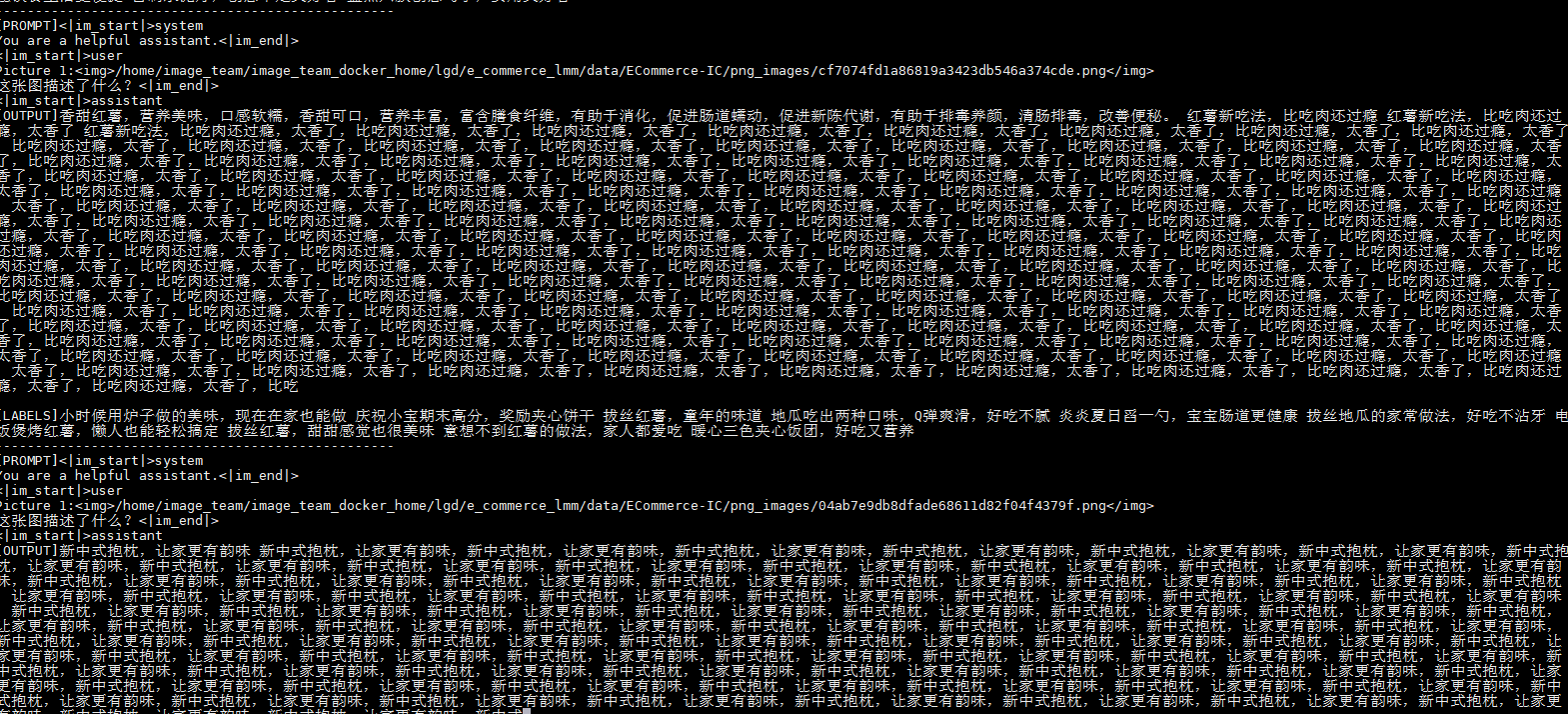

2. 上下文理解不足:尽管大型语言模型在处理单个句子时可能表现得相当出色,但它们往往难以理解和处理长篇幅的连贯文本。这可能导致模型无法正确把握上下文信息,从而产生不相关的输出。

3. 泛化能力有限:当前的大型语言模型可能在特定任务上表现出高水平的性能,但在面对新颖或复杂的情境时,它们的泛化能力仍然有限。这意味着模型可能无法适应新的输入类型,从而导致错误的响应。

4. 参数估计误差:大型语言模型涉及数十亿乃至数万亿的参数,对这些参数的精确估计是一个巨大的挑战。任何微小的误差都可能导致输出的巨大偏差。

5. 训练方法局限:目前主流的训练方法,如梯度下降等,虽然有效,但并非完美。这些方法可能无法确保模型在所有可能的输入上都达到最优性能。

6. 过拟合风险:随着模型规模的扩大,过拟合的风险也在增加。模型可能会过于依赖训练数据中的特定模式,而不是学习到更通用的规律。

7. 评估标准不全面:当前的模型评估通常侧重于特定的性能指标,可能无法全面反映模型在各种实际应用场景中的表现。

8. 缺乏常识推理:大型语言模型尚未能有效整合和使用常识知识进行推理,这限制了它们在面对需要此类知识的任务时的表现。

9. 反馈循环问题:模型的输出可能被用作进一步训练的数据,如果初始的输出存在问题,那么这些问题可能会被放大并在未来的模型迭代中持续存在。

【PS:友情链接【新】升级ChatGPT4.0失败的解决方案-CSDN博客】

大型语言模型“说胡话”的现象是多因素导致的复杂问题,涉及到数据质量、算法设计、模型评估以及常识推理等多个层面。解决这一问题需要跨学科的研究和创新,包括改进训练数据筛选机制、开发更为高效的训练算法、制定更加全面的模型评估标准,以及探索如何使模型更好地利用常识知识进行推理。

【PS:友情链接【新】升级ChatGPT4.0失败的解决方案-CSDN博客】

我们辩证地看待这一现象,我们既要认识到大模型在语言处理方面的巨大进步,也要看到其存在的局限性和不足。大型深度学习模型在捕捉语言的复杂性和多样性方面有着得天独厚的优势,它们能够处理海量数据,学习语言的细微差别和潜在规律。然而,这种优势也带来了挑战。由于模型的复杂性和不可解释性,我们很难完全理解模型是如何做出决策的,也就难以避免“说胡话”这类问题的出现。

【PS:友情链接【新】升级ChatGPT4.0失败的解决方案-CSDN博客】

要解决大模型“说胡话”的问题,我们需要从多个方面入手。首先,加强数据预处理和质量控制,确保训练数据的准确性和多样性。通过更精细化的数据标注和筛选,减少模型在训练过程中可能遇到的歧义和噪声。其次,优化模型的训练目标和损失函数,使其更加符合实际应用的需求。通过引入更多的约束条件和正则化项,减少模型过拟合和“说胡话”的风险。此外,加强模型的可解释性研究,探索模型内部的工作机制和决策过程,有助于我们更好地理解和控制模型的行为。

【PS:友情链接【新】升级ChatGPT4.0失败的解决方案-CSDN博客】

除了技术层面的改进,我们还需要从更宏观的角度审视人工智能技术的发展。人工智能技术的发展应该遵循人类社会的价值观和伦理规范,确保其在实际应用中不会对人类造成负面影响。同时,我们也应该认识到人工智能技术的局限性和不足,避免过度依赖和滥用这些技术。

综上所述,大模型“说胡话”的现象是人工智能技术发展过程中的一个挑战,也是我们需要深入研究和解决的问题。通过加强技术研究、优化数据处理、提升模型可解释性等多方面的努力,我们可以逐步克服这一难题,推动人工智能技术在自然语言处理领域的进一步发展。同时,我们也需要保持对技术的清醒认识和审慎态度,确保人工智能技术的发展能够为人类社会带来真正的福祉。

在未来的研究中,我们可以进一步探索如何结合人类的语言学知识和机器学习的算法优势,共同构建更加智能、可靠的自然语言处理系统。例如,通过引入语言学规则和先验知识来约束模型的输出,或者通过人机交互的方式让模型在实际应用中不断学习和优化。这些尝试有望为大模型的“说胡话”问题提供新的解决方案,并推动自然语言处理技术的持续进步。

此外,我们还需要关注大模型在其他领域的应用和挑战。随着技术的不断发展,大型深度学习模型将在更多领域发挥重要作用,如图像识别、语音识别、推荐系统等。在这些领域中,我们也可能会遇到类似“说胡话”的问题,因此需要借鉴自然语言处理领域的经验和教训,提前预防和解决可能出现的问题。

【PS:友情链接【新】升级ChatGPT4.0失败的解决方案-CSDN博客】

总之,大模型“说胡话”现象虽然是一个挑战,但也为我们提供了深入研究和改进的机会。通过不断地探索和实践,我们有信心克服这一难题,推动人工智能技术在各个领域的广泛应用和深入发展。在这个过程中,我们也需要保持对技术的敬畏之心,确保技术的发展始终符合人类的价值观和利益。