Apache Spark是一个开源的大数据处理框架,它提供了一种高效、可扩展的方式来处理大规模数据集。Spark的设计目标是为了提高大数据处理的速度和灵活性。

Spark的基本概念包括以下几个方面:

RDD(弹性分布式数据集):RDD是Spark的核心数据结构,它是一个可并行操作的、可变的、容错的分布式集合。RDD可以从存储系统(如Hadoop文件系统、HBase等)中创建,并且可以被分区和并行操作。

转换操作:Spark提供了丰富的转换操作,如map、filter、reduce等,用于对RDD进行转换和操作。这些操作可以将一个RDD转换为另一个RDD,并且可以链式地进行组合。

行动操作:行动操作是Spark中用于触发计算的操作,它会对RDD进行计算并返回结果。常见的行动操作包括count、collect、reduce等。

Spark SQL:Spark SQL是Spark的模块之一,它提供了一种用于处理结构化数据的接口。Spark SQL支持使用SQL查询、DataFrame和Datasets等方式来处理数据,可以方便地与Spark的其他组件集成。

在大数据分析中,Spark具有以下应用:

批处理:Spark可以处理大规模的数据集,并且可以高效地执行复杂的数据转换和计算操作。它提供了丰富的转换和行动操作,可以方便地进行数据清洗、聚合、过滤等操作。

流处理:Spark提供了流处理模块Spark Streaming,可以实时地处理数据流。它支持常见的流处理操作,如窗口计算、累加器、状态管理等,可以用于实时监控、实时报警等场景。

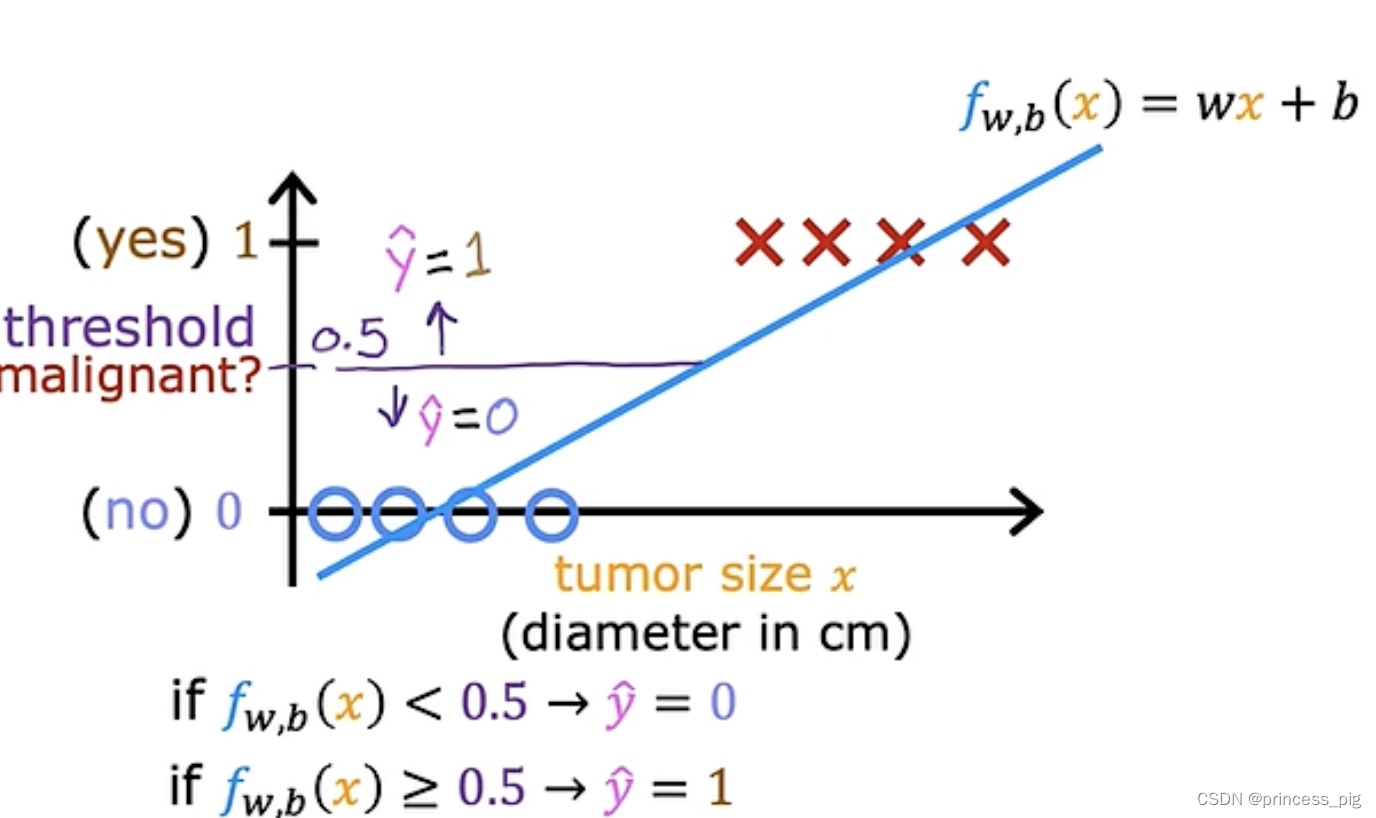

机器学习:Spark提供了机器学习库MLlib,可以进行大规模的机器学习和数据挖掘任务。MLlib支持常见的机器学习算法和特征工程操作,并且可以与其他Spark组件无缝集成。

图计算:Spark提供了图计算库GraphX,可以进行大规模的图计算。GraphX支持图操作和图算法,如图遍历、连通性分析、PageRank等,可以用于社交网络分析、网络流量分析等场景。

总结来说,Apache Spark是一个功能强大、可扩展的大数据处理框架,在大数据分析中有广泛的应用。它支持批处理、流处理、机器学习和图计算等多种场景,并且提供了丰富的API和库来简化大数据处理的复杂性。

![[Angular 基础] - routing 路由(下)](https://img-blog.csdnimg.cn/direct/bc5f89dee8f44b1d9b36faef464ab99b.png)