U-Net: Convolutional Networks for Biomedical Image Segmentation

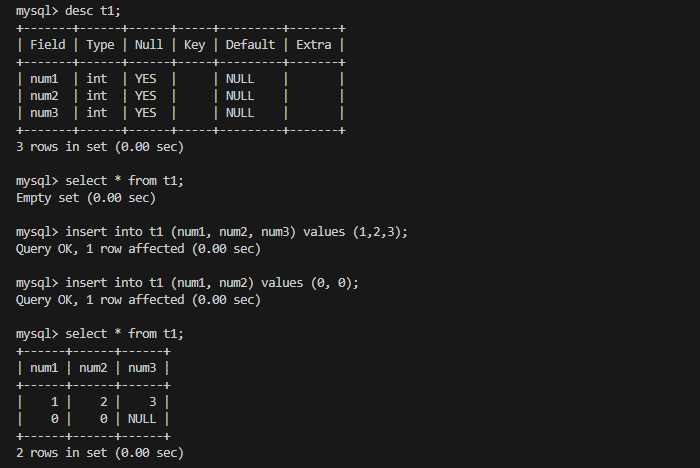

资料

1.代码地址

2.论文地址

https://arxiv.org/pdf/1505.04597

3.数据集地址

论文摘要的翻译

人们普遍认为,深度网络的成功训练需要数千个带注释的训练样本。在本文中,我们提出了一种网络和训练策略,该策略依赖于数据增强的强大使用,以更有效地使用可用的注释样本。该体系结构包括捕获上下文的收缩路径和支持精确定位的对称扩展路径。我们表明,这样的网络可以从很少的图像中进行端到端训练,并且在ISBI挑战中优于先前的最佳方法(滑动窗口卷积网络),以分割电子显微镜堆栈中的神经元结构。使用在透射光显微镜图像(相位对比和DIC)上训练的相同网络,我们在这些类别中以很大的优势赢得了2015年ISBI细胞跟踪挑战赛。此外,网络速度很快。在最新的GPU上,512x512图像的分割需要不到一秒的时间。

1背景

卷积网络的典型用途是分类任务,其中图像的输出是单个类标签。然而,在许多视觉任务中,特别是在生物医学图像处理中,期望的输出应该包括定位,即,应该为每个像素分配一个类标签。此外,成千上万的训练图像在生物医学任务中通常是遥不可及的。

因此,Ciresan等人。==在滑动窗口设置中训练网络,通过在像素输入周围提供局部区域(patch)来预测每个像素的类标签。==首先,这个网络可以本地化。其次,以patch为单位的训练数据量远大于训练图像的数量。

较大的patch需要更多的最大池化层,这会降低定位精度,而较小的patch只允许网络看到很少的上下文。

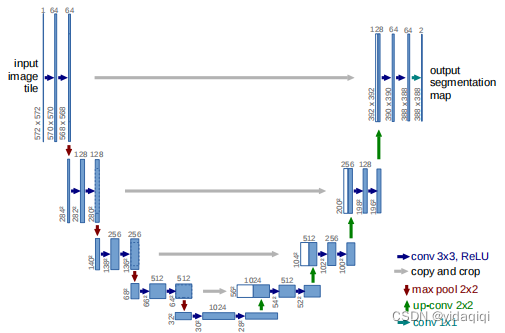

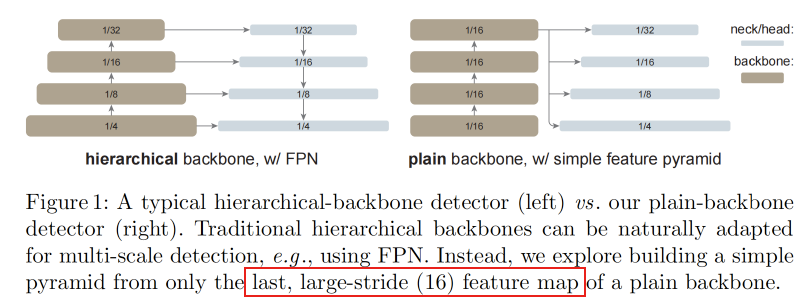

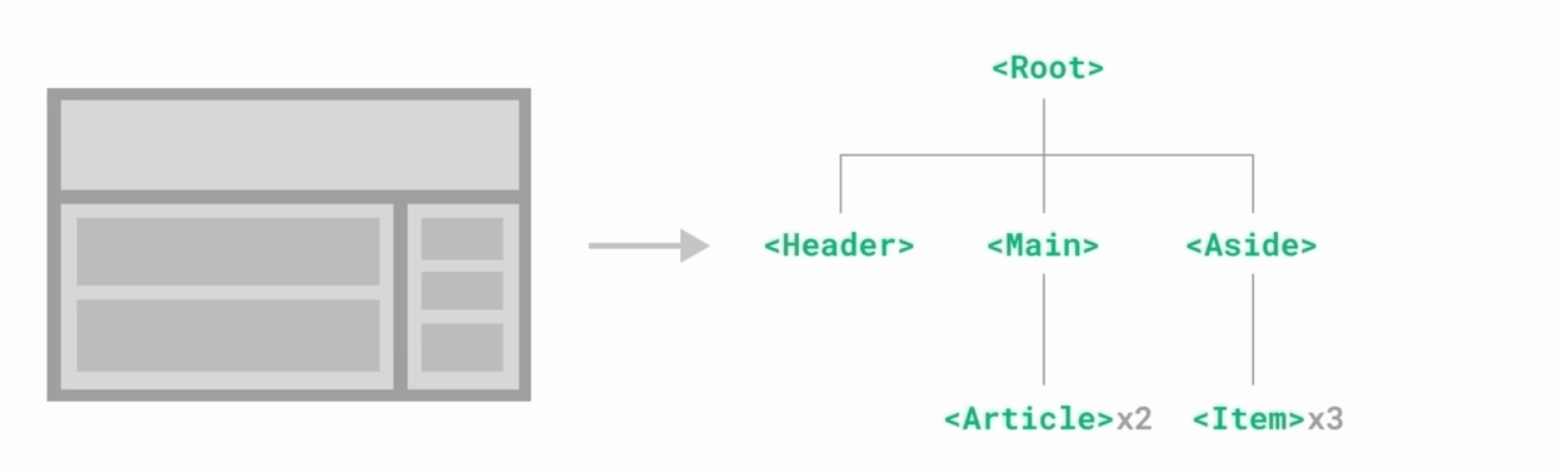

在本文中,在本文中,我们构建了一个更优雅的架构,即所谓的“全卷积网络”。我们修改和扩展了这种架构,使其适用于很少的训练图像,并产生更精确的分割;具体架构看图1

中的主要思想是通过连续的层来补充通常的收缩网络,其中池化算子被上采样算子取代。因此,这些层增加了输出的分辨率。为了定位,从收缩路径的高分辨率特征与上采样输出相结合。然后,连续的卷积层可以根据这些信息学习组装更精确的输出。

我们架构中的一个重要修改是,在上采样部分,我们也有大量的特征通道,这允许网络将上下文信息传播到更高分辨率的层。因此,扩张路径或多或少与收缩路径对称,并产生u形建筑。网络没有任何完全连接的层,只使用每个卷积的有效部分,即分割映射只包含像素,在输入图像中可以获得完整的上下文。

该策略允许通过重叠贴图策略对任意大的图像进行无缝分割(见图2)。为了预测图像边界区域的像素,通过镜像输入图像来推断缺失的上下文。这种平铺策略对于将网络应用于大型图像非常重要,因为否则分辨率将受到GPU内存的限制。

对于我们的任务,可用的训练数据很少,我们通过对可用的训练图像应用弹性变形来使用过度的数据增强。这允许网络学习这种变形的不变性,而不需要在注释的图像语料库中看到这些转换。

在许多细胞分割任务中的另一个挑战是同一类触摸物体的分离;参见图3。为此,我们建议使用加权损失,其中触摸单元之间的分离背景标签在损失函数中获得较大的权重。

2论文的创新点

- 我们构建了一个全卷积神经网络架构我们修改和扩展了这种架构,使其适用于很少的训练图像,并产生更精确的分割;

3 论文方法的概述

3.1 网络架构

网络体系结构如图1所示。

- 收缩路径(左侧)

两个3x3卷积(不填充)的重复应用组成,每个卷积后面都有一个整流线性单元(ReLU)和一个2x2 max池化操作,步幅为2,用于下采样。每一次下采样我们将特征通道的数量加倍。下采样结构图如下。

扩张路径(右侧)

特征映射的上采样,然后进行2x2卷积(“上卷积”),将特征通道的数量减半,与收缩路径中相应裁剪的特征映射进行连接,以及两个3x3卷积,每个卷积后面都有一个ReLU。扩张路径结构图如下。

在最后一层,使用1x1卷积将每个64个组件的特征向量映射到所需的类数量。这个网络总共有23个卷积层。

3.2 训练

输入图像及其相应的分割图用于使用随机梯度下降实现来训练网络,由于没有填充卷积,输出图像比输入图像小一个恒定的边界宽度。为了最小化开销并最大限度地利用GPU内存,我们倾向于使用较大的批处理大小,从而将批处理减少到单个图像。因此,我们使用高动量(momentum=0.99),使得大量之前看到的训练样本决定当前优化步骤中的更新。

energy function 是通过结合交叉熵损失函数在最终特征映射上的逐像素softmax来计算的。softmax函数: p k ( x ) = exp ( a k ( x ) ) / ( ∑ k ′ = 1 K exp ( a k ′ ( x ) ) ) p_{k}(\mathbf{x})=\exp(a_{k}(\mathbf{x}))/\left(\sum_{k^{\prime}=1}^{K}\exp(a_{k^{\prime}}(\mathbf{x}))\right) pk(x)=exp(ak(x))/(∑k′=1Kexp(ak′(x))) 其中 a k ( x ) a_{k}(\mathbf{x}) ak(x) 表示 x ∈ Ω \mathbf{x}\in\Omega x∈Ω 在 通道 k k k中的激活 Ω ⊂ Z 2 . K \Omega\subset\mathbb{Z}^2.K Ω⊂Z2.K表示类的数量and p k ( x ) p_k(\mathbf{x}) pk(x) 是最大似然函数。

当最大激活时的 k k k时 p k ( x ) ≈ 1 p_{k}(\mathbf{x})\approx1 pk(x)≈1

其他k时 a k ( x ) a_k(\mathbf{x}) ak(x) and p k ( x ) ≈ 0 p_k(\mathbf{x})\approx0 pk(x)≈0

我们预先计算每个地面真值分割的权重图,以补偿训练数据集中某类像素的不同频率,并迫使网络学习我们在触摸单元之间引入的小分离边界(见图3c和d)

使用形态学操作计算分离边界。然后,权重映射计算为 w ( x ) = w c ( x ) + w 0 ⋅ exp ( − ( d 1 ( x ) + d 2 ( x ) ) 2 2 σ 2 ) w(\mathbf{x})=w_c(\mathbf{x})+w_0\cdot\exp\left(-\frac{(d_1(\mathbf{x})+d_2(\mathbf{x}))^2}{2\sigma^2}\right) w(x)=wc(x)+w0⋅exp(−2σ2(d1(x)+d2(x))2)其中 w c : Ω → R w_c:\Omega\to\mathbb{R} wc:Ω→R 为平衡类频率的权值图, d 1 : Ω → R d_1:\Omega\to\mathbb{R} d1:Ω→R为到最近单元格边界的距离, d 2 : Ω → R d_2:\Omega\to\mathbb{R} d2:Ω→R 为到第二最近单元格边界的距离。在我们的实验中,我们设置 w 0 = 10 w_0=10 w0=10, σ ≈ 5 \sigma\approx5 σ≈5 .像素。

3.3 数据增强

当只有很少的训练样本可用时,数据增强对于教会网络所需的不变性和鲁棒性是必不可少的。

移位和旋转不变性以及对变形灰度值变化的鲁棒性。特别是训练样本的随机弹性变形似乎是训练具有很少注释图像的分割网络的关键概念。我们在粗糙的3 × 3网格上使用随机位移向量生成平滑变形。位移从具有10个像素标准差的高斯分布中采样。然后使用双三次插值计算逐像素位移。收缩路径末端的退出层执行进一步的隐式数据扩充。

4 论文实验

我们演示了u-net在三种不同的分割任务中的应用。第一个任务是在电子显微镜记录中对神经元结构进行分割。图2显示了数据集和我们获得的分割的示例。我们提供完整的结果作为补充材料

该数据集由EM分割挑战提供,该挑战始于ISBI 2012,并且仍然对新的贡献开放。训练数据是一组30张(512x512像素)的果蝇一龄幼虫腹侧神经索(VNC)连续切片透射电镜图像。每张图像都带有相应的完整注释的细胞(白色)和膜(黑色)的地面真值分割图。测试集是公开可用的,但其分割映射是保密的。通过将预测的膜概率图发送给组织者,可以获得评估结果。评估是通过对10个不同级别的地图进行阈值化,并计算“warping error”、“Rand error”和“pixel error”来完成的。

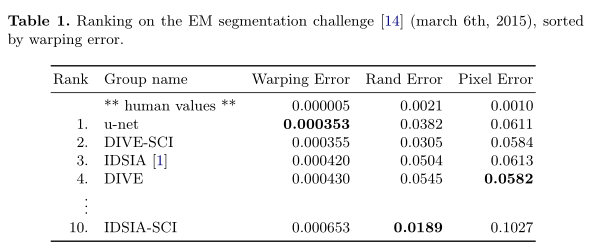

u-net(输入数据的7个旋转版本的平均值)在没有任何进一步的预处理或后处理的情况下实现了0.0003529的翘曲误差(新的最佳分数,见表1)和0.0382的随机误差。

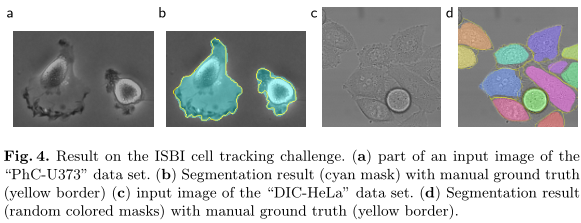

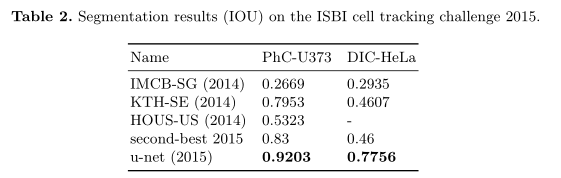

我们还将u-net应用于光显微图像的细胞分割任务。该分割任务是2014年和2015年ISBI细胞跟踪挑战的一部分。第一个数据集“PhC-U373”2包含聚丙烯酰亚胺底物上的胶质母细胞瘤-星形细胞瘤U373细胞,通过相差显微镜记录(见图4a,b和Supp. Material)。它包含35个部分注释的训练图像。在这里,我们实现了92%的平均IOU(“交集/联合”),明显优于第二优算法的83%(见表2)。第二个数据集“DIC-HeLa”3是通过差干涉对比(DIC)显微镜记录的平板玻璃上的HeLa细胞(见图3、图4c、d和Supp. Material)。它包含20个部分注释的训练图像。在这里,我们实现了77.5%的平均IOU,这明显好于第二好的算法(46%)。

5论文内一些重要的图

- 可以和一些实验、方法进行呼应,帮助你以后快速回忆起这篇论文内容核心。

- 你的论文方法概述也可以围绕这个图讲