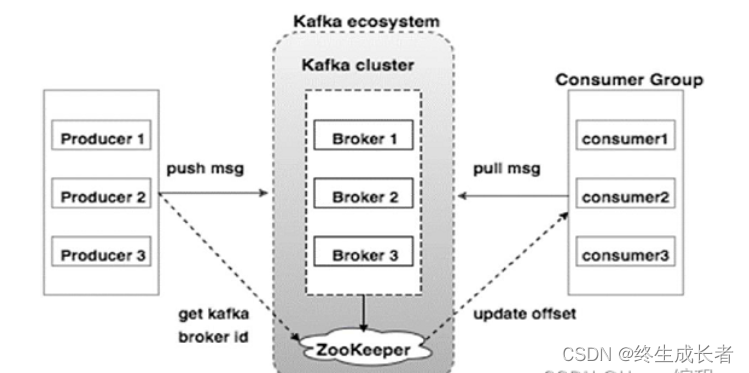

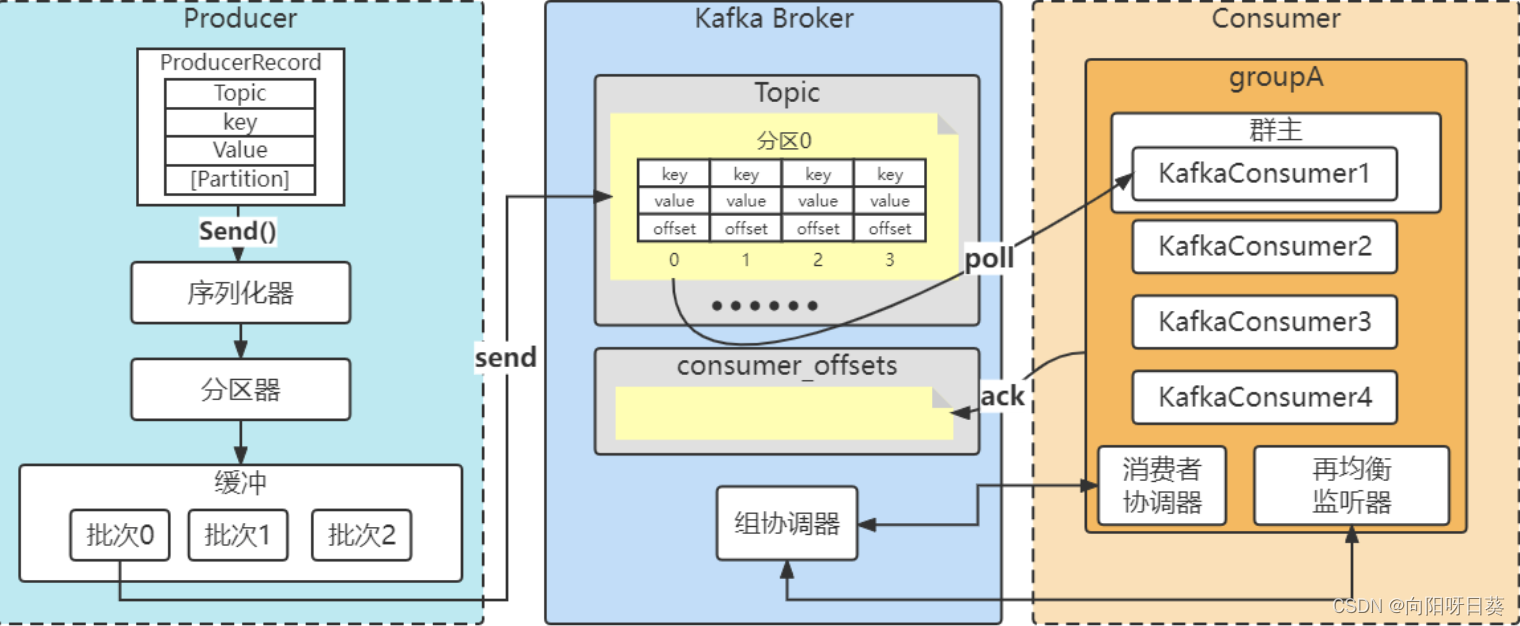

1. kafka的消费者是pull(拉)还是push(推)模式,这种模式有什么好处?

Kafka的消费者是pull(拉)模式。在这种模式下,消费者主动从Kafka的broker中拉取数据来进行消费。

这种pull模式的好处主要体现在以下几个方面:

- 消费者自主控制消费速度:消费者可以根据自己的处理能力,自行决定拉取数据的频率和数量。如果消费者的处理能力较强,可以频繁地拉取数据;如果处理能力较弱,则可以降低拉取数据的频率。这避免了在push模式下,因消费者处理速度慢而导致的消息堆积和可能的消息丢失问题。

- 更好的负载均衡:在pull模式下,Kafka的broker不会主动向消费者推送数据,而是由消费者主动从broker中拉取。这使得消费者可以根据自己的需求和处理能力,从多个partition中拉取数据,实现更好的负载均衡。

- 对消费者端故障容错性更好:在push模式下,如果消费者端发生故障,可能会导致消息的丢失。而在pull模式下,即使消费者端发生故障,只要它能在恢复后继续从broker中拉取数据,就不会丢失已经存储在broker中的消息。

- 更好的消息控制:消费者可以明确地知道自己消费到了哪一条消息,从而可以更加精确地控制消息的消费进度。

总的来说,Kafka的pull模式使得消费者能够更好地控制消费速度,实现更好的负载均衡,以及对消费者端故障具有更好的容错性。同时,它也使得消费者能够更精确地控制消息的消费进度。

2. 简述Kafka 的网络设计模式 ?

Kafka的网络设计模式主要基于Reactor设计模式,这是一种根据不同的网络事件将后台线程划分为不同角色的模型。在Kafka中,这种模式被用来实现高效的网络通信。

具体来说,Kafka的网络通信框架中,线程被划分为不同的角色,例如负责处理OP_ACCEPT事件的acceptor线程,以及负责处理OP_READ/OP_WRITE这种网络读写事件的processor线程。这种划分使得Kafka能够并行处理大量的网络请求,提高了系统的吞吐量和响应速度。

此外,Kafka还采用了结构化的消息设计,如XML或JSON格式,并提供了多种传输协议设计,如AMQP、WebService + SOAP/MSMQ,以及广义的RPC框架如PB、Dubbo等。这些设计使得Kafka能够灵活地适应不同的应用场景和数据模型。

在网络通信方面,Kafka支持两种消息队列模型:点对点模型和发布/订阅模型。点对点模型中,生产者将消息发送到指定队列,消费者从指定队列获取消息。而在发布/订阅模型中,消费者被动地接受消息,或者主动获取消息,每条消息可由多个消费者消费,实现消息复用。

综上所述,Kafka的网络设计模式是一个高度可扩展和灵活的架构,能够支持大规模的数据处理和实时数据流处理,适用于各种场景,如日志收集、在线分析、广告引擎以及电商中的实时推荐等。

3. 简述Kafka保留日志策略 ?

Kafka的保留日志策略主要涉及如何管理和控制Kafka中存储的消息数据的生命周期。其核心目标在于确保系统能够根据需要保留足够的消息数据,以支持诸如数据分析、历史数据查询等应用,同时又要避免因为存储过多的数据而导致的磁盘空间耗尽问题。

Kafka的保留日志策略主要基于以下几个关键参数:

- log.retention.hours:这个参数指定了日志文件的保留时间,即消息在Kafka中存储的最长期限。一旦消息超过了这个时间限制,它们就会被自动删除。这个参数允许用户根据业务需求设置合适的消息保留时间。

- log.retention.bytes:这个参数定义了每个日志文件的最大大小。当日志文件达到这个大小限制时,最老的消息会被删除,以释放磁盘空间。这个参数对于控制Kafka集群的磁盘使用情况非常有用。

- log.segment.bytes:这个参数决定了每个日志文件的分段大小。当达到这个大小限制时,当前日志文件会被关闭,并开始一个新的日志文件。这有助于Kafka进行日志文件的滚动和管理。

此外,Kafka还支持日志压缩(compact)策略。压缩策略与删除策略不同,它不会直接删除过期的消息,而是通过将相同的key对应的多个value值压缩成一个,来减少日志占用的空间。这种策略适用于那些只需要保留最新value的场景。

在实际应用中,用户可以通过设置broker端参数log.cleanup.policy来指定集群上所有topic的默认策略类型。同时,也可以通过topic级别参数cleanup.policy来为某些topic设置不同于默认值的策略类型。这样,Kafka就可以根据不同的业务需求和应用场景,灵活地调整和管理消息的保留策略。

综上所述,Kafka的保留日志策略是一个复杂而灵活的机制,它允许用户根据实际需求调整消息的保留时间和大小限制,以确保系统的正常运行和数据的可用性。

4. 如果Kafka副本leader出现故障,那么Kafka是如何处理这些故障的呢?

如果Kafka副本的leader出现故障,Kafka会进行一系列处理来确保服务的连续性和数据的可靠性。以下是处理过程的主要步骤:

- 选举新的leader:Kafka会从ISR(In-Sync Replicas)集合中选举一个新的leader。ISR集合是所有与leader同步的副本的集合。这个选举过程是由Zookeeper完成的。新的leader将从ISR集合中选出,以保证与故障前的leader数据尽可能保持一致。

- 数据同步:新的leader会从本地获取上次记录的HW(High Watermark),然后将log文件高于HW的部分截取掉。之后,新的leader会向所有follower同步数据,直到该follower的LEO(Log End Offset)大于等于该分区的HW。这样做是为了确保所有副本的数据一致性。

- 恢复服务:一旦新的leader选举出来并完成数据同步,Kafka会恢复服务。生产者可以向新的leader发送消息,消费者可以从新的leader读取消息。

需要注意的是,Kafka只能保证副本之间数据的一致性,并不能保证数据不丢失或者不重复。因此,在实际应用中,可能需要结合其他机制(如数据备份、日志记录等)来进一步提高数据的可靠性和安全性。

此外,Kafka副本的故障处理还涉及到follower故障的处理。如果follower发生故障,它会被临时踢出ISR。待follower恢复后,它会读取本地磁盘上次记录的HW,将log文件高于HW的部分截取掉,然后从HW开始向leader进行同步。当该follower的LEO大于该Partition的HW时,即follower追上leader之后,就可以重新加入ISR。

这样的设计使得Kafka能够在遇到故障时,快速恢复服务并保证数据的一致性,从而提供可靠的消息传递和流处理服务。

5. 如果Kafka副本follower出现故障,那么Kafka是如何处理这些故障的呢?

当Kafka副本中的follower出现故障时,Kafka会采取一系列措施来处理这些故障,以确保数据的一致性和系统的可用性。以下是Kafka处理follower故障的主要步骤:

故障检测:Kafka集群中的节点会相互监控彼此的健康状态。一旦检测到某个follower副本出现故障或无法响应请求,系统就会触发故障处理机制。

临时踢出ISR:当follower副本故障后,它会被临时踢出ISR(In-Sync Replicas)列表。ISR列表包含了所有与leader副本同步的副本,只有处于ISR列表中的副本才能被选为分区的leader。

数据恢复:被踢出ISR的follower副本在恢复后,会读取本地磁盘记录的上次的HW(High Watermark,即已提交的消息的偏移量)。然后,该follower副本会截取掉log文件中高于HW的部分,并从HW开始向leader副本进行同步。这样做是为了确保从leader副本同步的数据是完整且一致的。

重新加入ISR:当该follower副本的LEO(Log End Offset,即当前log文件的最后一条消息的偏移量)大于等于该分区的HW时,即follower追上leader之后,就可以重新加入ISR列表了。这样,Kafka就保证了副本之间数据的一致性。

Leader选举:如果leader副本出现故障,Kafka会触发Leader选举机制,从ISR列表中选择一个新的leader副本。这个新的leader副本会接管原来的leader的工作,继续处理读写请求,并与其他副本保持数据同步。

在整个故障处理过程中,Kafka通过副本机制和ISR列表来确保数据的一致性和可靠性。同时,Kafka也提供了丰富的配置选项和监控工具,帮助用户更好地管理和维护Kafka集群,降低故障发生的概率和影响。

此外,为了进一步提高系统的可用性,Kafka还采用了如分区复制、异步复制等策略,以及通过增加follower副本的数量来提升服务的性能,使服务具备了横向扩展的能力。这些措施共同确保了Kafka在面对各种故障时能够保持稳定和高效运行。

6. 简述Kafka副本的Unclean leader选举流程?

Kafka副本的Unclean leader选举流程主要涉及以下几个关键步骤:

- 监测节点变化:当Kafka集群中的一个Broker节点(尤其是当前的Leader节点)出现故障时,Controller会监测到这种节点变化。Controller是Kafka集群中的一个关键组件,负责管理和协调集群中的各个Broker节点。

- 请求ISR列表:Controller会向Zookeeper请求ISR(In-Sync Replicas)列表。ISR是那些与Leader副本保持同步的副本集合,它们具有最新的数据状态。在选举新的Leader时,ISR中的副本会被优先考虑。

- 选举新的Leader:基于ISR列表,Controller会进行新的Leader选举。选举的规则通常是按照AR(Assigned Replicas,即分配给分区的副本列表)中的顺序进行,且优先考虑ISR中存活的副本。这样可以确保新选出的Leader具有最新的数据状态,并减少数据不一致的风险。

- 更新Zookeeper信息:一旦新的Leader被选举出来,Controller会更新Zookeeper中存储的leader和ISR信息,以反映集群的最新状态。

需要注意的是,Unclean leader选举是一个在特定条件下触发的流程,例如在ISR中的副本都无法担任Leader时,Kafka可能会选择进行Unclean leader选举,即选择一个可能不是最新数据状态的副本作为新的Leader。这种情况下,可能会导致数据的不一致,因此在实际应用中需要谨慎使用。

总的来说,Kafka副本的Unclean leader选举流程是一个在Broker节点故障时自动进行的恢复过程,旨在确保Kafka集群的可用性和数据的可靠性。通过合理配置和使用Kafka的相关参数和机制,可以降低Unclean leader选举的风险,并提高Kafka集群的稳定性和性能。

7. 简述Kafka副本的leader选举流程?

Kafka副本的leader选举流程主要涉及Kafka集群中的broker节点以及它们之间的协作。以下是该流程的详细步骤:

- 节点注册与Controller选举:Kafka每启动一个节点,都会在Zookeeper中注册一个节点信息。每一个broker节点都有对应的Controller,这些Controller会争先抢占Zookeeper中的controller资源。只有成功抢到资源的那个Controller才能决定选举。选举出来的Controller将负责监听brokers节点的变化,并决定leader的选举。

- 监听节点变化与ISR获取:当某个Broker中的leader发生故障时,Controller会监听到这一节点变化。随后,Controller会获取ISR(In-Sync Replicas)列表,这个列表包含了所有与leader同步的副本。

- 选举新的leader:在ISR列表中的存活副本中,按照它们在AR(Assigned Replicas)中的顺序,优先选举出新的leader。这个新的leader将负责接管原来leader的工作,继续处理读写请求,并与其他副本保持数据同步。

- 更新leader及ISR:选举完成后,新的leader会被更新到系统中,同时ISR列表也会进行相应的更新,以反映当前副本的状态。

整个选举过程依赖于Zookeeper的信息同步功能。Controller的信息同步以及其他broker节点的状态更新都是通过Zookeeper来完成的。这种机制确保了Kafka集群在面临leader故障时能够迅速、准确地选举出新的leader,从而保持服务的连续性和稳定性。

请注意,以上步骤描述了一个典型的Kafka副本leader选举流程,实际操作中可能会根据Kafka集群的具体配置和部署环境有所调整。同时,Kafka也在不断地更新和优化其选举机制,以更好地满足用户对于高可用性和一致性的需求。

8. 简述kafka解决脑裂的解决方案 ?

Kafka解决脑裂问题的主要方案是利用纪元机制。当Kafka集群中新的主节点产生时,会通过Zookeeper生成一个全新的、数值更大的controller epoch标识。其他Broker在知道当前controller epoch后,如果收到由控制器发出的包含较旧epoch的消息,就会忽略它们。这样,Kafka可以确保集群中只有一个主节点在活动,从而避免脑裂问题。

此外,为了预防脑裂问题的发生,还可以采取一些预防措施,如优化网络配置、提高节点间的通信可靠性、设置合适的超时时间等。同时,采用一些检测和恢复机制,如使用ZooKeeper等协调服务来确保集群中只有一个主节点存在,也是非常重要的。在发生脑裂时,及时发现并解决问题也是至关重要的。

脑裂问题可能导致数据状态不一致、相互冲突的操作,甚至数据损坏或丢失。因此,解决Kafka中的脑裂问题对于确保系统的稳定性和数据的完整性至关重要。通过实施上述解决方案和预防措施,可以有效地减少脑裂问题的发生,并提高Kafka集群的可靠性和性能。