一手资源永远值得看 Apache Kafka

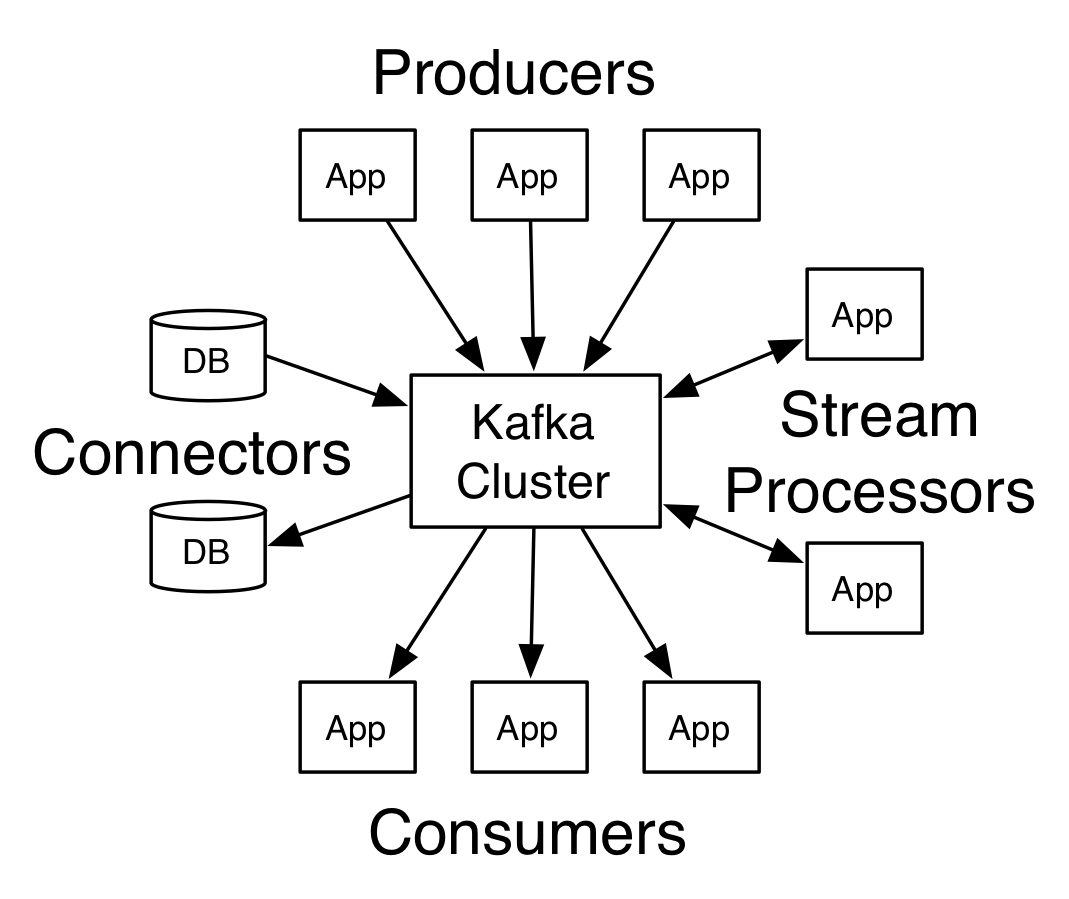

- Kafka 是一款消息中间件,主要包括Producer,Broker,Consumer

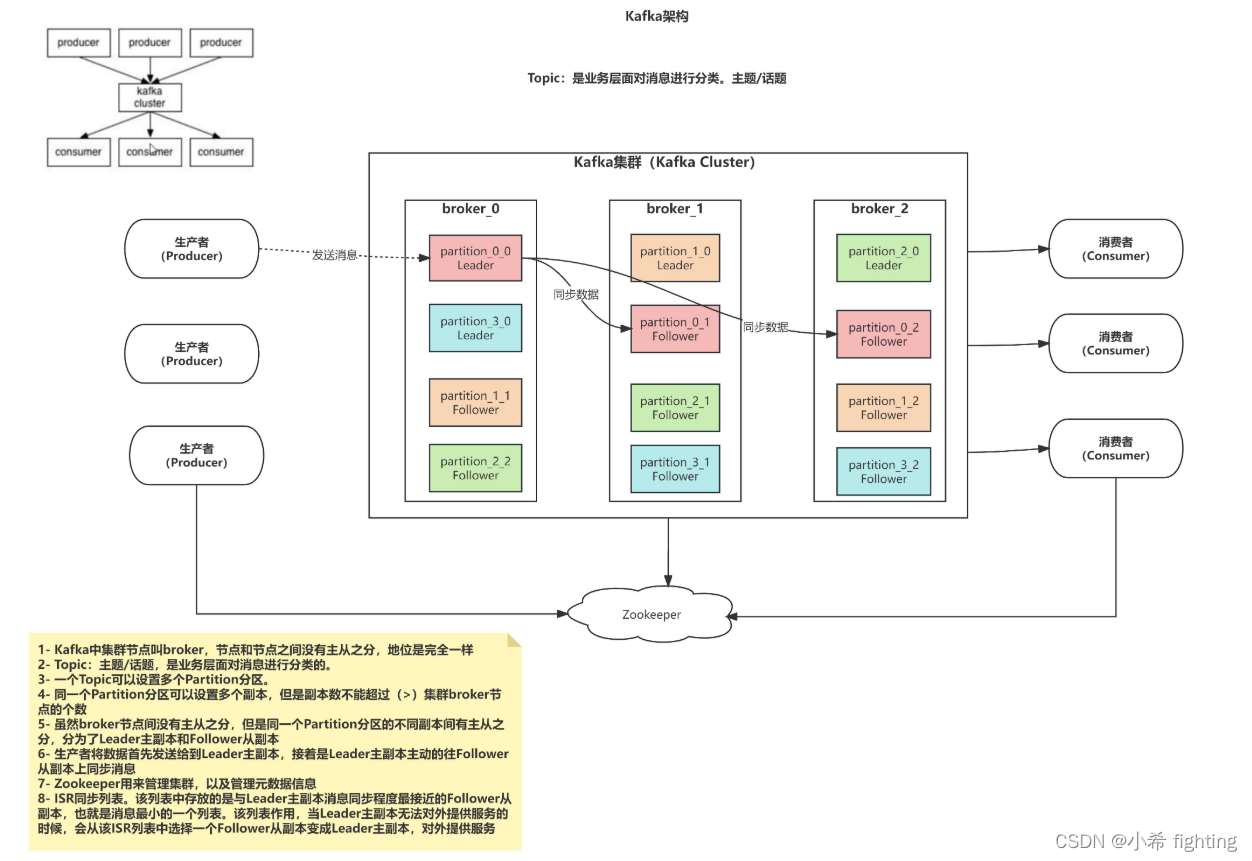

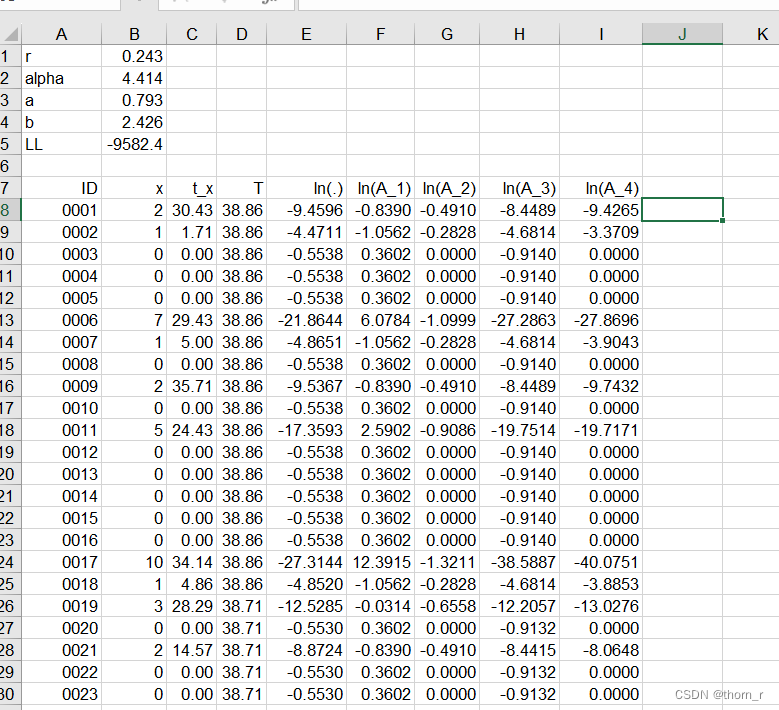

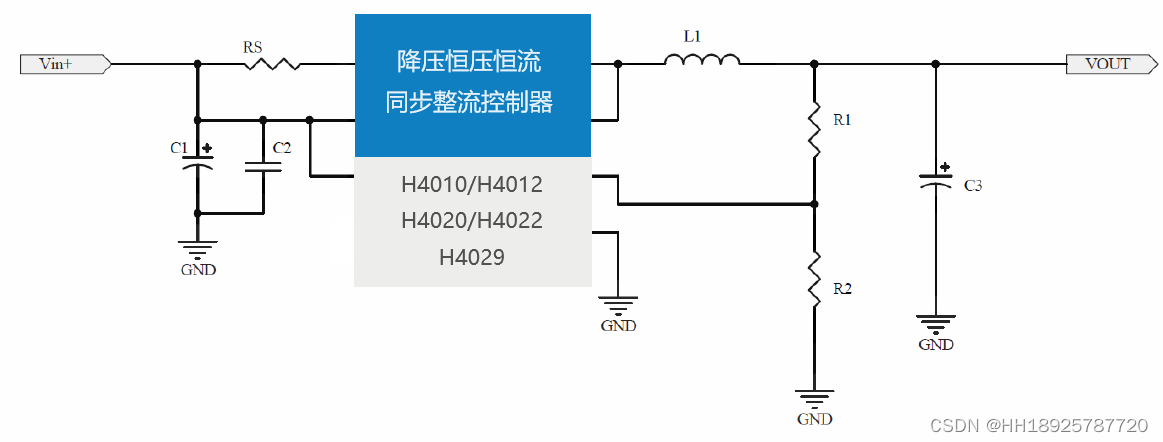

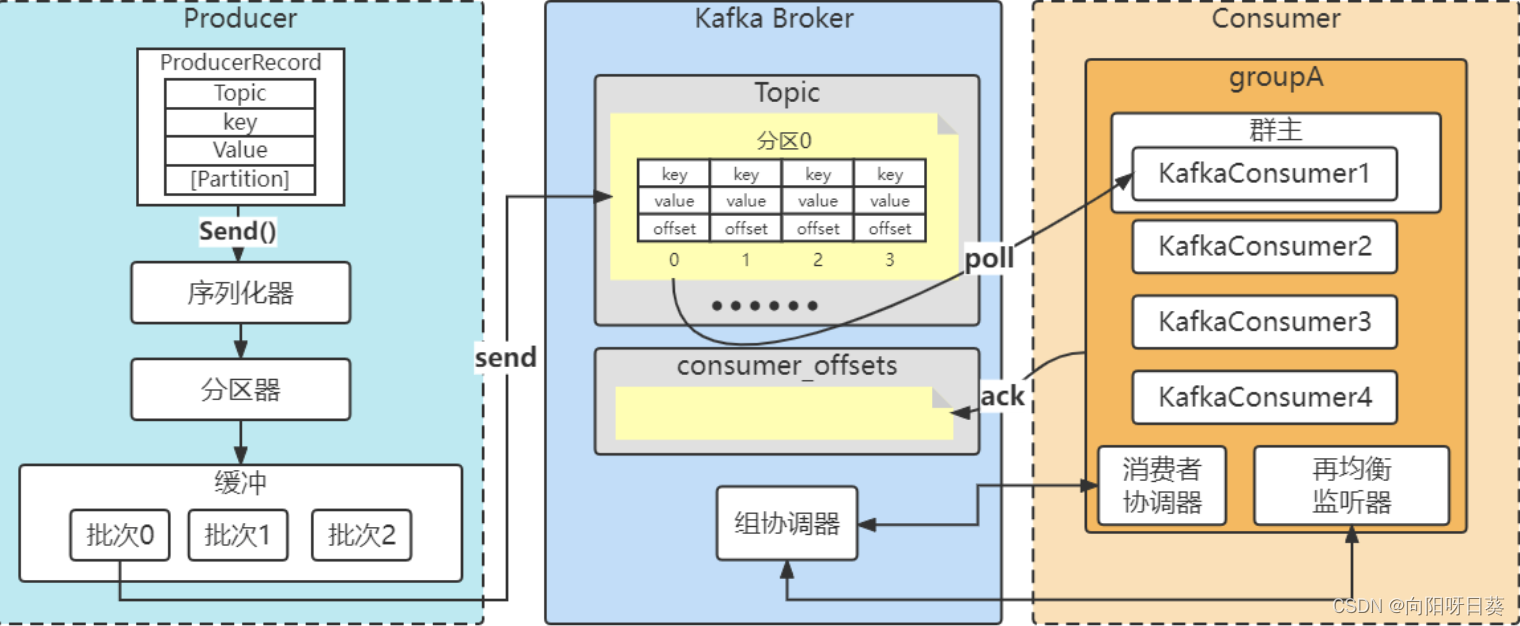

消息发送的流程如下图

ProducerRecord, 消息发送封装

Topic: 类似于其他MQ实现中queue的作用, 可以看成是个管道的名字,生产者生产好

消息后发送到这个queue, 有Broker转发给订阅了该主题的消费者。

Key: 可以不传,这个可以作为发送时候选取partition的参数

Value: 真正消费的消息体,Kafka里面有default的序列化实现,也可以自己自定义

[partition]: 可以定义partition, priority 最高,Kafka里面实现好的分区策略

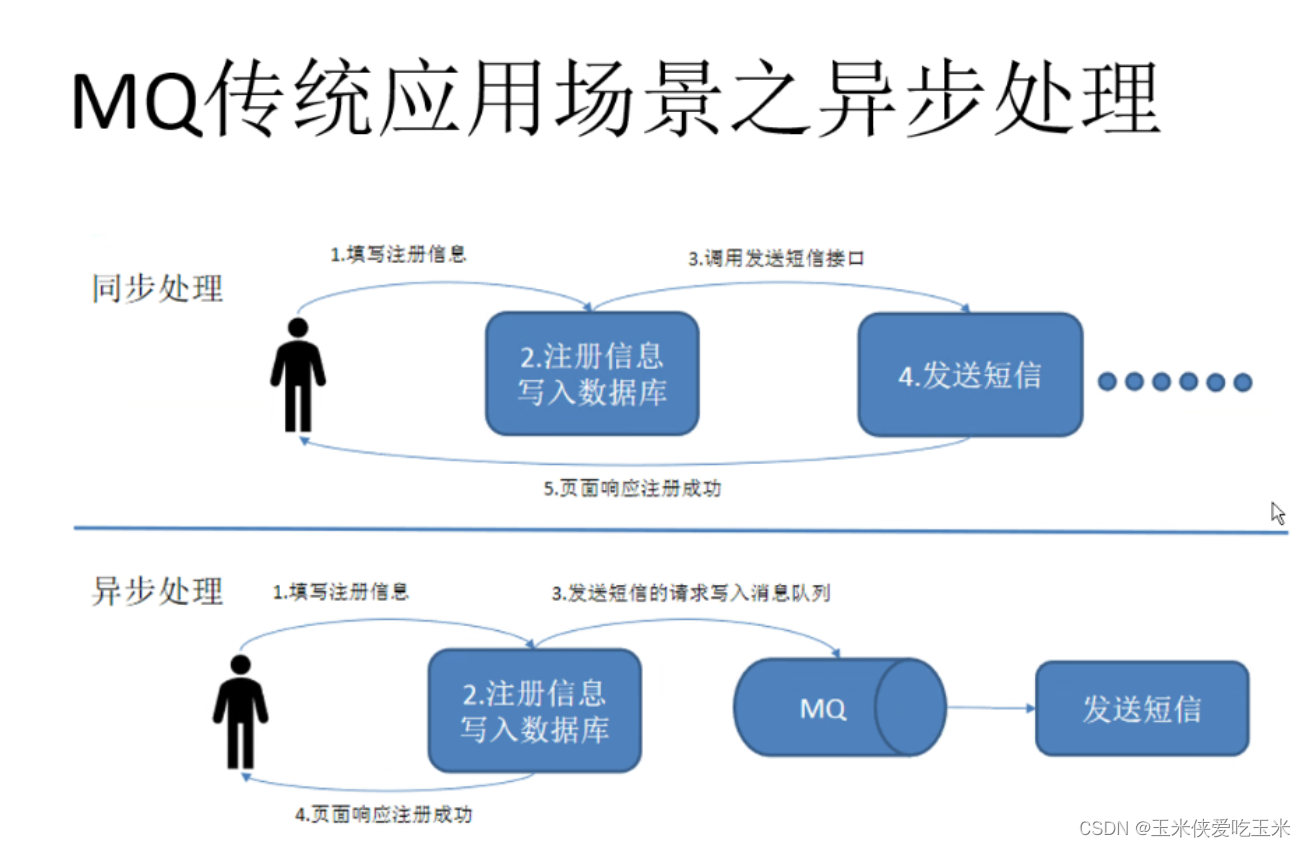

从图中可以看到 消息其实在进入序列化之前,还可以实现拦截器,但是这对性能有一定的影响,经过分区器知道partition之后进入缓存,这里面有两个参数决定消息是否进行发送

producer 的各种参数意义官方

linger.ms: record 来了 delay发送的时间,默认是0,没有delay

batch.size: 发送到同一个分区的消息 combined together 到一定的size

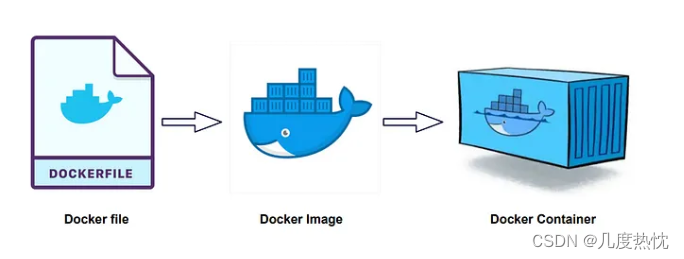

Broker

Broker的实现是基于scala语言的,对消息进行持久化以文件的方式,同时对消费者有组协调器,判断这个消息该给哪个消费者

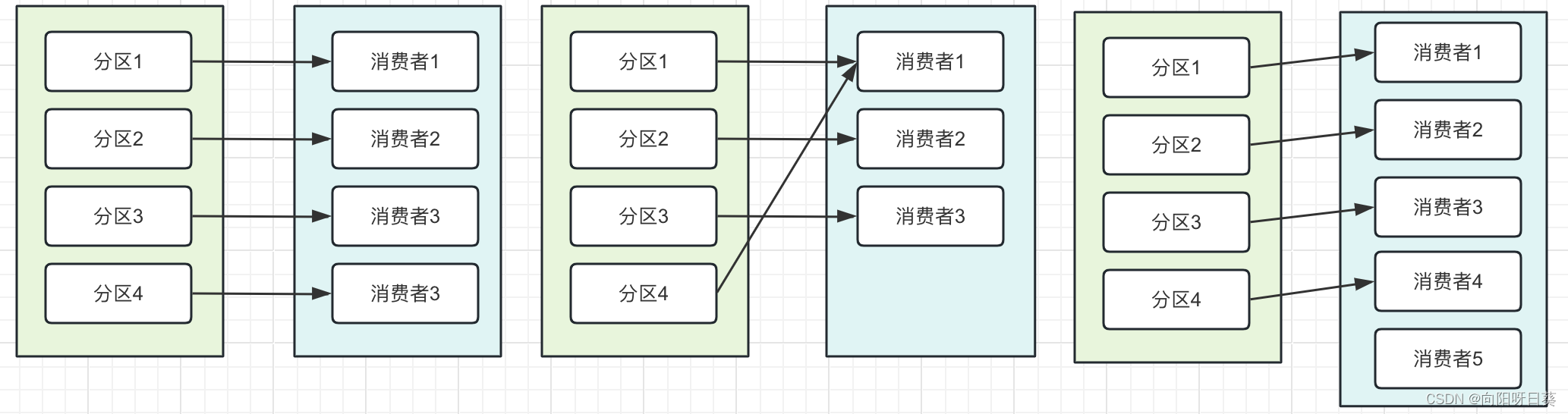

一个分区最多一个消费者,这个是保证消息是顺序消费的

但一个消费者可以消费多个分区,这是在分区比消费者多的前提

但消费者比分区多,Kafka的分区策略,就会有一个消费者闲置

消费者

消费者订阅主题,以group Id 分组批量消费

消费者的配置参数:官方

auto.offset.reset

earliest

当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,从头开始消费

latest

当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,消费新产生的该分区下的数据,只要group.Id不变,不管auto.offset.reset 设置成什么值,都从上一次的消费结束的地方开始消费。

enable.auto.commit ,一般都设为false, 不自动提交,防止丢数据