写文献综述常用的几种深度神经网络模型

- 卷积神经网络(CNN)

- 解释说明:专门用于处理图像和图像数据的深度学习模型。它通过卷积层、池化层等操作提取图像特征。

- 应用:图像分类、目标检测、人脸识别等。

- 未来改进:进一步提高模型的精度和效率,探索更复杂的网络结构和优化算法。

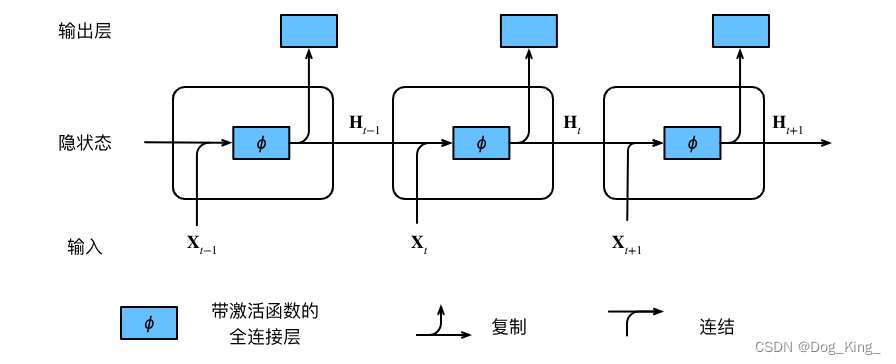

- 循环神经网络(RNN)

- 解释说明:用于处理序列数据的神经网络模型,能够捕捉序列中的时间依赖关系。

- 应用:自然语言处理、语音识别、时间序列分析等。

- 未来改进:解决长时依赖问题,优化模型结构以提高性能。

- 深度Q网络(DQN)

- 解释说明:用于强化学习的模型,通过与环境交互学习决策策略。

- 应用:游戏AI、机器人控制等。

- 未来改进:提高模型的稳定性和泛化能力,探索更高效的学习算法。

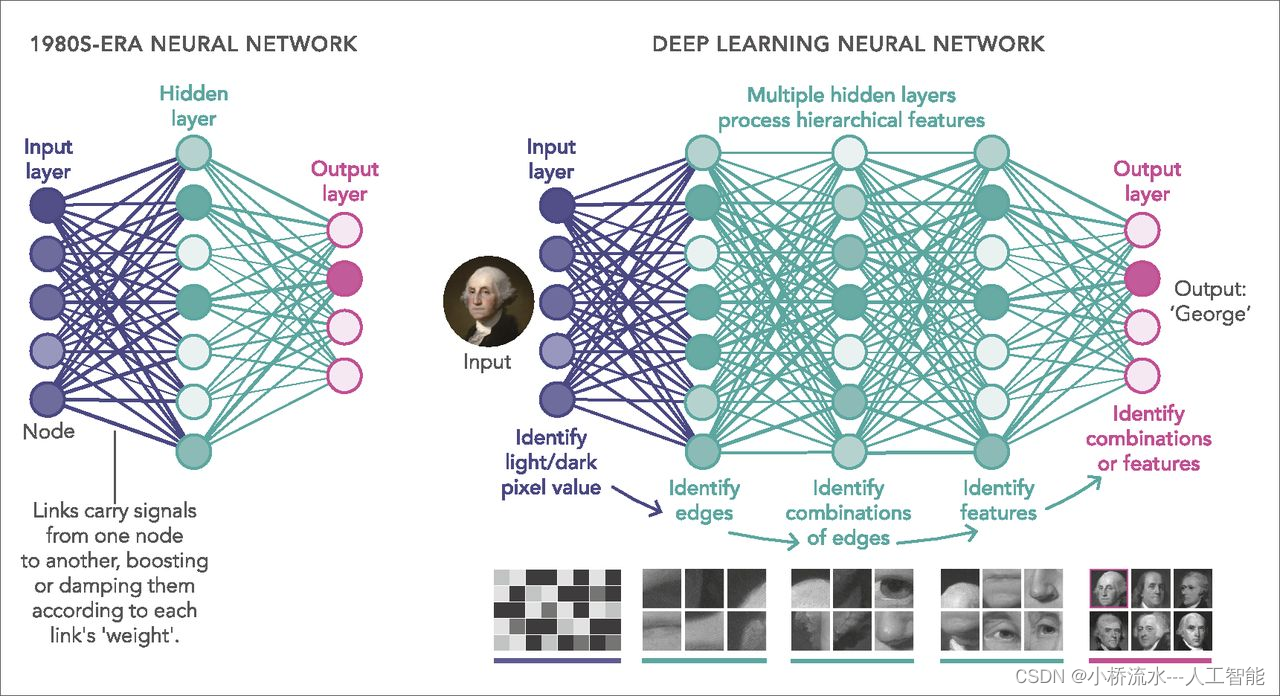

- 人工神经网络(ANN)(很多层,至少5层,区别于BP神经网络)

- 解释说明:深度学习的基本构建块,包括输入层、隐藏层和输出层。

- 应用:分类、回归、聚类等。

- 未来改进:优化网络结构、激活函数和训练方法,提高模型的性能。

- 变换器(Transformer)

- 解释说明:一种创新性的深度学习模型,最初用于自然语言处理任务。通过自注意力机制捕捉序列中的依赖关系。

- 应用:机器翻译、文本生成、语音识别等。

- 未来改进:提高模型的计算效率,降低内存消耗,探索更广泛的应用场景。

- 图神经网络(GNN)

- 解释说明:专门用于处理图数据的深度学习模型,能够捕捉图结构中的信息。

- 应用:社交网络分析、推荐系统等。

- 未来改进:提高模型处理大规模图数据的能力,优化图嵌入算法。

- 深度信念网络(DBN)

- 解释说明:由多个受限玻尔兹曼机(RBM)堆叠而成的深度生成模型。

- 应用:特征提取、降维等。

- 未来改进:提高模型的生成能力和稳定性,优化训练算法。

- 长短期记忆网络(LSTM)

- 解释说明:RNN的一种变体,通过引入门控机制解决长时依赖问题。

- 应用:时间序列预测、语音识别等。

- 未来改进:提高模型的性能,降低计算复杂度,探索新的应用场景。

- 生成对抗网络(GAN)

- 解释说明:由生成器和判别器组成的深度学习模型,通过对抗训练生成逼真的数据。

- 应用:图像生成、数据增强等。

- 未来改进:提高生成数据的质量和多样性,优化训练稳定性和收敛速度。

- 深度残差网络(ResNet)

- 解释说明:通过引入残差连接解决深度神经网络中的梯度消失和表示瓶颈问题。

- 应用:图像分类、目标检测等。

- 未来改进:进一步优化残差连接的结构和数量,提高模型的性能和效率。

- 生成对抗网络(Generative Adversarial Networks,GAN)

- 说明: GAN 是一种包含生成器和判别器的对抗性训练框架,用于生成具有真实感的数据样本。

- 主要应用: 图像生成、图像编辑、视频生成等生成式任务。

- 未来改进: 提高生成器的稳定性和生成样本的质量,减少训练中的模式崩溃和模式崩塌现象,以及探索新的架构和损失函数。

- 注意力机制(Attention Mechanism)

- 说明: 注意力机制允许模型在处理序列数据时集中注意力于相关部分,提高模型对输入数据的理解能力。

- 主要应用: 机器翻译、语音识别、图像描述生成等任务。

- 未来改进: 设计更加高效和灵活的注意力机制,探索多头注意力和自适应注意力等新技术,并结合其他模型构建更强大的系统。

- 变分自编码器(Variational Autoencoder,VAE)

- 说明: VAE 是一种生成模型,通过学习数据分布的潜在表示来生成新的数据样本,并且具有连续的潜在空间。

- 主要应用: 图像生成、数据压缩、数据重建等任务。

- 未来改进: 提高生成样本的质量和多样性,改进潜在空间的表示学习,以及结合其他生成模型和正则化方法。

- 自注意力模型(Self-Attention Model)

- 说明: 自注意力模型是一种利用自注意力机制处理序列数据的模型,能够在输入序列中建立全局依赖关系。

- 主要应用: 自然语言处理任务如语言建模、机器翻译等。

- 未来改进: 提高模型的计算效率和泛化能力,探索不同的注意力机制和模型结构。

- 深度强化学习(Deep Reinforcement Learning,DRL)

- 说明: DRL 结合了深度学习和强化学习,在没有标注数据的情况下,通过与环境的交互学习决策策略。

- 主要应用: 游戏玩法、机器人控制、自动驾驶等需要决策的任务。

- 未来改进: 提高算法的稳定性和样本效率,解决探索与利用之间的平衡问题,以及扩展到更复杂的任务和环境。

- 迁移学习模型(Transfer Learning Models)

- 说明: 迁移学习利用已训练好的模型的知识来加速新任务的学习,通常通过微调模型参数实现。

- 主要应用: 在数据量有限的情况下,用于加速模型训练和提高性能。

- 未来改进: 设计更加通用和可迁移的特征表示,提高模型的泛化能力,以及探索新的迁移学习策略和场景。

神经网络结构的搜索方法,一般有网格搜索,以及NAS搜索

. 神经网络结构搜索(Neural Architecture Search,NAS)

** NAS 是一种自动化的方法,用于搜索最优的神经网络结构,以解决特定任务。- 主要应用: 自动化模型设计、模型压缩、移动端部署等。