报告链接:https://stability.ai/news/stable-diffusion-3-research-paper

要点

- 发布研究论文,深入探讨Stable Diffuison 3的底层技术

- 基于人类偏好评估,Stable Diffusion 3 在排版和提示遵守方面优于最先进的文本到图像生成系统,例如 DALL·E 3、Midjourney v6 和 Ideogram v1

- 新的多模态扩散Transformer (MMDiT) 架构对图像和语言表示使用单独的权重集合,与以前版本的 SD3 相比,这提高了文本理解和拼写能力

继宣布 Stable Diffusion 3 的早期预览版之后,又发布了一份研究论文,概述了即将发布的模型的技术细节。

表现

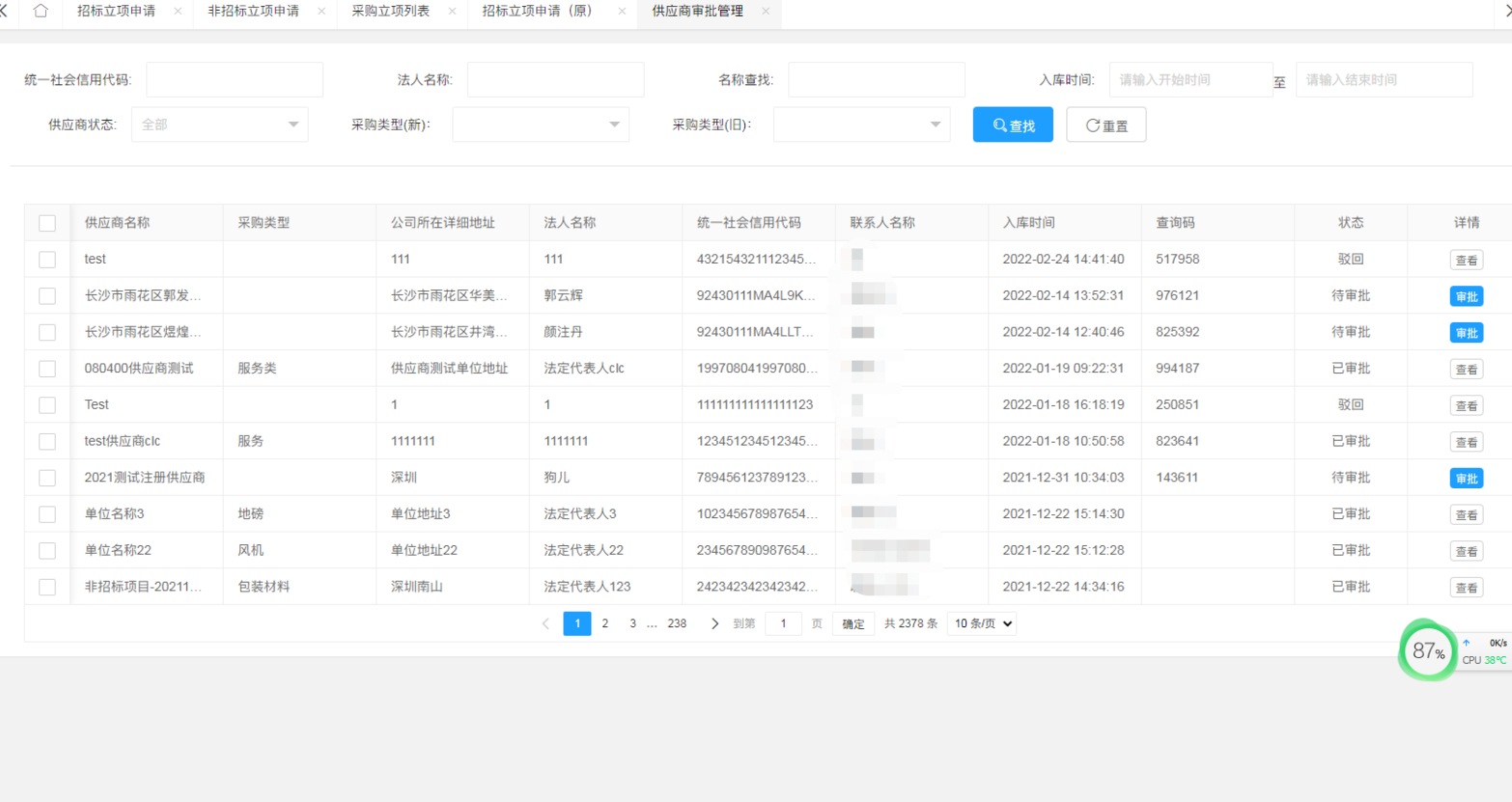

将 Stable Diffusion 3 的输出图像与其他各种开放模型(包括 SDXL、SDXL Turbo、Stable Cascade、Playground v2.5 和 Pixart-α)以及闭源系统(如 DALL·E 3、Midjourney v6 和 Ideogram v1)进行基于人类反馈的性能对比。在这些测试中,向人类评估者提供了每个模型的示例输出,并要求他们根据模型输出与提示上下文的紧密程度(“提示跟随”)、基于提示的文本呈现程度(“排版”)以及哪幅图像具有更高的美学质量(“视觉美学”)来选择最佳结果。

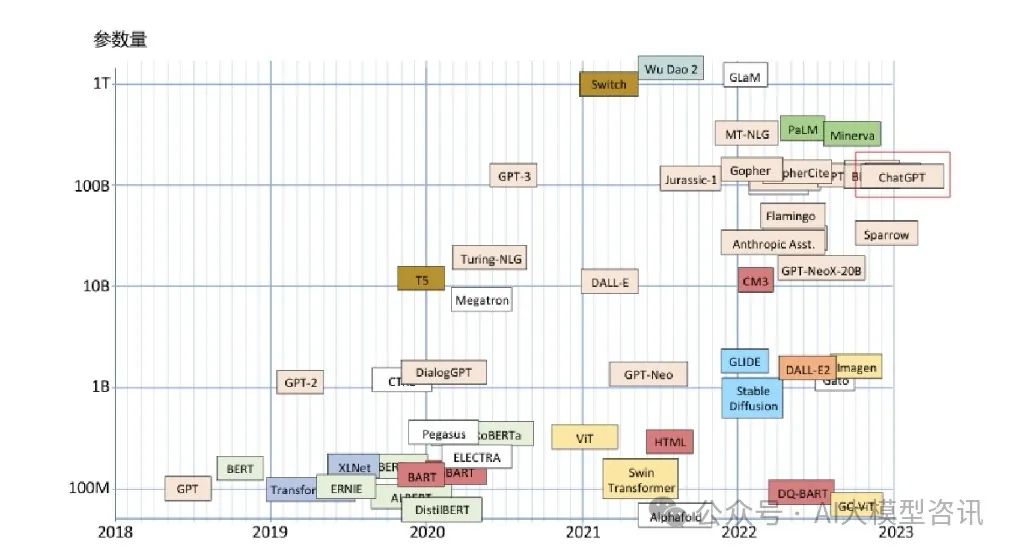

测试结果表明Stable Diffusion 3在所有上述领域都等于或优于当前最先进的文本到图像生成系统。在早期的消费者硬件上进行的未优化推理测试中,最大的SD3模型具有8B个参数,适合RTX 4090的24GB VRAM,当使用50个采样步骤时,需要34秒能生成分辨率为1024x1024的图像。此外,Stable Diffusion 3在首次发布期间将有多种变体,从800M到8B的参数模型,以进一步消除硬件障碍。

架构细节

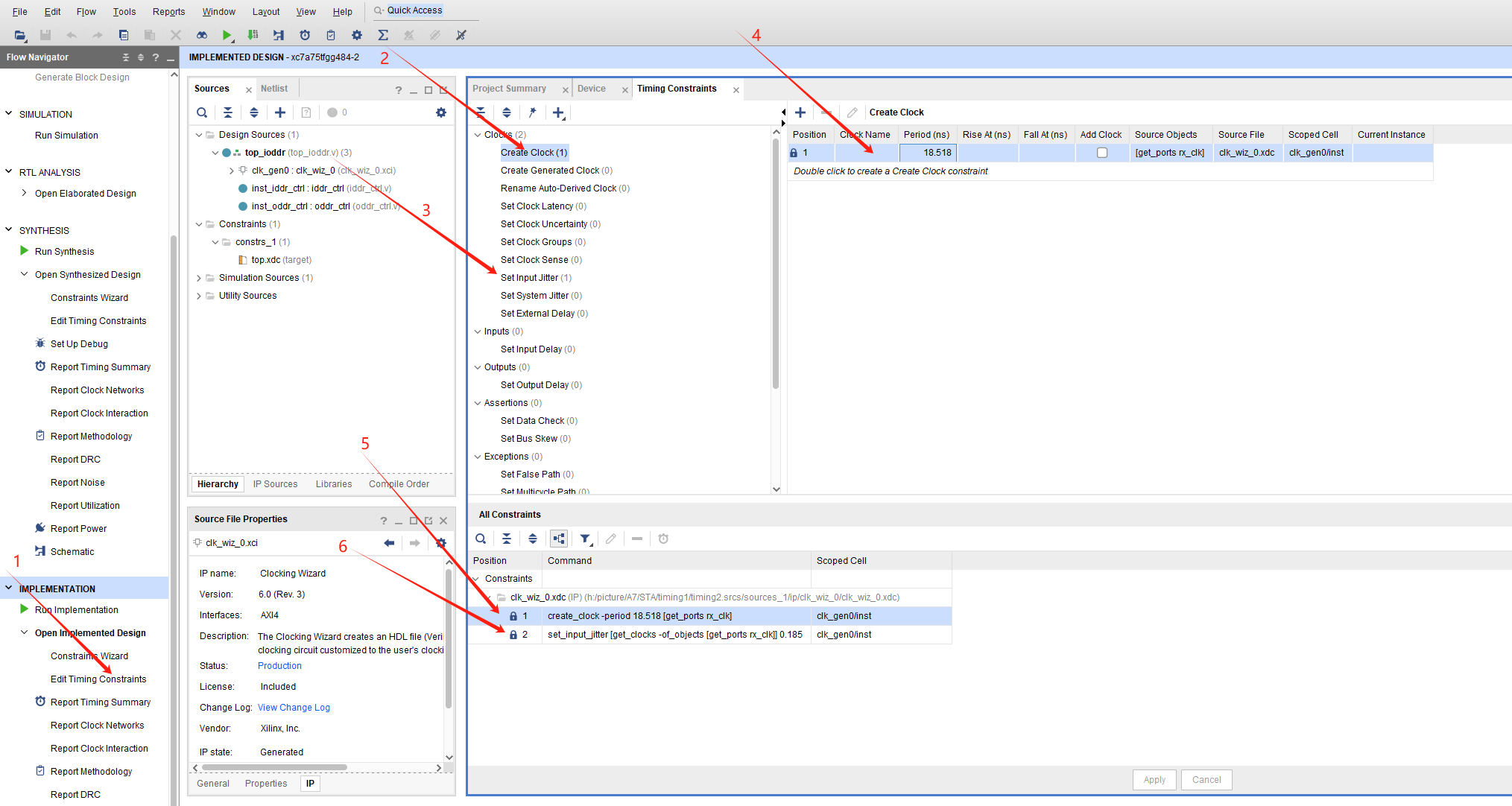

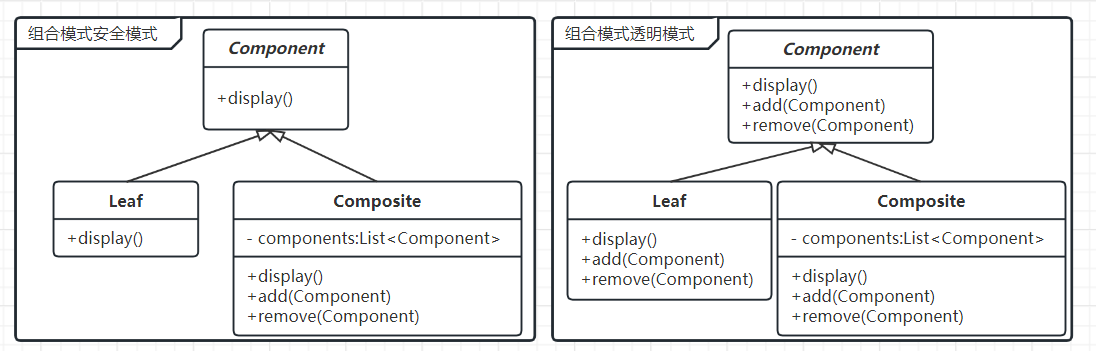

对于文本到图像的生成,SD3模型考虑文本和图像这两种模式,这是为什么将这种新架构称为 MMDiT,指的是它处理多种模式的能力。与之前版本的稳定扩散一样,使用预训练模型来导出合适的文本和图像表示。具体来说,SD3使用三种不同的文本嵌入器(两个 CLIP 模型和 T5)来编码文本表示,并使用改进的自动编码模型来编码图像tokens。

SD3 架构建立在 DiT 的基础上。由于文本和图像嵌入在概念上完全不同,因此对这两种模式使用两组独立的权重。如上图所示,这相当于每种模态都有两个独立的Transformers,但是将两种模态的序列连接起来进行注意力操作,这样两种表示都可以在自己的空间中工作,同时考虑另一种表示。

训练过程中测量视觉保真度和文本对齐,MMDiT 架构优于已建立的文本到图像主干,UViT 和 DiT

通过使用这种方法,信息可以在图像和文本标记之间流动,以提高生成的输出中的整体理解和排版。正如在论文中讨论的那样,这种架构还可以轻松扩展到视频等多种模式。

得益于 Stable Diffusion 3 改进的提示跟随功能,模型能够创建专注于各种不同主题和质量的图像,同时对图像本身的风格保持高度灵活性。

通过重新加权改善整流流量

Stable Diffusion 3 采用整流流 (RF) 公式(相关论文),其中数据和噪声在训练期间以线性轨迹连接。这会产生更直的推理路径,从而允许用更少的步骤进行采样。此外,在训练过程中引入了一种新颖的轨迹采样计划。这个schedule给予轨迹的中间部分更多的权重,因为假设这些部分会导致更具挑战性的预测任务。使用多个数据集、指标和采样器设置进行比较,针对 60 个其他扩散轨迹(例如 LDM、EDM 和 ADM)对比测试。结果表明,虽然以前的 RF 公式在少步采样方案中表现出改进的性能,但它们的相对性能随着步数的增加而下降。相比之下,重新加权的 RF 变体不断提高性能。

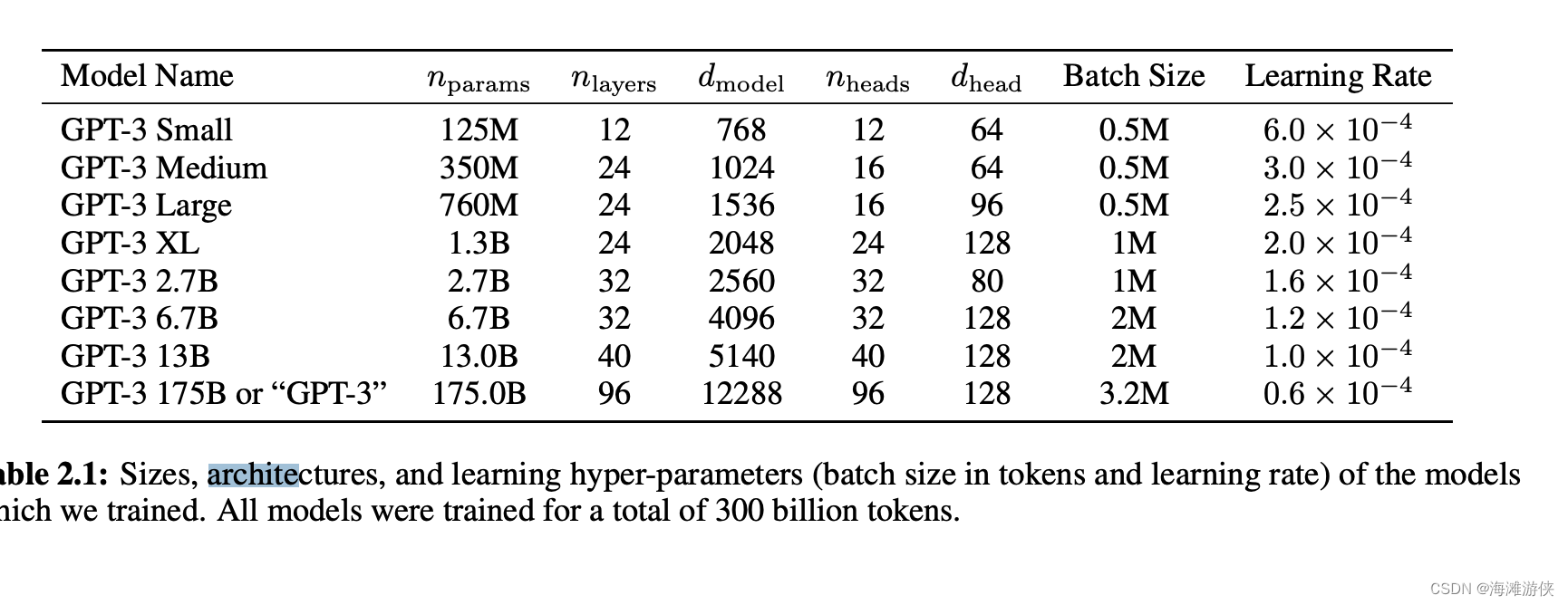

Scaling Rectified Flow Transformer Models

使用重新加权的整流流公式和 MMDiT 主干对文本到图像的合成进行了缩放研究。训练模型范围从具有 15 个blocks的450M 参数到具体 38 个blocks的 8B 参数,并观察到验证损失随着模型大小和训练步骤的函数而平滑下降(上行)。为了测试这是否转化为模型输出的有意义的改进,还评估了自动图像对齐指标 (GenEval) 以及人类偏好评分 (ELO)(下行)。结果表明这些指标与验证损失之间存在很强的相关性,表明后者是整体模型性能的有力预测因子。此外,扩展趋势没有显示出饱和的迹象,可乐观地认为未来可以继续提高模型的性能。

灵活的文本编码器

通过移除用于推理的内存密集型 4.7B 参数 T5 文本编码器,SD3 的内存需求可以显着降低,而性能损失很小。删除此文本编码器不会影响视觉美感(无 T5 的胜率:50%),只会导致文本依从性略有下降(胜率 46%),如上图“性能”部分下所示。然而,建议包括 T5,以充分利用 SD3 生成书面文本的能力,因为观察到,如果没有 T5,版式生成的性能会大幅下降(胜率 38%),如下例所示: