文章目录

1、问题提出

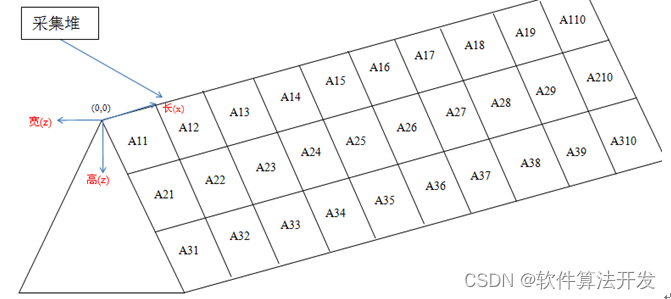

使用chatgpt之类的闭源大语言模型时,我们与ai沟通的数据会被其搜集用以训练改善模型。

我们的数据很容易被泄露;数据隐私和数据安全问题如何得到保障?

2、解决方案

为了解决上述问题,我们可以考虑在本地部署开源模型,避免数据泄露。

3、Ollama介绍

Ollama是一个强大的运行AI模型的工具;

3.1、Ollama的核心功能

易于安装和使用:Ollama 支持 macOS、Windows 和 Linux,提供了简洁明了的安装和运行指令,让用户无需深入了解复杂的配置即可启动和运行。

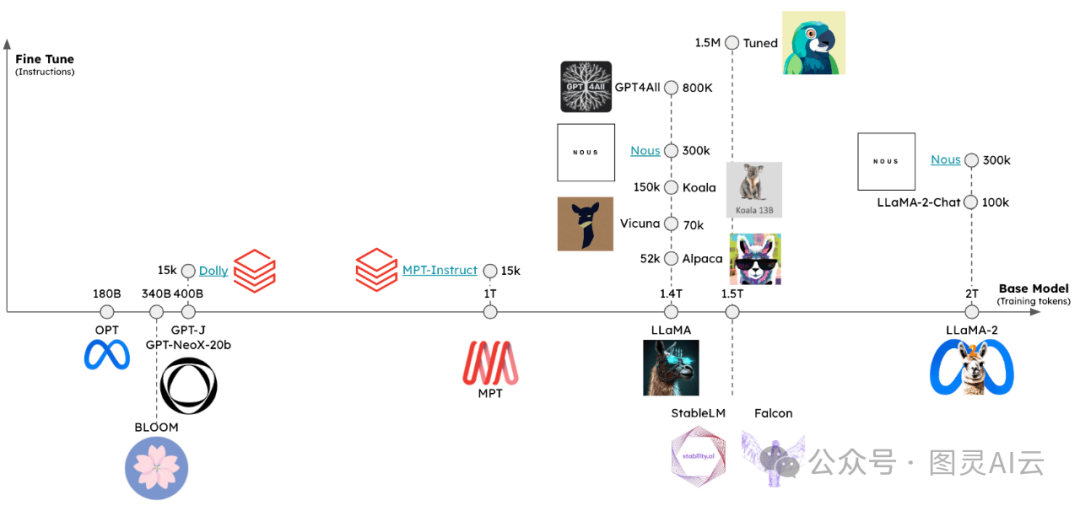

丰富的模型库:通过Ollama,用户可以访问和运行包括 Llama 2、Mistral 和 Dolphin Phi 在内的多种大型语言模型。这为开发者和研究者提供了极大的便利。

高度可定制:Ollama 允许用户通过 Modelfile 定义和创建自定义模型,满足特定应用场景的需求。

优化的性能:即使在普通的个人电脑上,Ollama 也能通过优化运行效率,支持运行较小的模型,为用户提供实验和测试的环境。

3.2、Ollama的独特之处

与市面上其他相似工具相比,Ollama 最大的特色在于它的易用性和灵活性。用户不仅可以通过命令行界面快速运行模型,还可以选择图形用户界面(GUI)进行交互,如 Ollama WebUI 和 macOS 的原生应用 Ollamac 等,极大地提高了用户体验。

4、Ollama安装与使用

4.1、Ollama的安装

使用Ollama,您可以在本地环境中轻松运行和管理大型语言模型,如Llama 2等。以下是Ollama的安装和运行指南,适用于macOS、Windows和Linux平台。

macOS 和 Windows 用户

下载Ollama:对于macOS用户,访问Ollama的官方网站或GitHub页面下载最新版本。

Windows用户可以下载预览版,或通过相同的渠道获取最新版本。

安装:

macOS用户直接从下载的包安装。

Windows用户根据下载的安装程序指引完成安装。

运行模型:

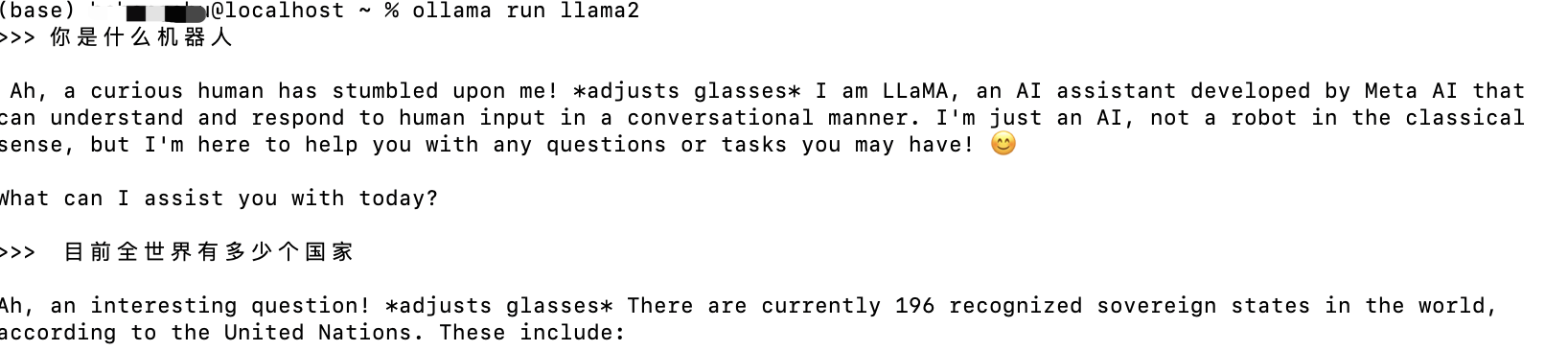

安装完成后,打开终端(macOS)或命令提示符(Windows),输入

命令来运行一个模型,例如Llama 2:

ollama run llama2

Linux 用户

通过命令行安装:打开终端,输入以下命令:

curl -fsSL https://ollama.com/install.sh | sh

这个命令会自动下载和安装Ollama。

运行模型:

安装完成后,在终端中输入

ollama run llama2

来运行Llama 2模型

5、使用Docker

对于熟悉Docker的用户,Ollama也提供了官方的Docker镜像。这可以让您在隔离的环境中运行模型,不受本地环境设置的限制。

拉取Ollama Docker镜像:

docker pull ollama/ollama

运行模型:

使用以下命令启动容器并运行模型,例如Llama 2:

docker run -it ollama/ollama run llama2

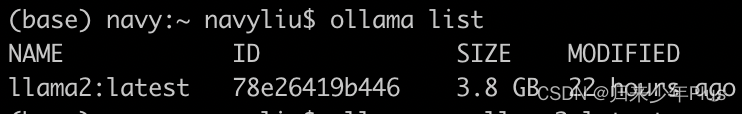

6、模型库和自定义模型

Ollama支持多种开源模型,您可以通过访问ollama.ai/library来查看所有可用的模型,并使用ollama pull <模型名>来下载指定模型。此外,如果您想创建自定义模型,可以通过创建Modelfile并使用ollama create <模型名> -f ./Modelfile来创建,并通过ollama run <模型名>来运行您的模型。

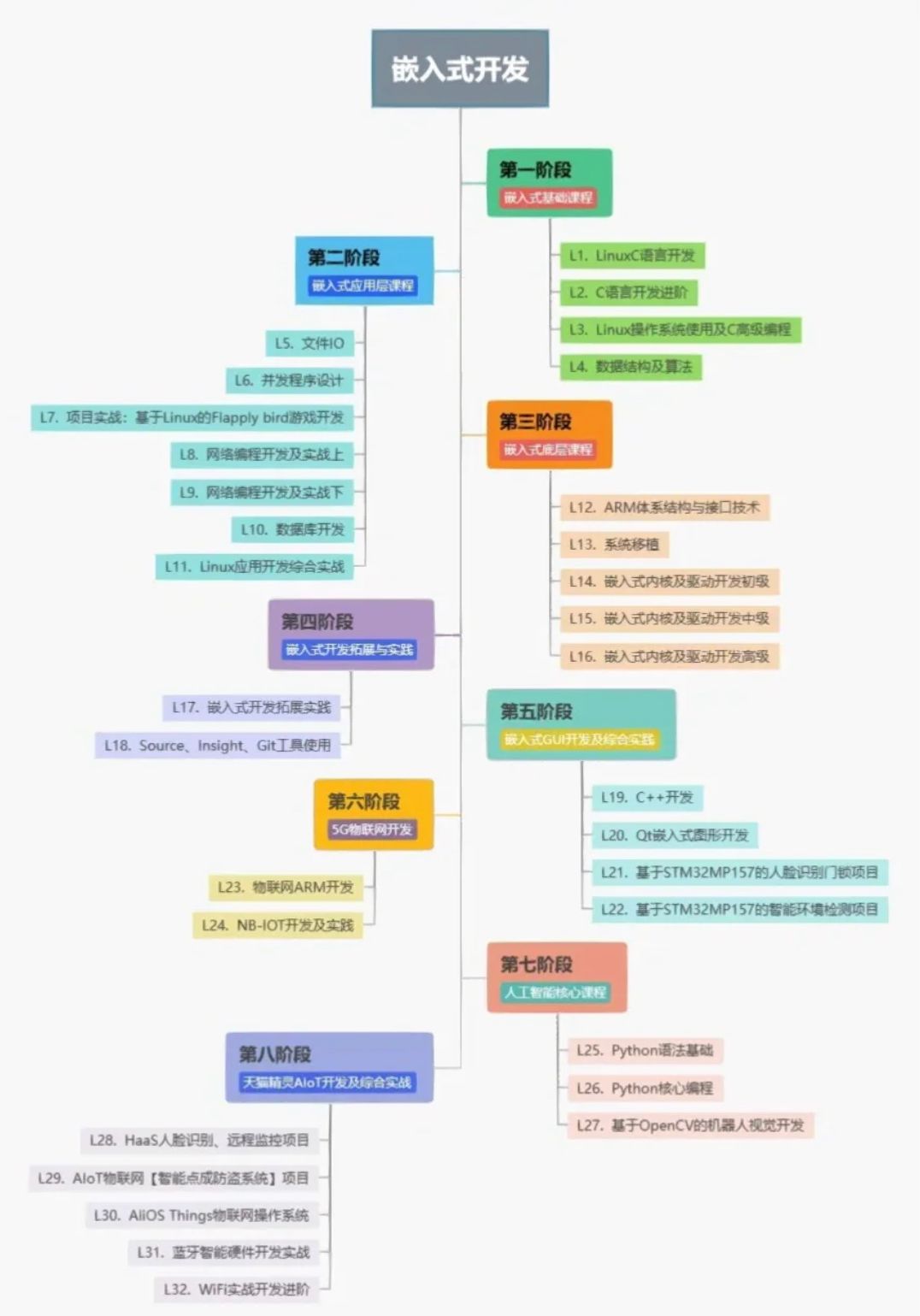

7、应用场景展望

Ollama 的应用场景非常广泛,不仅限于技术研究和开发测试。教育工作者可以利用它为学生提供实践AI技术的平台,技术爱好者也可以通过它探索人工智能的无限可能。

尝试下多模态开源模型llava,识别图片内容。使用相当流畅

出数学题和英语题(仅作为演示,通过优化提示词配合rag技术可以呈现更好的效果)

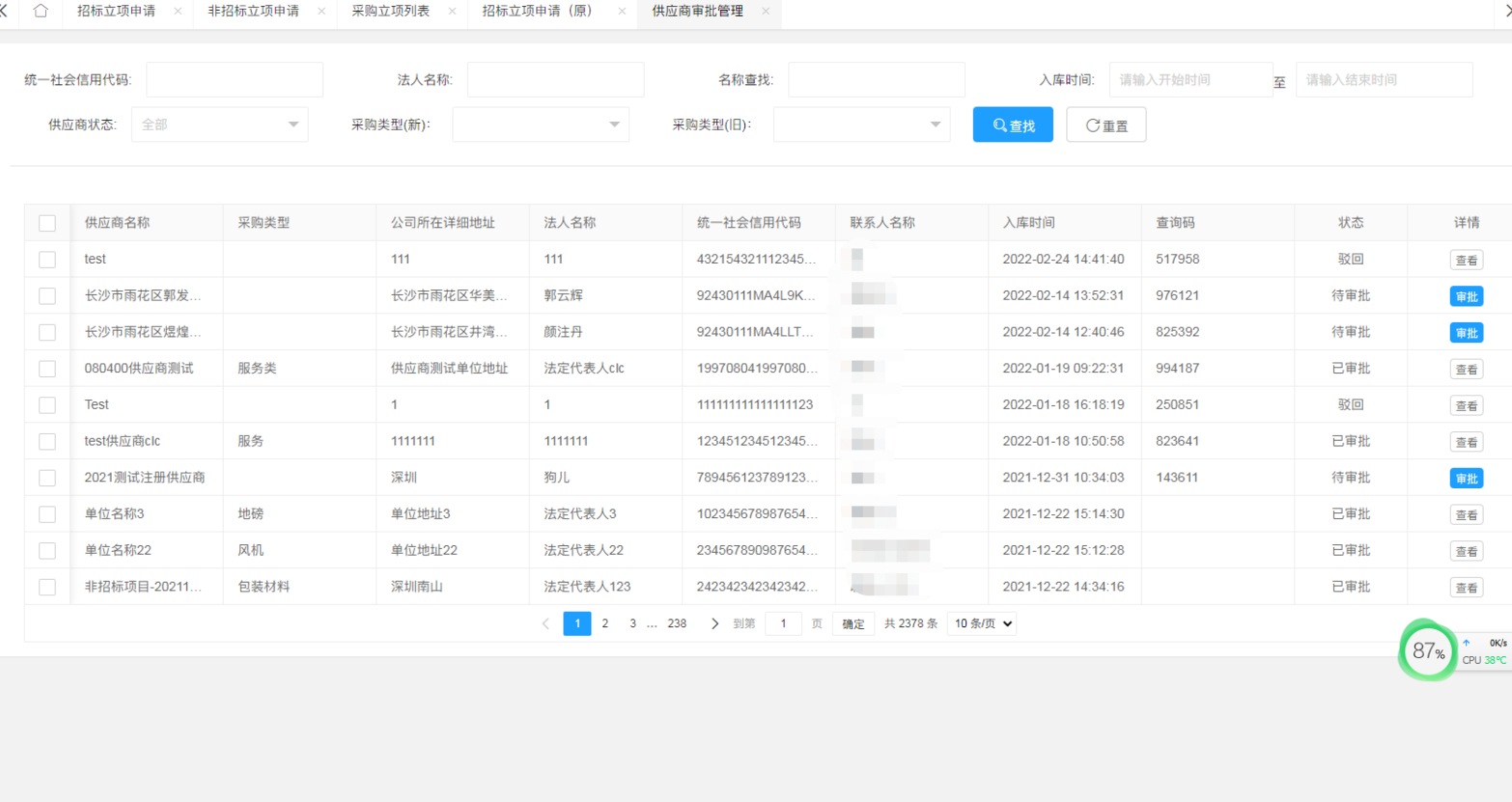

不喜欢这种通过命令行交互的形式的话,我们也可以配合open-webui这个开源项目来部署用户界面

项目网址:https://github.com/open-webui/open-webui

8、结语

Ollama 以其易用性、灵活性和强大的功能,为本地运行大型语言模型提供了一个理想的解决方案。

真正的大师,永远都怀着一颗学徒的心!