博客源地址:Stable Diffusion 3: Research Paper — Stability AI

论文源地址:https://arxiv.org/pdf/2403.03206.pdf

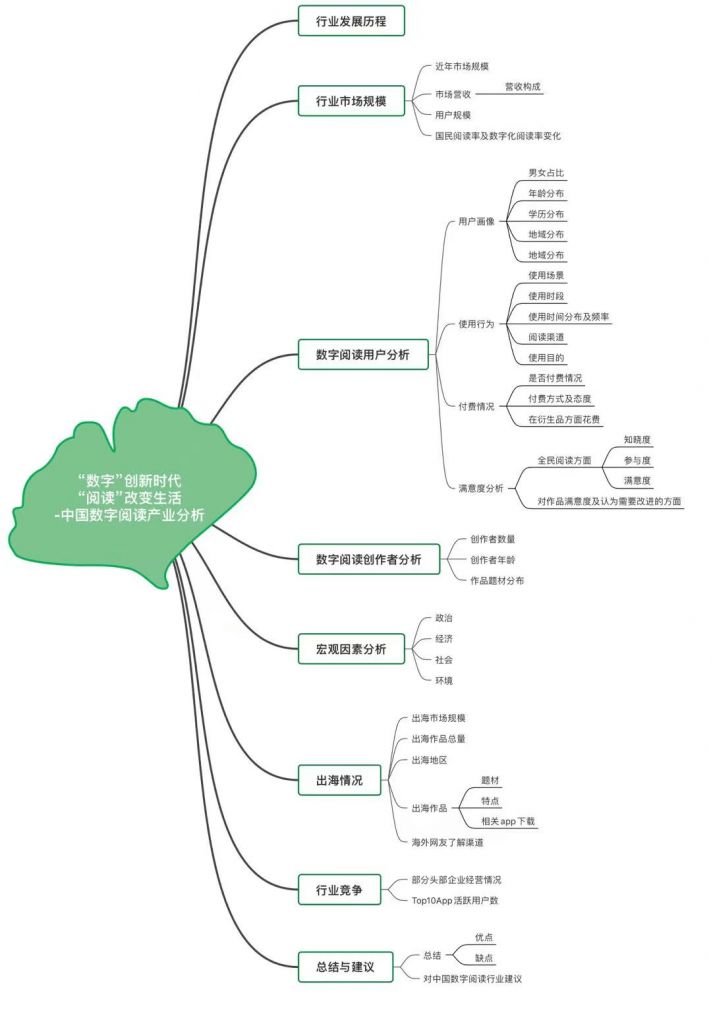

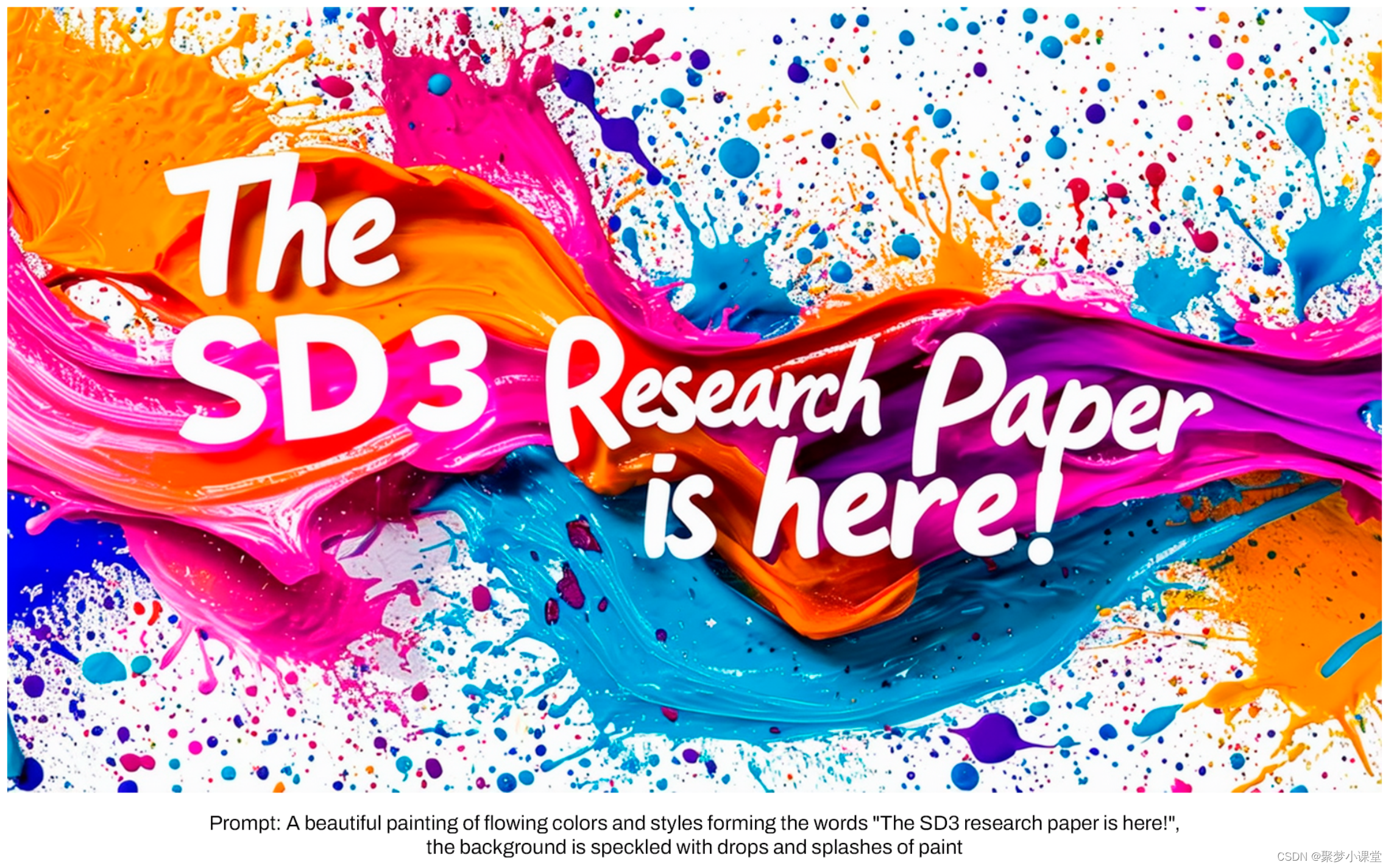

Stability.AI 官方发布了Stable diffusion 3.0的论文研究,不过目前大家都沉浸在SORA带来的震撼中,所以这个水花貌似也就被忽略了。但,毕竟绘画领域里边最大的开源模型,还是多少可以关注一下。

🎇首先看一下模型表现

这张图直接把我看懵了,为何在这张图中,SDXL 和SDXL turbo都这么高的胜率,而且超过MJ6.0,后来仔细理解了下blog的说辞,才明白这个是以SD3作为基线,赢过这些模型的比例,三个维度分别是美学评分,提示词跟随程度 和 文字识别“排版”能力。

基于这张图,大概可以看出,在文字识别能力方面,SD3的胜率整体非常高,而在美学评分方面,略微比MJ6和DALLE3强一点。

但问题是,个人体验的MJ6和DALLE3根本不在一个档次上,MJ6还是强很多的。并且基于官方已经发布的模型生成的图片来看,并没有觉得生成质量能比MJ6能强,所以这个还是等模型实际发布之后再看吧,毕竟这种评分都是按照“人类反馈评估”来得出的,并非是一个绝对客观的数值。

官方对SD3的评价说法是:根据我们的测试结果,我们发现 Stable Diffusion 3 在上述所有领域均等于或优于当前最先进的文本到图像生成系统。

emm... 他开心就好。

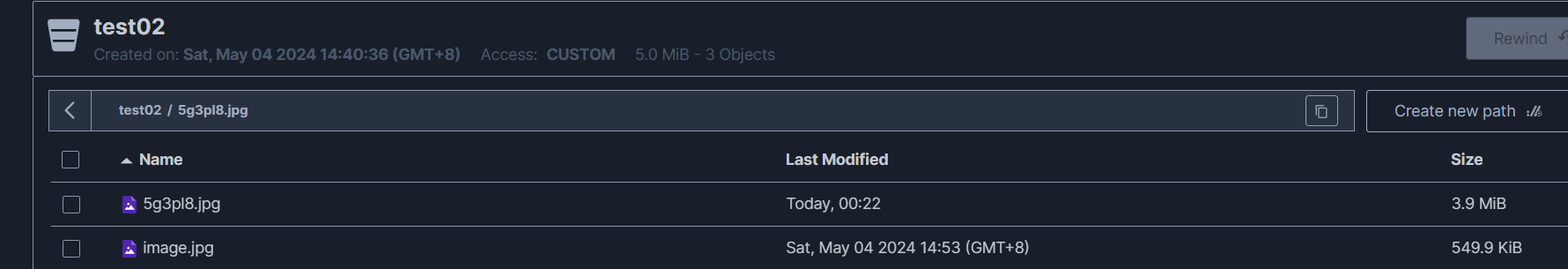

官方还提到一点,在硬件测试过程中,官方最大的8B参数SD3模型“适合”RTX4090的24G显存,并且生成一张1024x1024的图像,需要50次迭代和34秒的时间,emm,可以说“普及”基本就是很远的事情了。

不过官方也提到,他们不仅仅只有一个8B的版本,从800m到8B有一大堆的版本,“以进一步消除硬件障碍”,到时候得看下缩水的版本是不是会降低太多,至少从cascade的经验来看,缩水的模型,生成的质量是直线下降的,这一点也需要等官方实际发布之后再体验了。

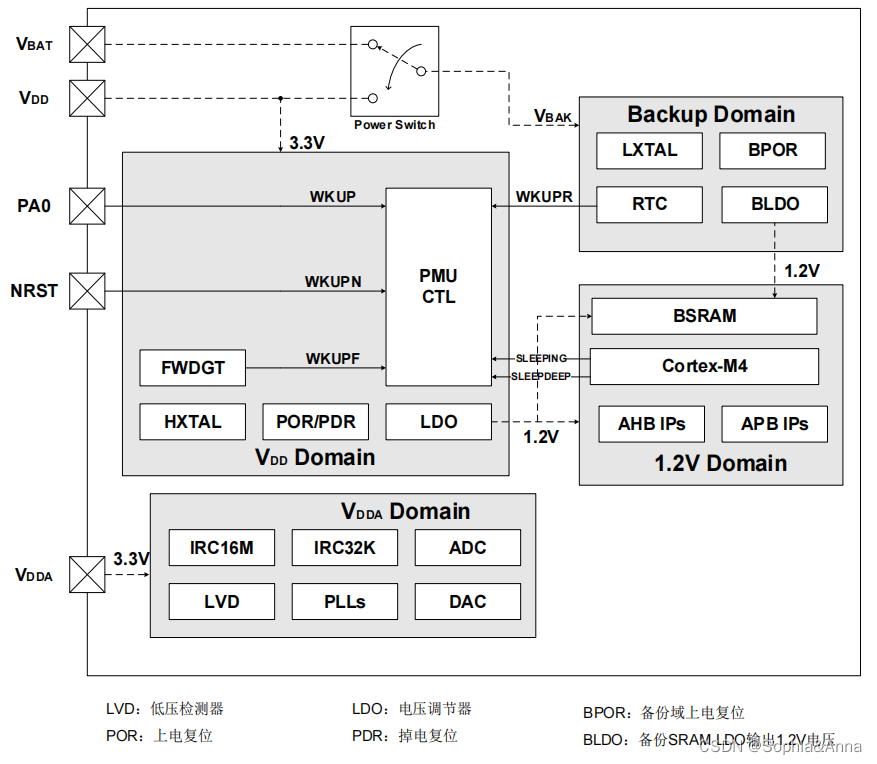

🧨架构细节

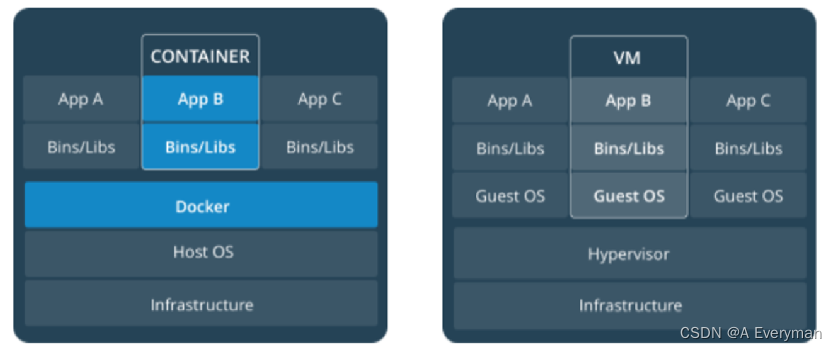

新版本的架构被称为MMDiT,Dit也就是Diffusion Transformer,融合了Diffusion和Transformer两种架构,如果没记错的的话,sora也是这个大的架构,当然了细节肯定有很多区别就是了。

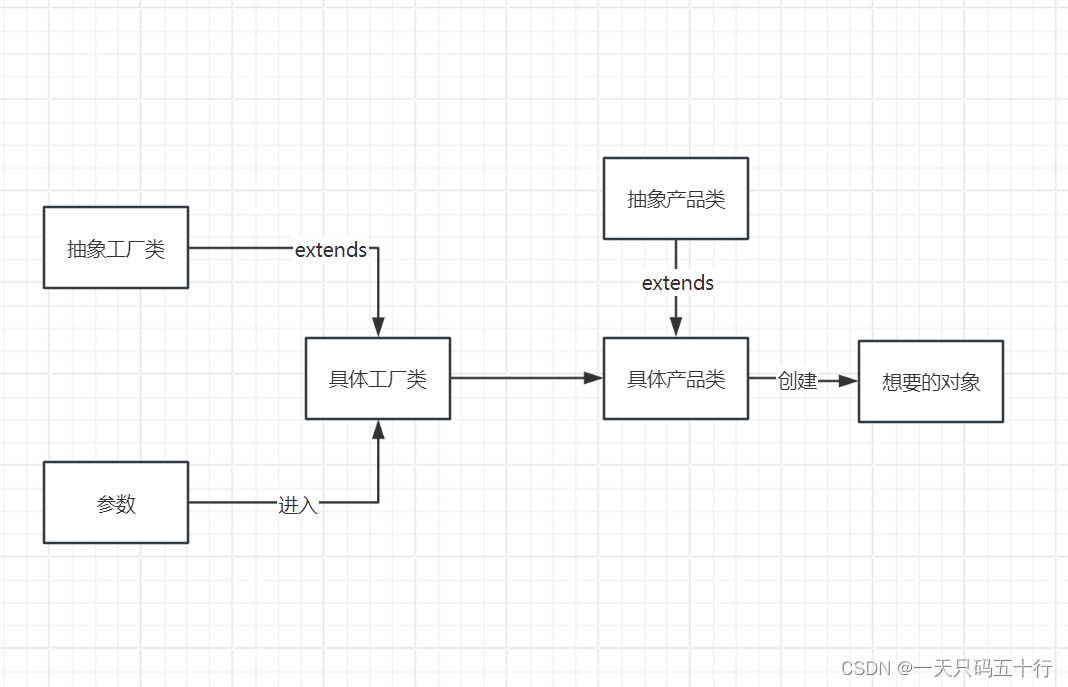

官方这次考虑了文本和图像两种“文本生成图像”的模式。这次官方使用了三种不同的文本嵌入模型(两个clip模型和t5模型)来编码文本。

架构概念图如下:

我们改进的多模态扩散变压器块的概念可视化:MMDiT。

官方认为,新的架构可以让“信息”在图像和文本之间更好的流动,这样生成的图像会更理解提示词,包括提示词中的“文本排版”内容。并且官方认为这种架构还可以轻松扩展到视频等多种模式。

(我个人认为Sora的spatial time pathes那种方式会更适合生成视频模型,也可以更好的理解物理世界,不知道sd3的架构中是否也使用了类似的技术。)

得益于 Stable Diffusion 3 改进的提示跟随功能,新的模型能够创建专注于各种不同主题和质量的图像,同时对图像本身的风格保持高度灵活性。

更多官方示例图像:

(以下两个章节直接原博客复制翻译,非技术的朋友可以暂时忽略。)

通过重新加权改善整流流量

Stable Diffusion 3 采用整流流 (RF) 公式(Liu et al., 2022;Albergo & Vanden-Eijnden,2022;Lipman et al., 2023),其中数据和噪声在训练期间在线性轨迹上连接。这会产生更直的推理路径,从而允许用更少的步骤进行采样。此外,我们在训练过程中引入了一种新颖的轨迹采样计划。这个时间表给予轨迹的中间部分更多的权重,因为我们假设这些部分会导致更具挑战性的预测任务。我们使用多个数据集、指标和采样器设置进行比较,针对 60 个其他扩散轨迹(例如LDM、EDM和ADM )测试我们的方法。结果表明,虽然以前的 RF 配方在少步采样方案中表现出改进的性能,但它们的相对性能随着步数的增加而下降。相比之下,我们重新加权的 RF 变体不断提高性能。

缩放整流流量变压器模型

我们使用重新加权的整流流公式和 MMDiT 主干对文本到图像的合成进行了缩放研究。我们训练的模型范围从 15 个具有 450M 个参数的块到 38 个具有 8B 个参数的块,并观察到验证损失随着模型大小和训练步骤的函数而平滑下降(顶行)。为了测试这是否转化为模型输出的有意义的改进,我们还评估自动图像对齐指标(GenEval)以及人类偏好分数(ELO)(底行)。我们的结果表明这些指标与验证损失之间存在很强的相关性,表明后者是整体模型性能的有力预测因子。此外,扩展趋势没有显示出饱和的迹象,这让我们乐观地认为未来可以继续提高模型的性能。

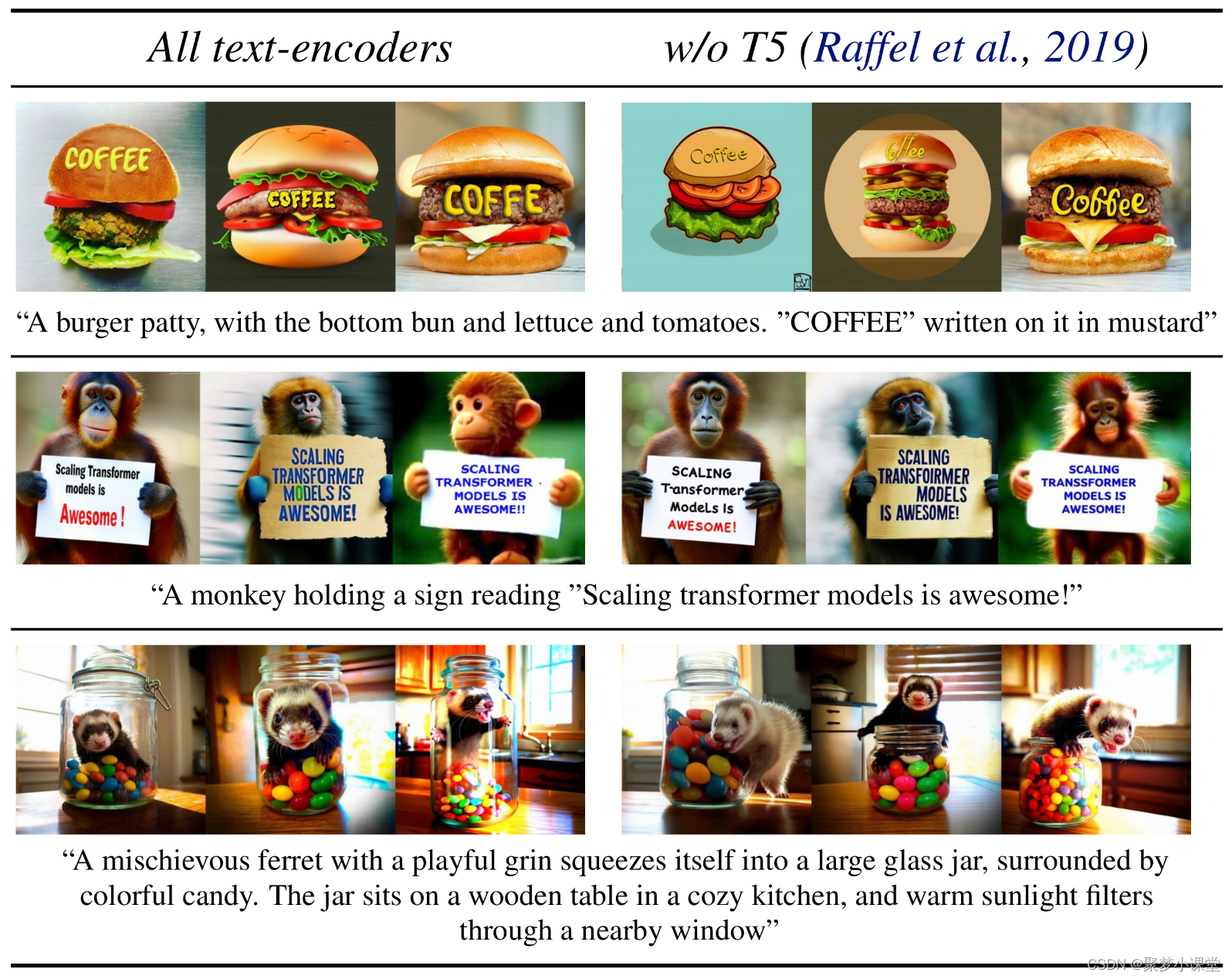

灵活的文本编码器

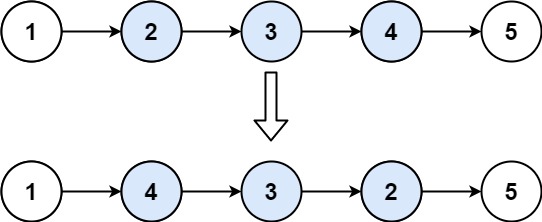

正如前文提到的,SD3用到三种不同的文本嵌入模型(两个clip模型和t5模型)来编码文本。这里测试了下,如果删掉其中一个比较大的模型4.7B参数的T5文本编码器会如何。

发现删掉之后,内存需求可以显著降低,(emm...好像很合理,毕竟这个模型有4.5B的参数),同时性能损失很小。

进一步测试下,发现删除这个文本编码器,对于视觉美感的影响几乎没有,删除前后胜率五五开。但是会导致“提示词相关性”下降,删除之后胜率降低到46%。

所以最终官方的建议是保留T5编码器,这样才能体验满血版的SD3,而且官方还发现,如果删除了T5这个模型,文本版式的生成性能下降会更大,胜率会降低到38%。

也就是说,删除T5编码器后,基准50%来看(也就是五五开),美学、提示词遵循程度、文字排版会降低到:50%,46%,38%。换句话说,如果生成的画面中没有文本,而你的硬件条件又比较差的话,那么删掉T5问题不大,但是如果你要生成文本相关的画面(比如说电影海报),那么还是升级硬件吧。

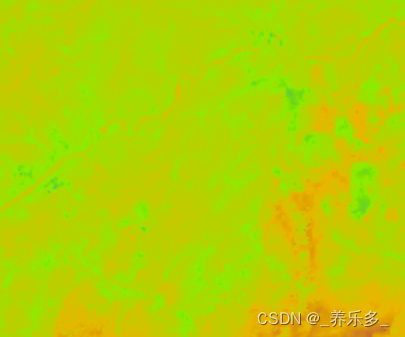

删除前后效果对比:

当渲染涉及许多细节或大量书面文本的非常复杂的提示时,

删除 T5 进行推理只会导致性能显着下降。

上图显示了每个示例的三个随机样本。

以上就是官方博客的内容和我个人的理解,欢迎大家多多交流。

这里是聚梦小课堂,如果觉得内容有用,还请帮忙点个赞哈。