主要内容

视频网址:https://www.bilibili.com/video/BV1Gg4y1U7uc/?spm_id_from=333.788&vd_source=b96c7e6e6d1a48e73edafa36a36f1697

教程网址:https://github.com/internLM/tutorial

OpenCompass主页:https://github.com/open-compass/opencompass

OpenCompass文档: https://opencompass.readthedocs.io/zh-cn/latest/

基础作业使用 OpenCompass 评测 InternLM2-Chat-7B 模型在 C-Eval 数据集上的性能

进阶作业

- 使用 OpenCompass 评测 InternLM2-Chat-7B 模型使用 LMDeploy 0.2.0 部署后在 C-Eval 数据集上的性能

备注:由于进阶作业较难,完成基础作业之后就可以先提交作业了,在后续的大作业项目中使用这些技术将作为重要的加分点!

实践教程本地复现

环境配置

conda create --name opencompass python=3.10 -y

source activate opencompass

git clone https://github.com/open-compass/opencompass

cd opencompass

pip install -e .

数据集下载

wget https://github.com/open-compass/opencompass/releases/download/0.1.8.rc1/OpenCompassData-core-20231110.zip

下载后放到opencompass下的data文件夹

# 列出所有跟 internlm 及 ceval 相关的配置

python tools/list_configs.py internlm ceval

启动评测

确保按照上述步骤正确安装 OpenCompass 并准备好数据集后,可以通过以下命令评测 InternLM-Chat-7B 模型在 C-Eval 数据集上的性能。由于 OpenCompass 默认并行启动评估过程,我们可以在第一次运行时以 --debug 模式启动评估,并检查是否存在问题。在 --debug 模式下,任务将按顺序执行,并实时打印输出。

python run.py --datasets ceval_gen \

--hf-path /share/temp/model_repos/internlm-chat-7b/ \

--tokenizer-path /share/temp/model_repos/internlm-chat-7b/ \

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \

--model-kwargs trust_remote_code=True device_map='auto' \

--max-seq-len 2048 \

--max-out-len 16 \

--batch-size 4 \

--num-gpus 1 \

--debug

命令解析

--datasets ceval_gen \

--hf-path /share/temp/model_repos/internlm-chat-7b/ \ # HuggingFace 模型路径

--tokenizer-path /share/temp/model_repos/internlm-chat-7b/ \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 2048 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 2 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

--debug

注意:需要将模型路径替换成自己的路径

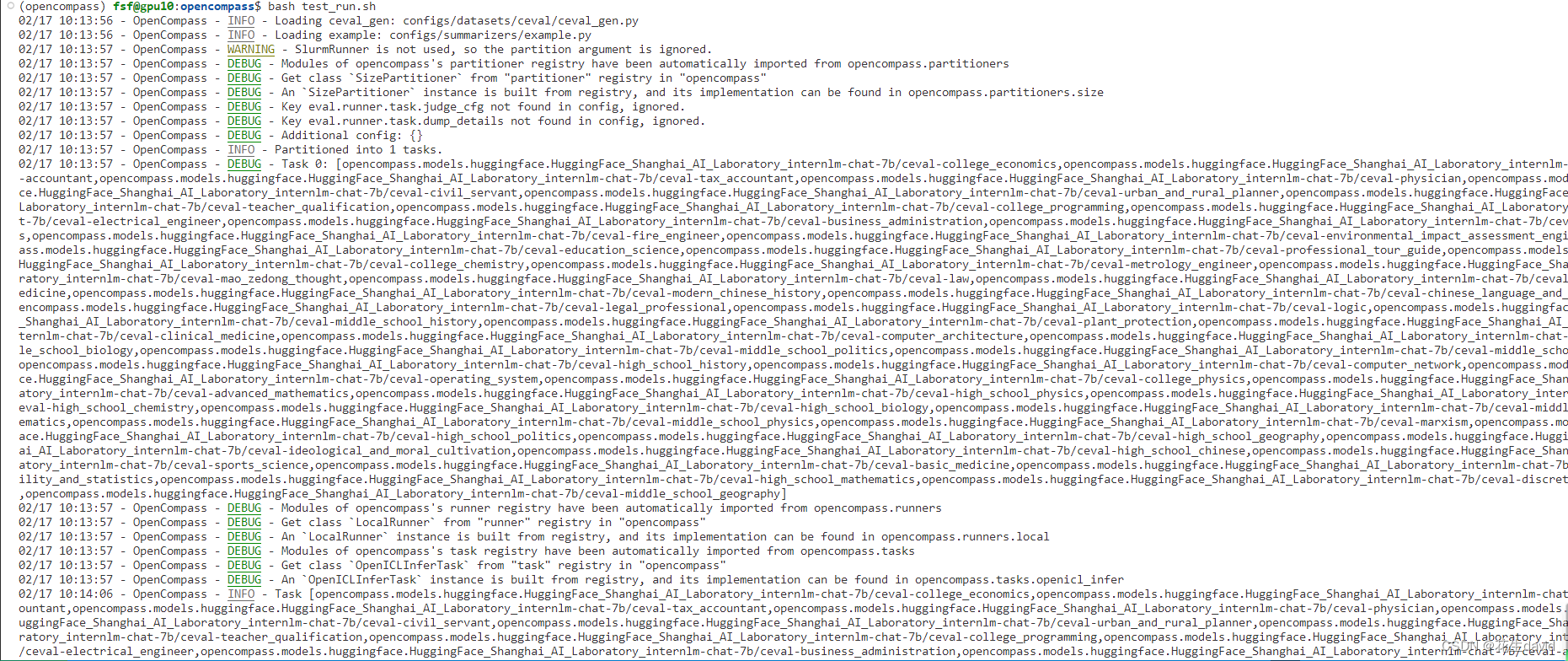

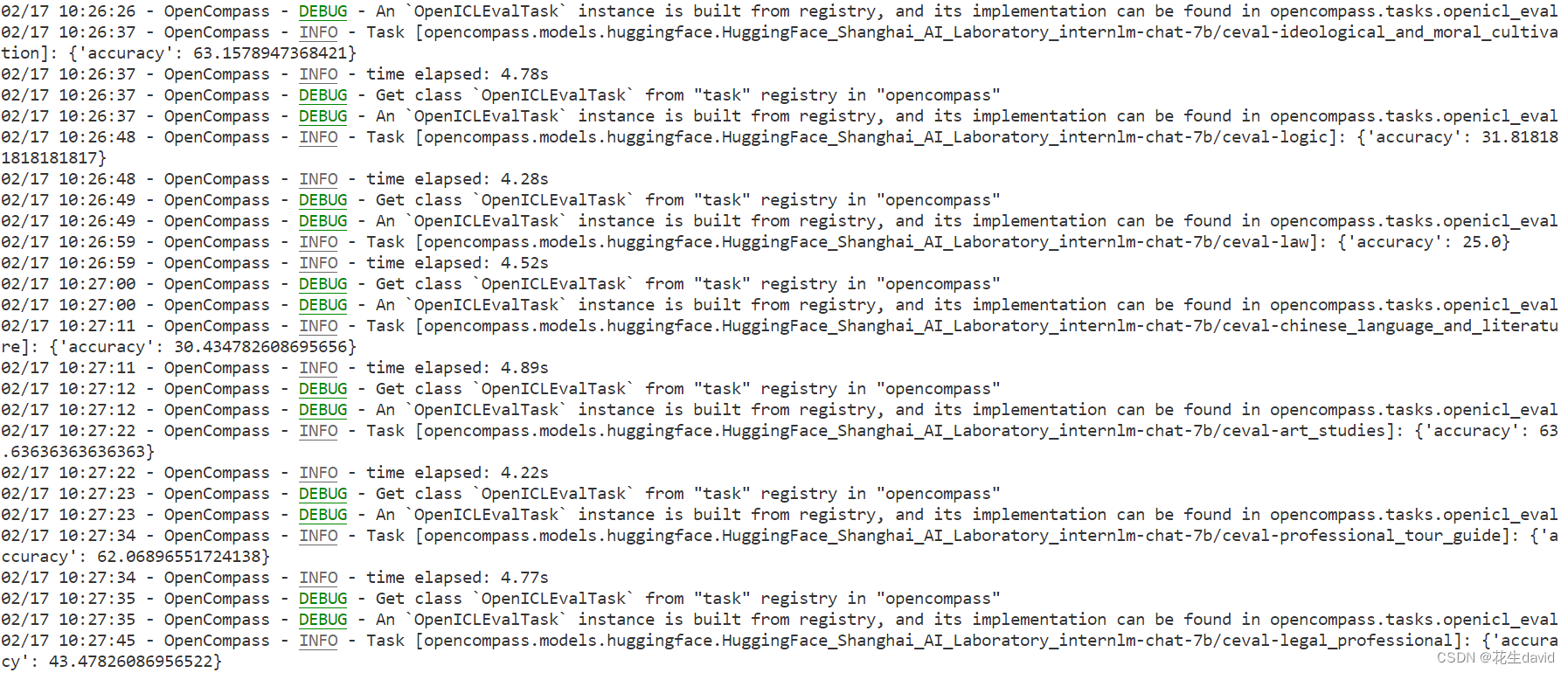

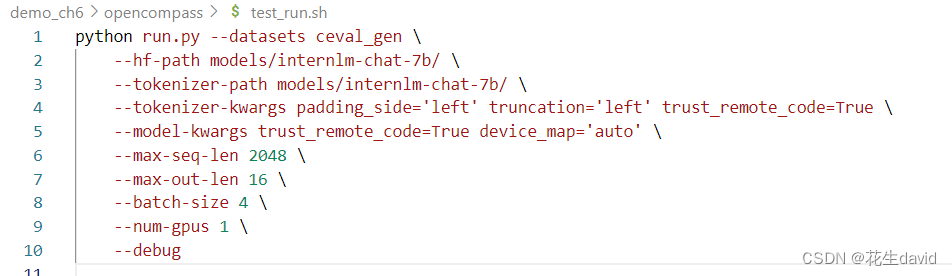

把上面的评测脚本写进test_tun.sh,然后bash运行,如果一切正常,您应该看到屏幕上显示 “Starting inference process”:

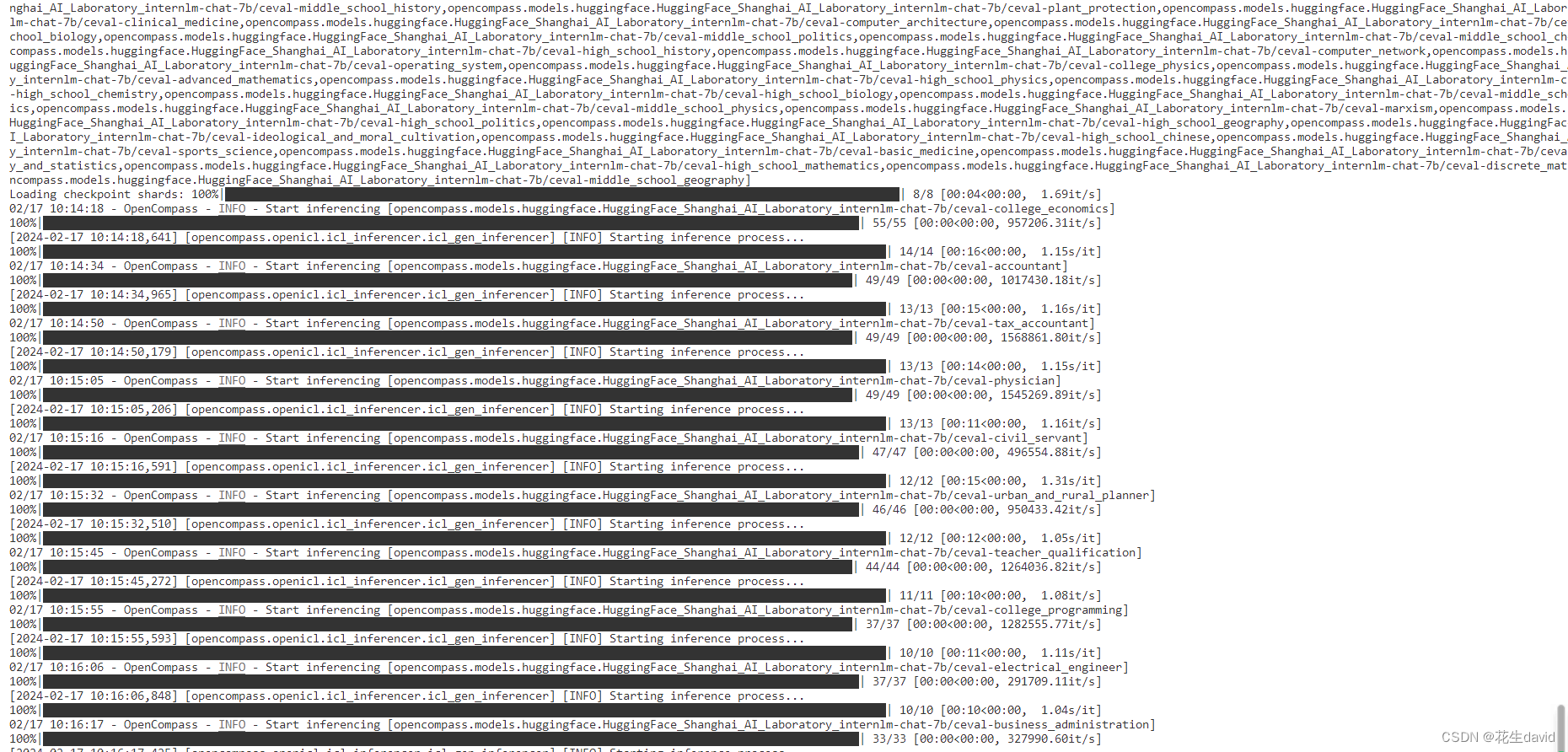

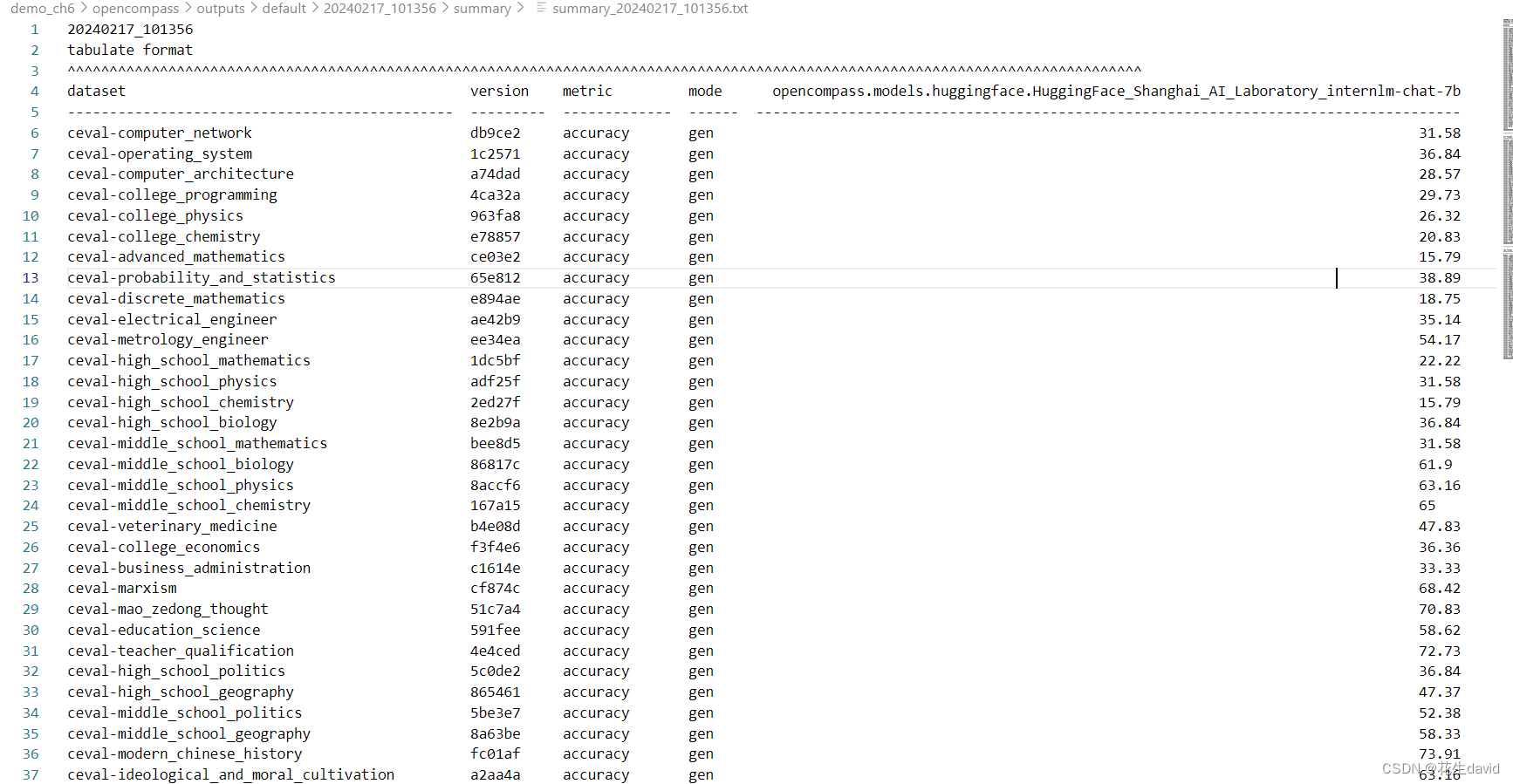

评测结果

评测完成后,将会看到:

视频教程里面只评测了一个子集,小编运行的时候没有修改数据集配置文件demo_ch6/opencompass/configs/datasets/ceval/ceval_gen_5f30c7.py,所以比较慢,附上配置文件详情:

from opencompass.openicl.icl_prompt_template import PromptTemplate

from opencompass.openicl.icl_retriever import FixKRetriever

from opencompass.openicl.icl_inferencer import GenInferencer

from opencompass.openicl.icl_evaluator import AccEvaluator

from opencompass.datasets import CEvalDataset

from opencompass.utils.text_postprocessors import first_capital_postprocess

ceval_subject_mapping = {

'computer_network': ['Computer Network', '计算机网络', 'STEM'],

'operating_system': ['Operating System', '操作系统', 'STEM'],

'computer_architecture': ['Computer Architecture', '计算机组成', 'STEM'],

'college_programming': ['College Programming', '大学编程', 'STEM'],

'college_physics': ['College Physics', '大学物理', 'STEM'],

'college_chemistry': ['College Chemistry', '大学化学', 'STEM'],

'advanced_mathematics': ['Advanced Mathematics', '高等数学', 'STEM'],

'probability_and_statistics': ['Probability and Statistics', '概率统计', 'STEM'],

'discrete_mathematics': ['Discrete Mathematics', '离散数学', 'STEM'],

'electrical_engineer': ['Electrical Engineer', '注册电气工程师', 'STEM'],

'metrology_engineer': ['Metrology Engineer', '注册计量师', 'STEM'],

'high_school_mathematics': ['High School Mathematics', '高中数学', 'STEM'],

'high_school_physics': ['High School Physics', '高中物理', 'STEM'],

'high_school_chemistry': ['High School Chemistry', '高中化学', 'STEM'],

'high_school_biology': ['High School Biology', '高中生物', 'STEM'],

'middle_school_mathematics': ['Middle School Mathematics', '初中数学', 'STEM'],

'middle_school_biology': ['Middle School Biology', '初中生物', 'STEM'],

'middle_school_physics': ['Middle School Physics', '初中物理', 'STEM'],

'middle_school_chemistry': ['Middle School Chemistry', '初中化学', 'STEM'],

'veterinary_medicine': ['Veterinary Medicine', '兽医学', 'STEM'],

'college_economics': ['College Economics', '大学经济学', 'Social Science'],

'business_administration': ['Business Administration', '工商管理', 'Social Science'],

'marxism': ['Marxism', '马克思主义基本原理', 'Social Science'],

'mao_zedong_thought': ['Mao Zedong Thought', '毛泽东思想和中国特色社会主义理论体系概论', 'Social Science'],

'education_science': ['Education Science', '教育学', 'Social Science'],

'teacher_qualification': ['Teacher Qualification', '教师资格', 'Social Science'],

'high_school_politics': ['High School Politics', '高中政治', 'Social Science'],

'high_school_geography': ['High School Geography', '高中地理', 'Social Science'],

'middle_school_politics': ['Middle School Politics', '初中政治', 'Social Science'],

'middle_school_geography': ['Middle School Geography', '初中地理', 'Social Science'],

'modern_chinese_history': ['Modern Chinese History', '近代史纲要', 'Humanities'],

'ideological_and_moral_cultivation': ['Ideological and Moral Cultivation', '思想道德修养与法律基础', 'Humanities'],

'logic': ['Logic', '逻辑学', 'Humanities'],

'law': ['Law', '法学', 'Humanities'],

'chinese_language_and_literature': ['Chinese Language and Literature', '中国语言文学', 'Humanities'],

'art_studies': ['Art Studies', '艺术学', 'Humanities'],

'professional_tour_guide': ['Professional Tour Guide', '导游资格', 'Humanities'],

'legal_professional': ['Legal Professional', '法律职业资格', 'Humanities'],

'high_school_chinese': ['High School Chinese', '高中语文', 'Humanities'],

'high_school_history': ['High School History', '高中历史', 'Humanities'],

'middle_school_history': ['Middle School History', '初中历史', 'Humanities'],

'civil_servant': ['Civil Servant', '公务员', 'Other'],

'sports_science': ['Sports Science', '体育学', 'Other'],

'plant_protection': ['Plant Protection', '植物保护', 'Other'],

'basic_medicine': ['Basic Medicine', '基础医学', 'Other'],

'clinical_medicine': ['Clinical Medicine', '临床医学', 'Other'],

'urban_and_rural_planner': ['Urban and Rural Planner', '注册城乡规划师', 'Other'],

'accountant': ['Accountant', '注册会计师', 'Other'],

'fire_engineer': ['Fire Engineer', '注册消防工程师', 'Other'],

'environmental_impact_assessment_engineer': ['Environmental Impact Assessment Engineer', '环境影响评价工程师', 'Other'],

'tax_accountant': ['Tax Accountant', '税务师', 'Other'],

'physician': ['Physician', '医师资格', 'Other'],

}

ceval_all_sets = list(ceval_subject_mapping.keys())

ceval_datasets = []

for _split in ["val"]:

for _name in ceval_all_sets:

_ch_name = ceval_subject_mapping[_name][1]

ceval_infer_cfg = dict(

ice_template=dict(

type=PromptTemplate,

template=dict(

begin="</E>",

round=[

dict(

role="HUMAN",

prompt=

f"以下是中国关于{

_ch_name}考试的单项选择题,请选出其中的正确答案。\n{

{question}}\nA. {

{A}}\nB. {

{B}}\nC. {

{C}}\nD. {

{D}}\n答案: "

),

dict(role="BOT", prompt="{answer}"),

]),

ice_token="</E>",

),

retriever=dict(type=FixKRetriever, fix_id_list=[0, 1, 2, 3, 4]),

inferencer=dict(type=GenInferencer),

)

ceval_eval_cfg = dict(

evaluator=dict(type=AccEvaluator),

pred_postprocessor=dict(type=first_capital_postprocess))

ceval_datasets.append(

dict(

type=CEvalDataset,

path="./data/ceval/formal_ceval",

name=_name,

abbr="ceval-" + _name if _split == "val" else "ceval-test-" +

_name,

reader_cfg=dict(

input_columns=["question", "A", "B", "C", "D"],

output_column="answer",

train_split="dev",

test_split=_split),

infer_cfg=ceval_infer_cfg,

eval_cfg=ceval_eval_cfg,

))

del _split, _name, _ch_name

如果想快一点看结果的话,修改下第8行ceval_subject_mapping =即可,可以只看自己关心的子数据集的评测结果~

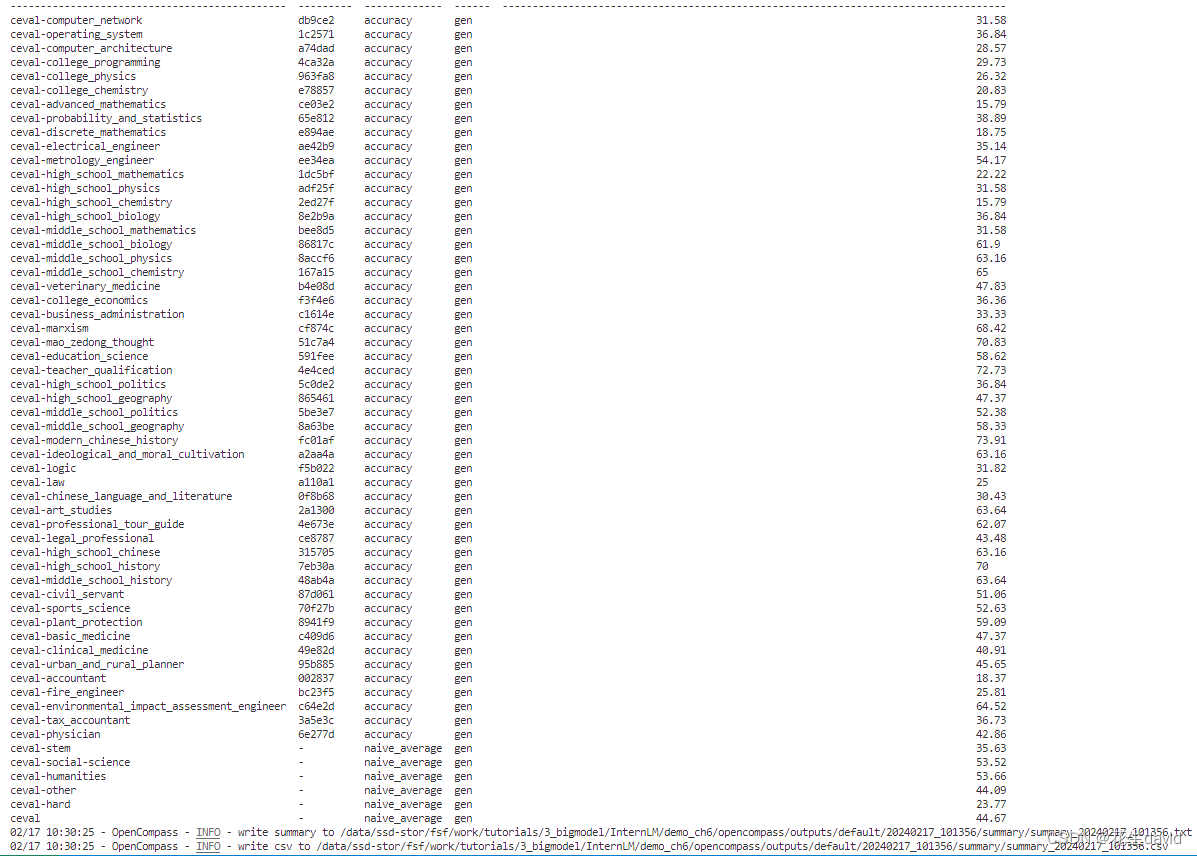

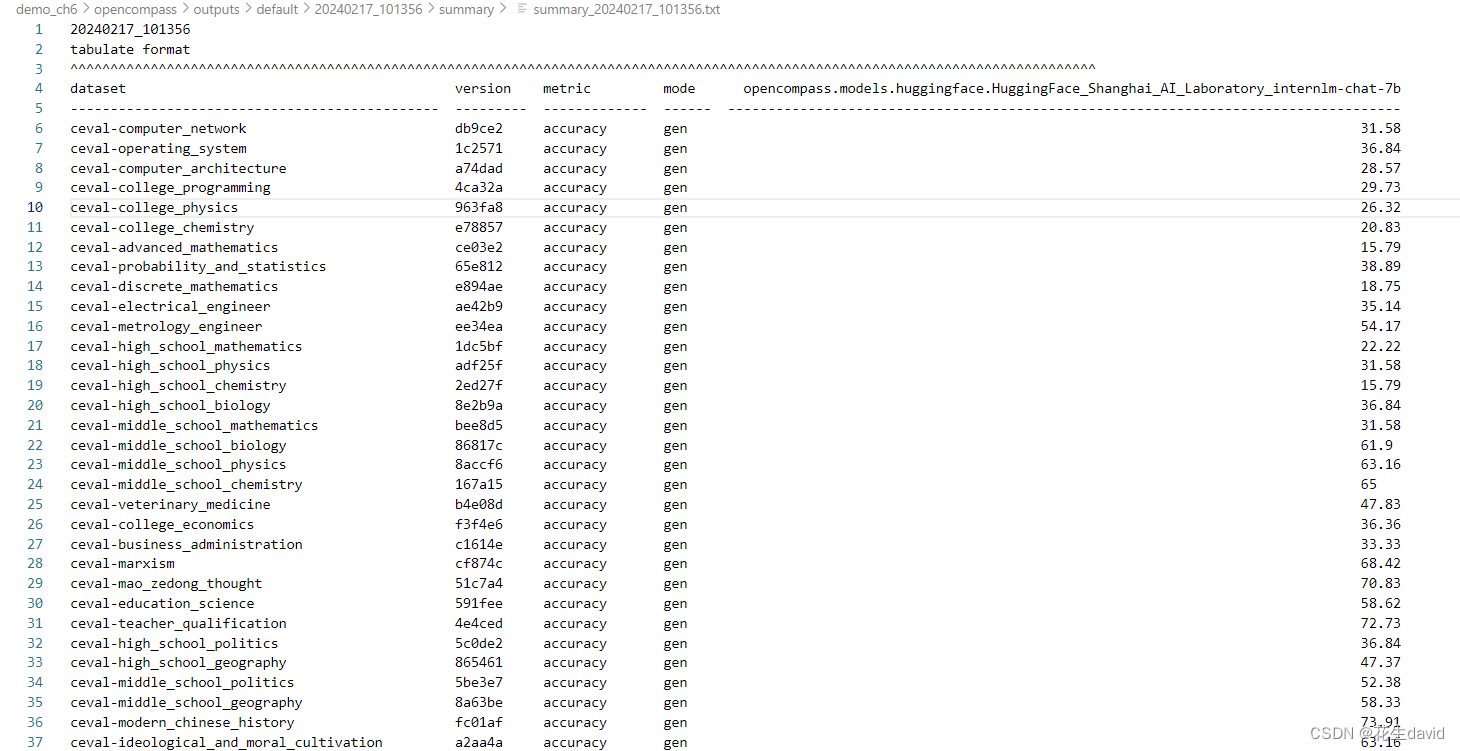

稍微等了几分钟,最终所有数据集的评测结果也出来了:

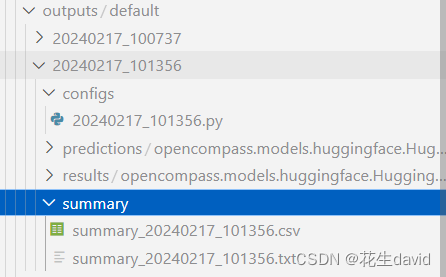

上面是打印出来的结果,也可以到模型输出路径demo_ch6/opencompass/outputs/default/20240217_101356/summary下面找找有输出的csv和txt评测结果文件:

评估结果文件说明

评估完成后,评估结果表格将打印如下:

dataset version metric mode opt350m opt125m

--------- --------- -------- ------ --------- ---------

siqa e78df3 accuracy gen 21.55 12.44

winograd b6c7ed accuracy ppl 51.23 49.82

所有运行输出将定向到 outputs 目录,结构如下:

outputs/default/

├── 20200220_120000

├── 20230220_183030 # 每个实验一个文件夹

│ ├── configs # 用于记录的已转储的配置文件。如果在同一个实验文件夹中重新运行了不同的实验,可能会保留多个配置

│ ├── logs # 推理和评估阶段的日志文件

│ │ ├── eval

│ │ └── infer

│ ├── predictions # 每个任务的推理结果

│ ├── results # 每个任务的评估结果

│ └── summary # 单个实验的汇总评估结果

├── ...

打印评测结果的过程可被进一步定制化,用于输出一些数据集的平均分 (例如 MMLU, C-Eval 等)。

这次运行示例输出如下所示:

关于评测结果输出的更多介绍可阅读 结果展示。

评测配置文件详解

**有关 run.py 支持的所有与 HuggingFace 相关的参数,请阅读 评测任务发起

除了通过命令行配置实验外,OpenCompass 还允许用户在配置文件中编写实验的完整配置,并通过 run.py 直接运行它。配置文件是以 Python 格式组织的,并且必须包括 datasets 和 models 字段。

这个配置文件跟mmdet等openmmlab开源库的风格基本是一致的

示例测试配置在 configs/eval_demo.py 中。此配置通过 继承机制 引入所需的数据集和模型配置,并以所需格式组合 datasets 和 models 字段。

from mmengine.config import read_base

with read_base():

from .datasets.siqa.siqa_gen import siqa_datasets

from .datasets.winograd.winograd_ppl import winograd_datasets

from .models.opt.hf_opt_125m import opt125m

from .models.opt.hf_opt_350m import opt350m

datasets = [*siqa_datasets, *winograd_datasets]

models = [opt125m, opt350m]

运行任务时,我们只需将配置文件的路径传递给 run.py:

python run.py configs/eval_demo.py

OpenCompass 提供了一系列预定义的模型配置,位于 configs/models 下。以下是与 opt-350m(configs/models/opt/hf_opt_350m.py)相关的配置片段:

# 使用 `HuggingFaceCausalLM` 评估由 HuggingFace 的 `AutoModelForCausalLM` 支持的模型

from opencompass.models import HuggingFaceCausalLM

# OPT-350M

opt350m = dict(

type=HuggingFaceCausalLM,

# `HuggingFaceCausalLM` 的初始化参数

path='facebook/opt-350m',

tokenizer_path='facebook/opt-350m',

tokenizer_kwargs=dict(

padding_side='left',

truncation_side='left',

proxies=None,

trust_remote_code=True),

model_kwargs=dict(device_map='auto'),

# 下面是所有模型的共同参数,不特定于 HuggingFaceCausalLM

abbr='opt350m', # 结果显示的模型缩写

max_seq_len=2048, # 整个序列的最大长度

max_out_len=100, # 生成的最大 token 数

batch_size=64, # 批量大小

run_cfg=dict(num_gpus=1), # 该模型所需的 GPU 数量

)

使用配置时,我们可以通过命令行参数 --models 指定相关文件,或使用继承机制将模型配置导入到配置文件中的 models 列表中。

与模型类似,数据集的配置文件也提供在 configs/datasets 下。用户可以在命令行中使用 --datasets,或通过继承在配置文件中导入相关配置

下面是来自 configs/eval_demo.py 的与数据集相关的配置片段:

from mmengine.config import read_base # 使用 mmengine.read_base() 读取基本配置

with read_base():

# 直接从预设的数据集配置中读取所需的数据集配置

from .datasets.winograd.winograd_ppl import winograd_datasets # 读取 Winograd 配置,基于 PPL(困惑度)进行评估

from .datasets.siqa.siqa_gen import siqa_datasets # 读取 SIQA 配置,基于生成进行评估

datasets = [*siqa_datasets, *winograd_datasets] # 最终的配置需要包含所需的评估数据集列表 'datasets'

数据集配置通常有两种类型:‘ppl’ 和 ‘gen’,分别指示使用的评估方法。其中 ppl 表示辨别性评估,gen 表示生成性评估。

此外,configs/datasets/collections 收录了各种数据集集合,方便进行综合评估。OpenCompass 通常使用 base_medium.py 进行全面的模型测试。要复制结果,只需导入该文件,例如:

python run.py --models hf_llama_7b --datasets base_medium

OpenCompass 通常假定运行环境网络是可用的。如果您遇到网络问题或希望在离线环境中运行 OpenCompass,请参阅 FAQ - 网络 - Q1 寻求解决方案。

基础作业

- 使用 OpenCompass 评测 InternLM2-Chat-7B 模型在 C-Eval 数据集上的性能

上面的教程本地复现部分已经完成了基础作业,评测命令如下:

评测结果再贴一下:

进阶作业

- 使用 OpenCompass 评测 InternLM2-Chat-7B 模型使用 LMDeploy 0.2.0 部署后在 C-Eval 数据集上的性能

首先安装LMDeploy:

pip install lmdeploy

OpenCompass 支持分别通过 turbomind python API 评测数据集。

以 InternLM-7B 模型为例,介绍如何评测。首先我们准备好测试配置文件configs/eval_internlm_turbomind.py,这个其实opencompass已经帮我们准备好了,只需要修改下需要评测的模型即可,具体如下:

from mmengine.config import read_base

from opencompass.models.turbomind import TurboMindModel

with read_base():

# choose a list of datasets

from .datasets.mmlu.mmlu_gen_a484b3 import mmlu_datasets

from .datasets.ceval.ceval_gen_5f30c7 import ceval_datasets

from .datasets.SuperGLUE_WiC.SuperGLUE_WiC_gen_d06864 import WiC_datasets

from .datasets.triviaqa.triviaqa_gen_2121ce import triviaqa_datasets

from .datasets.gsm8k.gsm8k_gen_1d7fe4 import gsm8k_datasets

from .datasets.humaneval.humaneval_gen_8e312c import humaneval_datasets

# and output the results in a choosen format

from .summarizers.medium import summarizer

datasets = sum((v for k, v in locals().items() if k.endswith('_datasets')), [])

# # config for internlm-7b model

internlm_7b = dict(

type=TurboMindModel,

abbr='internlm-7b-turbomind',

path="internlm/internlm-7b",

engine_config=dict(session_len=2048,

max_batch_size=32,

rope_scaling_factor=1.0),

gen_config=dict(top_k=1,

top_p=0.8,

temperature=1.0,

max_new_tokens=100),

max_out_len=100,

max_seq_len=2048,

batch_size=32,

concurrency=32,

run_cfg=dict(num_gpus=1, num_procs=1),

)

# config for internlm-20b model

internlm_20b = dict(

type=TurboMindModel,

abbr='internlm-20b-turbomind',

path="internlm/internlm-20b",

engine_config=dict(session_len=2048,

max_batch_size=8,

rope_scaling_factor=1.0),

gen_config=dict(top_k=1, top_p=0.8,

temperature=1.0,

max_new_tokens=100),

max_out_len=100,

max_seq_len=2048,

batch_size=8,

concurrency=8,

run_cfg=dict(num_gpus=1, num_procs=1),

)

models = [internlm_7b]

然后,在 OpenCompass 的项目目录下,执行如下命令可得到评测结果:

python run.py configs/eval_internlm_turbomind.py -w outputs/turbomind/internlm-7b

注:

- 如果想在测评配置文件中

engine_config和gen_config字段传递更多参数,请参考TurbomindEngineConfig 和 EngineGenerationConfig - 如果评测 InternLM Chat 模型,请使用配置文件

eval_internlm_chat_turbomind.py - 如果评测 InternLM 20B 模型,请修改

eval_internlm_turbomind.py或者eval_internlm_chat_turbomind.py。将models字段配置为models = [internlm_20b]。