上个月刚刚推出的英特尔新一代Meteor Lake CPU,预示着AI PC的新时代到来。AI PC可以不依赖服务器直接在PC端处理AI推理工作负载,例如生成图像或转录音频。这些芯片的正式名称为Intel Core Ultra处理器,是首款配备专门用于处理人工智能任务的 NPU(神经处理单元)的芯片。

为了更好地了解Meteor Lake CPU,我们测试了英特尔适用于 Audacity 和 GIMP(开源音频和图像编辑器)的 OpenVINO 插件和其它相关的AI应用,包含仅 CPU 模式、NPU 模式和 GPU 模式下运行了所有测试。我们进行的测试有:

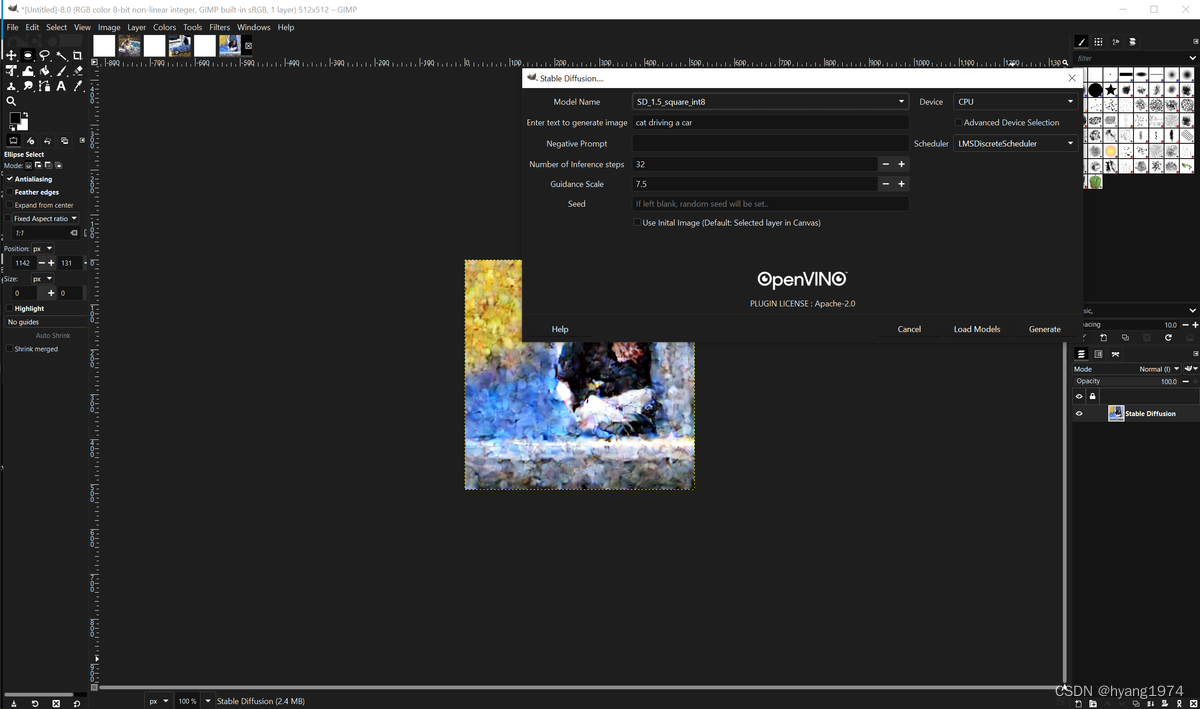

- OpenVINO Stable Diffusion:在 GIMP 中生成图像。

- OpenVINO Noise Reduction:消除 Audacity 中的背景噪音。

- OpenVINO Music Generation: Audacity 中的文本转音乐功能。

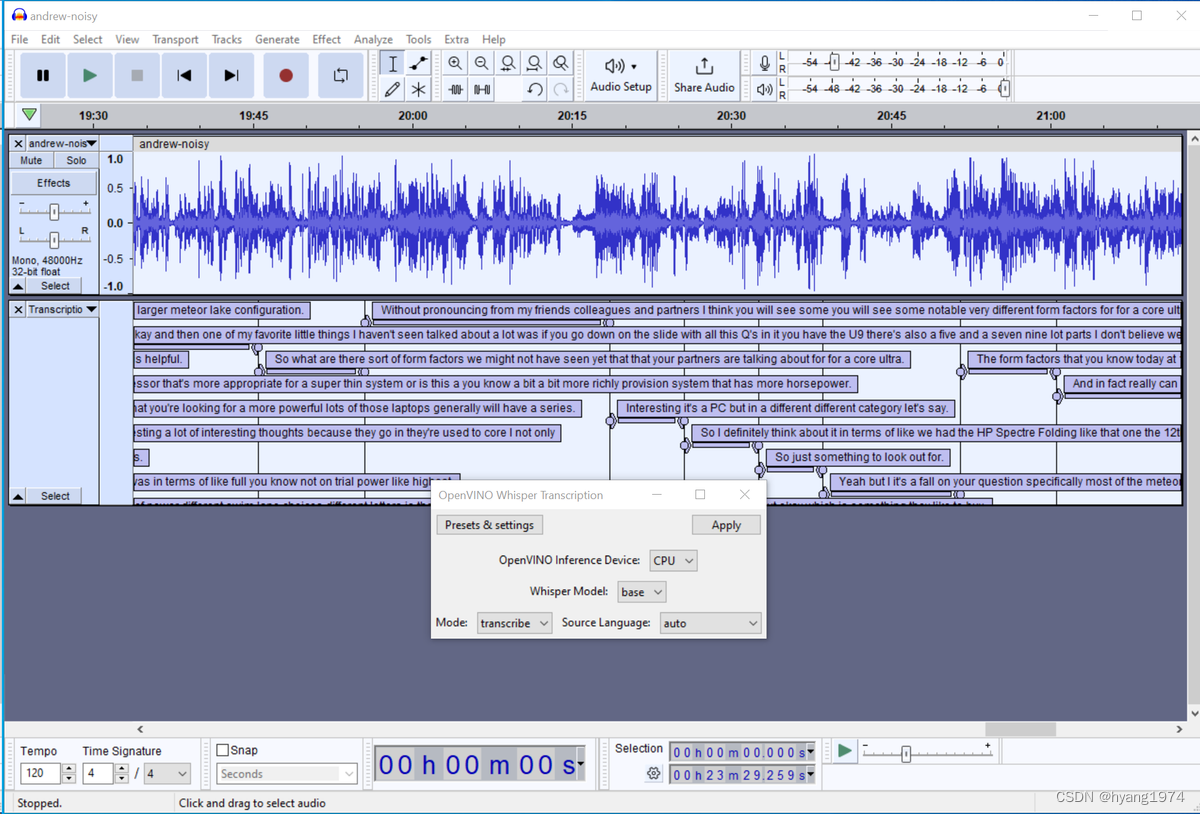

- OpenVINO Whisper Transcription:在 Audacity 中将音频转录为文本。

OpenVINO™是英特尔针对自家硬件平台开发的一套深度学习工具库,包含推断库,模型优化等等一系列与深度学习模型部署相关的功能。OpenVINO™工具包是用于快速开发应用程序和解决方案的综合工具包,可解决各种任务,包括模拟人类视觉,自动语音识别,自然语言处理,推荐系统等。该工具包基于最新一代的人工神经网络,包括卷积神经网络(CNN),循环和基于注意力的网络,可在英特尔®硬件上扩展计算机视觉和非视觉工作负载,从而最大限度地提高性能。它通过从边缘到云的高性能,人工智能和深度学习推理来加速应用程序。OpenVINO 插件专门识别 Meteor Lake 笔记本电脑的 NPU 并将其作为设备选项呈现。值得注意的是,虽然 OpenVINO 软件/插件可以在任何 x86 硬件上运行,最新的几个版本甚至加入了对Arm平台的支持,但它们专门针对 Intel CPU 和 GPU 进行了优化所以会有更好的性能。

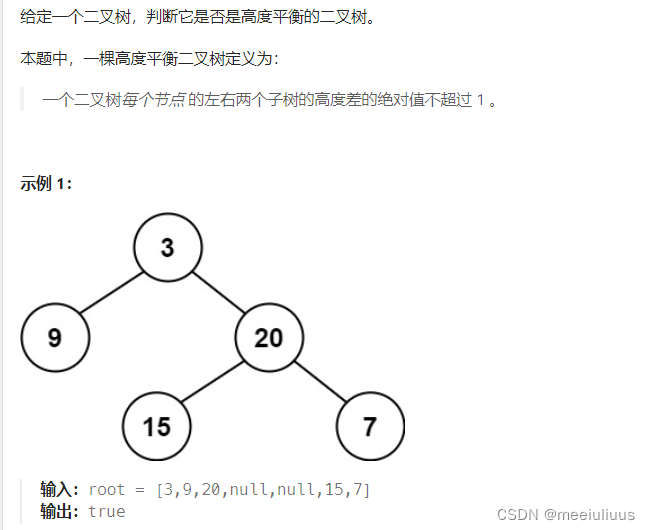

测试 1:基于Stable Diffusion的GIMP 图像生成

为 GIMP 安装英特尔的 OpenVINO 插件是一项相对复杂的任务,本文不包含如何在GIMP里安装OpenVINO插件,具体的安装过程我会再写另外一篇博文来阐述,也可参阅此Github项目。插件安装设置完成后,GIMP 将具有四个 OpenVINO 插件:Semantic-Segmentation、Style-Transfer、Super-Resolution和Stable-Diffusion。

Stable-Diffusion for GIMP 是一个图像生成器,需要 十几 秒到几分钟才能输出图像。在Stable-Diffusion里可以选择多种不同的模型,我们在测试中选择了 SD_1_5_square_int8,因为它是目前能支持Meteor Lake NPU 作为输出设备的模型之一。测试中发现SD_1_5_square_int8 的输出有点难看,因为它给你的看起来像是凌乱的手指画,而不是逼真的图像,但重点是看看它完成每项任务的速度有多快。

在使用Stable-Diffusion SD_1_5_square_int8 模型中,我们可以在Meteor Lake上选择四种不同的设备来处理输出的不同部分:Text部分使用GPU,Unet+使用GPU,Unet-使用NPU, VAE使用CPU。所有四个设备可以是相同的,也可以切换它们。

当我们同时使用GPU和NPU时,在Meteor Lake 笔记本电脑上生成图像仅花费 16 秒。当我们单独使用 GPU 时,这些时间增加了几秒,而当我们使用 NPU 时,这些时间几乎增加了一倍(31秒)。单独使用 CPU 的时间是最高的,分别为 59.5 秒和 61 秒。

下图是使用SD_1_5_square_int8 模型驾驶汽车的猫时,会得到下图这样的结果。如果想要更好看的输出,则需要使用SD_1_5_square 等模型,它可以生成逼真的图像,但是这个模型目前还没有NPU的支持。

测试 2:Whisper Transcription

Audacity OpenVINO Whisper Transcription 插件将使用您的 CPU、GPU 或 NPU将剪辑中的语音转换为带有时间戳的文本文件。我们在测试中使用 Open AI 的 Whisper AI基本转录模型,因为这是插件内置的模型。两台Meteor Lake测试平台完成的时间为48.8秒和52.1秒。考虑到源材料的长度是原来的 23 倍以上,这已经相当不错了。

测试 3:Audacity OpenVINO Noise Reduction

Audacity 插件 OpenVINO 噪声抑制可消除剪辑中的背景噪声。因此,我们选取了用于转录的23 分钟音频片段,并在其上运行了噪声抑制插件。运行噪声抑制插件时,可以选择 CPU、GPU 或 NPU 作为处理设备。但每次转录只能使用一个设备,因此不会混合 GPU 和 NPU 或 CPU 和 GPU。两台Meteor Lake测试机器的完成时间分别为934秒和1054秒。

这是一个相当 CPU 密集型的工作负载,因为我们看到处于 CPU 模式的笔记本电脑的工作负载最高。在 NPU 上运行并没有什么帮助。 Swift Go 和 IdeaPad Pro 5i 在 NPU 模式下运行速度都非常慢。

测试 4:OpenVINO Music Generation

Audacity 的其他有趣的 OpenVINO 插件之一使用 Stable Audio(Stability AI 的音乐模型)根据文本提示生成曲调。在我们的测试中,要求一首 30 秒的歌曲,提示为“爵士乐”,6 个插值步骤和 20 个推理步骤。这里有五种不同的设备设置:Text Encoder Device、Unet + Device、Unet – Device、VAE Decoder Device和 VAE Encoder Device。您可以选择 CPU、GPU 或(在 Unet + / – 上)NPU。 两台Meteor Lake的测试成绩分别为55秒和57秒。

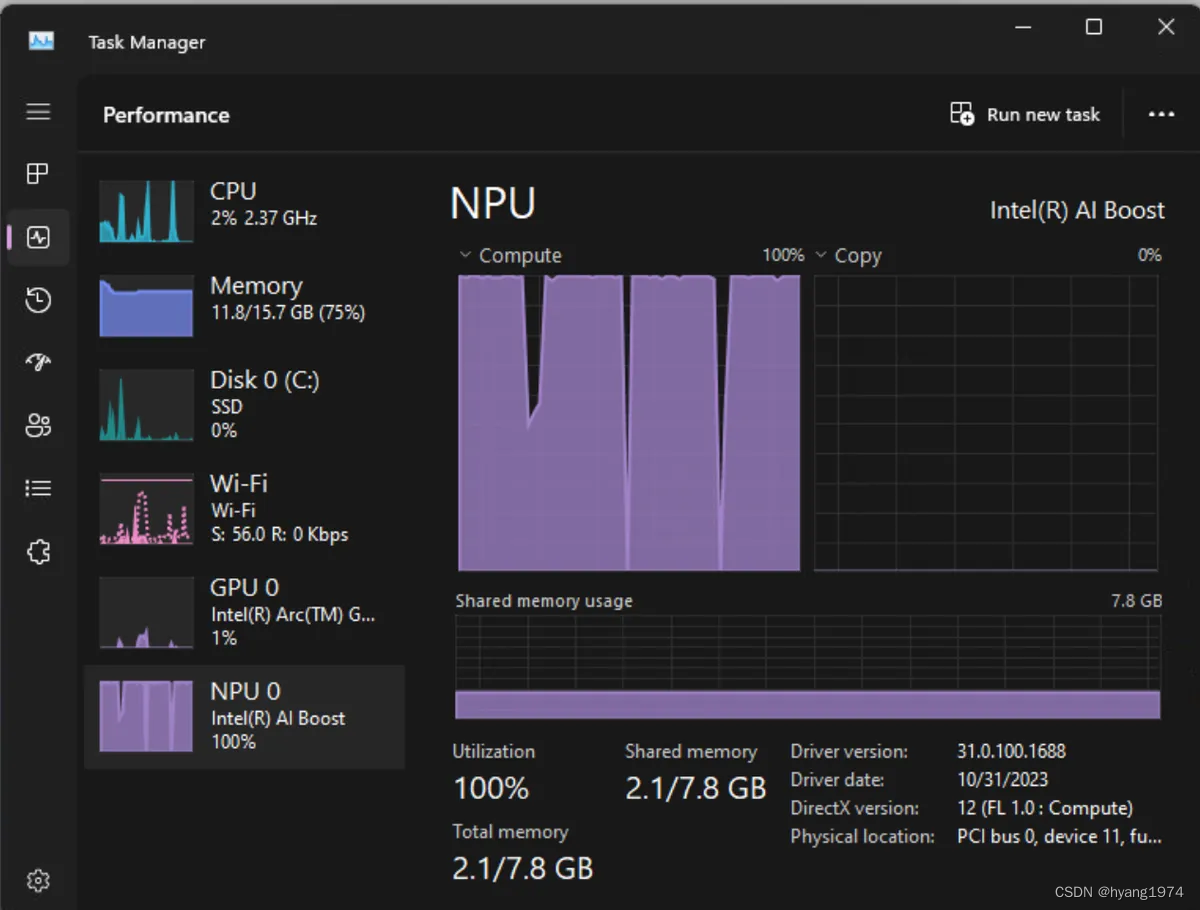

NPU 减轻 CPU 负担

NPU还有另外一个更大的价值在我们前面的测试中并未体现出来,那就是它如何减轻 CPU 的负载。例如,当我们在 Acer Swift 14 Go 上运行 NPU 专用工作负载并打开任务管理器时,CPU 利用率仅为 2%,而 NPU 利用率为 100%。

但当我在 CPU 模式下运行相同的工作负载时,处理器在任务期间被固定在 60%。

由此可见,当把AI的工作负载放到NPU上执行时,能极大地释放CPU的工作量。如果我们不插电,依靠 NPU 可能会节省电量以延长电池寿命。此外,随着 NPU 承担 AI 工作负载,CPU 可以自由地做其他事情。

作者的个人Blog(HY's Blog):https://blog.yanghong.dev