目录

在Python中,网络爬虫是一个重要的应用领域。为了实现网络爬虫,Python提供了许多库来发送HTTP请求和处理响应。其中,urllib和requests是两个最常用的库。它们都能够帮助开发人员轻松地获取网页内容,但在使用方式、功能和效率上存在一些差异。本文将深入探讨这两个库的区别,帮助你更好地选择适合你的项目的库。

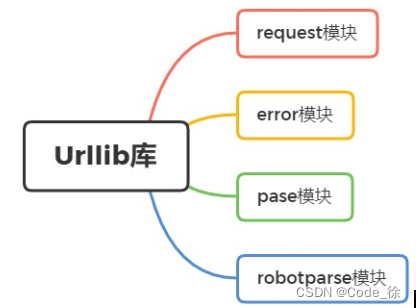

一、urllib库

urllib是Python标准库中的一个模块,用于发送HTTP请求。它提供了一个简单的接口来发送GET、POST等请求,并获取响应。

1、使用方法

使用urllib发送一个简单的GET请求的示例代码如下:

import urllib.request

url = 'http://example.com'

response = urllib.request.urlopen(url)

data = response.read()上述代码中,我们首先导入了urllib.request模块,然后定义了要请求的URL。接着,使用urlopen()函数发送GET请求,并将返回的响应对象存储在变量response中。最后,使用read()方法读取响应内容并存储在变量data中。

2、功能

urllib提供了一些基本的HTTP请求方法,如GET、POST、PUT、DELETE等。它还支持设置请求头和请求体等高级功能。但相对于requests库,urllib的用法更加底层和繁琐,需要手动处理更多的细节。例如,要设置请求头或请求体,你需要手动构建一个复杂的请求对象,并在发送请求时传递该对象。此外,urllib没有提供自动捕获异常、处理cookies、session管理等功能。

3、效率

由于urllib是Python标准库的一部分,因此它在处理请求时的性能比较稳定。但是,与requests相比,urllib的效率可能较低,因为它的API相对较为繁琐,需要更多的代码来实现相同的功能。此外,urllib没有连接池管理功能,每次请求都需要建立新的连接,这可能会导致性能下降。

二、requests库

requests库是一个第三方库,它为发送HTTP请求提供了更加简洁和人性化的API。与urllib相比,requests更加流行,因为它更加易用和功能强大。

1、使用方法

使用requests发送一个简单的GET请求的示例代码如下:

import requests

url = 'http://example.com'

response = requests.get(url)

data = response.text上述代码中,我们首先导入了requests模块,然后定义了要请求的URL。接着,使用get()函数发送GET请求,并将返回的响应对象存储在变量response中。最后,使用text属性获取响应内容并存储在变量data中。requests库的使用方法比urllib更加简洁明了,开发人员可以更加快速地编写代码。

2、功能

requests库提供了更加高级的API,可以更方便地设置请求头、请求体、处理cookies、处理session等。它还支持自动转换JSON数据、处理异常等。此外,requests还支持连接池管理和自动捕获异常等功能,使得开发人员可以更加专注于业务逻辑的实现。例如,要设置请求头或请求体,你可以直接传递一个字典作为参数给相应的函数或方法,而不需要手动构建请求对象。此外,requests还提供了许多有用的方法和属性来处理响应内容,如json()方法用于解析JSON数据、cookies属性用于获取或设置cookies等。这些功能使得开发人员可以更加高效地编写网络爬虫程序。

3、效率

requests库的性能通常比urllib更加优秀。由于它使用了连接池来复用TCP连接,因此在发送大量请求时可以显著提高效率。此外,requests还对请求进行了优化,可以更快地获取响应内容。因此,在开发大规模网络爬虫或需要高效率的网络请求时,建议使用requests库。requests库还支持多线程和多进程等功能,可以在多个线程或进程中同时发送请求,进一步提高程序的性能和并发能力。这些功能使得requests成为Python网络爬虫中的首选库之一。

三、总结与建议

通过对比urllib和requests两个库,我们可以发现它们在功能、使用方式和效率上存在差异。urllib作为Python标准库的一部分,具有稳定性和可靠性,但其API相对繁琐,需要更多的代码来实现相同的功能。而requests作为第三方库,提供了更加简洁和人性化的API,具有丰富的功能和高效的性能。在实际项目中,选择哪个库取决于具体需求。

如果你只需要发送基本的HTTP请求并且对性能要求不高,可以使用urllib库。它的标准库地位也意味着无需额外安装任何依赖,这对于某些环境可能是一个优势。但如果你需要更加高级的API和更好的性能,建议使用requests库。requests库的易用性和功能强大使得开发人员可以更加高效地编写网络爬虫程序。

在选择库时,还需要考虑其他因素,如社区支持、文档完善度和兼容性等。requests库拥有庞大的用户基础和活跃的社区,这意味着你可以找到丰富的资源和支持。同时,它有详细的文档和示例代码,方便开发人员学习和使用。此外,requests库与Python其他流行库的兼容性良好,可以方便地与其他库集成。

总的来说,选择urllib还是requests主要取决于具体需求和项目要求。如果你需要高效、易用且功能丰富的网络爬虫库,requests是更好的选择。它提供了简洁的API和强大的功能,使得开发人员可以更加专注于业务逻辑的实现。然而,如果你对性能有特别高的要求或者在某些特殊的环境下必须使用标准库,那么urllib可能更适合你的项目。在任何情况下,都应根据实际需求评估不同库的优势和不足,并选择最适合的库来满足项目需求。