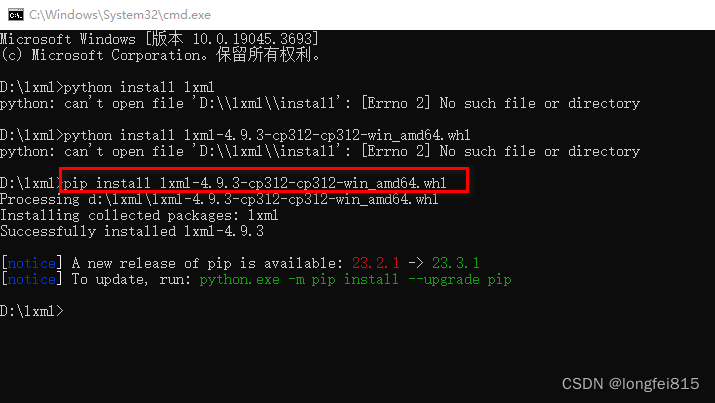

if params.grad is not None:

params.grad.zero_()

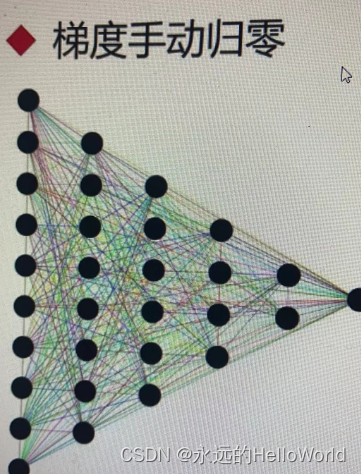

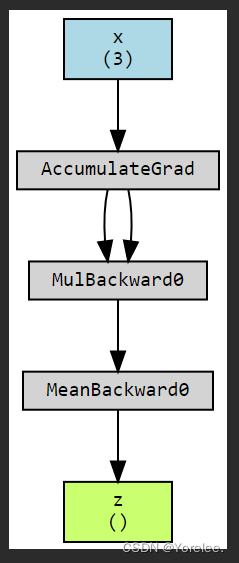

我们实际的运算往往会涉及到若干个requires-grad为true的张量进行运算,在这种情况下,Pytorch会计算整个计算图上的损失的导数,并把这些结果累加到grad属性中。多次调用backward()会导致梯度的错误累积。如果要防止这个问题发生,我们需要在每次迭代的时候手动的把梯度置为零。

Demo的例子

import torch

t_c=torch.tensor([0.5,14.0,15.0,28.0,11.0,8.0,3.0,-4.0,6.0,13.0,21.0])

t_u=torch.tensor([35.7,55.9,58.2,81.9,56.3,48.9,33.9,21.8,48.4,60.4,68.4])

t_un=0.1*t_u

#定义模型

def model(t_u,w,b):

return w*t_u+b

#定义损失函数

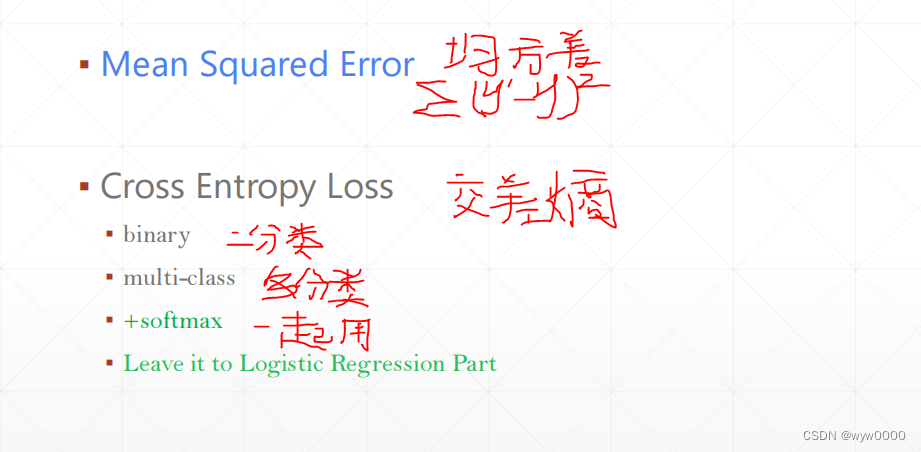

def loss_fn(t_p,t_c):

squared_diffs=(t_p-t_c)**2

return squared_diffs.mean()

#唯一改变

params=torch.tensor([1.0,0.0])

params.requires_grad=True

print(params)

#反向传播

loss= loss_fn(model(t_u,*params),t_c)

print(loss)

#对loss 进行反向传播

loss.backward()

#输出params的梯度看看

params.grad

![neuq-acm预备队训练week 9 P8604 [蓝桥杯 2013 国 C] 危险系数](https://img-blog.csdnimg.cn/direct/622526fec2cd47cd87b95851cf4a271c.png)