模型转为半精度的会加快推理速度吗

将模型转为半精度(通常指16位浮点数,即FP16)确实可以加快推理速度,同时还能减少显存(GPU内存)的使用。以下是一些关键点:

加快推理速度的原因

减少计算量:

- 半精度浮点数(FP16)比全精度浮点数(FP32)占用的位数少一半,这意味着在同样的时间内,处理器可以处理更多的数据。

提高内存带宽:

- 使用FP16会减少内存传输的带宽需求,因为每个数据点只占用16位而不是32位。这可以减少数据在内存和处理器之间传输的时间,从而提高整体计算效率。

硬件支持:

- 现代GPU(如NVIDIA的Tensor Cores)专门优化了半精度计算,可以在硬件层面上提供显著的性能提升。

减少显存使用

- 内存占用减半:

- 将模型参数和中间激活值从FP32转换为FP16,可以显著减少显存的占用。这对于在有限显存的GPU上运行大模型特别有用。

可能的影响和注意事项

精度损失:

- 使用FP16可能会带来一些数值精度的损失,特别是在梯度较小或较大的情况下。这在推理阶段通常影响较小,但在训练阶段可能需要特别处理。

混合精度训练:

- 在训练过程中,可以使用混合精度训练技术,即在关键计算步骤中使用FP32,以确保数值稳定性,同时在其他步骤中使用FP16,以提高效率。

兼容性:

- 并非所有的硬件和软件框架都完全支持FP16,因此在转换模型之前需要确保所使用的硬件和框架兼容FP16计算。

实践中的应用

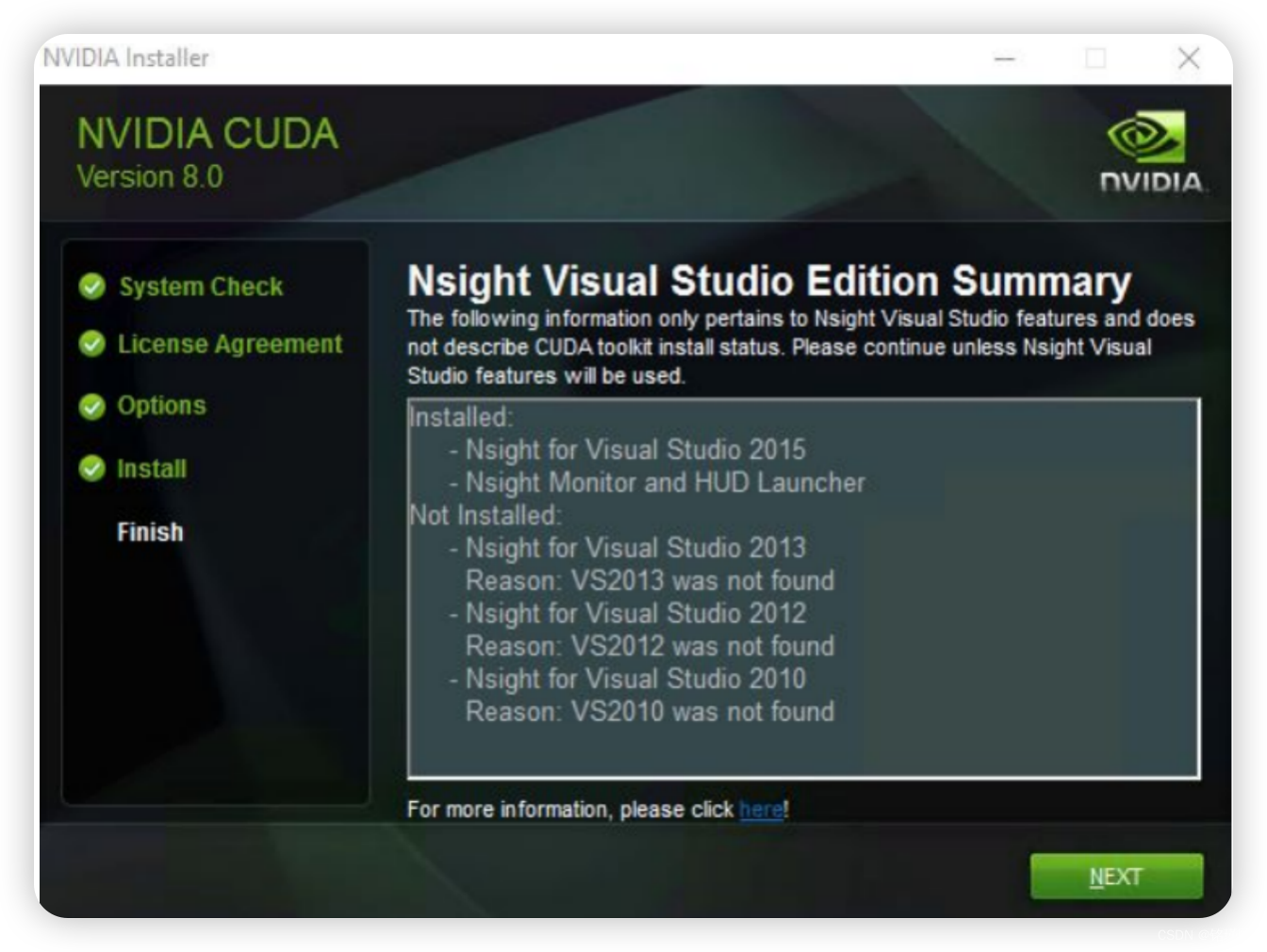

许多深度学习框架(如TensorFlow、PyTorch)都提供了将模型转换为FP16的工具和选项。例如,PyTorch有torch.cuda.amp模块,可以方便地进行混合精度训练和推理。

总结

将模型转为半精度(FP16)确实可以加快推理速度,并减少显存的使用。这种优化特别适用于现代GPU,并且在推理阶段通常不会显著影响模型的性能。然而,在进行这种转换时,需要考虑硬件和软件的兼容性,以及可能的数值精度损失。

将模型转为trt其推理过程能加速,加速的实际原因是什么

将模型转换为TensorRT(TRT)可以显著加速推理过程,主要原因包括以下几个方面:

1. 优化图和层融合

TensorRT会对模型进行图优化和层融合,这些优化包括:

- 节点融合:将多个操作融合成一个操作,以减少内存访问和计算开销。例如,将卷积、批归一化和激活函数融合成一个操作。

- 消除冗余计算:移除不必要的计算节点和操作。

- 重排序操作:根据硬件的特性重新排列操作顺序,以提高计算效率。

2. 精度优化

TensorRT支持多种精度模式,包括FP32、FP16和INT8,通过使用更低精度的计算,可以显著提高计算速度和减少内存带宽需求。

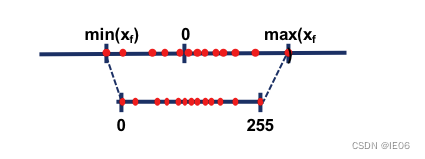

- FP16:半精度浮点数,减少计算量和内存带宽需求,同时利用现代GPU的Tensor Cores进行加速。

- INT8:8位整数,通过量化技术将模型参数和激活值转换为8位整数,进一步减少计算和内存需求。

3. 内存优化

TensorRT会优化内存分配和使用,以减少内存访问的开销:

- 内存复用:在不同的层之间复用内存,以减少显存占用。

- 内存对齐:确保内存访问是对齐的,以提高内存访问效率。

4. 高效的内核实现

TensorRT使用高度优化的CUDA内核来执行模型的计算,这些内核针对不同的硬件架构进行了优化,以最大化计算效率。

- 专用内核:为特定操作(如卷积、矩阵乘法)设计的高效内核。

- 并行计算:利用GPU的并行计算能力,最大化计算资源的利用率。

5. 动态张量优化

TensorRT可以在推理过程中动态调整张量的形状和大小,以适应不同的输入数据,从而提高计算效率。

6. 批处理优化

TensorRT支持批处理推理,通过一次处理多个输入样本来提高吞吐量。

7. 异步计算

TensorRT利用CUDA流和事件机制实现异步计算,最大化计算和数据传输的并行性,从而减少等待时间。

实践中的应用

将模型转换为TensorRT通常涉及以下步骤:

- 模型导出:将训练好的模型导出为ONNX格式。

- 模型解析:使用TensorRT解析ONNX模型,生成TensorRT的计算图。

- 模型优化:根据目标硬件和精度要求,对模型进行优化。

- 模型推理:使用TensorRT的推理引擎进行推理。

总结

将模型转换为TensorRT可以显著加速推理过程,主要通过图优化、精度优化、内存优化、高效内核实现、动态张量优化、批处理优化和异步计算等技术手段实现。这些优化措施充分利用了现代GPU的计算能力和内存带宽,显著提高了推理速度和效率。