简介

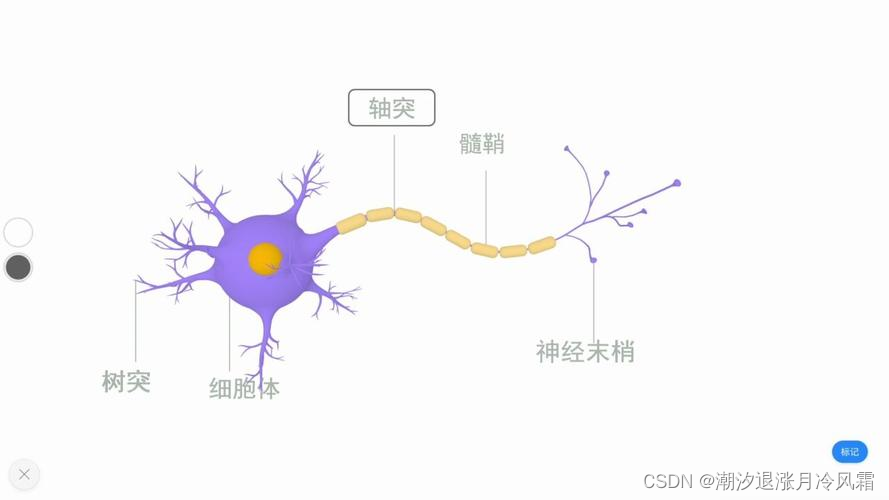

神经网络(Neural Network)是一种模仿人类大脑的机器学习算法,由一系列相互连接的神经元组成。它能够自动学习数据的特征和规律,并对新的输入数据进行预测和分类。

- 神经网络作为一种模仿生物大脑机制的机器学习算法,其产生和发展主要源于以下几个方面的背景:

对人脑认知机制的研究

- 20世纪初,神经生理学家开始对人脑神经元的工作机制进行深入研究,发现大脑皮层由数以十亿计的神经元相互连接而成。

- 这些神经元通过突触连接,能够传递和处理信息,从而实现复杂的认知功能。这种生物学启发为人工神经网络的建立奠定了基础。

计算机科学的发展

- 20世纪50年代,冯·诺依曼体系计算机的出现为人工神经网络的实现提供了计算平台。

- 随着计算机处理能力和存储能力的不断提升,为复杂的神经网络模型的训练和应用创造了条件。

机器学习理论的进步

- 20世纪50-60年代,感知机、反馈网络等早期神经网络模型被相继提出,为神经网络的发展奠定了基础。

- 20世纪80年代,反向传播算法的提出解决了多层神经网络的训练问题,使得更复杂的神经网络模型得以实现。

大数据时代的到来

- 近年来,随着互联网和智能设备的迅速发展,海量的数据不断产生。

- 这为神经网络的深度学习提供了大量的训练样本,使其在复杂问题中表现出了卓越的性能,如计算机视觉、自然语言处理等领域。

因此,神经网络的产生和发展离不开生物学、计算机科学、机器学习理论以及大数据时代的共同推动。这种跨学科的发展模式也使得神经网络成为当前机器学习领域最为先进和应用最广泛的技术之一。

主要特点

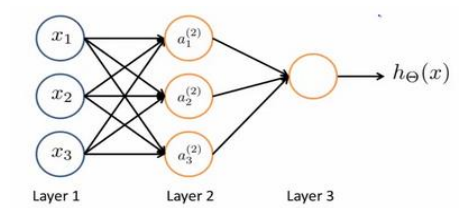

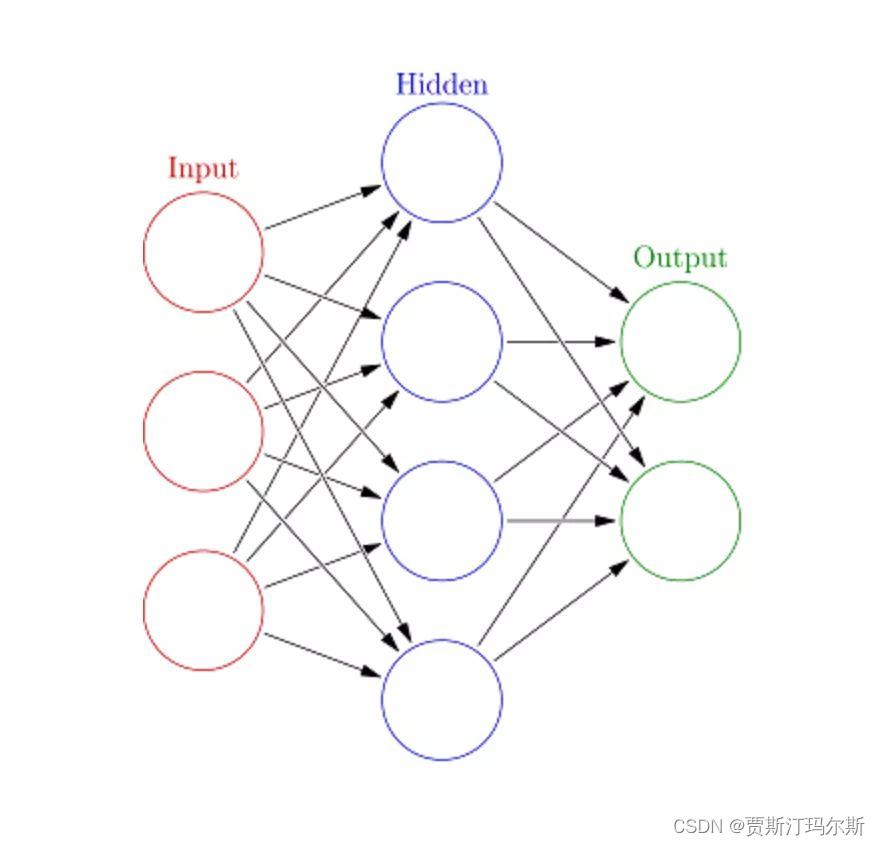

- 多层结构:神经网络由输入层、隐藏层和输出层组成,每一层都包含大量相互连接的神经元。这种多层结构使得神经网络能够逐步提取数据的复杂特征。

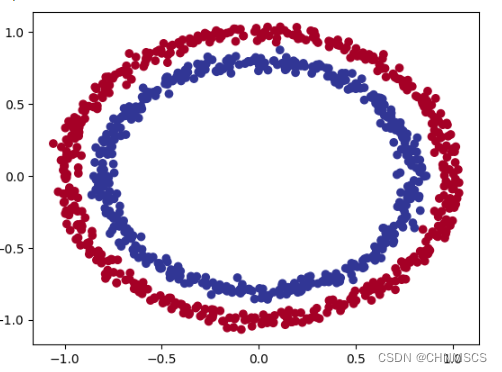

- 非线性激活函数:神经元之间的连接都有对应的权重,通过非线性激活函数(如 Sigmoid、ReLU 等)对加权输入进行处理,使神经网络具有非线性建模能力。

- 端到端学习:神经网络能够直接从原始数据中学习特征,而无需进行繁琐的特征工程。

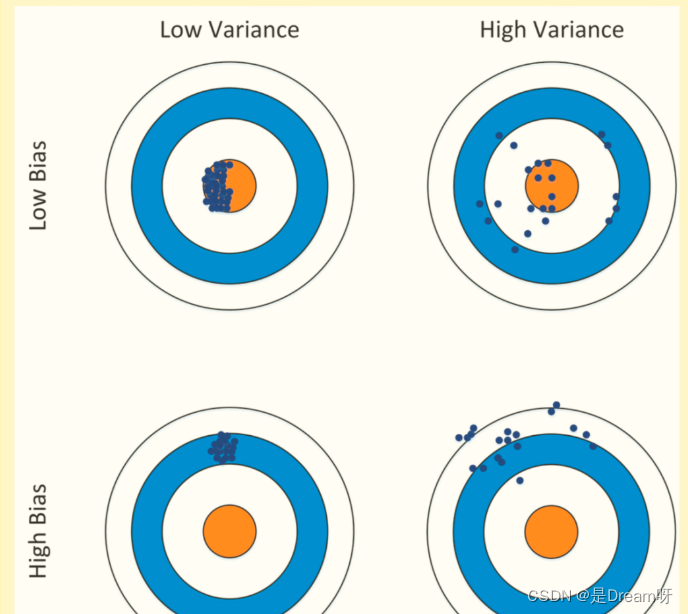

强大的泛化能力:通过大量的训练数据,神经网络能够学习数据的潜在规律,对新的输入数据进行准确的预测。

下面是一个简单的神经网络结构图示例:

Input Layer Hidden Layer Output Layer

+-------------+ +---------+ +---------+

| | | | | |

| | | | | |

| | | | | |

+-------------+ +---------+ +---------+

神经网络的训练过程主要包括以下几个步骤:

- 初始化网络参数:为每个神经元的连接权重和偏置项赋予随机值。

- 前向传播:将输入数据依次通过各层神经元,得到最终的输出。

- 计算损失函数:比较实际输出和期望输出之间的差异,定义损失函数。

- 反向传播:利用梯度下降法,将损失函数对各参数的梯度反向传播到各层,更新参数。

- 迭代训练:重复 2-4 步,直到网络收敛或达到预期精度。

常见应用

计算机视觉

- 应用场景:图像分类、目标检测、图像生成等

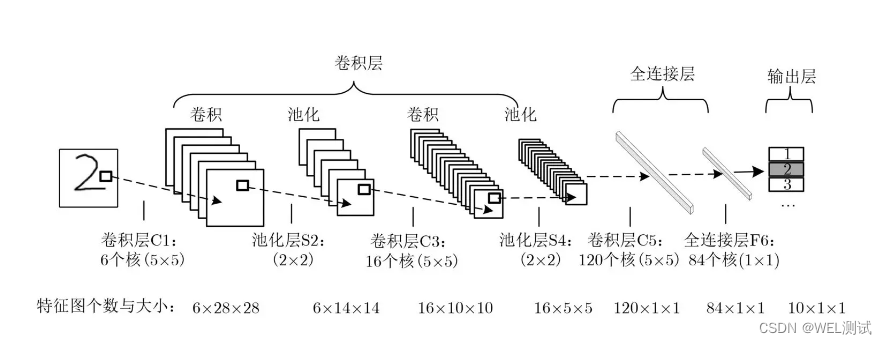

- 代码示例(使用 PyTorch 的 CNN 模型):

import torch.nn as nn

import torch.nn.functional as F

class ConvNet(nn.Module):

def __init__(self):

super(ConvNet, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

自然语言处理

- 应用场景:文本分类、机器翻译、问答系统等

- 代码示例(使用 PyTorch 的 RNN 模型):

import torch.nn as nn

class RNNClassifier(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(RNNClassifier, self).__init__()

self.hidden_size = hidden_size

self.i2h = nn.Linear(input_size + hidden_size, hidden_size)

self.i2o = nn.Linear(input_size + hidden_size, output_size)

self.softmax = nn.LogSoftmax(dim=1)

def forward(self, input_tensor, hidden_tensor):

combined = torch.cat((input_tensor, hidden_tensor), 1)

hidden = self.i2h(combined)

output = self.i2o(combined)

output = self.softmax(output)

return output, hidden

def initHidden(self):

return torch.zeros(1, self.hidden_size)

语音识别

- 应用场景:语音转文字、语音命令控制等

- 代码示例(使用 TensorFlow 的 RNN 模型):

import tensorflow as tf

class SpeechRecognitionModel(tf.keras.Model):

def __init__(self, input_dim, output_dim, hidden_units):

super(SpeechRecognitionModel, self).__init__()

self.lstm1 = tf.keras.layers.LSTM(hidden_units[0], return_sequences=True)

self.lstm2 = tf.keras.layers.LSTM(hidden_units[1], return_sequences=True)

self.dropout = tf.keras.layers.Dropout(0.5)

self.dense = tf.keras.layers.Dense(output_dim, activation='softmax')

def call(self, inputs):

x = self.lstm1(inputs)

x = self.dropout(x)

x = self.lstm2(x)

x = self.dropout(x)

x = self.dense(x)

return x

推荐系统

- 应用场景:个性化推荐、协同过滤等

- 代码示例(使用 TensorFlow 的 DNN 模型):

import tensorflow as tf

class RecommendationModel(tf.keras.Model):

def __init__(self, user_dim, item_dim, hidden_units):

super(RecommendationModel, self).__init__()

self.user_input = tf.keras.layers.Input(shape=(user_dim,))

self.item_input = tf.keras.layers.Input(shape=(item_dim,))

self.concat = tf.keras.layers.Concatenate()([self.user_input, self.item_input])

self.dense1 = tf.keras.layers.Dense(hidden_units[0], activation='relu')

self.dense2 = tf.keras.layers.Dense(hidden_units[1], activation='relu')

self.output = tf.keras.layers.Dense(1, activation='sigmoid')

def call(self, inputs):

user, item = inputs

x = self.concat([user, item])

x = self.dense1(x)

x = self.dense2(x)

x = self.output(x)

return x