神经网络(Neural Networks)是受生物神经系统启发而设计的一类计算模型,广泛应用于图像识别、语音识别、自然语言处理等领域。其基本思想是通过模拟人脑神经元的工作方式,实现对复杂数据的自动处理和分类。本文将详细介绍神经网络的基本原理、结构、训练过程及其在实际应用中的优势和挑战。

神经网络的基本结构

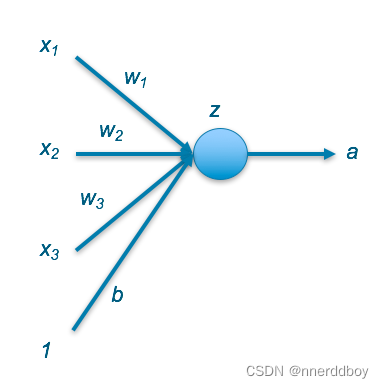

1. 神经元(Neuron)

神经网络的基本单元是神经元,也称为节点。每个神经元接收多个输入信号,通过加权求和和激活函数的作用,生成一个输出信号。数学表达式如下:

其中:

是输入信号

是权重

- b 是偏置

- f 是激活函数

- y 是输出信号

2. 层(Layer)

神经网络由多个层组成,每一层包含若干神经元。根据层的不同功能,神经网络可以分为三种层:

- 输入层(Input Layer):接收外部数据,不进行任何计算。

- 隐藏层(Hidden Layer):位于输入层和输出层之间,通过加权求和和激活函数进行数据处理。

- 输出层(Output Layer):生成最终的输出结果。

3. 激活函数(Activation Function)

激活函数的作用是引入非线性,使神经网络能够处理复杂的非线性问题。常见的激活函数包括:

Sigmoid 函数:输出值在 (0, 1) 之间,常用于二分类问题。

Tanh 函数:输出值在 (-1, 1) 之间,相较于 Sigmoid 函数对输入的变化更敏感。

ReLU(Rectified Linear Unit):当输入大于0时,输出等于输入;当输入小于0时,输出等于0。

神经网络的训练过程

神经网络的训练过程主要包括前向传播、损失计算和反向传播三个步骤。

1. 前向传播(Forward Propagation)

前向传播是指数据从输入层经过隐藏层到输出层的过程。在每一层,神经元接收上一层的输出信号,通过加权求和和激活函数计算得到当前层的输出信号。该过程一直持续到输出层,生成最终的预测结果。

2. 损失计算(Loss Calculation)

损失函数用于衡量神经网络的预测结果与真实标签之间的差异。常见的损失函数包括:

均方误差(Mean Squared Error, MSE):用于回归任务,计算预测值与真实值之间的平方差的平均值。

交叉熵(Cross-Entropy):用于分类任务,衡量两个概率分布之间的差异。

3. 反向传播(Backpropagation)

反向传播是指通过链式法则计算损失函数相对于每个参数的梯度,并利用梯度下降法更新参数的过程。具体步骤如下:

计算损失函数的梯度:通过链式法则计算损失函数相对于每个权重和偏置的梯度。

更新参数:利用梯度下降法更新权重和偏置。更新公式如下:

其中

是学习率,

和

分别是损失函数相对于权重和偏置的梯度。

4. 超参数调优

训练神经网络时,还需要调整一些超参数以获得最佳的模型性能。常见的超参数包括:

- 学习率(Learning Rate):控制参数更新的步长,过大或过小都会影响模型的收敛性。

- 批量大小(Batch Size):每次更新参数时所使用的样本数量,较小的批量可以更快地收敛,但噪声较大。

- 隐藏层数量和每层神经元数量:影响模型的表达能力和复杂度。

神经网络的优势和挑战

优势

- 非线性映射能力:神经网络通过激活函数可以处理复杂的非线性问题。

- 自适应学习能力:通过反向传播算法,神经网络可以自动调整参数,优化模型性能。

- 广泛应用:神经网络在图像识别、语音识别、自然语言处理等领域表现出色。

挑战

- 训练复杂度高:神经网络的训练过程需要大量的计算资源和时间,尤其是深度神经网络。

- 参数调优困难:神经网络的性能对超参数敏感,调优过程复杂。

- 过拟合风险:神经网络容易过拟合,需要正则化技术(如Dropout、L2正则化)来防止过拟合。

结论

神经网络作为一种强大的机器学习模型,具有处理复杂非线性问题的能力。然而,其训练过程复杂,对计算资源和数据质量要求较高。在实际应用中,需要根据具体任务和数据特点,合理选择网络结构和超参数,才能充分发挥神经网络的优势。随着计算资源的提升和算法的改进,神经网络在各个领域的应用将会更加广泛和深入。

![[GICv3] 3. 物理中断处理(Physical Interrupt Handling)](https://img-blog.csdnimg.cn/fcb5d44bc81d48b4b449a6573ad5d6cb.png)