概述

在第 1 部分和第 2 部分中,我们讨论了适用于文本和图像任务的预训练模型,并探索了当今常用的模型。我们分析了这些模型的架构以及如何将它们用于特定任务。实现 AGI 所需的两个主要支柱是语言理解和机器的视觉能力。有许多任务与这两种能力有关。

想象一下,我们已经完全掌握了这些方面,并达到了机器的最佳状态。如今,机器在安全和健康等领域非常有用。我们希望将它们部署在我们身边的物理机器——机器人中。

当我们听到“机器人”这个词时,我们可能会想到许多以机器人为主题的好莱坞电影和故事,有好的也有坏的。从“弗兰肯斯坦”的故事到“星球大战”等电影,机器人经常被描绘成高度先进的技术,表明其智力优于人类。

然而,我们对机器人以及关于其未来的持续讨论的最佳描述是在电影“ 2001:太空漫游”中。这部电影完美地说明了机器人或人工智能可能带来的能力和危险,并表明人类智能最终将占上风。

在本期节目中,请与我一起深入探索机器人的世界,探索机器人的概念何时首次进入人类的头脑,人们对机器人的看法是如何演变的,以及当今公司使用什么模型来制造机器人。许多公司目前正在开展制造机器人的项目,我们还将讨论机器人如何学习我们和其他生物遵守的物理定律。敬请期待!

什么是机器人?

机器人是人类创造的能够模仿人类智能的机器。它们能够感知、知觉并与周围环境进行物理交互,并且可以执行人类或其他生物可以完成的任务。机器人有多种类型,例如工业机器人、家用机器人、人形机器人等。工业机器人主要用于工厂中的重型机械任务,以提高生产的准确性和速度。它们可能没有走路或说话的能力,但家用机器人和人形机器人需要具备这些能力。家用机器人用于诸如打扫房间或管理智能家居系统等任务,其主要界面是通过口头交流。在接下来的几集中,我们将探讨机器人如何学习以及可用于此任务的不同模型。我邀请您和我一起参与这项迷人而诱人的探索。

纵观历史

纵观历史,人类一直致力于简化任务并在更短的时间内推进工作,从而取得了重大进步。从古代建造日晷、风车和水坝,到工业革命和许多任务的机械化,我们目睹了人类创新的愿望。随着新技术的出现,尤其是计算机时代和计算速度的快速加速,先进的机器人成为一个突出的想法。艾伦·图灵于 1950 年发表的文章“计算机器和智能”可以被认为是人工智能出现后第一篇讨论机器人技术的文章。“图灵测试”在这篇文章中首次被提出,现在它已经成为计算机科学领域的一个重要概念。

图灵在这篇文章中提出并试图回答的最重要的问题是:“机器能思考吗?”这个问题在哲学和技术上都得到了解决。在那篇文章中,他首次提出了“模仿游戏”的概念,也就是著名的图灵测试。在这个游戏中,有两个人和一台机器参与其中,一个人通过向机器和另一个人提问,试图弄清楚谁是机器,谁是人类。这个模仿游戏的目的是让机器表现得足够聪明,以误导观察者并说服他们将机器视为人类。在机器人领域,对机器人与人类互动和做出智能决策的表现的评估是使用类似于模仿游戏的概念来完成的。模仿游戏的概念在强化学习 (RL) 领域也得到了广泛的应用。强化学习是一种机器学习方法,它训练模型根据经验自我改进并做出更明智的决策。在强化学习中,机器或代理通过与环境的交互获得经验,问答系统使用这些经验来评估和改进其性能。

继图灵的论文之后,机器人领域经历了重大发展,取得了许多进步。其中最重要的贡献之一是汉斯·莫拉维克于 1983 年发表的论文“斯坦福推车和卡内基梅隆大学探测车”。

本文介绍了两款著名的机器人,斯坦福购物车和卡内基梅隆大学漫游者,并研究了它们的运动和与环境互动的能力。斯坦福购物车是由斯坦福大学开发的,是自动驾驶汽车的早期例子之一。

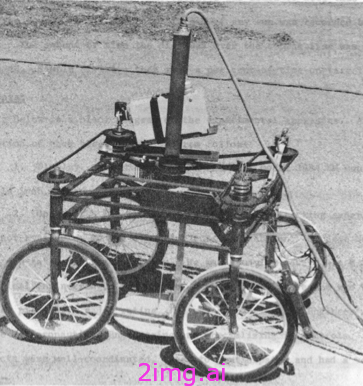

带电缆的斯坦福推车,1961 年:来源

斯坦福手推车由汉斯·莫拉维克(Hans Moravec)于20 世纪 60 年代设计,配备了传感器和计算设备,使其能够在不同环境中导航并与障碍物互动。它代表了户外环境中自主移动领域最早的成功之一。

卡内基梅隆大学开发的 CMU Rover是另一款专为户外环境移动而设计的机器人。

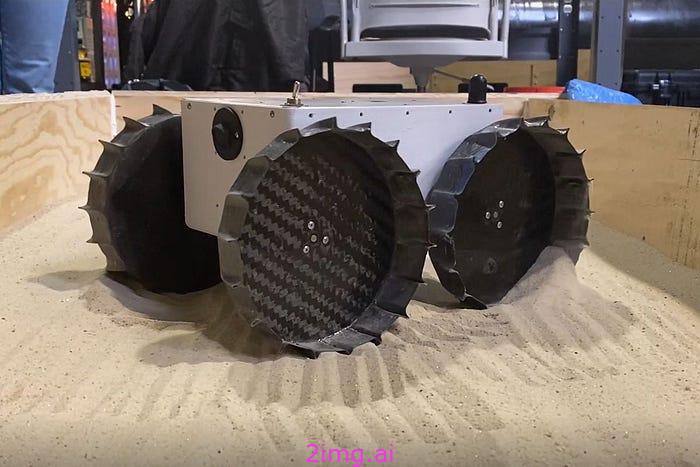

Iris 是一款由卡内基梅隆大学学生设计的小型四四方方的机器人,已通过 NASA 的关键设计审查,预计将于 2021 年秋季登陆月球。来源

该机器人能够穿越各种地形并自主执行任务。CMU Rover 被 NASA 用作月球探测机器人。

多年来,已经发表了大量有关机器人技术的文章,因此在本文中回顾所有文章是不切实际的。因此,在以下章节中,我们将探讨机器人如何学习、有哪些预训练模型可供机器人使用以及可以在哪些环境中训练机器人。机器人与其环境进行物理交互,因此了解如何有效地训练机器人至关重要。和我一起踏上这段激动人心的旅程吧!

最重要的预训练类型

我们研究的一些最常用的强化学习预训练数据包括:

模拟数据

此类数据是通过计算机模拟生成的。示例包括D4RL、Meta-World或Roboschool。模拟数据可以轻松生成和管理,具有成本效益且随时可用。它们具有很高的安全性,因为使用模拟数据意味着对机器人或环境没有物理风险或威胁。通过使用这些数据,可以精确控制环境的各种条件和特征,并可以进行多项实验。

然而,这可能导致对真实环境的适应不足,因为模拟数据不能反映真实环境的条件和特征,机器人模型在真实环境中可能会遇到不同的情况。模拟环境可能并不总是完全反映现实,可能会遇到与物体碰撞频率差异、运动精度不准确等问题,有时会导致迁移学习出现问题,因为使用模拟数据进行训练可能无法将学习迁移到真实环境中,可能需要在真实环境中进行适应和经验。OpenAI Gym、MuJoCo、RoboCup Soccer Simulation等环境是生成模拟数据的重要来源。

真实数据

有些数据集评估机器人在真实世界中的表现或人类在真实环境中与机器人的体验,例如从 Atari 游戏中的人类实验数据中收集的Atari 数据集。真实世界数据代表实际环境的条件和特征。在真实数据上训练的模型可以将学习迁移到真实环境中,从而减少在真实环境中适应和体验的需求。但是,收集真实世界数据可能成本高昂,需要更多时间和精力。在现实世界中,条件高度复杂且不可控,因此模型可能会遇到噪音和意外变化等挑战。此类数据用于训练强化学习模型。

与模拟数据相比,收集真实世界数据通常更为复杂,而模拟数据的生成具有更高的准确性和控制性。但是,根据每个项目的具体条件和需求,这两种类型的数据都用于预训练机器人模型。例如,如果项目涉及训练机器人在真实城市中进行自动驾驶,我们可以使用从机器人的摄像头和传感器收集的真实数据来预训练模型。这些数据展示了机器人应该如何对交通、行人、交通信号灯等做出反应。例如,制造自动驾驶汽车的公司声称他们的车辆能够在真实道路条件下行驶。

混合数据

这种类型的数据结合了真实数据和模拟数据的多样性,可以增强对环境条件的控制。它们还可以改善学习向真实环境的迁移,并在一定程度上减轻每种数据各自的弱点。然而,管理和分析组合数据更为复杂,成本也更高。例如,Gym Retro使用经典 Atari 游戏中的人类体验数据来训练强化学习模型。波士顿动力公司和特斯拉等知名科技公司可能会采用这些方法来训练他们的模型,提高他们的机器人和设备的性能和效率。例如,特斯拉可能会利用组合数据来训练其自动驾驶汽车,以提高其在现实条件下的性能并提高驾驶安全性。

模拟环境

即使是对于人类来说,一种重要的学习方式就是使用模拟环境。例如,为了训练飞行员(无论是商用飞行员还是军用飞行员),都会利用这些环境。它们提供的概念与实际飞行中的驾驶舱环境和条件非常相似,允许飞行员在模拟房间内开始飞行。通过这种方法,飞行员可以非常有效地学习飞行条件,即使这不是真正的飞行!同样,宇航员在进入太空之前,也要准备与太空和真空条件非常相似的环境,以学习如何在零重力条件下行动。

同样的方法也适用于训练机器人。为机器人提供学习任务所需的训练的方法之一是使用模拟环境。这些环境由为 Python 等语言编写的库提供支持,使机器人能够更高效、更有效地学习任务。由于任务和环境的多样性,例如,在完全遵守和执行物理定律的情况下,机器人可以更好、更快地学习。稍后,我们将研究其中一些库并了解它们的工作原理。敬请期待!

机器人中的预训练方法

机器人技术中的预训练方法包括一系列用于训练和提高机器人模型性能的技术和算法。这些方法已经使用多年,通常在模拟环境中执行,以减轻复杂性并减少与在现实环境中进行训练相关的时间和财务成本。对于更复杂的机器人任务,采用深度神经网络 (DNN)。因此,在训练中使用卷积神经网络 (CNN) 和循环神经网络 (RNN),尤其是 Transformer。

例如,机器人中存在用于物体检测或视觉的模型。由波士顿动力公司开发的机器人“ Spot ”利用 DNN 在其路径上进行物体检测和避障。基于 RNN 的模型用于人机交互机器人的语音识别和生成,例如麻省理工学院机器人实验室创建的机器人“ Kismet ”,它使用 RNN 根据声音检测人类情绪并使用语音生成适当的响应。基于强化学习 (RL) 的模型用于在动态环境中训练机器人作为智能代理,例如 DeepMind 的 AlphaGo,它利用基于 RL 的模型来增强围棋等特定游戏中的游戏策略。基于监督学习的模型也适用于训练机器人在各种环境中执行特定任务。iRobot 等公司使用监督学习模型来训练他们的家用机器人(如 Roomba)执行室内清洁等特定任务。这些模型使用真实世界数据进行训练,以在不同环境条件下提供最佳性能。

机器人技术中的一些预训练方法包括:

预训练强化学习

在这种方法中,机器人模型使用预定的数据集(通常来自经验或合成数据)进行预训练,以达到理想且稳定的初始状态。然后,在模拟环境中,它们学习并执行所需的任务,以便在真实环境中表现更好。

预训练数据是指在开始强化学习过程之前收集并用于训练模型的数据。这些数据可能来自过去的经验,例如来自之前在模拟环境中移动过的机器人的数据,并且这些移动的经验会被存储起来。模拟环境数据(物理或 3D 模拟)通常用作真实环境的替代品,以便安全有效地训练模型,而无需在真实环境中直接进行实验。或者,可以利用人类经验(通过人类指导)。例如,如果正在训练机器人协助中心的老年人,它可以从人类护理人员的经验中学习如何与老年人相处以及如何互动。

但是,这种方法是否适合训练所有类型的机器人取决于模型所训练的具体任务。使用强化学习进行训练的成功依赖于有效且与任务相关的预训练数据。例如,这种方法可用于需要在复杂环境中寻路和移动的工业机器人、需要学习与家庭环境中的各种物体交互的家用机器人,或需要学习在道路和城市环境中导航的自动驾驶汽车。然后,为了提高机器人在现实世界中的表现,我们可以使用预训练模型作为强化学习的输入。在下一节中,我们将使用代码检查最重要的模拟环境。敬请期待!

强化学习的模拟环境

在上一节中,我们了解了如何利用预训练数据来促进强化学习。现在,让我们探索可用于此目的的重要模拟环境。有许多模型可用于此任务,其中最重要的是:

DQN:雅达利(Atari)

基于奖励和惩罚的 DQN 系统最早由 DeepMind 在 2013 年的一篇文章中提出。

在这个系统中,机器人会因做出正确的动作而获得奖励,而因做出错误的动作而受到惩罚。强化学习代理会收集 Atari 游戏的经验,并用于训练强化学习模型。每个经验都包括游戏的当前状态、代理采取的行动、获得的奖励以及游戏的下一个状态。研究人员最初使用该数据集来训练 DQN 等强化学习模型。DQN 代表深度 Q 网络,这是一种利用深度神经网络来估计 Q 值函数的算法。Q 值函数估计给定环境中每个动作的值。机器人观察环境的当前状态,并根据估计的 Q 值函数选择动作。然后,它从环境中获得奖励,并使用深度强化学习算法根据收到的奖励更新 Q 值函数。该算法已广泛应用于机器人技术、游戏和通用人工智能。

DQN:Atari来源

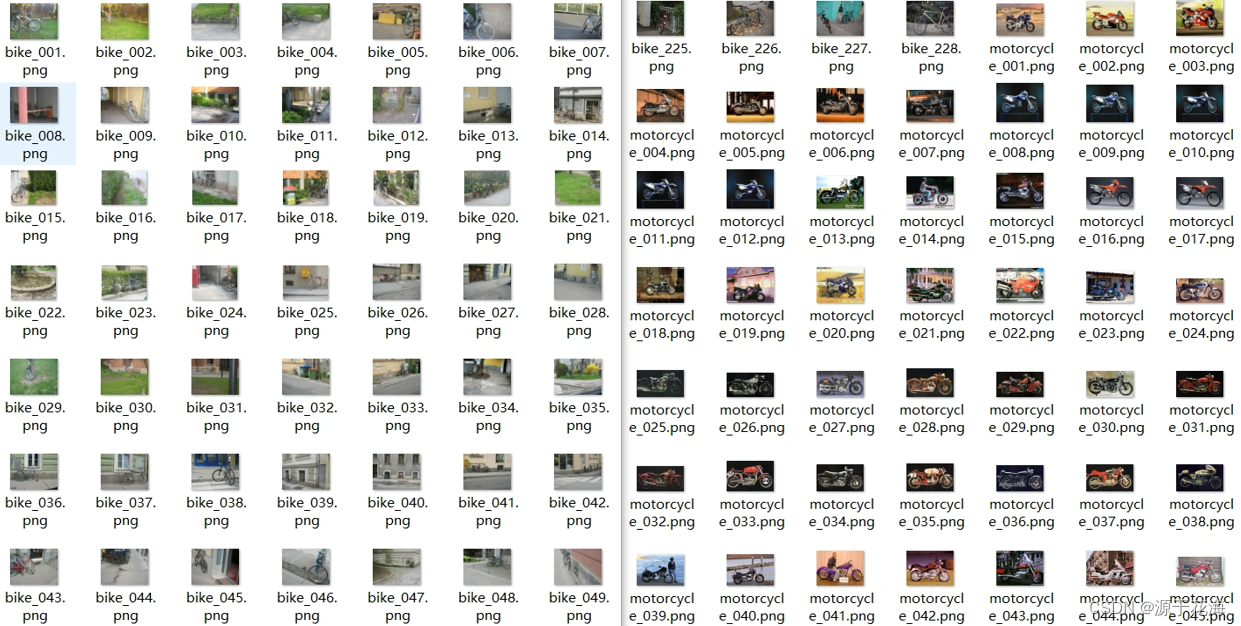

该数据集的主要用途是训练和评估用于解决视觉问题的强化学习算法,尤其是用于 Atari 等视频游戏。然而,该数据集不仅适用于训练游戏模型,还可用于训练机器人模型,它们需要决定如何与动态和复杂的环境进行交互。

OpenAI Gym2

这个工具最初是由Greg Brockman等人在 OpenAI 团队的论文《OpenAI Gym》中提出的,该论文于 2016 年 10 月在国际神经信息处理系统会议 (NIPS) 上发表。

OpenAI Gym 是一个用于开发和测试强化学习算法的开源编程库,为开发人员提供了创建和利用各种测试环境的能力。自推出以来,该工具已被广泛用作训练和开发强化学习算法的主要工具。

要在 Python 代码中调用 OpenAI Gym,您只需使用 Gym 库并调用所需的环境。首先,您需要安装Gym 库。注意以下命令:

!pip install gym

现在我们可以使用 ` make`函数调用所需的环境。在下面的代码中,我们要调用CartPole环境,这是 OpenAI Gym 中用于测试和训练 RL 算法的流行环境之一。请注意以下代码:

import gym # 选择环境名称 env_name = 'CartPole-v1' # 创建环境 env = gym.make(env_name) # 启动环境 observer = env.reset()

在CartPole环境中,代理必须使用放置在“推车”顶部的“杆”来平衡称为“推车”的柱子。推车可以左右移动,代理必须使用适当的动作保持柱子的平衡,以防止系统由于该环境的实际重力而移动其位置。在机器人技术中, CartPole环境对于需要保持平衡的机器人特别有用。例如,考虑一个人形机器人,它需要穿越一条没有障碍物的平滑路径,然后需要能够转动和移动身体,同时仍保持平衡以防止自己摔倒。

OpenAI Gym。来源

OpenAI Gym 中提供的环境包括各种不同的任务和挑战,例如经典视频游戏,如《太空侵略者》、《打砖块》、《吃豆人》等。这些环境对于测试和评估视频游戏领域的强化学习算法非常有用。控制环境包括机器人控制问题和电机控制任务,有助于评估强化学习算法在复杂控制问题中的性能。此外,CartPole和 Mountain Car 等图形决策环境用于在简单灵活的问题设置中测试强化学习算法。该库还提供了用于记录和评估算法性能的工具,以便用户可以改进和分析其结果。

MuJoCo

MuJoCo由 OpenAI 于 2004 年开发,是一种物理模拟引擎,用于模拟物理环境并创建用于训练 RL 模型的模拟环境。它用于机器人技术、运动控制、RL 模型训练和科学研究等各个领域。MuJoCo 支持创建具有精确动态物理的模拟环境,使 RL 算法能够在安全可控的环境中训练并提高其性能。

要使用 MuJoCo,您需要安装一个名为mujoco-py的库,以便在 OpenAI Gym 中可用的环境中使用。此库提供在 Python 中调用 MuJoCo 模拟引擎的功能,并允许您创建和控制模拟环境。

!pip install mujoco-py

使用 MuJoCo 有两种方式:您可以直接调用它并使用其库,也可以使用 C API。但是,使用 C API 需要一定的 C++ 能力。要访问 C API 并阅读其文档,您可以参考以下 GitHub 链接:

mujoco/README.md 在 main · google-deepmind/mujoco

使用 MuJoCo 的一个例子是机器人控制领域。例如,可以利用 MuJoCo 创建机器人的模拟环境,以训练强化学习算法来控制机器人的运动。这些算法通过与模拟环境的交互得到经验改进,并经过训练可在现实环境中有效可靠地运行。

RoboCup 足球模拟 2D/3D

足球模拟器 RoboCup 于 1997 年在一篇题为《引言》的论文中首次提出

https://www.researchgate.net/publication/220605309_RoboCup-97_The_First_Robot_World_Cup_Soccer_Games_and_Conferences

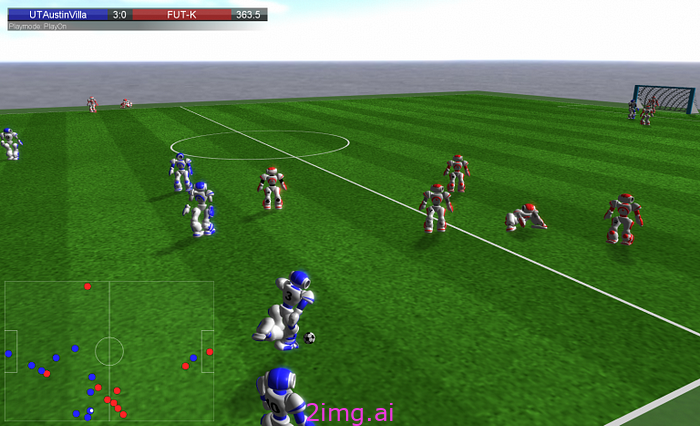

该模拟旨在创建一个可控且可重复的模拟环境,以测试机器人足球的新型人工智能算法。RoboCup 足球赛是机器人和人工智能领域的著名比赛之一。这些比赛自 1997 年以来每年在世界各地举行。这些比赛的主要目标是开发和推进与人工智能、机器人和机器学习相关的技术。RoboCup 足球赛模拟了一个有机器人、球和障碍物的足球场,遵循 FIFA 规则,但略作修改以简化模拟。其中的机器人使用人工智能算法来控制其运动、决策和与其他机器人的交互。它以 2D 和 3D 两种形式举行。在 2D 比赛中,机器人在二维场地上比赛,并从顶视图显示。

2D 游戏可视化。来源

而在3D比赛中,比赛场地是三维的,机器人比赛更加逼真,RoboCup仿真环境对于训练和测试针对机器人和人工智能提出的新算法和新想法非常有用。

3D 游戏可视化。来源

要在 Python 中使用 RoboCup Soccer Simulation 2D/3D 环境,您可以使用支持此环境的各种库。其中一些库包括“ PySimulator ”和“ rcssserver3d ”。您可以使用这些库调用比赛环境。

from rcssserver3d import Server # 创建服务器实例 server = Server() # 启动服务器 server.start() # 与机器人环境交互(交互代码放在此处) # 停止服务器 server.stop()

安装和设置 ` rcssserver3d`库高度依赖于系统,并且可能非常复杂。此库通常用于Linux 系统,需要额外的配置和设置。安装和设置过程非常复杂,取决于各种因素,例如操作系统、不同版本、软件依赖项等。有关安装和设置说明,请参阅 rcssserver3d 库的官方指南和文档。安装后,您可以使用类似于上面显示的代码来调用和与 RoboCup 3D 环境交互。

在下一部分中,我们将探讨机器人的另一种学习方法。

模仿学习(IL)

您所指的方法称为模仿学习 (IL),这是人类和生物都使用的一种强大技术。想象一下,我想在线学习探戈舞。我下载舞蹈教程并模仿探戈大师的动作。经过一些练习和重复,我可以从他们那里学会探戈舞。同样,机器也存在一种方法,尤其是在机器人技术中。

在这种方法中,模型通过模仿外部源来学习其行为。机器分析样本或源的行为并尝试模仿其模式和方法。

IL 的第一步是数据收集,通常涉及收集图像、视频或其他我们希望模型学习的期望行为样本等数据。下一步是模型训练,使用收集的数据训练机器学习模型。该模型试图识别和模仿数据中存在的模式和方法。

训练后,接下来是验证和参数调整。模型需要验证和参数调整,以确保它在其他数据上表现良好并正确模仿行为。完成所有这些步骤后,机器学习模型就可以用于应用程序或系统,包括机器人、自动驾驶汽车或其他人工智能应用程序。

对于 IL,我们有两种主要方法:

行为克隆

为此,我们使用了监督学习方法,其中代理仅向机器演示动作,机器只是精确地重复这些行为。根据手头的任务,这种方法可能是有益的,也可能是有害的。例如,考虑一个医疗机器人;自然,它复制专家行为的能力越强,它就越有效。然而,有些机器人与环境的互动更多,环境可能会随着时间的推移而动态变化。因此,如果机器只执行它在该环境中学到的特定行为,它可能效率不高。

逆向强化学习(IRL)

这种方法允许机器人模仿人类行为或其他来源。与行为克隆方法(其中机器模型只是复制外部来源的行为)相比,IRL 试图了解这些行为背后的原因并将其作为奖励函数纳入模仿学习问题中。在 IRL 中,机器人试图通过分析人类行为或其他来源并将其用于决策来了解专家或其他个人正在处理的主要问题。这使机器人能够提高其性能并在以前从未遇到过的新情况或问题中执行与专家类似的行为。这种方法通常更复杂且计算效率更高。这种方法在机器人技术中的主要应用之一是自动驾驶,其中机器人通过分析专业驾驶员的行为并使用 IRL,可以在各种路线上实现理想且安全的行为并充当自动驾驶。

模仿学习方法有多种应用。例如,在机器人技术中,它可用于教授人类容易完成的任务,例如烹饪或折叠衣服;在视频游戏中,IL 通常用于通过向熟练玩家学习来训练 AI 代理。此外,在手术机器人技术中,向专业外科医生学习的机器人可以有效地进行精细的手术。

实现方法

对于 IL 方法,有预训练模型可用。这些模型通常使用深度学习中的 CNN 等方法进行训练。通常,模拟环境也用于实现 IL。您可以使用各种库来处理模拟环境。例如,如果您想使用 OpenAI Gym,您可以安装gym 库并使用其训练环境。这些模拟环境可以是物理模拟器,如 OpenAI Gym、Mujoco、Unity ML-Agents,也可以是 ROS(机器人操作系统)中提供的模拟环境。

IL 方法最重要的预训练模型:

如上所述,基于 DQN 的模型被广泛用于训练机器人执行各种任务,例如武器控制、导航和游戏。例如,总部位于香港的机器人公司RobotEra的Humanoid-Gym推出了一系列用于训练人形机器人的模拟环境。它具有人体动力学、平衡性和人形机器人的灵活运动等特征。它主要用于训练模仿学习 (IL) 和强化学习 (RL) 算法。

在 IL 中,通常使用在描述性数据或描述性和操作性数据上训练的模型来执行正确的操作。描述性数据仅包含模型所需的输入特征,而不提供相应的输出(操作)。换句话说,这些数据提供描述当前状态或环境的信息,而不提供相应的操作。示例包括图像、视频、传感器或描述环境当前状态的其他特征。

另一方面,描述性和操作性数据由一组数据组成,这些数据既包括与环境当前状态相对应的输入(描述性)特征,也包括输出(动作)特征。这些本质上是输入输出对,包括图像和相应的动作(例如,描述视频游戏中的状态和相应的玩家动作)或描述人类在任务中的感官和操作特征的数据(例如,描述环境的状态和人类在驾驶或跑步时的动作)。

IL 的主要目标是从可用数据(通常是一组图像或视频)或与环境的交互中创建一个称为“工作者”的机器学习模型,能够模仿动作。这些动作可以是各种操作,包括机器人动作、视频游戏中的用户动作,甚至是真实或虚拟环境中的人形动作。虽然 Humanoid-Gym 是用于模仿学习的强大工具,但它也可以用于强化学习和其他机器学习方法。Humanoid-Gym 是一种积极开发的工具,并且正在不断改进。

Humanoid 人形健身馆

各种机器人,包括RobotEra的XBot-S和XBot-L机器人,都已使用 Humanoid-Gym 进行训练。Agility Robotics 等公司已使用 Humanoid-Gym 训练其 Digit 机器人。ANYbotics已使用它来训练ANYmal 机器人,而 OpenAI 已使用它来训练其Dactyl 机器人。Humanoid-Gym 是训练人形机器人的强大工具。该库允许研究人员和工程师开发和测试新的机器人控制算法,而无需物理机器人硬件。

使用 Humanoid-Gym 的优势在于其模拟环境,消除了在训练过程中伤害机器人或人类的风险。它使您能够比在真实机器人上训练更快、更有效地训练您的算法,并允许您自定义模拟环境以匹配您的机器人和特定任务。然而,模拟环境和现实世界之间总是存在差距,这可能会影响您的算法在真实机器人上的性能。此外,Humanoid-Gym 是一个复杂的工具,可能需要专业知识才能有效使用。

基于 Actor-Critic 的模型:A2C

该模型由两个深度神经网络组成,即 Actor 和 Critic。Actor 是一个神经网络,负责在环境中生成动作和代理行为,并根据优势函数的输出做出实际决策。通常,Actor 会寻求选择与其他动作相比具有更大优势的动作。此外,Critic 是另一个神经网络,负责估计环境中不同状态的价值函数。Critic 估计状态的值,以便 Actor 可以选择最佳动作。事实上,通过结合这两个网络,Actor-Critic 可以提高代理的整体性能。

该算法使用损失函数更新神经网络代理的性能,该损失函数包括值函数和优势函数中的误差总和。由于结合了 Actor 和 Critic 以及在线经验的使用,该算法可以有效快速地提高代理的性能。A2C 已用于训练机器人执行各种任务,例如武器控制、导航和游戏。

TRPO(信任区域策略优化)

TRPO (Trust Region Policy Optimization)算法最早由John Schulman和他的同事在2015年提出,其论文《Trust Region Policy Optimization》在国际机器学习会议(ICML)上发表。

TRPO(信任区域策略优化)是强化学习领域的一种高级算法,用于在复杂环境中训练策略。该算法通过限制策略更新的幅度来解决训练过程中出现较大且不稳定的变化这一难题。TRPO 的一个关键特性是使用信任区域,在此可以感知可接受的策略变化。通过施加此约束,TRPO 可确保在训练期间进行的任何策略更改都会提高代理性能,但不会显著影响性能。

另一个功能“稳定进展”旨在通过从不完全用新策略替换当前策略来创造可持续的训练进展。TRPO 不是直接优化,而是使用信任区域约束来控制策略变化并防止不稳定的更新。

此外,与许多使用梯度估计技术的强化学习方法不同,TRPO 采用直接优化方法。这意味着,在每一步中,它都会尝试寻找一种新的策略来提高性能,同时施加约束以防止不稳定的变化。

TRPO 是强化学习中先进而有效的算法之一,它为在复杂环境中训练代理提供了显著的改进。由于使用信任区域和稳定的进度,该算法可以有效处理与复杂环境中的训练相关的不稳定性问题并提高代理性能。

PPO(近端策略优化)

2017年,John Schulman和他的同事在一篇题为“近端策略优化算法”的论文中介绍了PPO算法。

PPO 是在 TRPO 之后引入的,是一种更简单、更具可扩展性的强化策略训练方法。它利用直接约束策略变化和性能增强等概念,对 TRPO 进行了改进。PPO 是一种基于梯度优化算法的强化学习方法,用于 Actor-Critic 算法中的策略训练。PPO 已用于训练机器人执行更复杂的任务,例如人形机器人控制和拥挤环境中的导航。该算法对以前的方法进行了改进,旨在解决强化学习算法在训练过程中策略变化较大和过度拟合的问题。该算法与上述内容的联系在于,这两种算法(A2C 和 PPO)都用作基于 Actor-Critic 的强化学习方法。

T2T-ViL(Transformer to Transformer — 视觉和语言)

是卡内基梅隆大学的研究人员于 2021 年推出的深度神经网络模型。该模型由两个 Transformer神经网络组成,一个是用于处理和解释文本的“ Text Transformer ”,另一个是用于处理和解释图像的“ Vision Transformer ”。这两个网络同时且连续地相互协作。现在让我们看看它是如何完成这项任务的。

文本转换器

T2T-ViL 模型类似于 GPT(生成式预训练 Transformer)等模型,它们适用于使用 Transformer 架构处理自然语言文本。例如,GPT 用于根据输入文本生成文本,而 Text Transformer 用于处理和解释有关图像的文本。然而,这两个模型从根本上都利用自注意力和前馈网络进行文本处理。

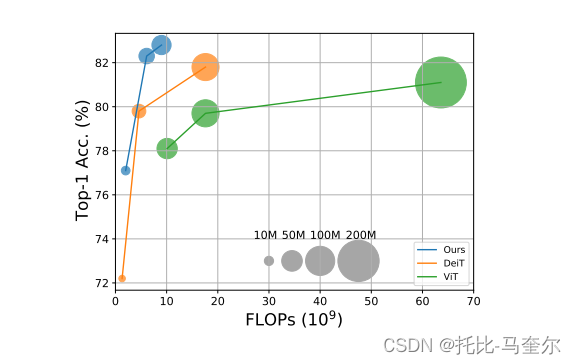

视觉转换器

目前正在开发的一种新兴模型是 T2T-ViL 中使用的一种深度神经网络,该模型在各种机器人中都具有很高的应用潜力。与之前基于 CNN 的模型相比,Vision Transformer 的主要优势在于它不需要卷积块;相反,它采用了 Transformer 块,可以更有效地发现图像中的语义模式,包括更复杂的语义模式。Vision Transformer 是一种专为图像处理而设计的 Transformer 模型,与用于文本处理的传统 Transformer 模型略有不同。

Vision Transformer 模型将图像划分为更小的块,从每个块中提取颜色、形状和纹理等视觉特征。它还利用自注意力机制将注意力集中在图像的相关部分,从而使模型的输出成为类别、动作序列、对问题的回答等。此外,它还采用注意力机制将注意力集中在图像的相关部分,而传统的 Transformer 则将这些机制用于文本和单词。

此类复杂模型最初经过预训练,以获得对图像和文本内容的深度了解。这通常涉及两个重要阶段。第一阶段是与任务无关的预训练,其中模型在包括文本和图像在内的大型多样化数据集上进行训练,以自动学习输入元素之间的模式、特征和语义关系。通常,此阶段使用自监督学习和自监督模型等方法。例如,模型可以进行自监督训练,也可以根据预测文本中下一个单词等任务进行训练。下一阶段是特定于任务的微调,其中预训练模型专门针对特定任务进行训练,例如图像中的对象检测或文本翻译。此过程有助于模型获得有关所需任务的深度了解并在该任务中提供更好的性能。

这些信息随后可用于模型预训练后的微调过程,以针对特定任务(例如图像及其标签或文本及其对应部分)训练模型,从而在任务执行中提供更好的性能。

该模型可用于利用人工智能解释和响应用户消息的机器人。例如,它可用于训练机器人执行任务,例如智能家居机器人或 Dactyl 等工业机器人,以完成组装和物体操作等各种任务,或训练社交机器人与人类互动和理解自然语言,或训练自动驾驶汽车了解周围环境和安全驾驶。

结论

在本文的第 1 部分和第 2 部分中,我们广泛讨论了适用于文本和图像的预训练模型。我们教授了这些模型。在第 3 部分中,我们讨论了机器人技术的历史和该领域的重要文章,以及如何从头开始训练它们。机器人行业仍在不断发展,还有很长的路要走。尽管取得了所有进步和发展,但机器人尚未充分发挥其潜力。例如,与语言模型或机器视觉模型不同,它们不在受控环境中。机器人需要改进才能与真实和物理环境进行交互。它们在受控环境中表现非常好。然而,在不受控的环境中,情况就不同了。除了许多不可预测的物理定律外,真实环境中的数据是实时生成的,事件的展开方式有成千上万种可能性。因此,机器人接受的训练可能不适合许多实时事件。

人类和生物经过数千年的努力,以及本能和生物力量,已经成功达到了这一阶段。也许如果未来设计出一种模型,比如像新生的生物,它可以在当下学习。成为解决问题的关键。解决所有这些问题可能导致实现 AGI。一个能够理解它存在的模型。我们可以有自我意识。我们知道我们现在在这个星球上。我们有一个目标。但人工智能还没有达到那个阶段。现在想象一下这种情况发生。我们应该害怕它吗?我们应该高兴吗?地球上最聪明的生物是人类。当然,对智能的定义各不相同,许多人可能有不同的定义。而且,我们知道人工智能可以比我们中的许多人聪明得多。如果机器人达到理解自己的阶段,我们将是第二聪明的。如果我们不考虑它的危险,最重要的是拥有 AGI 钥匙的人。

![[解决] chrome/edge浏览器打开F12开发者模式,点击应用标签崩溃](https://img-blog.csdnimg.cn/img_convert/226dc99c2a699b9efe9363ff758cb14d.png)