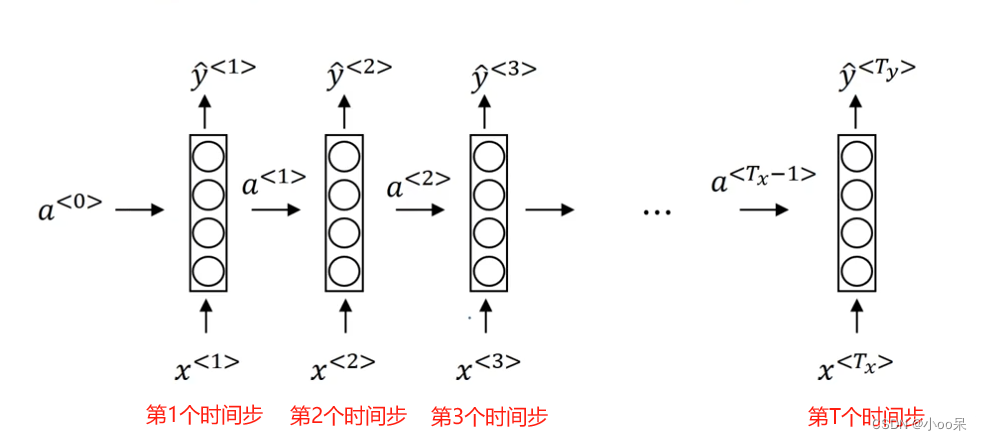

在之前的文章中,我们谈到了标准RNN所面临的诸多困境,你也可以理解为RNN的缺点。其中最让人苦恼的就是梯度消失问题,正是由于梯度消失问题的存在,导致RNN无法获得上下文的长期依赖信息。那么就没有办法解决了吗?非也!本文就介绍一种改进网络结构——GRU

关于传统RNN的知识可以看我之前的文章:【机器学习300问】118、循环神经网络(RNN)的基本结构是怎样的?![]() https://blog.csdn.net/qq_39780701/article/details/139685879

https://blog.csdn.net/qq_39780701/article/details/139685879

一、什么是GRU?

GRU,即门控循环单元(Gated Recurrent Unit),是一种用于自然语言处理和其他序列任务的神经网络架构,是标准循环神经网络(RNN)的一种改进版本。GRU的核心在于它试图解决标准RNN的梯度消失问题,同时保留长期依赖信息。

上面这段话的解释,太过于苍白无力,只知道它解决了梯度消失问题,却没说怎么解决的。要想弄清楚GRU相对标准RNN到底强在哪里,就必须要了解其基本结构。

二、GRU网络的基本结构

先说结论:“GRU通过两种门组件和两种记忆状态解决了梯度消失”,接下来我们一个个好好看看这四大组件。

(1)四大组件

① 重置门

重置门(reset gate),记为 ,这个门决定了上一时间步的记忆状态如何影响当前时间步的候选记忆内容。计算时会结合前一时间步的隐藏状态

和当前输入

,输出是一个0到1之间的值。值越接近1表示越多地保留之前的状态,越接近0表示遗忘更多旧状态。对应的数学表达如下:

② 更新门

更新门(update gate),记为 ,这个门决定了上一时间步的记忆状态有多少需要传递到当前时间步,以及当前的输入信息有多少需要加入到新的记忆状态中,同样,它也是基于

和

计算得到的。对应的数学表达如下:

③ 候选记忆状态

候选记忆状态(candidate memory),记为 ,这是基于当前输入

、上一时间步隐藏状态

以及重置门的输出,三者计算得到的。其中的重置门决定了如何“重置”旧的记忆状态,以便更好地整合新信息。对应的数学表达如下:

④ 最终记忆状态

最终记忆状态(hidden state)记为 ,通过结合更新门的输出和候选记忆状态以及上一时间步的记忆状态来计算得出的。其中更新门决定了新旧记忆的混合比例。对应的数学表达如下:

让我们总结一下上面的各种符号,方便后期查阅:

| 符号 | 解释 |

| 更新门 | |

| 重置门 | |

| 当前时刻的隐藏状态 | |

| 候选隐藏状态 | |

| 前一时刻的隐藏状态 | |

| 当前时刻的输入 | |

| 对应的训练参数 | |

| sigmoid激活函数 | |

| Hadamard积(按元素乘积)运算符 |

(2)到底长什么样?图解GRU

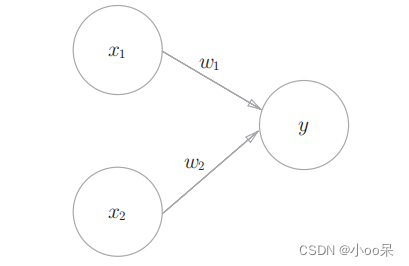

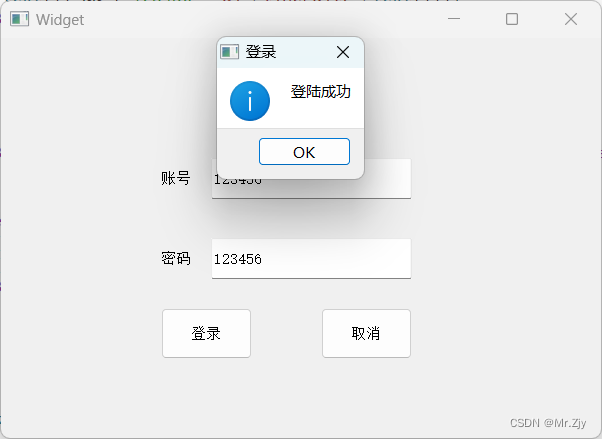

① 重置门和更新门的结构

上图描述了门控循环单元中的重置门和更新门的输入, 输入是由当前时间步的输入和前一时间步的隐状态给出。 两个门的输出是由使用sigmoid激活函数的两个全连接层给出。

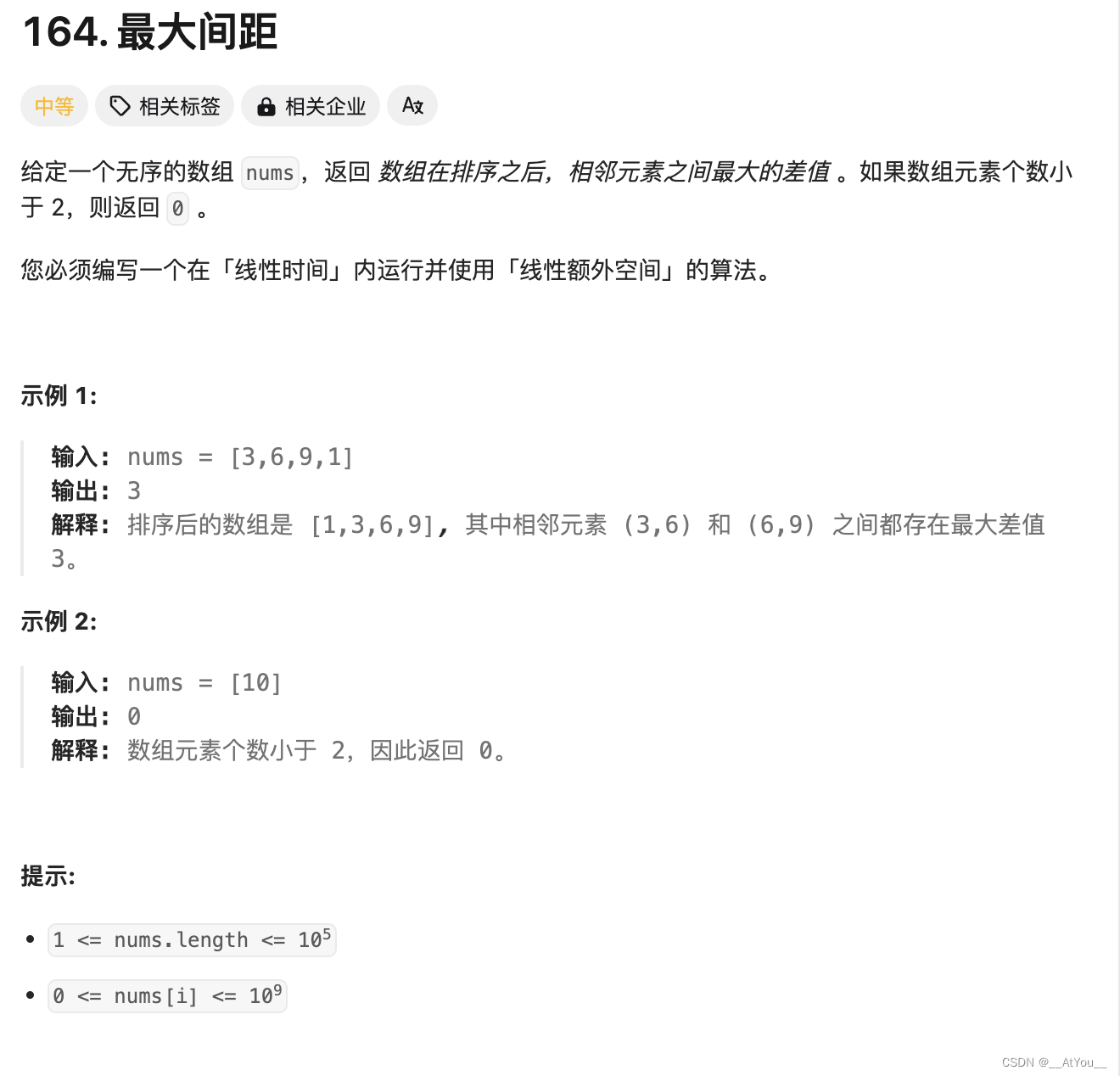

② 候选隐藏状态的结构

③ GRU的循环块结构

门控循环单元具有以下两个显著特征:

重置门有助于捕获序列中的短期依赖关系;

更新门有助于捕获序列中的长期依赖关系。

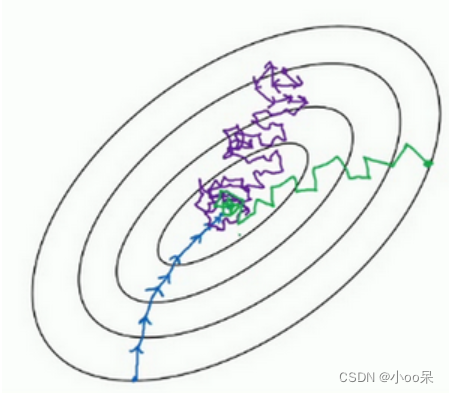

三、GRU为何能缓解梯度消失?

在传统的RNN中,由于长时间依赖问题,反向传播过程中梯度可能会因连续乘以小于1的数而变得非常小,导致早期时间步的权重几乎不更新,这就是梯度消失问题。

而GRU通过其独特的门控机制,特别是更新门和重置门的设计,能够更加灵活地控制信息流:

- 更新门:有助于模型决定在每一步中应该保留多少之前时刻的信息。它可以让模型在需要的时候保持激活状态,这样有助于后续的梯度传递而不会随时间迅速减小。如果更新门接近1,那么梯度可以在很多时间步内传递而不衰减,使得长期依赖的信息得到保留。

- 重置门:帮助模型决定忽略多少之前的信息。重置门可以用来减少那些不太相关信息的影响,从而保护模型不会把注意力放在不相关的长期依赖上。当选择忽略一些不相关的信息时,梯度将不会在这部分信息上进行传递,这有助于集中于更相关的信息,并有助于梯度完整地在其他相关部分传递。

因为有了这样的机制,GRU能够在每次更新中将梯度既不是完全传递也不是完全阻断,而是能够在相关的部分进行传递。这样在优化过程中,即使对于较长的序列,也能够更加稳定地保留梯度,防止了梯度极端消失,这对于学习长期依赖至关重要。因此,GRU往往在处理长序列数据时比传统RNN更加有效。

四、举个例子说明GRU的工作原理

我们可以把某个学生的学习历程想象成一个时间序列,其中每个学科对应一个时间步骤上的输入数据。每个笔记代表了在特定时间点(假设从小学、初中、高中到大学)学习的内容。我们想利用GRU模型来理解学生的学习轨迹。

GRU在这个场景的应用解释:

① 输入序列

在这个例子中的输入序列,就是学生学习的学科,例如他在高中时学习的学科:['语文', '数学', '英语', '编程', '物理']

② 初始化隐藏状态(小学时期)

开始时,GRU有一个初始的隐藏状态,可以看作是学生开始学习时的一张“空白记忆板”。

③ 第t-1个时间步(高中时期)

学生在高中时学习了一系列科目并做了笔记:['语文', '数学', '英语', '编程', '物理']。这些知识构成了他前一时间步隐藏状态 。

④ 第t个时间步(大学时期)

- 更新门:现在学生在大学里学习深度学习,他需要回顾某些高中学科的知识。在GRU中,更新门将决定他之前学过哪些知识依然重要并且需要在他的记忆中保留(比如'数学'知识对于'微积分','线性代数'和'概率论'很重要;'编程'对'Python'和'机器学习基础'很重要)。

- 重置门:对于那些与当前的深度学习不直接相关的旧知识(比如'语文'和'英语'),通过重置门,GRU可以决定减少对这些信息的依赖,从而让神经网络集中于更相关的信息(这里是数学和编程相关的科目)。

- 候选记忆状态:在接触到新的科目后('微积分', '线性代数', 'Python', '概率论', '机器学习基础'),经过重置门过滤后,之前的知识和新的输入共同决定了新的候选隐藏状态。以此模拟学生如何将过去的知识与新知识结合起来。

- 最终隐藏状态:更新门负责把新的候选隐藏状态与旧的隐藏状态结合起来,创造出最新的隐藏状态,代表学生整合了新旧知识后的当前知识水平。这一过程就是学生用之前学过的高中的数学和编程课程来帮助理解大学的深度学习课程。

在反向传播过程中,GRU的这些门结构帮助了梯度在通过长序列时不会消失,确保即使时间跨度很长(比如从高中到大学),模型仍然能够学习到如何从过去的经验中获取有用的知识。在这个例子里,即使'物理'可能不直接相关深度学习,但如果更新门认为这部分知识还是有用的,那么信息依然可以被保留下来。在真实的GRU模型中,这一切都是通过网络自动学习到的权重来决定的。