大数据产业创新服务媒体

——聚焦数据 · 改变商业

AI时代的脚步越来越近了,而关于GPU自主权的需求也越来越迫切了。在中国,如果有一个厂商有可能完成这件事情,那大概率还是得靠华为。

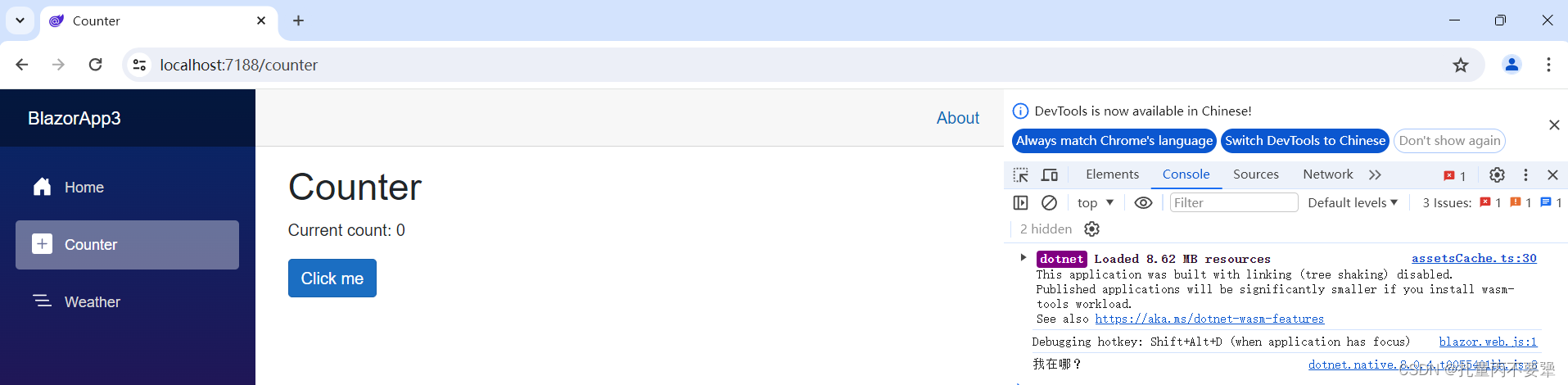

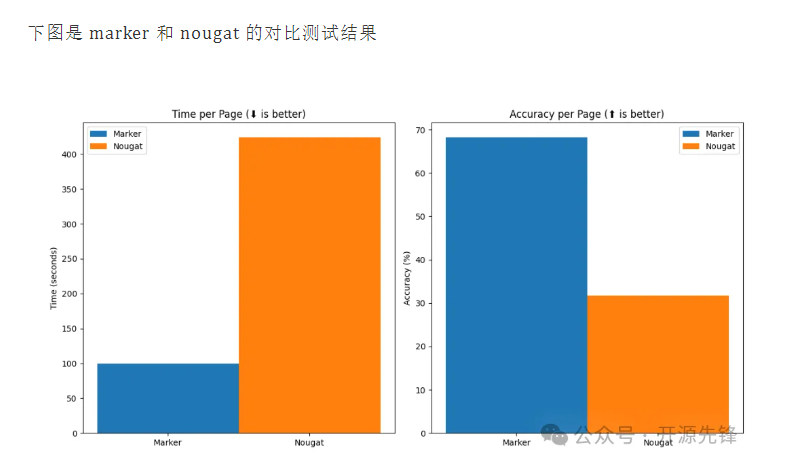

近期,据媒体报道,Ascend 910B AI在训练大型语言模型时,其效率可达到英伟达A100的80%。如果这数据是真实的,那Ascend 910B真的快要追平英伟达A100了。这对中国算力产业,是一个标志性的事件。

随着美国对中国AI芯片出口的限制,国内对Ascend 910B的需求激增,预计2024年出货量将超过40万片。此外,科大讯飞与华为的合作进一步推动了910B性能的提升,使其基本达到与A100对标的能力。华为昇腾910B的推出,打破了英伟达在AI芯片领域的垄断,展现了中国在高性能计算领域的发展潜力。

那么,我们不禁要问,Ascend 910B真的可堪重任了么?

“破局者”的崛起,华为Ascend 910B的诞生

华为Ascend芯片的发展历程是中国AI芯片技术自主创新的缩影。Ascend芯片的诞生,标志着华为在人工智能领域的深度布局和坚定决心。

华为Ascend芯片的故事始于2018年10月10日,华为在上海举办的全联接大会上首次公开展示了Ascend系列AI芯片。这一系列产品包括了昇腾910和昇腾310两款处理器,均采用了华为自主研发的达芬奇架构,旨在满足不同AI应用场景的需求。

2019年8月23日,华为宣布昇腾910正式推出,这是一款专为大规模计算任务和AI训练而设计的芯片。昇腾910的发布,不仅彰显了华为在AI芯片技术上的突破,也向世界证明了中国在高端芯片设计领域的能力。

到了2023年,Ascend芯片的市场认可度显著提升。据报道,百度为200台服务器订购了1600片昇腾910B AI芯片,华为已向百度交付了超过60%的订单。这一举措不仅体现了Ascend芯片的性能得到了行业的认可,也展示了华为在AI芯片领域的竞争力。

华为并未因早期的成功而止步,而是持续推动Ascend芯片的创新和发展。2023年11月,华为宣称Ascend 910B AI芯片在某些特定测试中,训练性能上已超越英伟达A100达20%。

华为还致力于打造昇腾芯片的生态系统。通过与全球高校、研究机构以及企业的合作,华为在昇腾芯片的基础上构建了一个包括基础软件平台、科研创新、人才发展等多维度的生态系统。这一生态系统的建设,为昇腾芯片的未来发展提供了坚实的基础。

在全球化的科技舞台上,华为Ascend 910B的诞生犹如一颗璀璨的新星,照亮了国产AI芯片的前行之路。华为Ascend 910B的横空出世,标志着中国在高端AI芯片领域取得了实质性的突破。它采用了华为自研的达芬奇架构,集成了数千个核心,提供了高达256TOPS的算力。这一性能的飞跃,让Ascend 910B在AI训练和推理任务中展现出卓越的能力。

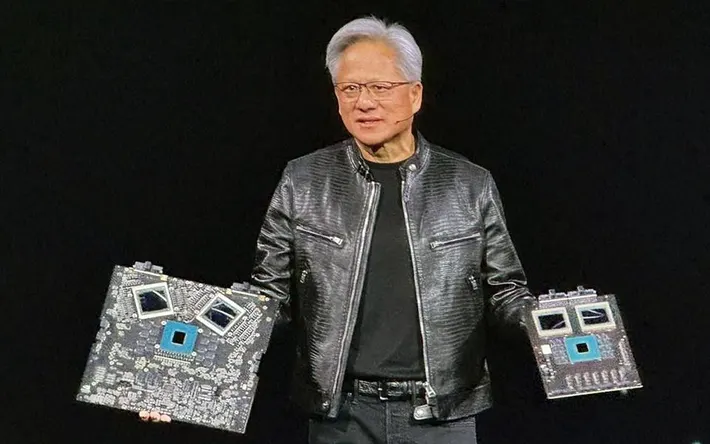

“霸主”的回应,英伟达可没躺着睡大觉

当然,英伟达没有躺在功劳簿上睡大觉,事实上,英伟达“正值壮年”,发展势头非常迅猛。

在AI芯片的竞技场上,英伟达以其A100芯片巩固了其霸主地位。A100芯片以其卓越的性能参数傲视群雄。这款基于安培架构的GPU,拥有高达19.5 TFLOPS的FP64峰值性能和312 TFLOPS的FP16 Tensor Core峰值性能。显存方面,A100提供40GB和80GB两个版本,其中80GB版本的显存带宽达到2039 GB/s。这些参数的卓越表现,使得A100在AI训练、推理以及高性能计算(HPC)中展现出无与伦比的能力。

A100是英伟达从V100芯片演进而来,它不仅继承了V100的优良传统,更在多个方面实现了质的飞跃。与V100相比,A100在单精度浮点计算能力上从15.7TFLOPS提升至19.5TFLOPS,双精度浮点运算也从7.8TFLOPS提升至9.7TFLOPS。这些提升,得益于A100采用的更先进的制程技术和架构优化。

近期,英伟达在最新发布会上推出了新一代的AI芯片Blackwell GPU,代号为B200,计划于今年晚些时候上市。Blackwell GPU采用台积电的4纳米工艺,整合了两个独立制造的裸晶,共有2080亿个晶体管。与A100相比,Blackwell GPU在性能上得到了全面提升,更擅长处理AI相关任务。一个B200 GPU能够提供高达20 petaflops的FP4八精度浮点运算能力,远超A100的性能。

此外,英伟达还推出了GB200加速卡,结合了两个B200 GPU和一个独立的Grace CPU,将能使大模型推理工作负载的性能提升30倍,同时提高效率。在参数为1750亿的GPT-3 LLM基准测试中,GB200的性能达到了H100的7倍,而训练速度则达到了H100的4倍。

英伟达的这一系列动作,无疑再次证明了其在AI芯片领域的领导地位,同时也为未来的技术发展和应用场景描绘了更加广阔的蓝图。

性能对决,数字背后的真相

在AI芯片的竞技场上,华为Ascend 910B与英伟达A100的对决,不仅是数字的比拼,更是技术实力的较量。

算力比拼,256TOPS与312TFlops的较量

Ascend 910B以其256TOPS的算力,向A100的312TFlops发起挑战。虽然在数值上A100略胜一筹,但Ascend 910B在实际应用中的性能表现却不容小觑。

显存与带宽,64GB HBM2E与80GB HBM2E的对决

在显存方面,Ascend 910B配备了64GB的HBM2E,而A100则提供了80GB的HBM2E。虽然A100在显存容量上略大,但Ascend 910B的显存带宽却达到了惊人的2000GB/s,与A100的1555GB/s相比,显示出了其在数据传输效率上的优势。在AI计算中,显存带宽直接影响到数据处理速度,Ascend 910B在这方面的表现无疑为其赢得了更多的青睐。

功耗与效率,400W与300W的较量

功耗是衡量芯片效率的重要指标。Ascend 910B的功耗为400W,而英伟达A100则是300W。然而,当我们将功耗与性能相结合时,Ascend 910B的能效比却展现出了其独特的优势。在AI训练任务中,Ascend 910B的能效表现甚至超越了A100,这一成绩的取得,得益于华为在芯片设计上的精细打磨和优化。

技术细节,深入达芬奇与Ampere的心脏

技术的核心在于细节,而达芬奇架构和Ampere架构正是Ascend 910B和A100的心脏。

达芬奇架构是华为自研的AI计算架构,其设计哲学在于提供高效的AI计算能力。通过3D Cube矩阵运算单元,达芬奇架构能够在一个时钟周期内完成大量MAC操作,实现了对AI计算任务的加速。此外,达芬奇架构还支持多种精度计算,满足不同AI应用场景的需求。

Ampere架构作为英伟达的最新一代GPU架构,其创新之处在于对AI和HPC任务的优化。Ampere引入了新的Tensor Core和结构化稀疏技术,进一步提升了AI计算的性能和效率。同时,Ampere还强化了对多实例GPU(MIG)的支持,为多任务并行处理提供了可能。

AI芯片的国产化,迫在眉睫

在全球科技领域,中美之间的竞争愈发激烈,而华为Ascend 910B与英伟达A100的对决,正是这场博弈的缩影。

面对美国的禁售令,华为没有选择退缩,而是积极应对。通过加大研发投入,华为成功推出了Ascend 910B,不仅满足了国内市场的需求,更向世界展示了其技术实力。Ascend 910B的推出,是华为在逆境中坚持创新的明证,也是对美国技术封锁的有力回应。

随着国产替代潮的兴起,Ascend 910B迎来了前所未有的机遇。国内企业对于国产AI芯片的需求日益增长,Ascend 910B凭借其出色的性能和可靠的供应,迅速占领市场。这一过程中,Ascend 910B不仅推动了国内AI技术的发展,也加速了国产芯片的自主可控进程。

放眼全球,AI芯片市场的竞争日趋激烈。英伟达凭借其深厚的技术积累和广泛的市场影响力,长期占据市场主导地位。然而,随着华为等中国企业的崛起,这一格局正在发生改变。Ascend 910B的推出,不仅打破了英伟达的垄断,更为全球AI芯片市场带来了新的活力和竞争。

技术是企业发展的核心竞争力,而Ascend 910B的推出,背后有着深刻的逻辑和影响。

未来是星程大海,鹿死谁手不可知

在AI芯片的广阔天地中,Ascend 910B与A100正展开一场实战演练,它们在不同的应用场景下展现着自己的实力。

实验室中的理论性能只是开始,真正的考验在于实际应用中的表现。Ascend 910B和A100在图像识别、自然语言处理、科学计算等多个领域中被广泛应用。它们在处理复杂算法和大数据集时的性能,直接关系到AI应用的效率和准确性。

在大数据时代,AI芯片需求日益增长。Ascend 910B和A100都需要处理海量数据,并从中提取有价值的信息。无论是在数据中心的大型计算任务,还是在边缘设备上的小型计算需求,两款芯片都显示出了其在处理大数据方面的能力。它们在满足不同层次需求的同时,也推动了AI技术的发展和应用。

未来是属于AI的时代,Ascend 910B与A100只是序章,AI芯片的发展趋势和潜力无限。

未来AI芯片的技术路线图将更加注重性能与能效的平衡,同时,新的计算范式和算法优化也将不断推动芯片架构的创新。例如,通过采用先进的制程技术、内存技术,以及引入新的计算模型如神经形态计算,AI芯片将实现更高的计算效率和更低的能耗。

人工智能的下一站是AGI,即能够执行任何智能任务的AI系统。AI芯片作为实现AGI的关键,需要具备更强大的学习能力和适应性。未来AI芯片将更加智能化,能够自适应不同的任务和环境,为实现真正的AGI提供硬件基础。

国产AI芯片的长远布局不仅关乎技术发展,也是国家安全和产业竞争力的重要保障。通过持续的研发投入和技术创新,国产AI芯片将不断提升在全球市场的竞争力。同时,通过构建完善的生态系统和产业联盟,国产AI芯片将在全球AI领域占据更重要的地位。

随着技术的不断进步和市场需求的不断扩大,Ascend 910B与A100只是AI芯片发展的一个缩影。未来,无论是在技术层面还是在市场应用层面,AI芯片都将展现出更加广阔的发展前景和巨大的潜力。虽然英伟达现在如日中天,但需要知道的是,整个人类都还只站在AI的门槛边,等待我们的还将是一场长征。

记得在去年数据猿举办的线下论坛上,一位嘉宾说过的一句话,“英伟达现在是很厉害,但刚开始的时候,黄仁勋也是背着一个双肩包,走在清华大学校园里,求各个实验室的老师能用一下英伟达的产品。”

英伟达也是从无人问津一点点走过来的,并不是不可打败的神。

文:一蓑烟雨 / 数据猿

责编:凝视深空 / 数据猿

![[AI资讯·0618] 快手AI模型“可灵“在质量优于Sora,OpenAI和谷歌发布新技术推动AI视频推理发展,Gemini1.5Pro在该榜单中表现突出](https://img-blog.csdnimg.cn/img_convert/9143cf514b6c67e6f0cbc8369bbe3d09.jpeg)

![日本新入管法通过:2027年起实施[育成就劳]制度,新制度更适合外国劳工在日本工作和生活!](https://img-blog.csdnimg.cn/direct/3a80b05d92a84563adb187e68f674545.png)