文章目录

1.在使用YOLOv8进行目标检测模型训练时,减小批次大小(Batch Size)可能会加快训练速度。

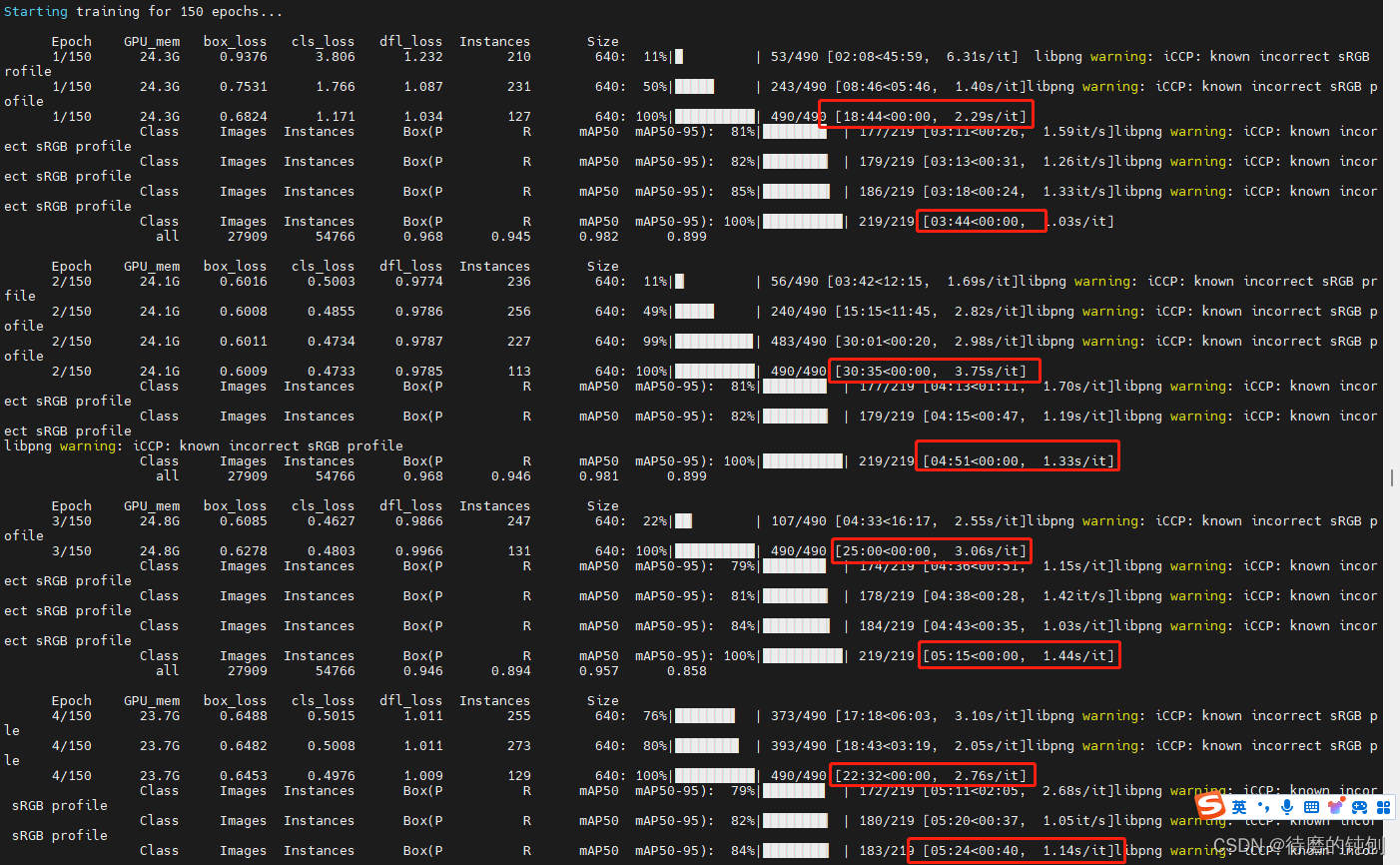

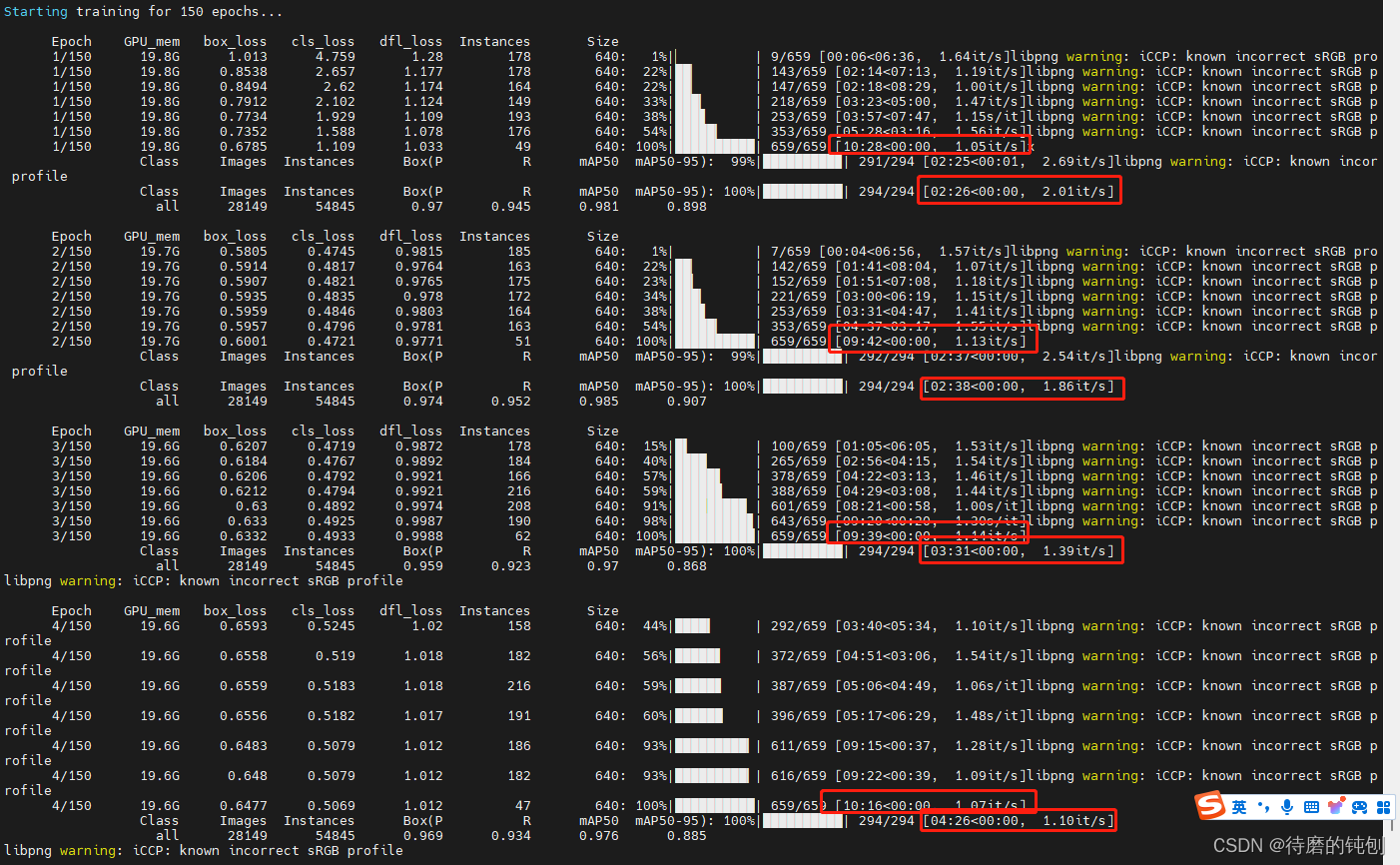

- Batch Size = 64*8

- Batch Size = 48*8

2. 这种现象主要与以下几个因素有关:

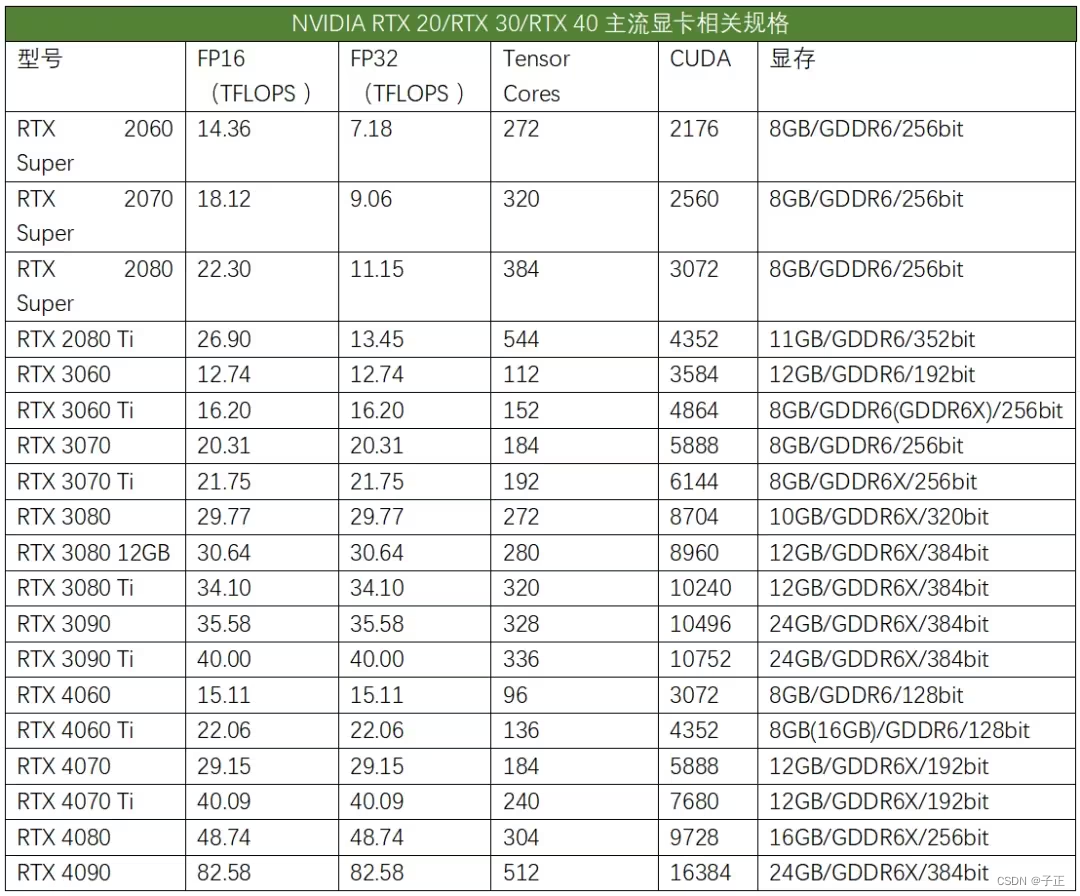

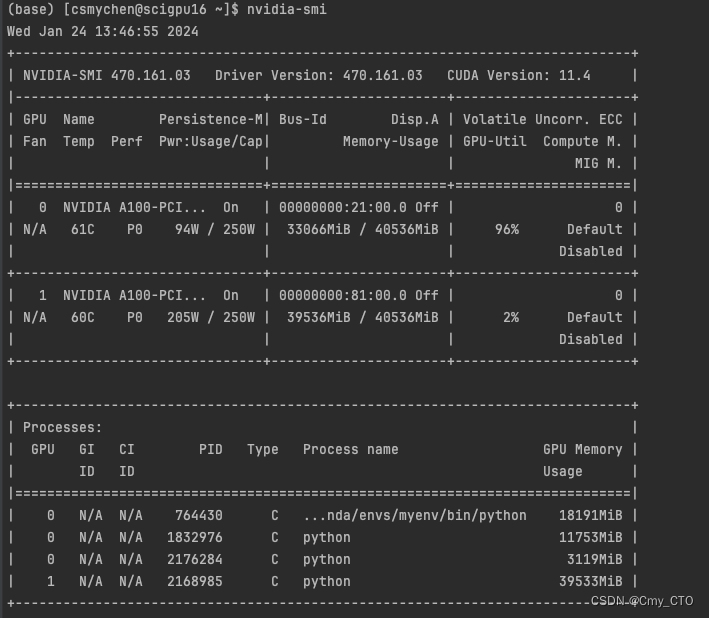

1.显存限制(GPU Memory Constraints):

- 较大的批次大小会占用更多的显存,而显存不足可能会导致显存溢出,进而需要频繁地从CPU到GPU之间传输数据,这会显著减慢训练速度。减小批次大小可以缓解显存压力,减少数据传输的开销,从而提高训练速度。

2.梯度累积(Gradient Accumulation):

- 在显存限制的情况下,采用较小的批次大小进行梯度累积(即在多次前向传播后累积梯度再进行一次反向传播)是一种常见的策略,这样可以在不增加显存需求的情况下达到大批次训练的效果,同时保持较高的训练效率。

3.硬件和软件优化(Hardware and Software Optimization):

- 有时候,硬件(如GPU)的计算资源和内存带宽对大批次的优化并不完全匹配,导致训练过程中并没有完全利用计算资源。减小批次大小可以更好地匹配硬件的计算和内存带宽,从而提高训练效率。

4.数据加载和预处理(Data Loading and Preprocessing):

- 较大的批次大小需要在每次迭代前加载和预处理大量数据,如果数据加载和预处理的效率不高,会成为训练过程中的瓶颈。较小的批次大小可以减少每次加载和预处理的数据量,从而提高数据准备的效率。

3. 潜在的缺点

需要注意的是,虽然减小批次大小可能会提高训练速度,但这也会带来一些潜在的缺点:

- 梯度估计不稳定:较小的批次大小会导致梯度估计的不稳定,可能会影响模型的收敛速度和最终的模型性能。

- 训练时间增加:总体的训练时间可能会增加,因为每个epoch的迭代次数变多了。

因此,在训练YOLOv8时,选择适当的批次大小需要综合考虑显存容量、数据加载速度、模型收敛性等因素,找到一个平衡点来优化训练速度和模型性能。