主要涉及要部署的前端webui是来源于:https://github.com/open-webui/open-webui

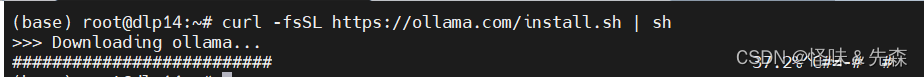

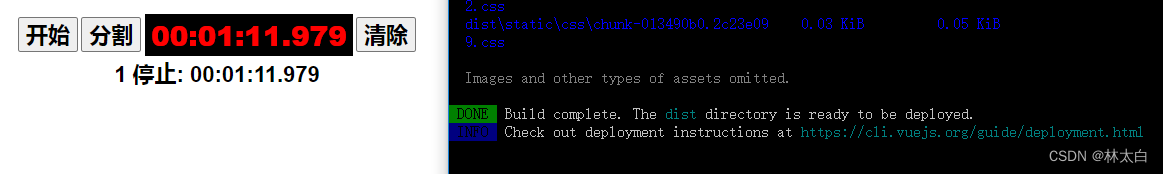

正常就使用:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

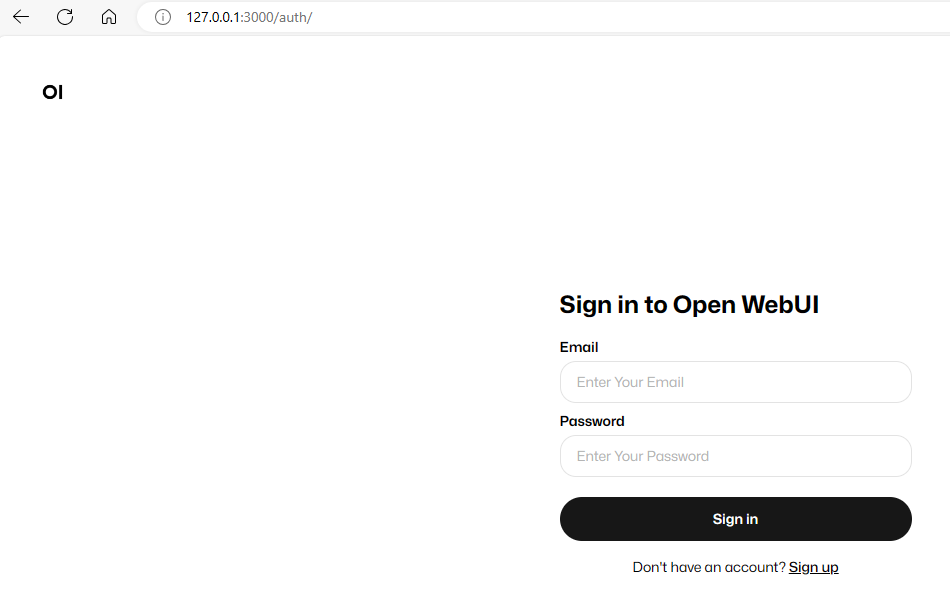

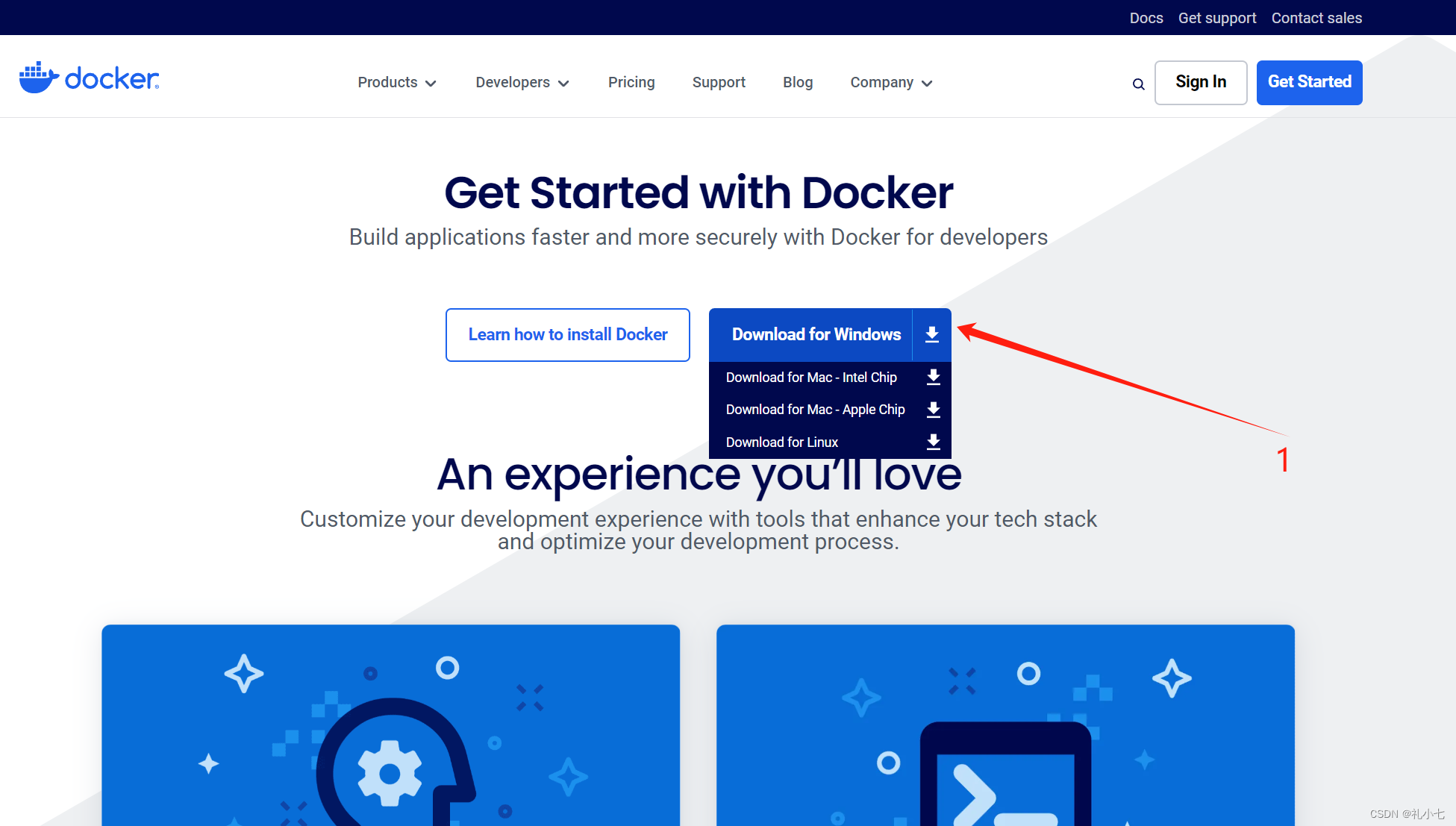

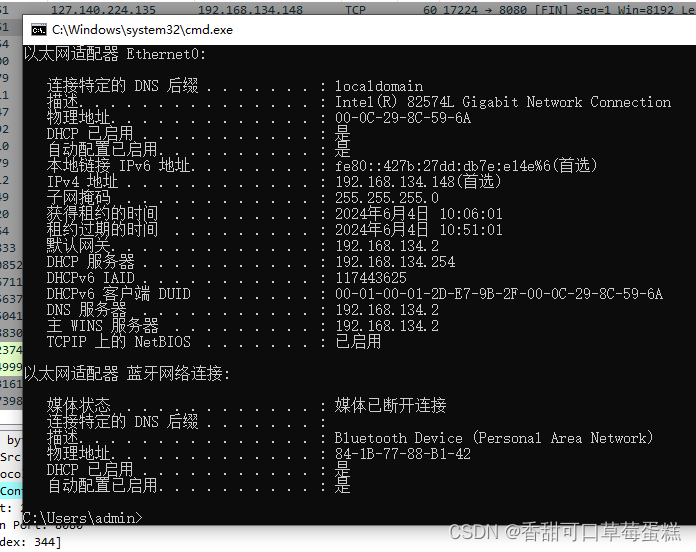

运行就好,依赖于docker,这个是ollama和webui需要同一台机器上。之后通过127.0.0.1:3000访问,这个3000端口安装需要可以改变。

其余的webui和ollama需要不同的设备上,就用项目里的其余命令。

如果还是操作有问题,参考