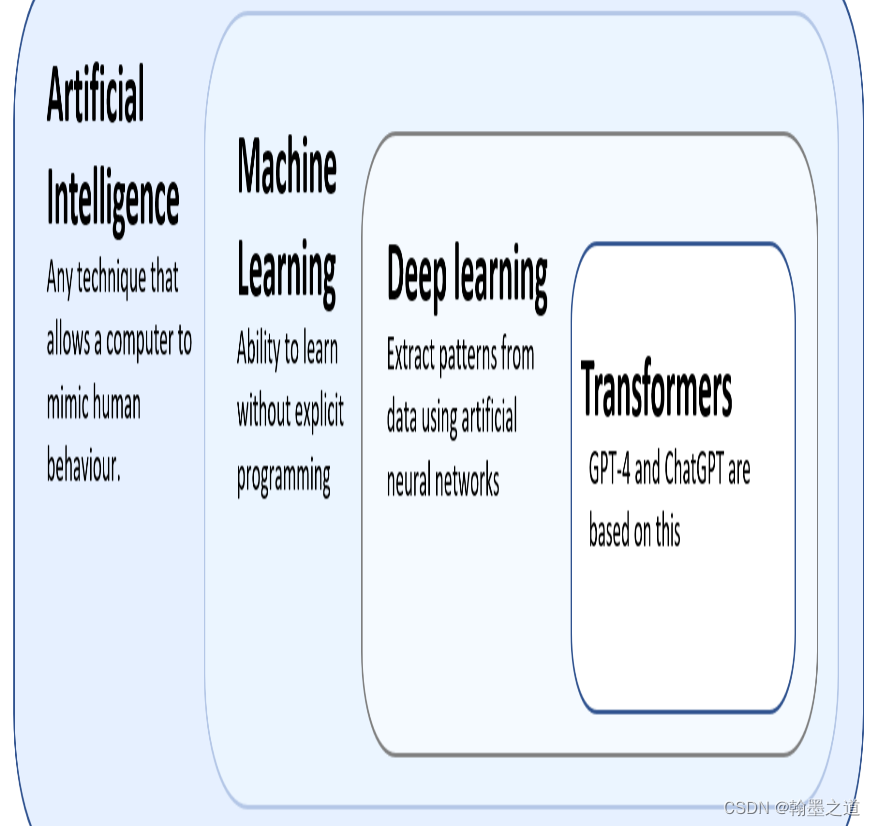

GPT-1

特点

- 架构:基于Transformer的解码器部分。

- 训练数据:使用了BookCorpus数据集,包含约7,000本电子书。

- 参数数量:约1.17亿个参数。

- 训练目标:以无监督方式进行语言建模,通过预测下一词来学习上下文关系。

创新点

- Transformer架构:首次应用于生成模型,展示了Transformer在自然语言生成任务中的潜力。

- 无监督预训练:证明了在大规模文本上进行无监督预训练的有效性。

GPT-2

特点

- 架构:扩大了GPT-1的规模。

- 训练数据:使用WebText数据集,包含约800万个网页。

- 参数数量:从1.17亿增加到15亿。

- 训练目标:依旧是无监督的语言建模,但模型规模和数据规模显著增加。

创新点

- 大规模预训练:展示了更大规模的模型在生成任务上的强大能力,生成的文本质量显著提升。

- 开放域生成:能够在多种任务中表现出色,如翻译、总结、问答等,展示了模型的广泛适用性。

GPT-3

特点

- 架构:进一步扩大模型规模。

- 训练数据:使用更大、更多样化的数据集,包括Common Crawl、WebText、Books等。

- 参数数量:从15亿增加到1750亿。

- 训练目标:继续采用无监督的语言建模,同时强调零样本、少样本学习能力。

创新点

- 极大规模模型:展示了模型规模对性能提升的巨大影响,尤其在少样本学习和零样本学习中的表现。

- 少样本学习:能够通过少量示例进行任务学习,减少了对大量标注数据的依赖。

GPT-4

特点

- 架构:在GPT-3的基础上进一步优化。

- 训练数据:使用更大规模和更多样化的数据集,进一步提升模型的泛化能力。

- 参数数量:虽然具体数字未公开,但预估显著增加。

- 训练目标:继续强化少样本学习和零样本学习,同时改进模型的推理和对话能力。

创新点

- 多模态能力:不仅支持文本,还可能支持图像、视频等多模态输入。

- 更高精度:通过优化训练过程和增加训练数据,提高模型在各类任务中的表现。

- 安全性和可靠性:进一步增强对有害内容的过滤和控制,提升模型的安全性和可靠性。

迭代总结

- 模型规模:每一代模型参数数量显著增加,提升了模型的生成能力和任务适应性。

- 训练数据:数据规模和多样性不断扩大,提升了模型的泛化能力。

- 训练目标:从单一的语言建模到多任务、多模态学习,提升了模型的灵活性和适用性。

- 技术创新:包括Transformer架构的应用、大规模预训练、少样本学习、多模态支持等,推动了模型性能的持续提升。

GPT系列模型的每次迭代都在前一代的基础上进行改进,通过增加模型参数、扩展训练数据集和优化训练方法,逐步提升模型的生成能力和任务表现。

![[数据集][目标检测]焊接处缺陷检测数据集VOC+YOLO格式3400张8类别](https://img-blog.csdnimg.cn/direct/534ed050a6684c3fa2450a397482e2c4.png)