目录

大家好,我是阳仔,一个对人工智能充满热情的新手。在这个快速发展的时代,人工智能技术已经成为推动许多行业革新的关键力量。从自动驾驶汽车到智能语音助手,从精准医疗到个性化教育,人工智能的应用无处不在,极大地改变了我们的生活方式和工作模式。作为一个初学者,我渴望探索这一领域的奥秘,学习如何利用这些强大的技术来解决实际问题。在这个学习旅程中,我希望能与大家分享我的学习心得和经验,同时也期待从大家那里获得宝贵的建议和指导。让我们一起在人工智能的浪潮中乘风破浪,探索未知的可能性!

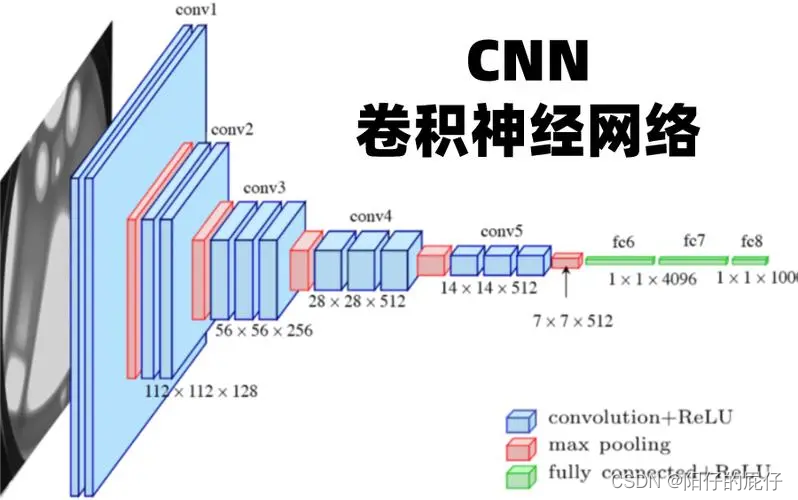

在人工智能的领域中,卷积神经网络(CNN)和循环神经网络(RNN)是两种极具影响力的神经网络架构,它们在处理不同类型的数据和任务中展现出了各自独特的优势。今天咱们就简单学习一下卷积神经网络(CNN)和循环神经网络(RNN)是两种常见的深度学习模型,它们在处理不同类型的数据时各有优势。

卷积神经网络(CNN)

CNN 主要用于处理图像数据。它通过使用卷积层来自动提取图像中的特征,这使得它在图像识别和处理方面非常有效。CNN 的关键部分包括:

- 卷积层(Convolutional Layer):通过滤波器(或称为卷积核)提取局部特征。

- 激活层(Activation Layer):通常使用 ReLU 函数来增加非线性。

- 池化层(Pooling Layer):降低特征维度,常用的方法有最大池化和平均池化。

- 全连接层(Fully Connected Layer):将学到的“高级”特征映射到最终的分类或回归任务中。

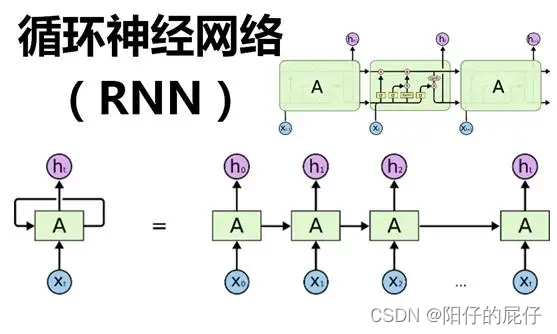

循环神经网络(RNN)

RNN 主要用于处理序列数据,如文本、时间序列数据等。它的特点是在模型中引入了“记忆”元素,能够将先前的信息传递到当前的任务中,这使得它在处理序列相关问题时非常有效。RNN 的关键部分包括:

- 循环单元(Recurrent Unit):能够处理输入数据的同时保持一个内部状态(或记忆),这个状态会随着每一个时间步被更新。

- 隐藏层状态(Hidden State):保存了序列中之前时间步的信息。

- 输出层(Output Layer):根据当前时间步的隐藏状态输出结果。

- 应用场景对比

应用场景

- CNN:图像识别、物体检测、图像分割等。

- RNN:自然语言处理、语音识别、时间序列预测等。

代码示例

这里给出一个简单的 CNN 和 RNN 的 PyTorch 实现示例。

CNN 示例

import torch

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 16, kernel_size=3, stride=1, padding=1)

self.relu = nn.ReLU()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc = nn.Linear(16 * 14 * 14, 10)

def forward(self, x):

x = self.pool(self.relu(self.conv1(x)))

x = x.view(-1, 16 * 14 * 14)

x = self.fc(x)

return x

RNN 示例

import torch

import torch.nn as nn

class SimpleRNN(nn.Module):

def __init__(self, input_size, hidden_size, num_layers, num_classes):

super(SimpleRNN, self).__init__()

self.hidden_size = hidden_size

self.num_layers = num_layers

self.rnn = nn.RNN(input_size, hidden_size, num_layers, batch_first=True)

self.fc = nn.Linear(hidden_size, num_classes)

def forward(self, x):

h0 = torch.zeros(self.num_layers, x.size(0), self.hidden_size).to(x.device)

out, _ = self.rnn(x, h0)

out = out[:, -1, :]

out = self.fc(out)

return out

这两个示例展示了如何在 PyTorch 中实现基本的 CNN 和 RNN 模型。希望这能帮助你更好地理解这两种网络的结构和功能。列举讲解

我们通过一个具体的例子来进一步探讨卷积神经网络(CNN)和循环神经网络(RNN)的区别和适用场景。

例子:图像分类与语言翻译

图像分类(使用 CNN)

假设我们有一个任务是对图像进行分类,比如识别一张图片是猫还是狗。这种类型的任务非常适合使用 CNN,因为 CNN 能够有效地从图像中提取空间层次的特征。

为什么选择 CNN:

图像是由像素的空间排列组成的,局部区域的像素组合往往包含重要信息(如边缘、纹理等),CNN 通过卷积层可以捕捉这些局部特征。卷积操作保持了图像的空间关系,使得模型能够学习到各种方向和位置的特征。池化层能够减少计算量同时保持特征的不变性(如平移不变性)。简单的 CNN 模型结构可能包括:

- 多个卷积层和激活层,用于提取图像特征。

- 池化层,用于降低特征维度。

- 全连接层,用于将提取的特征映射到分类结果。

语言翻译(使用 RNN)

现在假设我们有一个任务是将英文翻译成中文。这种类型的任务非常适合使用 RNN,因为 RNN 能够处理序列数据,并且能够利用之前的信息(即上下文)来影响后续的输出。

为什么选择 RNN:

语言翻译需要理解整个句子的上下文,这需要记忆之前的单词来更好地预测接下来的单词。RNN 通过其循环结构,能够将之前时间步的隐藏状态传递到当前时间步,从而保持了对之前信息的记忆。语言的序列性质使得序列模型(如 RNN)特别适用。简单的 RNN 模型结构可能包括:

- RNN 层,用于处理序列数据并保持时间上的状态。

- 全连接层,用于将 RNN 的输出映射到目标语言的词汇上。

总结

CNN 更适合处理具有空间关联性的数据(如图像),通过其卷积层能够有效提取空间特征。

RNN 更适合处理序列数据(如文本),通过其循环结构能够处理时间序列信息并保持上下文的连续性。

实例:OCR

OCR(光学字符识别)技术通常会使用 CNN,但在更复杂的系统中,可能会结合使用 CNN 和 RNN,以及其他技术如 CTC(Connectionist Temporal Classification)来提高识别的准确性和效率。

使用 CNN 的原因

在 OCR 任务中,CNN 能够有效地从图像中提取特征。这些特征包括字符的形状、大小、方向等,这些都是进行字符识别所必需的。CNN 的层次结构使其非常适合从原始像素数据中逐层提取越来越抽象的视觉特征。

结合 RNN 的优势

尽管 CNN 在图像特征提取方面表现出色,但 OCR 任务通常涉及到从图像中识别文本序列。这里的文本序列意味着字符之间存在依赖关系,单个字符的上下文信息对于正确识别非常重要。在这种情况下,RNN(特别是其变体如 LSTM 或 GRU)可以用来处理由 CNN 提取的特征序列,因为 RNN 能够处理序列数据并记住长序列中的上下文信息。

CTC 的作用

在 OCR 中,尤其是当文本行的长度未知或者字符之间的间距不均匀时,直接从序列特征到文本输出的映射变得复杂。CTC 可以在这里发挥作用,它允许模型生成不定长的输出,并且能够在训练过程中自动对齐输入数据和目标文本标签。

综合模型示例

一个典型的 OCR 系统可能包括以下步骤:

- 预处理:图像归一化、去噪、二值化等。

- 特征提取:使用 CNN 提取图像特征。

- 序列建模:使用 RNN 处理特征序列,捕捉字符之间的依赖关系。

- 解码:使用 CTC 或其他解码算法将 RNN 的输出转换为最终的文本。

- 代码示例

这里是一个简化的模型结构,展示如何在 PyTorch 中结合 CNN 和 RNN 来处理 OCR 任务:

import torch

import torch.nn as nn

class CRNN(nn.Module):

def __init__(self, num_classes):

super(CRNN, self).__init__()

self.cnn = nn.Sequential(

nn.Conv2d(1, 16, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(2),

nn.Conv2d(16, 32, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(2)

)

self.rnn = nn.LSTM(32, 64, num_layers=2, batch_first=True)

self.fc = nn.Linear(64, num_classes)

def forward(self, x):

x = self.cnn(x)

x = x.squeeze(2) # 假设 x 的形状是 [batch_size, channels, height, width]

x = x.permute(0, 2, 1) # 调整维度以适应 RNN 输入

x, _ = self.rnn(x)

x = self.fc(x)

return x

# 假设 num_classes 是字符集大小加上一个额外的空白标签用于 CTC

model = CRNN(num_classes=11)

这个模型是一个简化的 CRNN(卷积循环神经网络),它结合了 CNN 的图像特征提取能力和 RNN 的序列处理能力,非常适合处理 OCR 任务。

以上就是CNN和RNN的简单学习了总结,坚持跟阳仔一起学习AI知识。