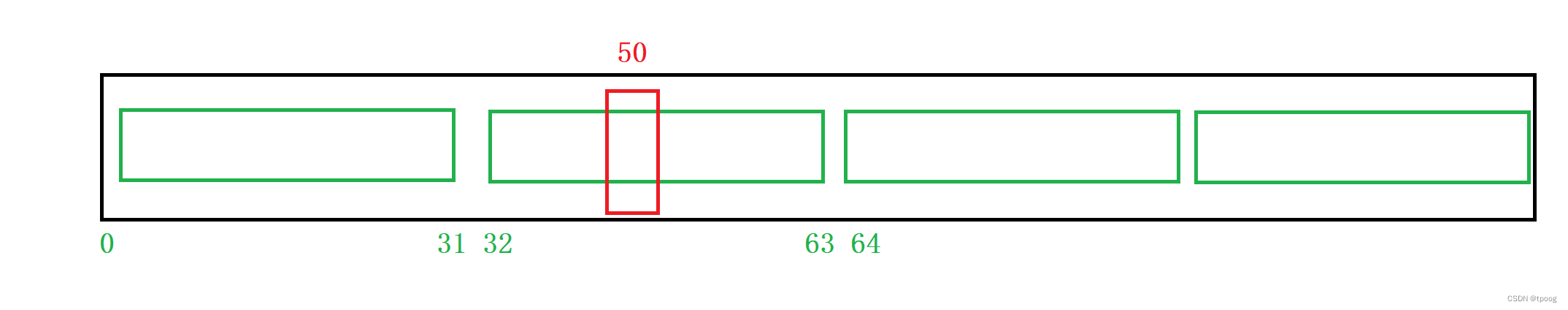

在 ViT(Vision Transformer)模型中,输入图像被分割成固定大小的图块,然后通过一个线性变换(通常是一个卷积层)来将每个图块投影到一个较低维度的特征空间。这些投影后的图块被视为序列,然后输入到Transformer模型中。在Transformer的self-attention层中,每个位置的图块都会产生自己的查询(Q)、键(K)和值(V)向量。这些Q、K、V向量用于计算注意力权重,并生成每个位置的输出。

如果输入图像的图块数减少,即图块的数量减少,那么每个图块将捕获更广泛的上下文信息。这意味着在较小的输入图像中,每个位置的图块将覆盖更多的内容。然而,由于图块数的减少,可能会导致每个位置的查询、键和值向量的维度较大,这可能会导致较大的注意力矩阵,从而增加计算成本。为了平衡这一点,可能需要调整Q、K、V向量的维度,以及注意力头的数量,以适应变化的输入大小,并保持计算成本相对较低。

总的来说,如果输入图像的图块数量减少,Q、K、V向量可能会变得更大,以捕获更广泛的上下文信息,并且可能需要调整注意力头的数量以及向量的维度,以适应变化的输入大小。