在当前移动互联网的运维环境中,日志数据量通常非常巨大,因此需要精细化的日志存储策略来确保系统的性能、成本效率和可扩展性。以下是一些笔者认为可以落地实施的精益日志存储策略:

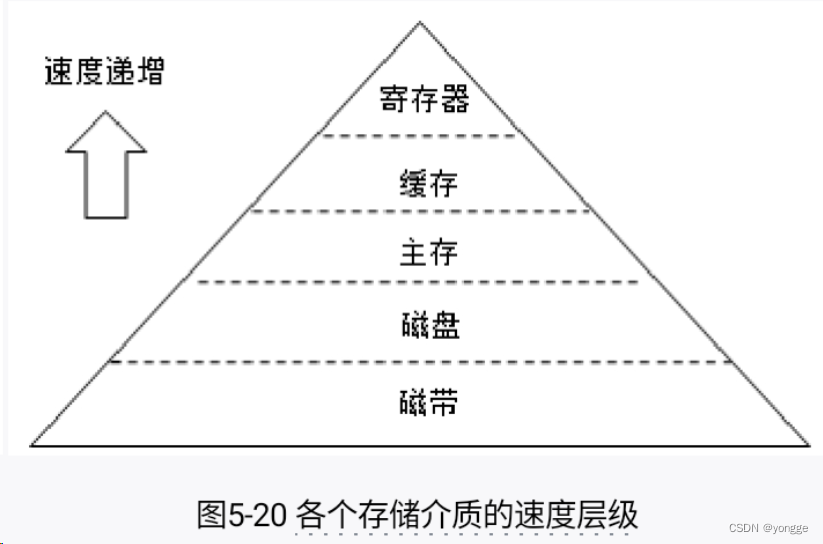

日志分级存储:

- 热存储:将最近的或经常访问的日志保留在高性能的存储系统(如SSD)中,以便快速访问和分析。

- 冷存储:随着时间的推移,将旧日志迁移到成本较低的存储解决方案中,如高容量硬盘或云存储服务。

- 归档:对于需要长期保留但不常访问的日志,可以将其归档到更经济的存储介质上,如磁带或低成本云归档服务。

日志压缩与去重:

- 使用压缩算法(如Gzip)减少存储占用。

- 实施日志去重技术,避免存储重复的日志内容,特别是在多节点环境中。

基于策略的日志留存:

- 根据法规、业务需求和安全政策制定日志保留策略。

- 定期审查和调整保留策略,以确保不保留不必要的日志数据,从而减少存储需求。

智能解析和索引:

- 在存储之前,对日志进行智能解析,仅存储关键信息,减少不必要的日志详情。

- 使用有效的索引策略,提高查询效率,减少对存储系统的负载。

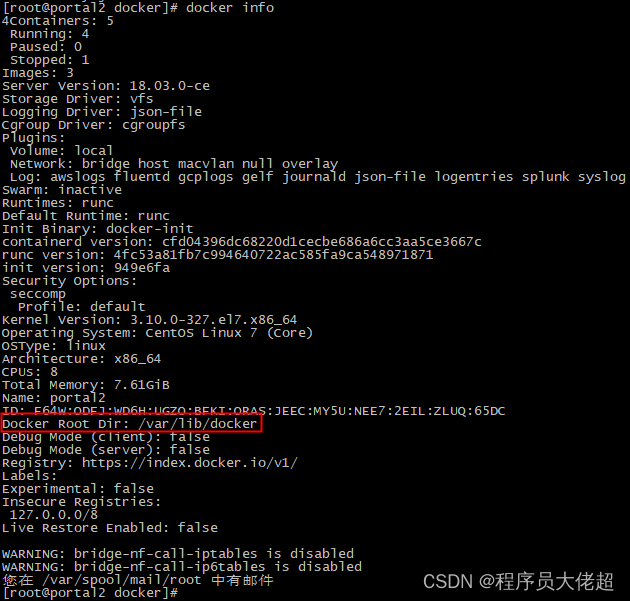

采用分布式日志系统:

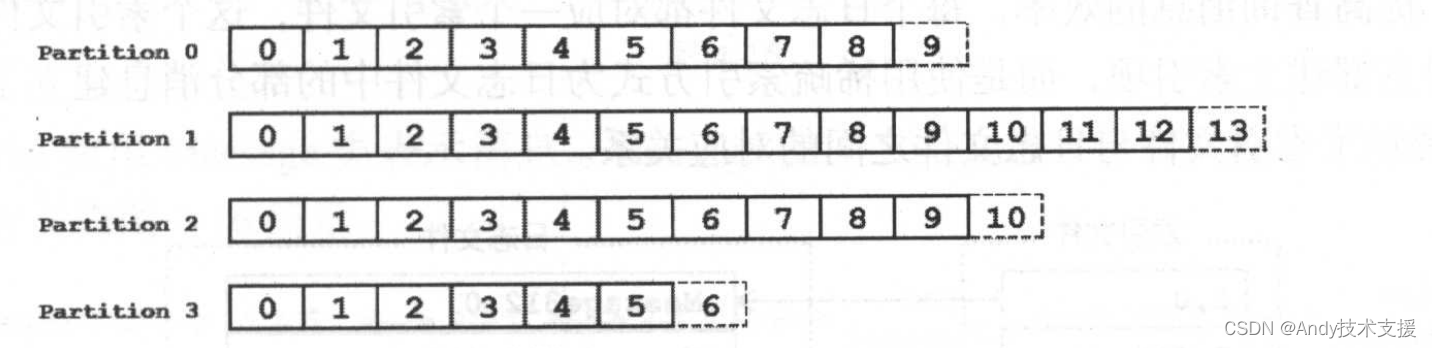

- 使用如Elasticsearch、Apache Kafka等分布式日志处理系统,可以提高数据处理速度,优化存储结构。

- 分布式系统可以通过增加节点来水平扩展,提高存储和处理能力。

监控和自动化管理:

- 实施日志生成和存储的实时监控,确保系统不会因日志泛滥而影响性能。

- 自动化过期日志的清理和存储空间的回收。

考虑云存储解决方案:

- 利用云服务提供的可扩展性和成本效益,特别是对于冷数据或归档数据。

- 选择合适的云服务级别,根据访问频率和数据重要性选择不同的存储类型。

以下展开说部分内容。

一、日志去重技术

指纹技术(Fingerprinting):

- 使用哈希算法(如MD5、SHA-256)对日志条目生成唯一指纹。只存储未见过的唯一指纹,从而避免重复存储相同内容。

内容定义块级去重(Content-Defined Chunking, CDC):

- 将数据分割成多个块,并对每个块进行哈希,只保存未曾出现过的块。这种方法在文件系统级别尤为常见,适用于大规模数据去重。

时间窗口去重:

- 在一个定义的时间窗口内,只保留一条具有相同内容的日志。这适用于高频生成的重复日志,如心跳或状态检查日志。

模式识别:

- 识别日志中的重复模式或常见模板,并仅存储变量信息。例如,对于格式化日志,可以只存储与模板不同的部分。

可用的开源工具(包括但不仅限于)

Logstash:

- Logstash是ELK栈的一部分,可以通过其丰富的过滤插件来实现日志去重。使用

fingerprint插件可以对日志数据生成哈希值,以识别和过滤重复事件。

- Logstash是ELK栈的一部分,可以通过其丰富的过滤插件来实现日志去重。使用

rsyslog:

- rsyslog提供了

mmnormalize模块,可以对日志进行规范化处理,从而辅助去重。虽然它本身不直接支持去重,但可以通过外部脚本或程序来实现。

- rsyslog提供了

Fluentd:

- Fluentd是一个开源数据收集器,它可以通过插件来扩展功能,包括去重。可以编写自定义的Fluentd插件来处理日志去重。

BorgBackup:

- 虽然BorgBackup是一个备份工具,但它内置了高效的去重功能。它使用变长块去重技术,适合于需要备份大量日志数据的场景。

Dedupely:

- 这是一个专门用于数据去重的工具,虽然不专门针对日志数据,但其去重算法可以应用于包括日志在内的各种数据类型。

二、日志压缩技术

基于文本的压缩:

- Run-Length Encoding (RLE): 对连续重复的字符进行编码,适用于高度冗余的文本数据。

- Huffman Coding: 一种变长编码技术,常用于文本数据压缩,通过为常见字符分配较短的编码。

- Lempel-Ziv (LZ77 and LZ78) Algorithms: 这些算法是许多现代压缩工具的基础,例如gzip和zip,通过查找重复的字符串来压缩数据。

二进制压缩:

- Delta Encoding: 存储数据之间的差异,而不是完整的记录,适用于数值日志数据。

- Bit Packing: 基于实际数值范围调整存储位数,减少无用的存储空间。

可用的开源工具(包括但不仅限于)

gzip:

- gzip是最常用的压缩工具之一,基于DEFLATE算法,提供了良好的压缩率和相对较快的压缩速度,广泛用于日志文件的压缩。

bzip2:

- bzip2提供比gzip更高的压缩率,但压缩和解压速度较慢,适用于对压缩率要求较高的场景。

xz:

- xz基于LZMA算法,提供高压缩率,通常比bzip2更有效率,尤其适合大型日志文件的压缩。

Zstandard (zstd):

- Zstandard是由Facebook开发的压缩算法,提供高压缩率和非常快的解压速度,适合实时日志处理和传输。

Snappy:

- Snappy由Google开发,设计目标是提供合理的压缩率和非常快的压缩速度,适用于需要快速压缩且CPU资源有限的场景。

LZ4:

- LZ4是一个非常快速的压缩算法,提供适中的压缩率,非常适合那些需要极速压缩和解压的场合,如实时数据处理和日志管理。

三、日志智能解析

从原始日志数据中提取结构化信息,并建立索引以便快速查询和分析。

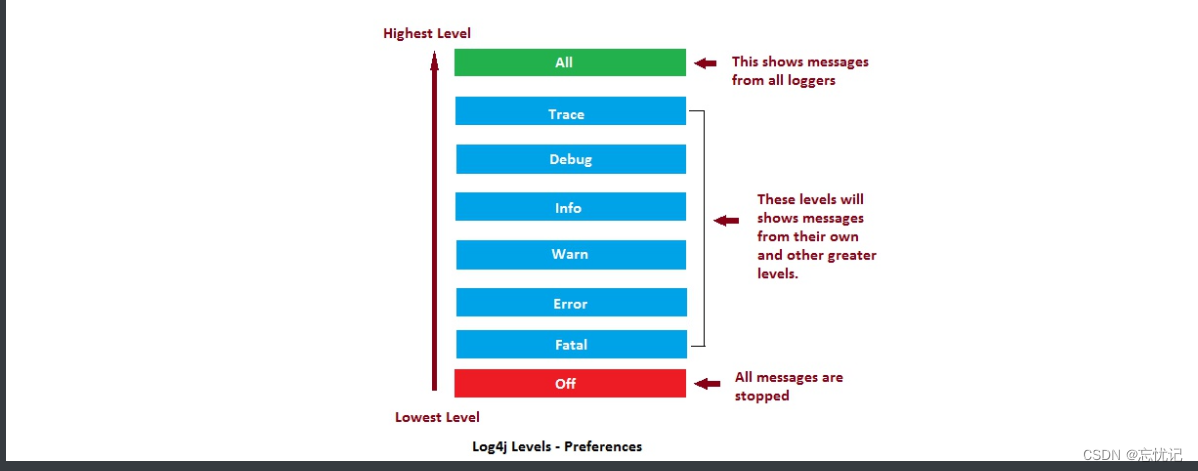

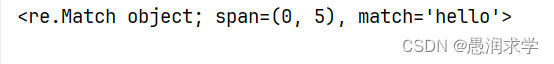

正则表达式匹配:

- 使用正则表达式来识别和提取日志中的关键信息,如时间戳、日志级别、错误代码等。

自然语言处理(NLP):

- 应用NLP技术来理解和解析日志内容,特别是对于非结构化或半结构化的文本数据。

机器学习模型:

- 利用机器学习算法自动识别和分类日志数据中的模式,以及预测潜在的问题和异常。

语义分析:

- 进行深入的语义分析来理解日志消息的含义,这对于复杂的系统日志尤为重要。

分布式索引和搜索引擎:

- 使用分布式搜索引擎技术来索引和检索大规模的日志数据,支持高效的查询性能。

可用的开源工具(包括但不仅限于)

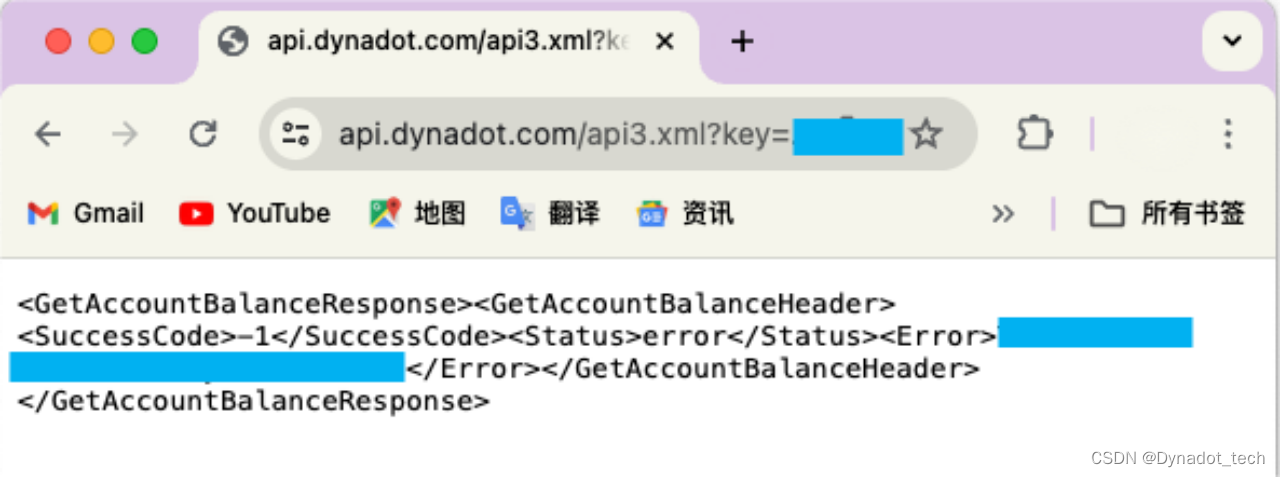

Elasticsearch:

- Elasticsearch是一个高度可扩展的开源全文搜索和分析引擎,常用于日志数据的索引和搜索。它可以实时处理大量数据,并支持复杂的数据查询。

Logstash:

- Logstash是ELK栈(Elasticsearch, Logstash, Kibana)的一部分,用于日志数据的收集、处理和转发。它支持多种输入插件和过滤器,可以解析不同格式的日志数据。

Fluentd:

- Fluentd是一个开源数据收集器,用于统一日志层。它提供了丰富的插件,支持多种数据源和输出,包括Elasticsearch等搜索引擎。

Apache Solr:

- Apache Solr是一个开源搜索平台,基于Apache Lucene构建。它支持复杂的搜索功能,并可以用于大规模日志数据的索引和搜索。

Graylog:

- Graylog是一个开源的日志管理平台,提供了日志收集、索引和实时分析的功能。它内置了Elasticsearch作为搜索引擎,支持高效的日志数据查询和分析。

Apache Kafka + Apache Spark:

- 结合使用Apache Kafka和Apache Spark可以构建一个强大的实时日志处理系统。Kafka用于高吞吐量的日志数据传输,而Spark可以用于实时数据处理和分析。