本文并非逐句翻译,添加个人理解与疑惑,如有需要,请自行阅读原文。

Geometric Multimodal Contrastive Representation Learning

几何多模态对比表征学习

发表在 2022 ICML

数据集:

由于从不同通道获得的数据的固有异质性,在测试时对缺失模态既有信息又鲁棒的多模态数据的学习表示仍然是一个具有挑战性的问题。为了解决这个问题,我们提出了一种新的几何多模态对比(GMC)表示学习方法,该方法由两个主要部分组成:i)由模态特定的基本编码器和共享投影头组成的两级结构,该编码器允许将任意数量的模态处理为固定维度的中间表示,该投影头将中间表示映射到潜在表示空间; ii)多模态对比损失函数,其鼓励所学习的表示的几何对齐。我们的实验表明,GMC表示是语义丰富的,并实现了最先进的性能与丢失的模态信息在三个不同的学习问题,包括预测和强化学习任务。

1. Introduction

多模态表征学习降低了原始多模态数据的固有复杂性,并且能够提取不同模态之间的潜在语义相关性。通常,多模态数据的良好表示(i)捕获执行给定下游任务所需的各个模态的语义。此外,在现实世界的分类和控制等场景中,(ii)获得的表示在执行过程中对缺失的模态信息具有鲁棒性是至关重要的。为了实现i)和ii)中的要求,需要根据每种模态的独特特征进行相应和高效的处理,并将它们有效地结合起来,这仍然是一个具有挑战性的问题,被称为多模态表征学习中的异质性差距。

缓解异构性差距的一个直观想法是将异构数据投射到共享的表示空间中,以便完整观察的表示捕获跨所有模态共享的语义内容。在这项工作中,作者专注于在不同数据源之间的异质性差距中出现的(共享的)潜在空间中对齐特定模态表示的问题。在这方面,有两个方向显示出希望,

即基于生成的方法通常将变分自编码器(VAE)框架(Kingma & Welling, 2014)扩展到多模态数据,如MVAE (Wu & Goodman, 2018)和MMVAE (Shi et al., 2019);

以及依赖于特定模态表示融合的方法,如MFM (Tsai et al., 2019b)和Multimodal Transformer (Tsai et al., 2019a)。基于融合的构建方法实现了目标 i),但通常不提供一种机制来处理缺失的模态。虽然这在基于生成的方法中得到了更好的解释,但由于要求很高的重建目标,这些方法经常难以对齐完整的和特定于模态的表示。

与这两种模式相比,GMC能够学习多模态任意性质的模态表示,不需要明确的监督信号(如标签)。

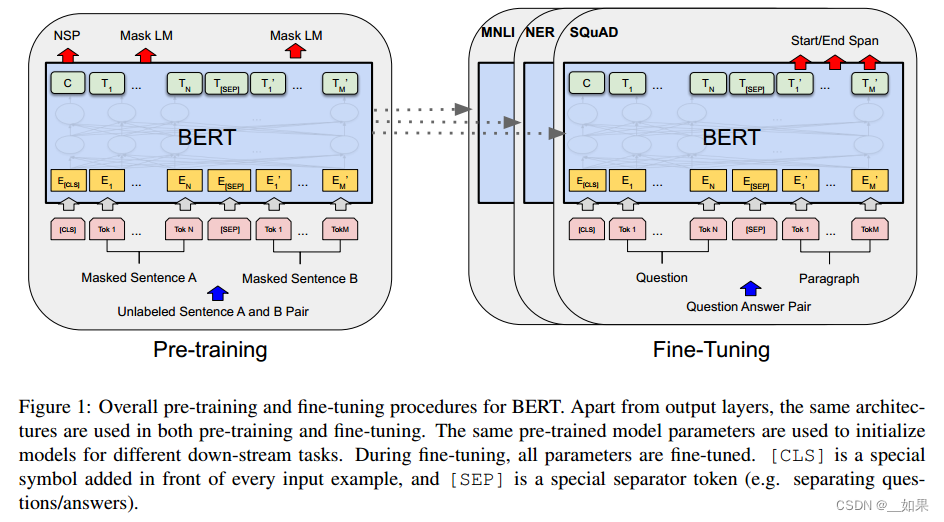

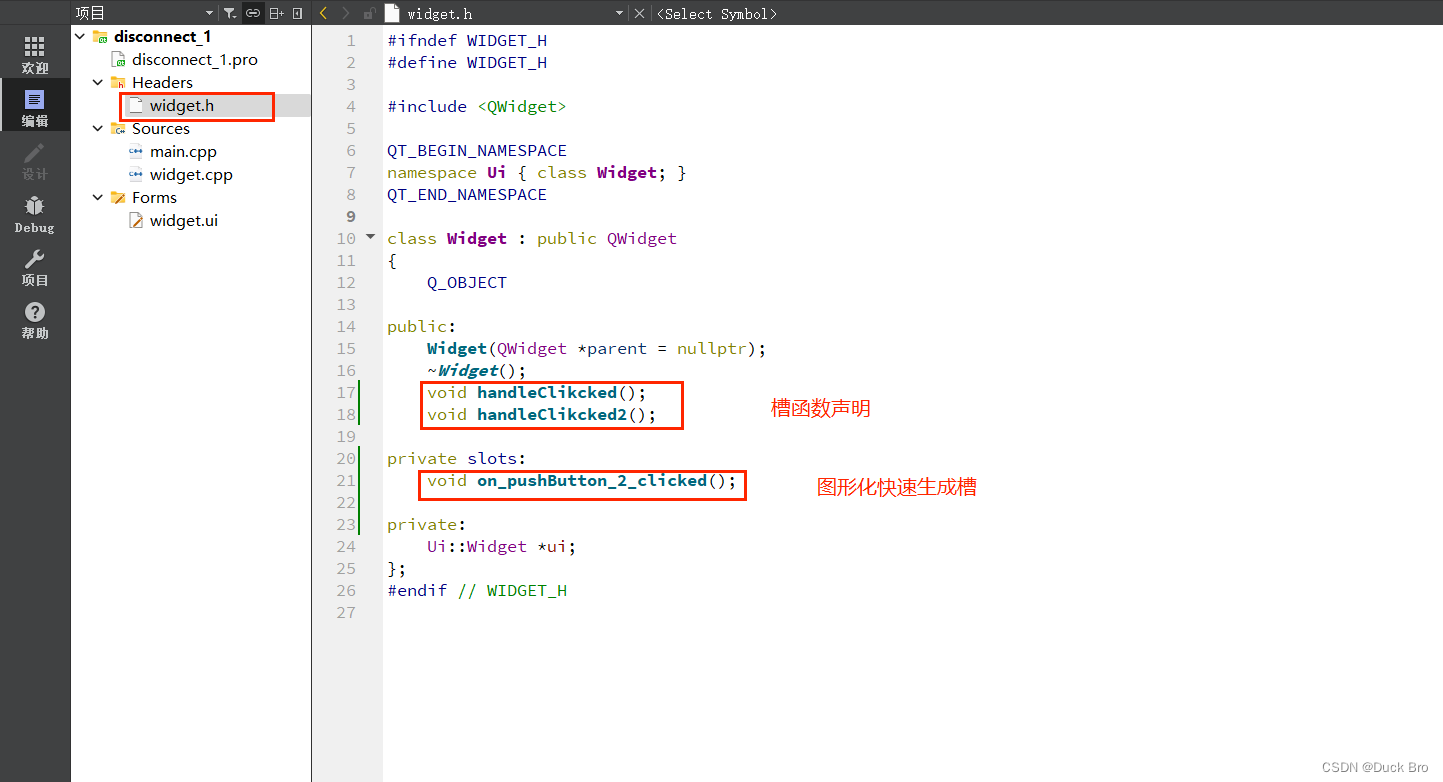

本文提出了几何多模态对比(GMC)框架,通过对齐相应的模态特定(z1或z2)和完整(z1:2)表示(实线箭头,蓝色圆圈)并与不同的模态特定和完整对进行对比,来学习多模态数据的表示。

受最近在视觉对比表示学习中提出的归一化温度缩放交叉熵(NT-XEnt)损失的启发(Chen等,2020),本文提出了一种新颖的多模态对比损失,明确地将模态特定表示与从相应完整观测中获得的表示进行对齐,如图1所示。

GMC假设一个由一组模态特定基本编码器组成的两级神经网络模型架构,将模态数据处理成固定维度的中间表示,以及一个共享投影头,将中间表示映射到潜在表示空间,其中应用对比学习目标。它可以扩展到任意数量的模态,并提供语义丰富的表示,对缺失的模态信息具有鲁棒性。此外,正如本文实验所示,GMC是通用的,因为它可以集成到现有模型中,并应用于各种具有挑战性的问题,例如以无监督的方式学习表示(第5.1节),使用弱监督信号进行预测任务(第5.2节)或下游强化学习任务(第5.3节)。本文展示了与现有模型相比,GMC能够在缺失模态信息的情况下实现最先进的性能。

2. The Problem of Geometric Misalignment in Multimodal Representation Learning 多模态表征学习中的几何错位问题

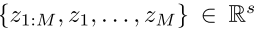

我们考虑以N元组的数据集X的形式提供信息的场景,即![]() ,其中每个元组

,其中每个元组![]() 表示M种不同模态提供的观测值。我们将包含所有M模态的元组

表示M种不同模态提供的观测值。我们将包含所有M模态的元组![]() 称为完整观测值,将单个观测值xm称为模态特定值。目标是学习

称为完整观测值,将单个观测值xm称为模态特定值。目标是学习![]() 完整的表示

完整的表示![]() 和

和![]() 特定于模态的表示

特定于模态的表示![]() ,它们是:

,它们是:

i) 信息丰富,即![]() 和任何

和任何![]() 都包含某些下游任务的相关语义信息,因此,

都包含某些下游任务的相关语义信息,因此,

ii) 在测试时对缺失模态具有鲁棒性,即后续下游任务的成功与提供的输入是完整表示 ![]() 还是任何模态特定表示

还是任何模态特定表示 ![]() 无关。

无关。

先前的工作已经证明在各种应用中使用完整表示z1:M是成功的,例如图像生成和雅达利游戏的控制。直观地说,如果完整表示z1:M足以执行下游任务,那么在同一表示空间中与z1:M几何对齐的学习模式特定表示应该确保zm包含执行任务所需的信息,即使z1:M无法提供。因此,在第5节中,本文研究了z1:M和每个zm在几个多模态数据集和最先进的多模态表示学习模型上的几何对齐。

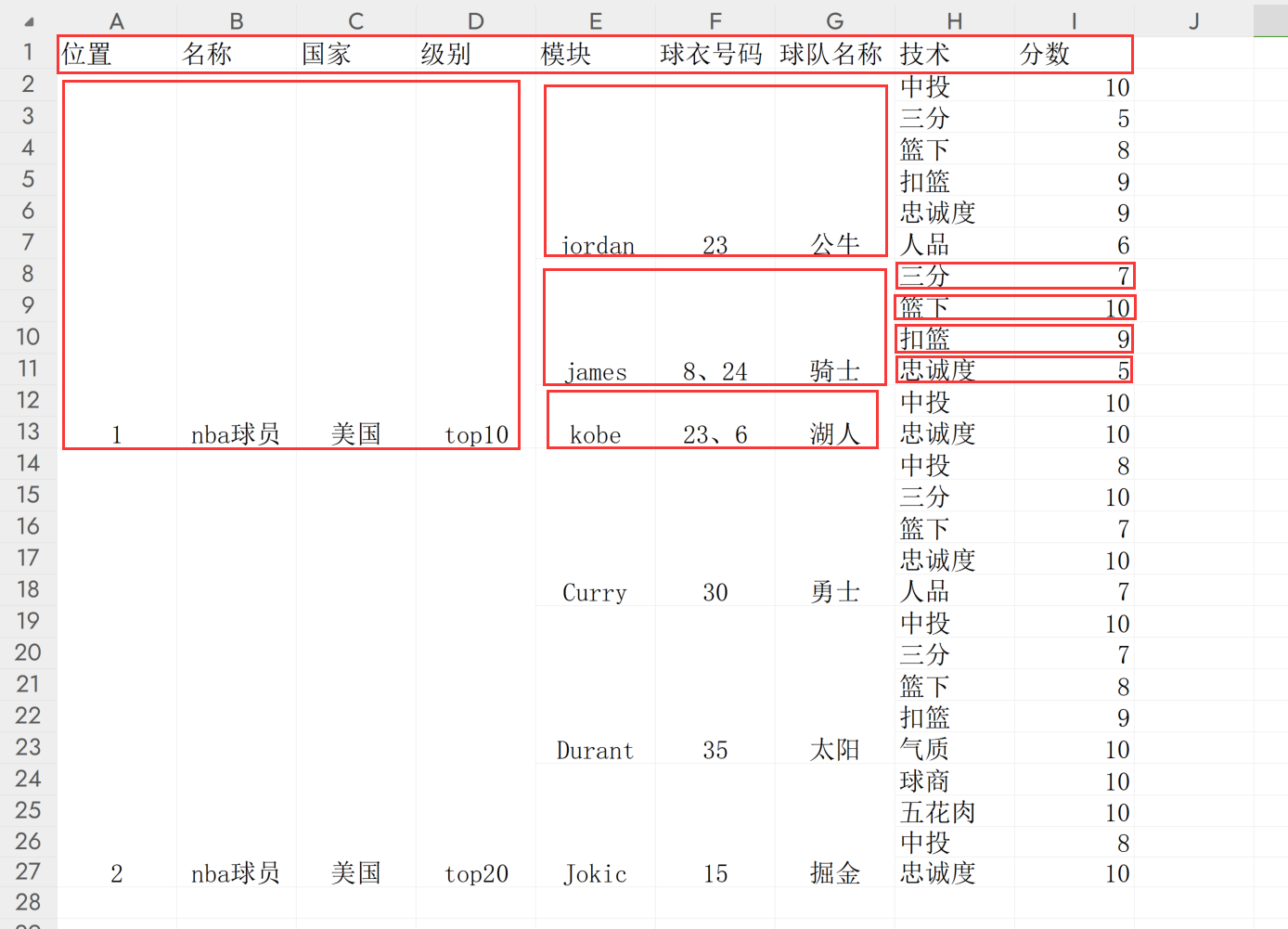

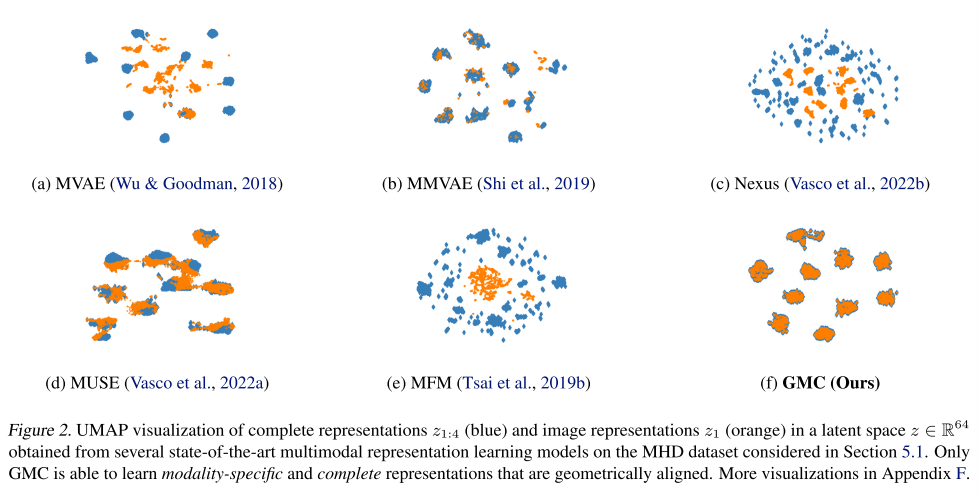

在图2中,可视化了z1:M(蓝色)和zm对应于图像模态(橙色)的编码示例,其中我们看到现有方法产生几何上不对齐的表示。正如在第5节中经验显示的那样,这种偏差在不同的学习场景和数据集中是一致的,并且可能导致下游任务的性能不佳。

在潜在空间z∈R64中,完整表示z1:4(蓝色)和图像表示z1(橙色)的UMAP可视化,从5.1节中考虑的MHD数据集上的几个最先进的多模态表示学习模型中获得。只有GMC能够学习特定于模态的和几何对齐的完整表示。

为了实现i)和ii),我们提出了一种新的方法,该方法基于一个简单的思想,即在潜在表征空间中以几何方式将模态特定表征zm与相应的完整表征z1:M对齐,并将其构建为一个对比学习问题。

3. Geometric Multimodal Contrastive Learning

几何多模态对比框架包含三个主要成分:

基础编码器集合 f(·):这个集合包含了一系列神经网络基础编码器,表示为

。其中,f1:M(·) 和 fm(·) 分别接受完整的 x1:M 和特定模态观测值 xm 作为输入,并输出中间的 d 维表示

。其中,f1:M(·) 和 fm(·) 分别接受完整的 x1:M 和特定模态观测值 xm 作为输入,并输出中间的 d 维表示

共享投影头 g(·):这是一个神经网络共享投影头,将基础编码器 f(·) 给出的中间表示映射到潜在表示

,并对其应用对比项。投影头 g(·) 使得中间表示在共享的表示空间 Z 中编码,同时保留模态特定的语义。

,并对其应用对比项。投影头 g(·) 使得中间表示在共享的表示空间 Z 中编码,同时保留模态特定的语义。多模态对比 NT-Xent 损失函数 (LGMC):这个损失函数受到最近提出的 SimCLR 框架的启发,鼓励 zm 和 z1:M 的几何对齐。

作者将zm与z1:M的几何对齐问题描述为一个对比预测任务,其目标是在给定的小批量中识别zm及其对应的完整表示z1:M。

假设![]() 是B个完备表示的一个mini-batch。

是B个完备表示的一个mini-batch。

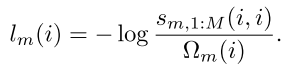

sim(u,v)表示向量u与v之间的余弦相似度,τ∈(0,∞)是温度系数,对于mini-batch B 中第 i 和第 j 个样本对应的表示 zi m 和 zj n(特定于模态或完整的),计算它们的相似度。

![]()

对于给定的模态 m,我们将正对样本定义为![]() ,其中 i = 1, . . . , B,并将其余样本对视为负对。与正对

,其中 i = 1, . . . , B,并将其余样本对视为负对。与正对![]() 对应的负对之间的相似度之和,用以下方式表示:

对应的负对之间的相似度之和,用以下方式表示:

并定义同一对样本的对比损失为

最后,结合了每个模态m = 1,…的损失项。,M,得到最终的训练损失

作者只对比了单一模态特定的表示与完整的表示,LGMC可线性扩展到任意数量的模态。在第5节中,表明LGMC可以作为一个额外的term添加到现有框架中,以提高它们对缺失模态的鲁棒性。此外,还通过实验证明了基础编码器和共享投影头的结构可以根据任务灵活调整。

4 Related Works

5 Experiments

评估了GMC在三种不同场景下学习到的表示的质量:

1、无监督学习问题,在多模态手写数字(MHD)数据集上学习多模态表示(Vasco等人,2022b)。作者展示了表征的几何对齐,并展示了与缺失模态的下游分类任务的基线相比,GMC的优越性能(第5.1节);

2、一个监督学习问题,通过将GMC集成到最先进的方法中来展示GMC的灵活性,从而在具有挑战性的分类场景中为缺失的模式提供鲁棒性(第5.2节);

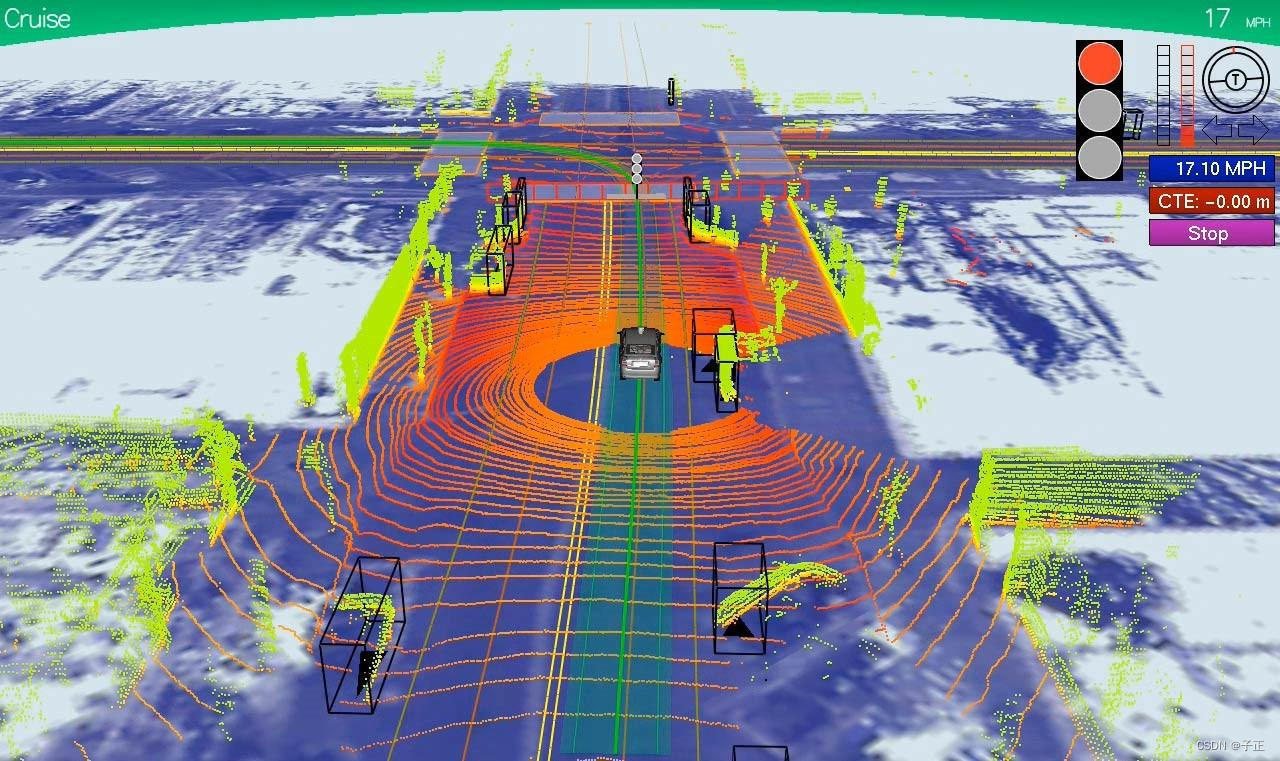

3、强化学习(RL)任务,其中展示了GMC产生的一般表示,可用于解决下游控制任务,并在缺少模态信息的情况下展示最先进的驱动性能(第5.3节)。

在每个相应的部分中,都描述了使用的数据集、基线、评估和训练设置。

在附录D和e中报告了所有模型架构和训练超参数。所有结果都是在5个不同的随机种子运行中平均的,除了RL实验,考虑10个运行。

表征的几何对齐 为了评估表征的几何对齐,使用了最近提出的Delaunay成分分析(DCA) (Poklukar et al., 2022)方法,该方法旨在对表征进行一般评估。DCA基于将表示E的评估集与参考集R的几何和拓扑性质进行比较的思想,作为真正的底层流形的近似值。如果集合E的整体和局部结构与R捕获的结构非常相似,即两个集合描述的流形具有相似的连通分量的数量、结构和大小,则认为集合E与R很好地对齐。

DCA用Delaunay邻域图逼近R和E所描述的流形,并得到若干反映它们排列的分数。作者考虑其中的三种:网络质量q∈[0,1],它衡量连接组件中R和E的整体几何排列;以及精度P∈[0,1],召回率R∈[0,1],分别测量E和R中包含在几何上对齐良好的分量中的点的比例。为了解释所有三个归一化分数,我们报告谐波平均值定义为3/(1/P 1/R 1/q),当所有P,R, q > 0,否则为0。在所有实验中,我们使用完整表示z1:M作为参考集R,使用模态特定的zm作为评估集E来计算DCA,两者都是从测试观察中获得的。分数的方法和定义的详细描述见附录A。

5.1. 无监督学习

MHD数据集,由与手写数字相关的图像(x1)、声音(x2)、运动轨迹(x3)和标签信息(x4)组成。作者收集了每类60000张28 × 28的灰度图像,以及标准化的200维轨迹表示和128 × 32维音频表示。数据集分为5万个训练样本和1万个测试样本。

模型,我们考虑了几种基于生成和融合的最先进的多模态表示方法:MVAE、MMVAE、Nexus、MUSE和MFM(详细描述见第4节)。为了公平比较,在可能的情况下,我们在所有基线模型中使用相同的编码器架构和潜在空间维度,如附录d所述。对于GMC,我们使用相同的模态特定基编码器fm(·)作为基线,并使用额外的基编码器f1:4(·)作为输入,将完整的观测值作为输入。共享投影头g(·)由3个全连通层组成。我们设温度τ = 0.1,考虑64维的中间和共享表示空间,即h∈R64, z∈R64。我们使用10−3的学习率训练所有模型100个epoch,使用作者建议的训练方案和超参数(当可用时)。

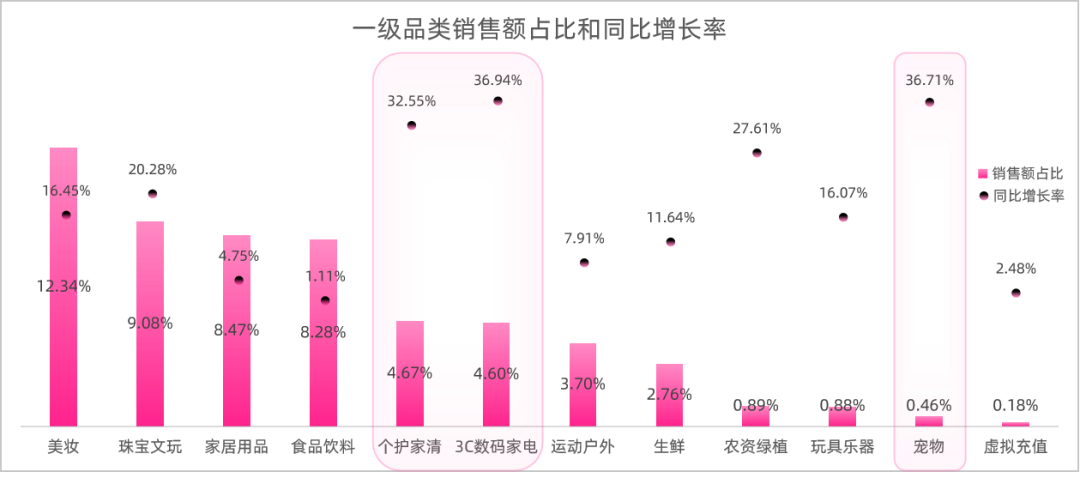

我们遵循文献中已建立的评估,将分类作为下游任务(Shi等人,2019),并在训练分割的完整表示z1:M = g (f1:M(x1:M))上训练一个10类分类器神经网络(具体架构见附录D)。分类器训练了50个epoch,学习率为1e−3。我们报告了当分类器同时提供完整的z1:4和模态特定表示zm作为输入时获得的测试精度。分类结果分类结果如表1所示。虽然所有模型在x1:4和x4上都达到了完美的精度,但我们观察到,GMC是唯一一个在只给出x1、x2或x3作为输入时成功执行任务的模型,显著优于基线。

几何对齐,以验证优越的性能gmc的性能源于表征的更好的几何对齐,我们使用DCA评估了从所有模型获得的测试表征。对于每个模态m,我们比较了评估集E = {zm}和参考集R = {z1:4}的对齐情况。获得的DCA分数显示在表2中,我们看到GMC优于所有考虑的基线。对于某些情况,我们观察到得到的表示完全不对齐,产生P = R = q = 0。虽然一些基线在某种程度上能够将z1和/或z4对齐到z1:4,但GMC是唯一能够对齐声音和轨迹表示z2和z3的方法,从而产生优越的分类性能。我们还通过可视化表示z的二维UMAP投影(McInnes et al., 2018)来验证几何对齐。在图2中,我们显示了使用所考虑的模型获得的z1:4的投影和图像表示z1。我们清楚地看到,GMC不仅正确地对齐了z1:4和z1,而且还将表示分离为10个簇。

此外,我们可以看到,在基线中,只有MMVAE和MUSE在某种程度上与表2中报告的定量结果一致。对于MVAE、Nexus和MFM,图2直观地支持得到的DCA评分0。注意,被DCA标记为异常值的点将从可视化中省略。我们在附录f中提供了其他模态的类似可视化。模型复杂性在表3中,我们给出了本任务中使用的多模态表示模型所需的参数数量。结果表明,GMC所需的参数比最小基线模型少得多,比MMVAE少68%。

5.2. 监督学习

在本节中,我们通过调整模型的架构和训练过程来评估GMC的灵活性,在训练过程中接收额外的监督信号来指导完整表征的学习。我们演示了如何将GMC集成到现有方法中,以最小的计算成本为缺失的模式提供额外的鲁棒性。

数据集,我们采用了CMU-MOSI (Zadeh等人,2016)和CMU-MOSEI (Bagher Zadeh等人,2018)这两个流行的数据集,用于具有挑战性的时间动态的情感分析和情感识别。两个数据集都由从视频中提取的文本(x1)、声音(x2)和视觉(x3)模态组成。CMU-MOSI由2199个短的独白视频片段组成,这些视频片段由主题表达对各种主题的看法。CMU-MOSEI是CMU-MOSI数据集的扩展,其中包含23453个表达电影评论的主题YouTube视频剪辑。在这两个数据集中,每个视频片段都用[−3,3]中的标签进行注释,其中−3和3分别表示强烈的消极和强烈的积极情绪得分。我们使用临时对齐的CMU-MOSEI分别由18134和4643个训练和测试样本组成,CMU-MOSI分别由1513和686个训练和测试样本组成。

模型,我们考虑了多模态变压器(Tsai et al., 2019a),它是CMU-MOSI和CMU-MOSEI数据集上最先进的分类模型(我们参考Tsai et al. (2019a)了解该架构的详细描述)。对于GMC,我们采用与多模态变压器相同的联合模态编码器f1:3(·)架构,但去掉了最后的分类层。对于模态特定的基本编码器{f1(·),f2(·),f3(·)},我们使用一个简单的GRU层,其中包含30个隐藏单元和一个全连接层。共享投影头g(·)由单个全连通层组成。我们设τ = 0.3,考虑60维的中间和共享表示h, z∈R60。

此外,我们在完整表示z1:M上使用了一个由2个线性层组成的简单分类器,在训练期间为模型提供监督信号。我们遵循Tsai等人(2019a)提出的训练方案,以10−3的衰减学习率训练所有模型40个epoch。

评估,我们评估了缺失情态信息的情感分析分类中表征学习模型的性能。我们考虑与Tsai等人(2019b;a)相同的指标,并报告了在测试数据集上获得的预测的二进制精度(Acc),平均绝对误差(MAE),相关性(Cor)和F1分数(F1)。在附录C中,我们在CMU-MOSI数据集上给出了类似的结果。

结果,CMU-MOSEI检测结果见表4。当使用完整的观测值x1:3作为输入时,GMC通过基线模型实现了具有竞争力的性能,这表明额外的对比损失不会降低模型的能力(表4a)。然而,GMC显著提高了模型对缺失模态的鲁棒性,如表4b、4c和4d所示,其中我们仅使用单个模态作为输入。虽然GMC在所有指标上都优于基线,但我们观察到F1分数和二进制精度(Acc)的最大改进,其中基线通常比随机表现更差。与之前一样,我们额外评估了特定模态表征zm(包括集合E)和完整表征z1:3(包括集合R)的几何对齐。表5报告的结果DCA评分支持表4所示的结果,并验证了GMC与基线相比显著改善了几何对齐。此外,GMC的计算成本很小(140万个参数),与基线(110万个参数)相比,只需要300,000个额外的参数。