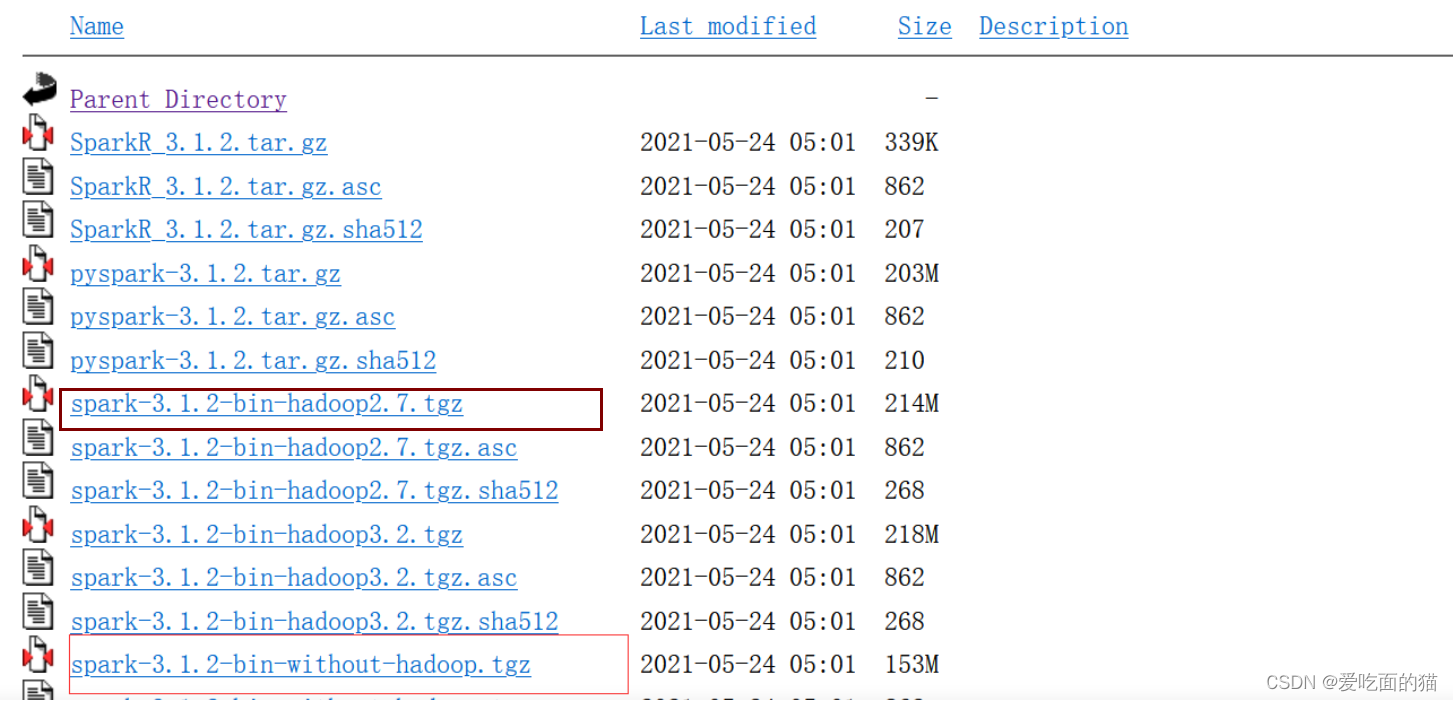

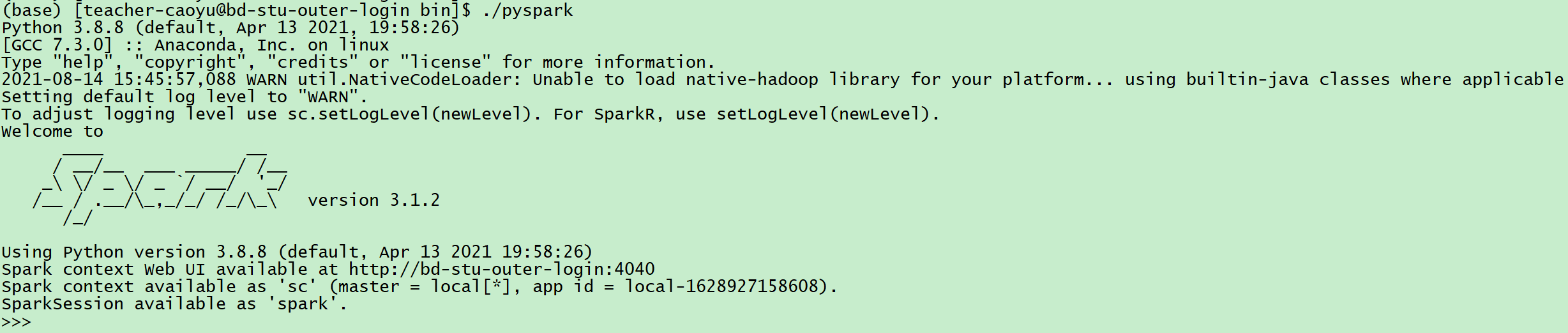

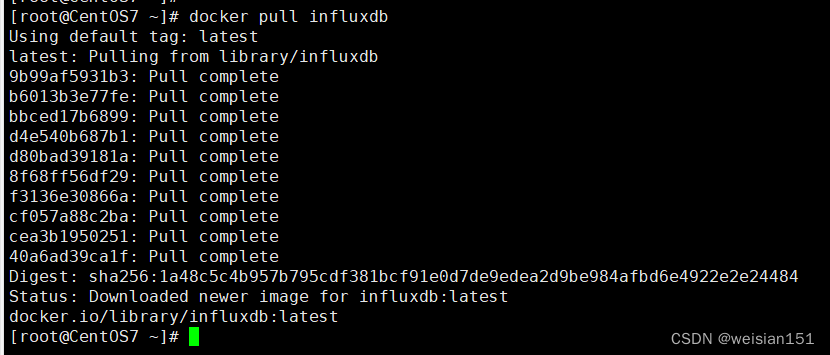

在搭建Spark单机版环境的实战中,首先确保已经安装并配置好了JDK。然后,从群共享下载Spark安装包,并将其上传至目标主机的/opt目录。接着,解压Spark安装包至/usr/local目录,并配置Spark的环境变量,以确保系统能够识别Spark命令。通过编辑/etc/profile文件,并执行source /etc/profile命令,使配置生效。最后,验证安装成功,可执行spark-submit --version命令查看Spark的版本信息。这样,你就成功搭建了Spark单机版环境,为后续的大数据处理和分析工作做好了准备。

搭建Spark单机版环境

2024-03-27 09:08:01 19 阅读