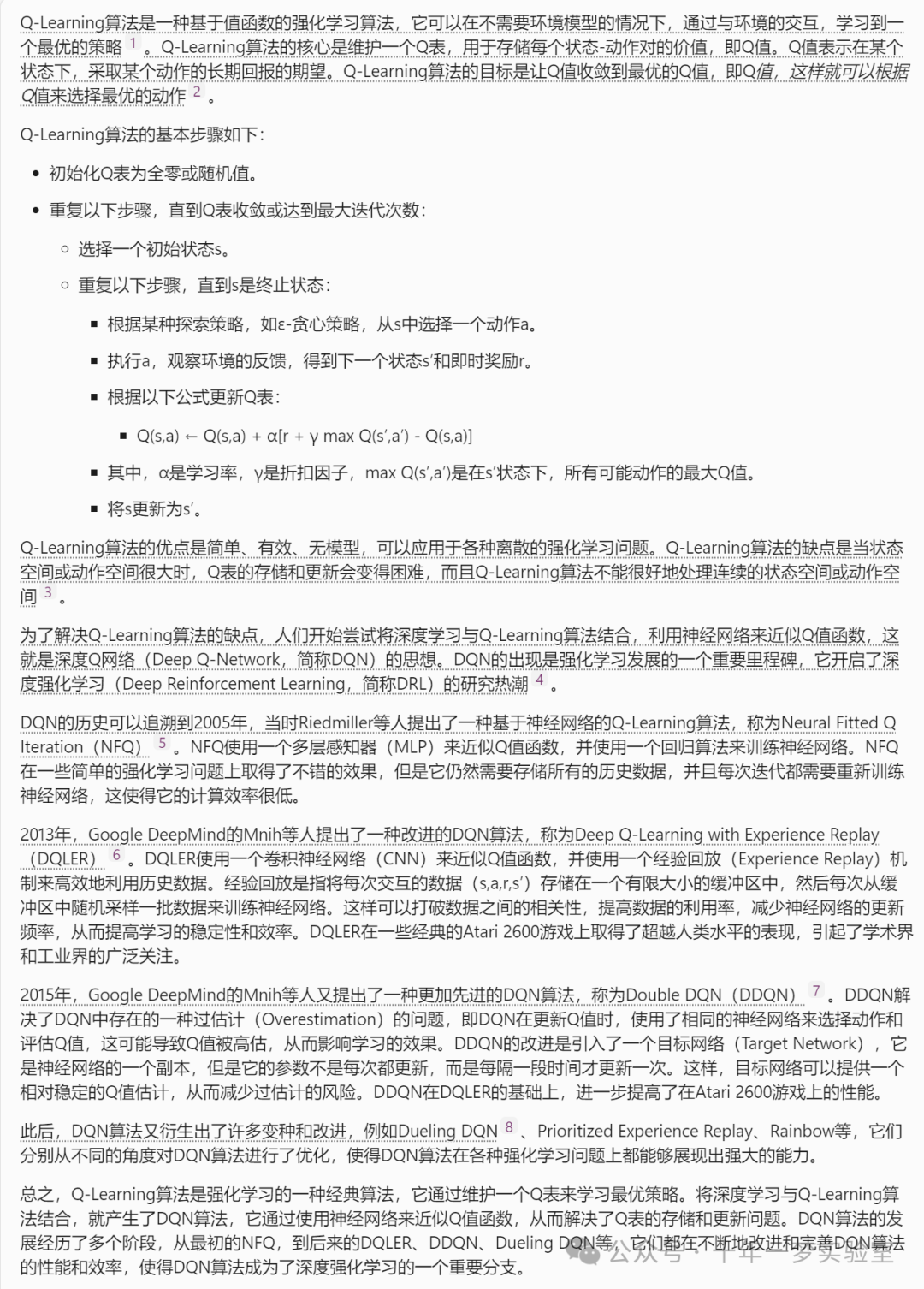

Q-Learning:

一种无模型的强化学习算法,可以在不了解环境动态的情况下学习最优策略。适用于处理有限状态和动作空间的问题。Deep Q-Networks (DQN):

结合深度学习和Q-Learning的算法,使用深度神经网络近似Q函数。适合处理高维状态空间的问题,如复杂网络环境中的安全防御。Policy Gradient Methods:

直接对策略进行参数化,并使用梯度上升法优化策略。适用于动作空间连续或策略需要更复杂表示的情况。Actor-Critic Methods:

结合了值函数近似和策略梯度的方法,使用两个模型:一个是actor,负责生成动作;另一个是critic,负责评估动作。这种方法在稳定性和收敛速度方面表现较好。Deep Deterministic Policy Gradient (DDPG):

一种适用于连续动作空间的算法,结合了DQN和Policy Gradient的优点。在需要精细控制防御策略的网络安全场景中特别有用。Proximal Policy Optimization (PPO):

旨在解决策略梯度方法中的样本效率和训练稳定性问题。PPO通过限制策略更新步骤的大小来保持训练的稳定性,适合于动态变化的网络环境。Trust Region Policy Optimization (TRPO):

同样旨在改善策略梯度方法的稳定性和效率,通过保持旧策略和新策略之间的散度在一个小范围内,以确保策略更新的安全性。Monte Carlo Tree Search (MCTS):

一种用于决策过程中进行大规模搜索的算法,特别适合于具有高度不确定性和复杂策略空间的网络安全场景。Multi-Agent Reinforcement Learning (MARL):

在多个智能体同时操作的环境中学习最优策略。对于模拟多种网络攻击和防御策略的交互特别有用。Federated Learning:

一种分布式机器学习技术,允许模型在保持数据隐私的前提下进行协同训练。这对于跨多个网络节点共享网络安全防御经验特别重要。

这些算法都属于机器学习和强化学习的领域,各自有着独特的应用场景和优缺点。下面是对这些算法的简要比较:

Q-Learning

- 类型:无模型强化学习算法。

- 应用场景:适用于有限状态和动作空间的问题。

- 特点:不需要了解环境动态,通过试错学习最优策略。

- 局限性:难以直接应用于高维状态空间。

Deep Q-Networks (DQN)

- 类型:结合深度学习的Q-Learning算法。

- 应用场景:适合处理高维状态空间的问题。

- 特点:使用深度神经网络近似Q函数,能够处理更复杂的环境。

- 局限性:可能会遇到稳定性和收敛速度的问题。

Policy Gradient Methods

- 类型:基于策略的强化学习算法。

- 应用场景:适用于动作空间连续或策略需要复杂表示的情况。

- 特点:直接对策略进行优化,使用梯度上升法更新策略。

- 局限性:可能会遇到高方差和效率问题。

Actor-Critic Methods

- 类型:结合值函数近似和策略梯度的方法。

- 应用场景:平衡策略优化和值函数估计。

- 特点:使用两个模型(actor和critic),提高了稳定性和收敛速度。

- 局限性:设计复杂,需要调整的参数较多。

Deep Deterministic Policy Gradient (DDPG)

- 类型:适用于连续动作空间的算法。

- 应用场景:需要精细控制的问题,如网络安全防御。

- 特点:结合了DQN和Policy Gradient的优点,适用于连续动作空间。

- 局限性:复杂度高,需要细心调参。

Proximal Policy Optimization (PPO)

- 类型:改进的策略梯度方法。

- 应用场景:动态变化的环境。

- 特点:通过限制策略更新步骤的大小,保持训练稳定性。

- 局限性:算法实现相对复杂。

Trust Region Policy Optimization (TRPO)

- 类型:改进的策略梯度方法。

- 应用场景:需要保证更新安全性的场景。

- 特点:通过维持策略更新的散度在小范围内,提高稳定性。

- 局限性:计算成本较高。

Monte Carlo Tree Search (MCTS)

- 类型:决策过程中的搜索算法。

- 应用场景:高度不确定性和复杂策略空间的问题。

- 特点:适用于具有大规模搜索空间的问题。

- 局限性:计算密集型。

Multi-Agent Reinforcement Learning (MARL)

- 类型:多智能体强化学习。

- 应用场景:模拟多种网络攻击和防御策略的交互。

- 特点:可以在多个智能体同时操作的环境中学习最优策略。

- 局限性:算法设计和训练难度较大,容易出现非稳定性。

Federated Learning

- 类型:分布式机器学习技术。

- 应用场景:需要保护数据隐私的网络安全防御。

- 特点:允许跨多个节点协同训练,而不泄露私有数据。

- 局限性:通信开销大,对数据分布的要求较高。

总体来看,这些算法各有千秋,选择合适的算法需要考虑问题的特性、动作和状态空间的维度、以及是否需要保护数据隐私等因素。

![基于51单片机的微波炉温度控制器设计[proteus仿真]](https://img-blog.csdnimg.cn/direct/cf3b1e51952c4763bf34c569bbcf1417.png)