大数据开发(Hadoop面试真题)

- 1、Map的分片有多大?

- 2、MapReduce的map进程和reducer进程的ivm垃圾回收器怎么选择可以提高吞吐量?

- 3、MapReduce作业执行的过程中,中间的数据会存在什么地方?不会存在内存中吗?

- 4、Mapper端进行combiner之后,除了速度会提升,那从Mapper端到Reduce端的数据量会怎么变?

- 5、MapReduce map输出的数据超出它的文件内存之后,是落地到磁盘还是落地到HDFS中?

- 6、MapReduce Map到Reduce默认的分区机制是什么?

- 7、MapReduce Map Join为什么能解决数据倾斜?、

- 8、MapReduce运行过程中会发生OOM,OOM发生的位置?

- 9、MapReduce用了几次排序,分别是什么?

- 10、MapReduce中怎么处理一个大文件?

1、Map的分片有多大?

Map的分片大小取决于多个因素,包括所用的分布式文件系统、集群的配置和硬件资源。

一般来说,Hadoop的Map的默认分片大小是64MB。这是因为Hadoop将输入数据切分固定大小的块进行处理,每个块作为Map的输入。这个大小可以通过’mapreduce.input.fileinputformat.split.maxsize’属性进行配置。

然而,实际的分片大小可能会受到其它因素的影响。例如,如果输入文件小于64MB,那么分片大小将等于文件大小。另外,Hadoop还会考虑数据块的位置信息,尽量将Map任务分配到离数据块所在位置最近的节点上,以减少数据传输的开销。

总的来说,Map的分片大小是根据多个因素综合考虑的,包括文件大小、集群配置、硬件资源和数据位置等。

2、MapReduce的map进程和reducer进程的ivm垃圾回收器怎么选择可以提高吞吐量?

为了提高MapReduce的吞吐量,我们可以选择适当的垃圾回收器。在选择垃圾回收器时,可以考虑以下几点:

- 吞吐量优先:选择垃圾回收器时,应优先考虑吞吐量,因为MapReduce任务通常是大规模的数据处理任务,需要高效地处理大量的数据。因此,选择具有高吞吐量的垃圾回收器是很重要的。

- 低延迟次要:与吞吐量相比,MapReduce任务通常更注重整体的吞吐量,而不是单个任务的低延迟。因此,在选择垃圾回收器时,可以适当地降低低延迟地需求,以获得更高的吞吐量。

- 并行处理:由于MapReduce任务通常是并行处理的,可以选择支持并行处理的垃圾回收器。这样可以更好地利用多核处理器地性能,提高吞吐量。

- 内存占用:MapReduce任务通常需要处理大量地数据,因此会占用大量的内存。选择垃圾回收器时,应考虑其对内存的使用情况,避免内存占用过高导致性能下降。

3、MapReduce作业执行的过程中,中间的数据会存在什么地方?不会存在内存中吗?

在MapReduce作业执行的过程中,中间的数据会存在本地磁盘上,而不是存储在内存中。这是因为MapReduce框架通常处理大规模的数据集,无法完全存储在内存中。中间数据存储在本地磁盘上可以确保数据的持久化和可靠性,并允许处理大量的数据。当然,一些优化技术也可以用于减少中间数据的存储量,如压缩、合并等。

4、Mapper端进行combiner之后,除了速度会提升,那从Mapper端到Reduce端的数据量会怎么变?

从Mapper端到Reduce端的数据量在应用Combiner之后会减少。Combiner是在Mapper阶段对输出的键值对进行合并和压缩,减少了传输到Reduce阶段的数据量。这是因为Combiner会将相同的键的值进行局部聚合,减少了传输的数据量。因此,使用Combiner可以减少网络传输和磁盘IO的开销,提高整体的性能。

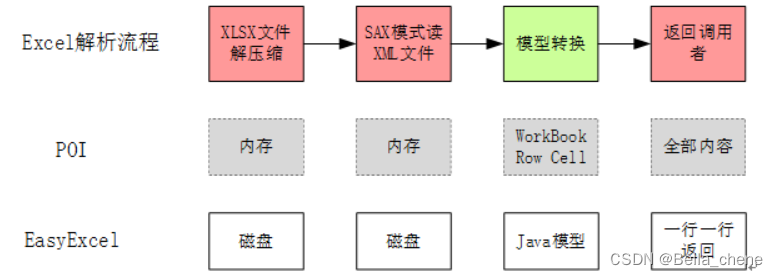

5、MapReduce map输出的数据超出它的文件内存之后,是落地到磁盘还是落地到HDFS中?

MapReduce map输出的数据会先缓存到内存中,当达到一定阈值时,会通过Partitioner将数据分区后写入磁盘。这些分区文件会存储在本地磁盘上。接着,这些分区文件会被复制到HDFS中,以便后续的reduce阶段可以从HDFS中读取并进行处理。所以,MapReduce map输出的数据最终会落地到磁盘和HDFS中。

6、MapReduce Map到Reduce默认的分区机制是什么?

MapReduce中默认的分区机制是根据Key的哈希值进行分区。具体来说,Map阶段输出的每个键值对都会根据键的哈希值被分配到不同的分区中,同一个键的所有值都会被发送到同一个分区中。这样可以保证相同的键值对在Reduce阶段被正确的聚合处理。

7、MapReduce Map Join为什么能解决数据倾斜?、

MapReduce Map Join可以通过将关联字段相同的记录分发到同一个reduce节点上进行聚合,从而解决数据倾斜的问题。具体来说,MapReduce Map Join的解决方法如下:

- 首先,将关联字段相同的记录发送到同一个reduce节点上。这样,相同关联字段的记录将被聚合在一个reduce节点上进行处理,减少了数据倾斜的可能性。

- 其次,对于数据倾斜的情况,MapReduce Map Join还可以采用一种特殊的处理方式,即将数据倾斜的部分记录拆分成多个小文件,然后将这些小文件发送到多个reduce节点上进行处理。这样可以将数据倾斜的压力分散在多个节点上,提高了处理的效率。

总的来说,MapReduce Map Join通过将关联字段相同的记录聚合在同一个reduce节点上,并采用特殊的处理方式来解决数据倾斜的问题,提高了MapReduce程序的执行效率。

8、MapReduce运行过程中会发生OOM,OOM发生的位置?

OOM(Out of Memory)在MapReduce运行过程中可能发生在以下位置:

- Map阶段:当Mapper任务处理输入数据时,如果输入数据量过大或者Mapper函数在处理数据时产生大量的中间键值对,可能会导致内存溢出。

- Reduce阶段:当Reducer任务处理来自Mapper的中间键值对时,如果中间键值对数量过大或者Reducer函数在处理数据时产生大量的输出数据,可能会导致内存溢出。

- Shuffle阶段:在MapReduce的Shuffle过程中,大量的中间数据需要在Map和Reduce之间传输,中间数据量过大,可能会导致内存溢出。

- Combiner阶段:如果在MapReduce作业中使用了Combiner函数进行局部聚合操作,当Combiner处理大量的中间键值对时,也可能会引发内存溢出。

9、MapReduce用了几次排序,分别是什么?

MapReduce在实现过程中使用了两次排序。

第一次排序是在Map阶段,它的目的是将输入数据划分为多个分区,并按照分区和键值进行排序,以便将具有相同键的数据发送到同一个Reducer中进行处理。

第二次排序是在Reduce阶段,它的目的是对来自不同Mapper的输出进行全局排序,以确保最终输出的结果按照键值有序。这个全局排序是在Reducer中进行的。

10、MapReduce中怎么处理一个大文件?

在MapReduce中处理一个大文件的步骤如下:

- 切分:将大文件切分为多个更小的文件块,每个文件块的大小通常由Hadoop配置文件中的参数指定。这样做的目的是为了方便并行处理和分布式计算。

- 映射:通过Map函数将每个文件块映射为键值对。Map函数是自定义的,你可以根据具体需求编写逻辑,将文件块分解为键值对。每个键值对的键是中间结果的键,值是中间结果的值。

- 分区:对映射后的键值对进行分区,根据键的哈希值将键值对分发到不同的Reducer节点。分区操作可以确保具有相同键的键值对被发送到同一个Reducer节点上,以便进行后续处理。

- 排序:在每个Reducer节点上,对分区后的键值对进行排序操作。排序可以帮助提高后续的聚合和处理效率。

- 规约:对排序后的键值对进行规约操作,将具有相同键的值进行合并。这样可以减少数据传输量并提高计算效率。

- 归约:对规约后的键值对进行归约操作,根据具体需求进行数据聚合、计算或其它处理操作。归约操作是自定义的,你可以根据具体需求编写逻辑。

- 输出:将归约后的结果写入Hadoop分布式文件系统(HDFS)或其它存储介质,以便后续分析或使用。