大数据开发(Spark面试真题)

1、Spark的阶段划分?

Spark的阶段划分是指将一个Spark作业划分为多个阶段(Stage)来执行的过程。每个阶段包含一组相互依赖的任务,并且每个任务可以并行执行。Spark的阶段划分是为了提高作业的执行效率和并行度。

Spark的阶段划分分为两个阶段:转换阶段(Transformation Stage)和动作阶段(Action Stage)。

- 转换阶段:在转换阶段中,Spark会将作业中的转换操作(如map、fliter、reduce等)划分为多个任务,并将这些任务组织成一个阶段。每个任务会以一种无依赖的方式执行,并生成RDD(弹性分布式数据集)作为输出。转换阶段的任务之间可以并行执行,但不同阶段的任务之间存在依赖关系。

- 动作阶段:在动作阶段中,Spark会将作业中的动作操作(如count、collect、save等)划分为多个任务,并将这些任务组织成一个阶段。每个任务会以一种有依赖的方式执行,依赖于前面阶段的输出RDD。动作阶段的任务之间可以并行执行,但不同阶段的任务之间存在依赖关系。

通过将作业划分为多个阶段,Spark可以有效地利用集群资源并实现作业地并行执行。同时,阶段划分还可以帮助Spark进行任务调度和数据分区,提高整体地执行效率。

2、Sparkjoin的分类?

Sparkjoin可以根据不同的分类标准进行分类。一种常见的分类是根据Join操作的执行方式进行分类,可以分为Shuffle Join和Broadcast Join。

- Shuffle Join:在Shuffle Join中,Spark会将参与Join操作的数据集按照Join的条件进行分区,并将具有相同Join键的数据分发到同一个节点上进行Join操作。这种方式适用于数据集比较大的情况,但需要进行数据的洗牌操作,因此会带来网络传输和性能开销。

- Broadcast Join:在Broadcast Join中,Spark会将一个小数据集复制到每个节点的内存中,然后将参与Join操作的大数据集分发到各个节点上进行Join操作。这种方式适用于一个数据集比较小而另一个数据集比较大的情况,可以避免数据的洗牌操作,提高性能。

此外,还可以根据Join操作的实现方式进行分类,如Sort-Merge Join、Hash Join等。Sort-Merge Join是通过对参与Join操作的数据集进行排序,然后按照Join的条件进行合并操作。Hash Join则是通过构建哈希表,将参与Join操作的数据集按照Join的条件进行哈希,并将具有相同哈希值的数据进行Join操作。

3、Spark map join的实现原理?

Spark的map join是一种用于处理大规模数据的优化技术,它通过在内存中将两个数据集进行联接,从而避免了磁盘IO的开销。下面是Spark map join的实现原理:

- 数据划分:首先,Spark将两个数据集划分为多个分区,每个分区的数据流尽可能均匀。这样可以并行处理每个分区,提高处理效率。

- 数据广播:接下来,Spark将其中一个数据集(通常较小的那个)广播到每个节点的内存中。这样可以保证每个节点都可以访问到该数据集,并避免了多次网络传输的开销。

- 分区处理:每个节点接收到广播的数据后,将其与本地的另一个数据集进行联接操作。这里的联接操作通常是通过键值对进行的,即根据两个数据集的共同键将它们进行匹配。

- 结果汇总:最后,每个节点将自己的结果发送给驱动程序节点,由驱动程序节点进行最终的结果汇总。

需要注意的是,Spark的map join适用于两个数据集中至少一个可以完全放入内存的情况。如果两个数据集都无法完全放入内存,那么Spark将会使用其它的联接策略,如Sort Merge Join或Broadcast Join等。

4、介绍下Spark Shuffle及其优缺点?

Spark Shuffle是Apache Spark中的一个关键概念,用于在数据分区的过程中重新分配和重组数据。当Spark执行对数据进行重新分区或聚合操作时,它需要将数据重新发送到不同的节点上,以便进行下一步的计算。这个过程就是Shuffle。

优点:

- 数据本地性:Spark Shuffle可以在节点之间移动数据,以便在计算过程中最大限度地利用数据本地性。这减少了数据传输地开销,提高了计算的性能。

- 分布式计算:Shuffle运行Spark在多个节点上进行执行计算操作,从而实现了分布式计算的能力。这使得Spark能够处理大规模的数据集,并在短时间内完成计算任务。

- 灵活性:Spark Shuffle提供了多种不同的Shuffle实现方式,如Sort Shuffle、Hash Shuffle和Tungsten Shuffle等,可以根据数据和计算需求选择最合适Shuffle策略。

缺点:

- 数据传输开销:Shuffle涉及将数据从一个节点传输到另一个节点,这会产生网络传输的开销。当数据量巨大时,这个开销可能会成为性能的瓶颈。

- 磁盘IO:Shuffle操作可能需要将数据持久化到磁盘上,以便在不同阶段的计算中使用。这可能导致磁盘IO成为性能瓶颈,并增加延迟。

- 内存消耗:Shuffle操作需要在内存中存储大量的数据,并进行排序、合并等操作。如果内存不足,可能会导致内存溢出或性能下降。

5、什么情况下产生Spark Shuffle?

- 数据重分区:当需要将数据重新分区以进行后续的数据处理操作时,Spark Shuffle就会产生。这可能会因为数据需要重新分发到不同的Executor上,以便进行并行处理。

- 聚合操作:当需要对数据进行聚合操作时,Spark Shuffle就会发送。例如,当使用groupByKey、reduceByKey、aggregateByKey等操作时,需要将具有相同键的数据重新分发到同一个Executor进行聚合。

- 排序操作:当需要对数据进行排序时,Spark Shuffle也会发送。例如,当使用sortByKey、sort、distinct等操作时,需要将数据重新分发到不同的Executor上进行排序。

6、Spark为什么适合迭代处理?

- 内存计算:Spark使用内存计算,将数据存储在内存中而不是磁盘上。这大大提高了数据处理的速度。对于迭代处理来说,可以将中间结果保留在内存中,避免了磁盘读写的开销,从而加快了迭代速度。

- 可以保留中间结果:Spark的弹性分布式数据集(RDD)可以在内存中保留中间结果。对于迭代处理来说,每次迭代都可以重用中间结果,而不是重新计算。这进一步加速了迭代处理的速度。

- 基于DAG执行引擎:Spark使用DAG(有向无环图)执行引擎,可以将迭代处理转化为一系列的有向无环图操作。这种方式可以优化任务的执行顺序,减少数据的传输和计算开销,提高了迭代处理的效率。

- 支持多种语言:Spark支持多种编程语言,包括Scala、Java、Python和R等。这使得开发者可以使用自己熟悉的编程语言进行迭代处理的开发,提高了开发效率。

7、Spark数据倾斜问题,如何定位,解决方案?

Spark数据倾斜问题是大数据处理中常见的挑战之一。下面是解决该问题的一般步骤和解决方案:

- 定位数据倾斜:首先,通过监控Spark作业运行过程中的日志信息,查看各个阶段的任务执行情况。如果发现某个阶段的任务执行时间远远超过其它任务,很可能存在数据倾斜的问题。

- 分析数据倾斜原因:确定数据倾斜的原因是解决问题的第一步。常见的数据倾斜原因包括数据分布不均匀、数据键值冲突等。

- 解决方法

- 增加分区:如果数据分布不均匀,可以尝试增加分区数,使数据能够更均匀地分配到不同地分区中。

- 重新分桶/哈希:对于键值冲突的情况,可以尝试重新分桶或者通过哈希函数重新计算键值,使数据能够更均匀地分布到不同的分区中。

- 增加缓存:对于某些热点数据,可以将其缓存到内存中,减少重复计算。

- 采用随机前缀/后缀:对于键值冲突较多的情况,可以通过在键值的前缀或者后缀添加随机值,使冲突几率降低。

- 倾斜数据单独处理:将倾斜数据单独处理,可以将其分成多个小任务,并行处理,降低整体任务的执行时间。

- 测试和优化:实施解决方案后,需要对作业进行测试和优化,确保数据倾斜问题得到解决,并且整体性能得到提升。

8、Spark的stage如何划分?在源码中是怎么判断属于Shuffle Map Stage或Result Stage的?

在Spark中,Stage是任务调度和执行的基本单位,它将一个作业划分为多个阶段。Spark中的Stage划分分为Shuffle Map Stage和Result Stage两种类型。

- Shuffle Map Stage(Shuffle阶段):

- Shuffle Map Stage是指需要进行数据重分区的阶段,通常在该阶段需要将数据按照key进行重新分区,以便进行后续的聚合操作或者连接操作。

- 在源码中,Spark通过检查每个RDD的依赖关系来判断是否属于Shuffle Map Stage。如果一个RDD的依赖关系包含宽依赖(即父RDD与子RDD之间存在Shuffle操作),则该RDD属于Shuffle Map Stage。

- Result Stage(结果阶段):

- Result Stage是指不需要进行数据重分区的阶段,通常包含计算结果的最终输出。

- 在源码中,Spark通过检查每个RDD的依赖关系来判断是否属于Result Stage。如果一个RDD的依赖关系不包含宽依赖(即父RDD与子RDD之间不存在Shuffle操作),则该RDD属于Result Stage。

Shuffle Map Stage的输出会作为Result Stage的输入。

9、Spark join在什么情况下会变成窄依赖?

- 当两个RDD进行join时,它们的分区方式相同,即它们的分区数量一样,并且每个分区中的数据量也相当,这样就可以将每个分区的数据进行一对一的匹配,形成窄依赖。

- 当进行shuffle操作的key值较少时,可以通过增大分区数来减少每个分区的数据量,使得每个分区的数据量相对较小,从而形成窄依赖。

- 当两个RDD的数据分布相对均匀,没有明显的数据倾斜或不均匀情况时,join操作可以更加高效地形成窄依赖。

在这些情况下,Spark可以高效地进行join操作,避免数据的重新分区和大量的数据传输,提高了计算效率。

10、Spark的内存模型?

Spark的内存模型是基于分布式内存计算的,主要包括两个组件:Driver和Executor。

Driver是Spark应用程序的主控节点,负责将应用程序转化为任务并将其分配给Executor执行。Driver节点包含了应用程序的整个代码以及数据集的元数据,也会保存一部分数据在内存中。

Executor是Spark应用程序的工作节点,负责执行任务并保存数据。每个Executor运行在一个独立的JVM进程中,它们通过网络与Driver进行通信。Executor会将数据存在在内存中的数据结构中,这些数据结构可以是RDD(弹性分布式数据集)或DataFrame等。

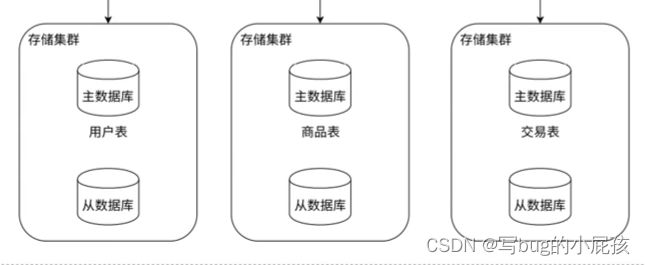

Spark的内存模型中,整个集群的内存被划分为两部分:存储内存和执行内存。存储内存用于存储数据以提高数据访问的速度,执行内存用于存储正在执行的任务的数据。

在Spark的内存模型中,数据会首先被加载到存储内存中,如果存储内存不足,则会选择将一部分数据溢出到磁盘上。而执行内存则用于执行计算任务,包括转化、过滤、聚合等操作。

Spark的内存模型的优势在于可以将数据缓存在内存中,从而加快数据的访问速度,提高计算性能。同时,Spark的内存模型也支持弹性扩展,可以根据需要动态调整内存的使用,以适应不同的工作负载。