1,视频地址

2,关于llama.cpp 项目

https://github.com/ggerganov/llama.cpp

LaMA.cpp 项目是开发者 Georgi Gerganov 基于 Meta 释出的 LLaMA 模型(简易 Python 代码示例)手撸的纯 C/C++ 版本,用于模型推理。所谓推理,即是给输入-跑模型-得输出的模型运行过程。

那么,纯 C/C++ 版本有何优势呢?

无需任何额外依赖,相比 Python 代码对 PyTorch 等库的要求,C/C++ 直接编译出可执行文件,跳过不同硬件的繁杂准备;

支持 Apple Silicon 芯片的 ARM NEON 加速,x86 平台则以 AVX2 替代;

具有 F16 和 F32 的混合精度;

支持 4-bit 量化;

golang 的项目地址:

https://github.com/go-skynet/go-llama.cpp

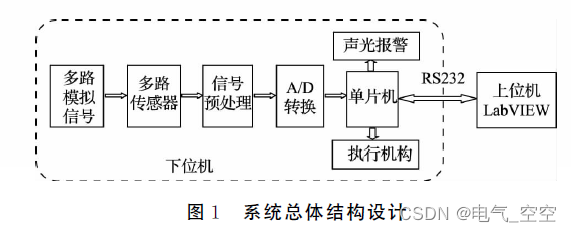

3,准备工作,解决cgo编译问题

关于go-llama.cpp 项目地址:

https://github.com/go-skynet/go-llama.cpp

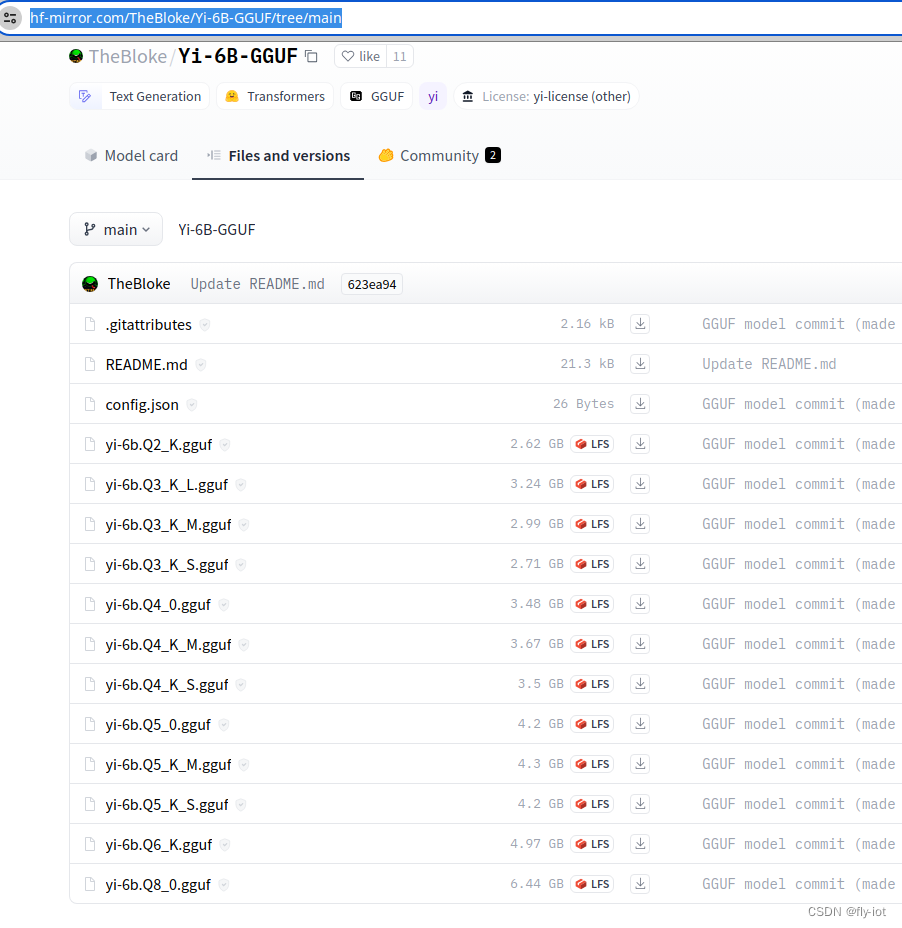

首先下载模型:

https://hf-mirror.com/TheBloke/Yi-6B-GGUF/tree/main

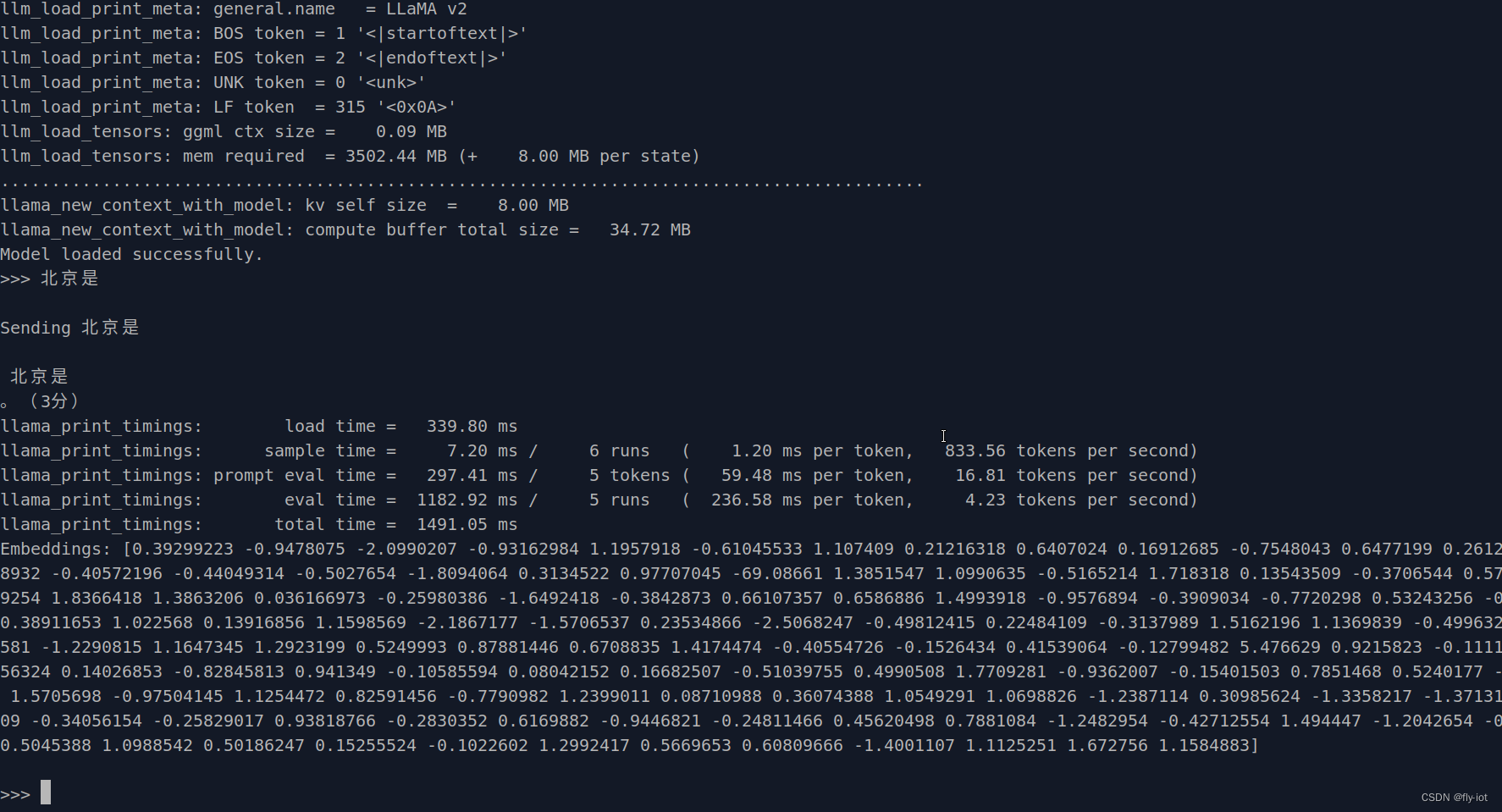

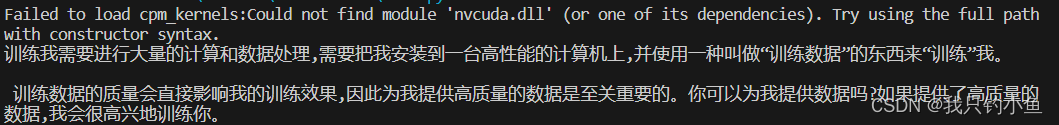

然后运行测试:

虽然模型回答的不太对,但是可以运行了,速度确实还可以。

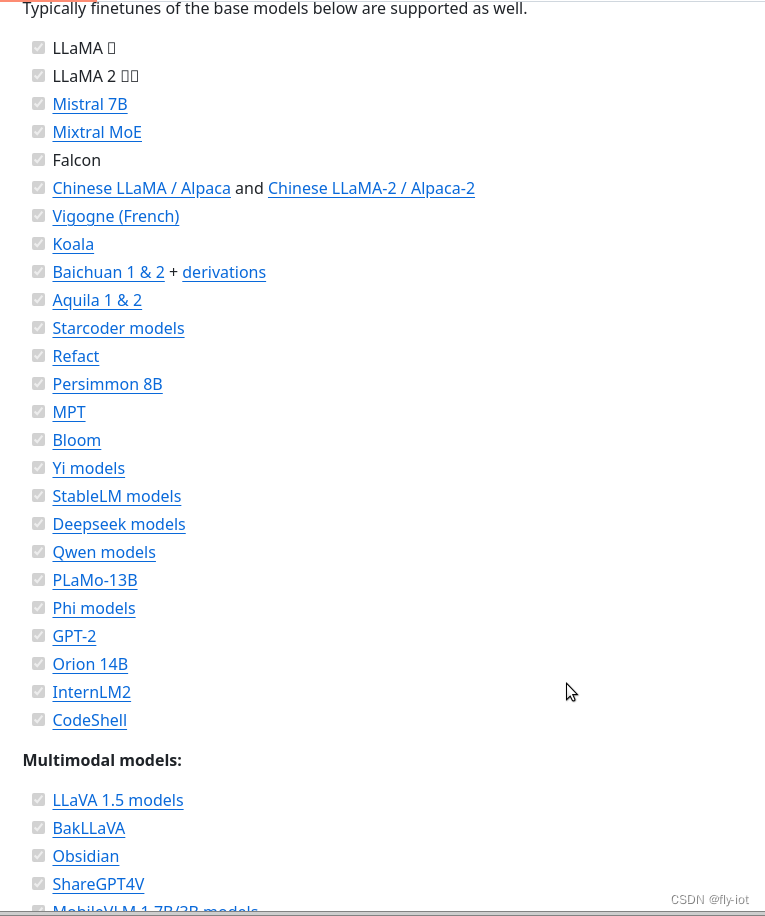

4,只要是llama.cpp支持的模型就可以

已经支持很多模型了,都需要测试下效果。

![[<span style='color:red;'>大</span><span style='color:red;'>模型</span>]<span style='color:red;'>Yi</span>-<span style='color:red;'>6</span><span style='color:red;'>B</span>-chat WebDemo 部署](https://img-blog.csdnimg.cn/direct/33c14ae8fe334001b94a5f7a84f26e3c.png#pic_center)