本文详细介绍清华开源项目 ChatGLM 本地部署的详细教程。清华开源项目 ChatGLM-6B 已发布开源版本,这一项目可以直接部署在本地计算机上做测试,无需联网即可体验与 AI 聊天的乐趣。

目录

一、ChatGLM-6B介绍

本文详细介绍清华开源项目 ChatGLM 本地部署的详细教程。清华开源项目 ChatGLM-6B 已发布开源版本,这一项目可以直接部署在本地计算机上做测试,无需联网即可体验与 AI 聊天的乐趣。

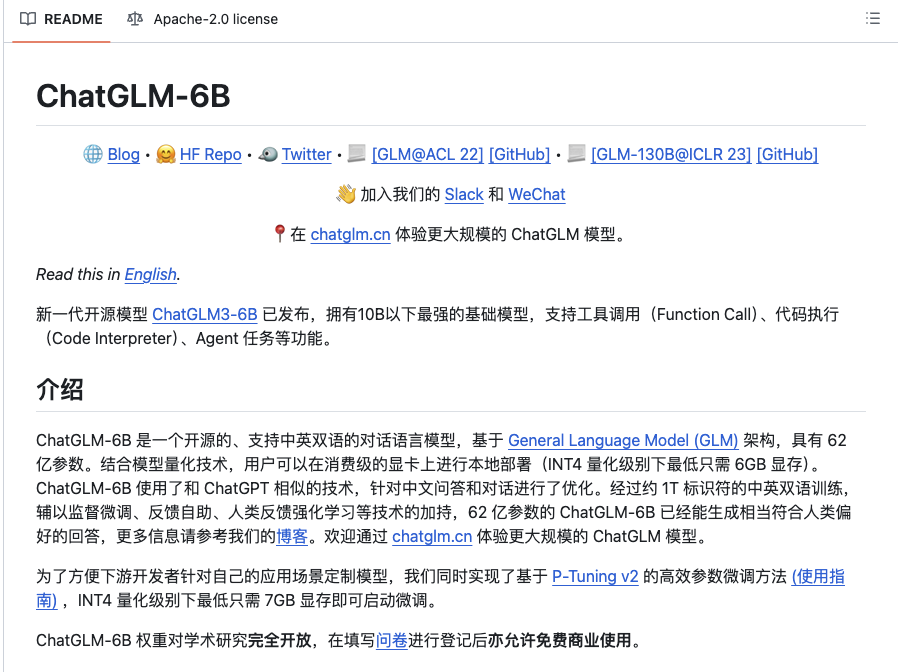

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。 ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答,更多信息请参考我们的博客。欢迎通过 chatglm.cn 体验更大规模的 ChatGLM 模型。

为了方便下游开发者针对自己的应用场景定制模型,我们同时实现了基于 P-Tuning v2 的高效参数微调方法 (使用指南) ,INT4 量化级别下最低只需 7GB 显存即可启动微调。(ChatGLM-6B-INT4 是轻量化的版本)

ChatGLM-6B 权重对学术研究完全开放,在填写问卷进行登记后亦允许免费商业使用。

二、环境配置

1.首先需要下载Anaconda和PyCharm。

Anaconda官网:https://www.anaconda.com/download/

PyCharm官网:https://www.jetbrains.com/zh-cn/pycharm/

PyCharm建议下载专业版的,上网找个激活码就ok。

安装过程很简单,网上教程一大堆,随便找个一步步来就可以。就不再赘述。

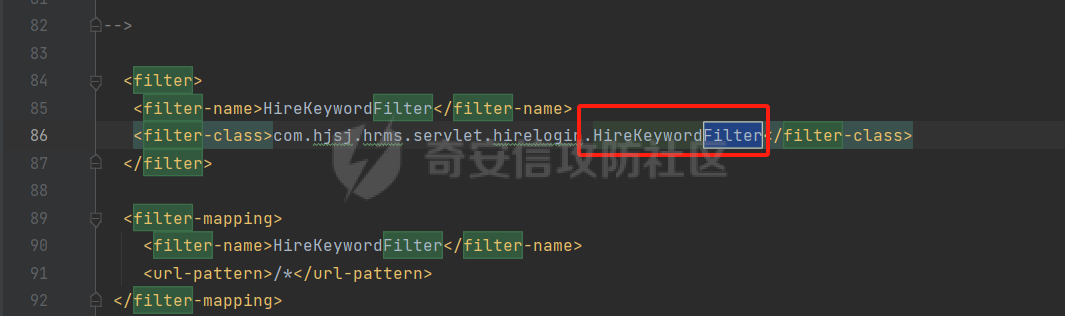

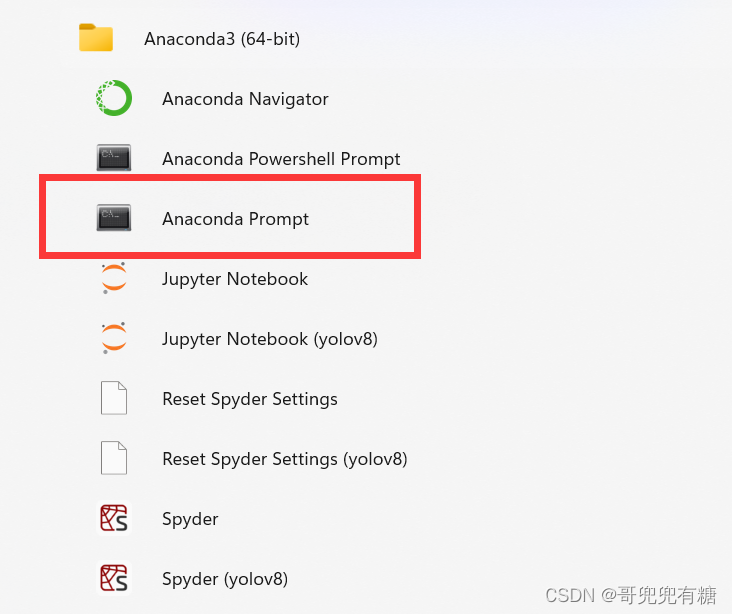

2.安装好Anaconda之后,在开始菜单栏会有文件夹,打开Anaconda Prompt(记住不能错,必须是Anaconda Prompt)

新建虚拟环境,代码如下:

conda create -n llm python3.10 -y

#创建名字为llm的环境,python版本为3.10

conda activate llm

#激活环境llm如图所示:

看到下面这个这个状态就是创建成功了。

3.下载模型包 chatglm

下载地址:https://huggingface.co/THUDM/chatglm-6b/tree/main

普通配置的电脑建议下载Int4的轻量化版本,不然显卡带不动,该版本效果比原版本差一些。

下载完成之后,用pycharm打开,打开设置,配置刚才创建的环境llm,如图所示:

完成之后,安装需要的包:

pip install -r requirements.txt

pip install gradio在pycharm的终端里面,激活环境llm,pip一键下载即可。

(注意不要点错了,不是console,是prompt)

如果在pycharm里面pip下载报错,直接打开Anaconda Prompt,激活llm环境,手动pip install 下载需求文件里面的库即可。

三、运行测试

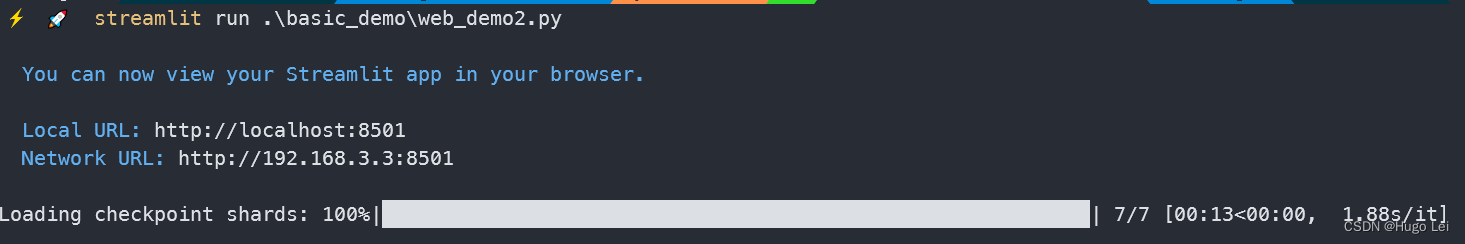

在代码里面,cli_demo.py是命令行对话的示例,web_demo.py是网页版的示例,直接点击运行这个。

程序会运行一个 Web Server,并输出地址。在浏览器中打开输出的地址即可使用。最新版 Demo 实现了打字机效果,速度体验大大提升。注意,由于国内 Gradio 的网络访问较为缓慢,启用 demo.queue().launch(share=True, inbrowser=True) 时所有网络会经过 Gradio 服务器转发,导致打字机体验大幅下降,现在默认启动方式已经改为 share=False,如有需要公网访问的需求,可以重新修改为 share=True 启动。

四、局限性

由于 ChatGLM-6B 的小规模,其能力仍然有许多局限性。以下是我们目前发现的一些问题:

模型容量较小:6B 的小容量,决定了其相对较弱的模型记忆和语言能力。在面对许多事实性知识任务时,ChatGLM-6B 可能会生成不正确的信息;它也不擅长逻辑类问题(如数学、编程)的解答。

产生有害说明或有偏见的内容:ChatGLM-6B 只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容。(内容可能具有冒犯性,此处不展示)

英文能力不足:ChatGLM-6B 训练时使用的指示/回答大部分都是中文的,仅有极小一部分英文内容。因此,如果输入英文指示,回复的质量远不如中文,甚至与中文指示下的内容矛盾,并且出现中英夹杂的情况。

易被误导,对话能力较弱:ChatGLM-6B 对话能力还比较弱,而且 “自我认知” 存在问题,并很容易被误导并产生错误的言论。例如当前版本的模型在被误导的情况下,会在自我认知上发生偏差。