目录

6.2 AdaBoost vs. Gradient Boosting

1. 引言

机器学习领域中有许多著名的算法,其中AdaBoost(Adaptive Boosting)因其在提高模型性能方面的显著优势而备受关注。作为一种集成学习算法,AdaBoost通过组合多个弱学习器来构建一个强学习器,从而提高模型的准确性和泛化能力。本文将深入介绍AdaBoost算法的原理、工作流程、优缺点以及在实际应用中的表现。

2. AdaBoost的基本概念

2.1 弱学习器

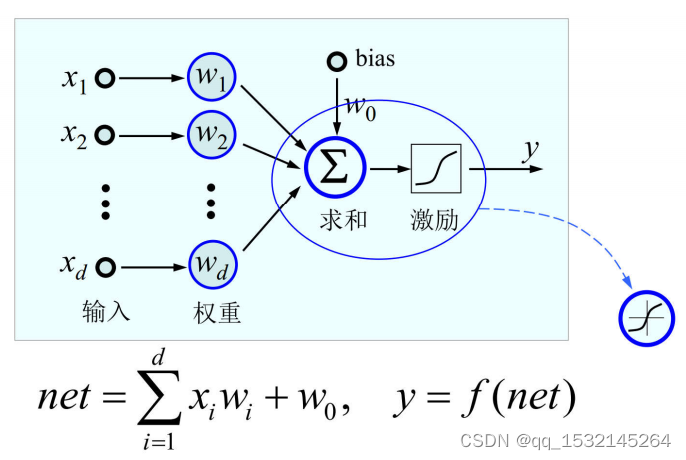

在了解AdaBoost之前,我们首先需要理解什么是弱学习器。弱学习器是指在某个学习任务上略优于随机猜测的模型,它的准确性略高于50%。通常,弱学习器的性能不足以独立解决整个学习问题,但通过组合多个弱学习器,我们可以得到一个强大的模型。

2.2 错误率与权重更新

AdaBoost的核心思想之一是对训练样本的错误进行关注。算法会为每个样本分配一个权重,其中,被错误分类的样本将获得更高的权重,以便在后续训练中更加关注这些困难的样本。这种策略使得算法能够重点关注对模型性能提升有帮助的样本。

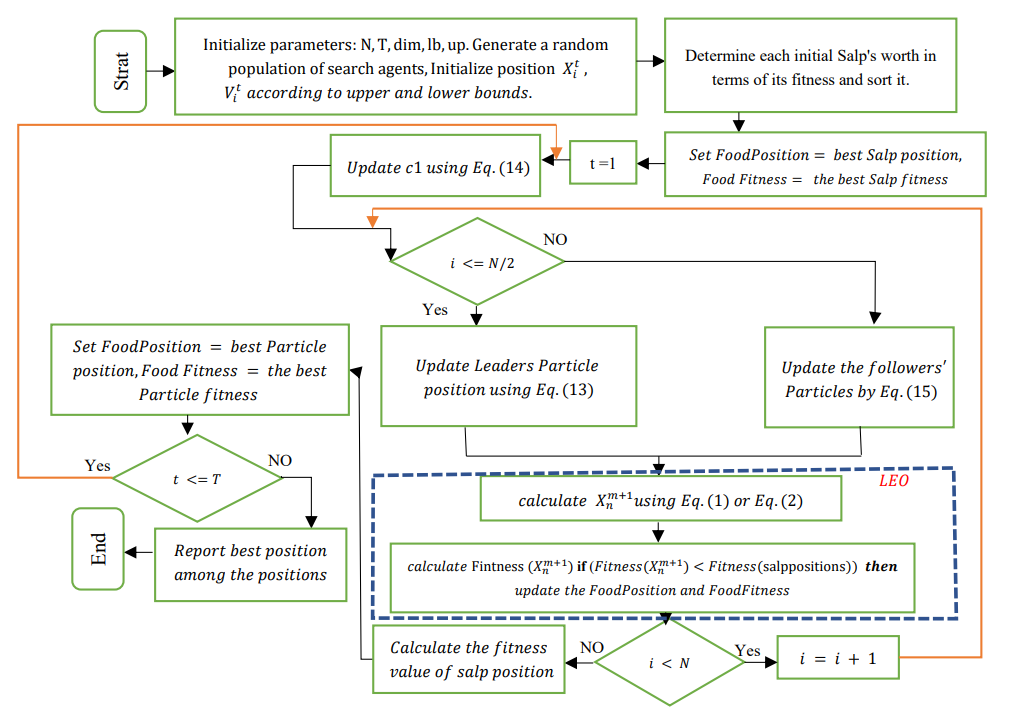

3. AdaBoost的工作流程

AdaBoost的工作流程分为四个主要步骤:初始化权重、训练弱学习器、更新样本权重和构建强学习器。下面将详细介绍每个步骤的过程。

3.1 初始化权重

AdaBoost开始时,为训练数据集中的每个样本分配相等的权重。假设有N个样本,每个样本的初始权重为1/N。这意味着每个样本对模型的训练起到相同的作用。

初始化权重的目的是确保每个样本在初始阶段都受到足够的关注,以便在后续的训练中能够适应模型。

3.2 训练弱学习器

在AdaBoost的每一轮迭代中,一个新的弱学习器被训练。训练过程主要关注在前一轮中被错误分类的样本,以便修正模型的缺陷。

训练弱学习器的步骤如下:

1. **选择弱学习器类型:** 弱学习器可以是任何表现略优于随机猜测的模型,通常是决策树桩(仅有一个分裂节点的决策树)。

2. **使用加权数据集训练弱学习器:** 根据样本的权重,调整训练数据集,使得在新的数据集上训练的弱学习器更加关注前一轮中被错误分类的样本。

3. **计算弱学习器的权重:** 弱学习器的权重与其在训练中的性能有关,性能更好的学习器获得更大的权重。权重的计算通常基于学习器在训练集上的错误率。

3.3 更新样本权重

在训练完弱学习器后,根据它们的性能更新每个样本的权重。被正确分类的样本权重减小,而被错误分类的样本权重增加。这样,下一轮训练中,模型将更关注先前被错误分类的样本,从而逐步改进模型性能。

更新样本权重的公式如下:

其中:

- 是第t轮中样本i的权重。

- 是弱学习器的权重。

- 是样本i的真实标签。

-是弱学习器在样本i上的预测。

3.4 构建强学习器

通过迭代训练多个弱学习器并更新样本权重,AdaBoost会得到一系列弱学习器和它们的权重。最终,这些弱学习器会组合成一个强大的模型,其预测结果是所有弱学习器加权求和的结果。强学习器的预测公式如下:

其中:

- 是强学习器的预测结果。

- 是弱学习器的数量。

- 是第t个弱学习器的权重。

- 是第t个弱学习器的预测结果。

通过这种方式,AdaBoost通过组合多个弱学习器来构建一个在分类任务中表现优秀的强学习器。

4. AdaBoost的优缺点

4.1 优点

- 提高模型准确性:AdaBoost通过组合多个弱学习器显著提高了模型的准确性。

- 对异常值鲁棒:由于关注错误分类的样本,AdaBoost对异常值的影响相对较小。

- 不易过拟合:通过适当调整学习率和迭代次数,AdaBoost在一定程度上避免了过拟合问题。

4.2 缺点

- 对噪声敏感:AdaBoost对噪声和异常值敏感,可能导致过分关注这些异常样本。

- 训练时间较长:由于迭代训练的过程,AdaBoost的训练时间较长,特别是在大型数据集上。

5. 应用场景

AdaBoost算法在各个领域都取得了显著的成功,其优势主要体现在处理复杂分类问题和提高模型性能方面。以下是一些AdaBoost算法在不同领域的典型应用场景:

5.1 图像识别

在计算机视觉领域,AdaBoost广泛应用于图像识别任务。通过结合多个弱分类器,AdaBoost能够有效地提高人脸检测、目标识别等任务的准确性。在人脸检测中,AdaBoost能够学习并组合多个简单的特征分类器,从而成功地识别出复杂的人脸模式。

5.2 语音处理

在语音处理领域,AdaBoost被用于语音信号的分类和识别。通过训练多个弱学习器来捕捉语音中的不同特征,AdaBoost可以构建出一个强大的模型,用于语音识别、说话人识别等应用。其在提高语音处理系统性能方面具有显著的优势。

5.3 生物信息学

在生物信息学中,AdaBoost被广泛应用于基因表达数据的分类和预测。通过学习基因表达数据中的模式,AdaBoost可以帮助科学家识别关键的基因或预测某些疾病的发生。其在生物信息学中的成功应用有助于推动医学研究和生物医学领域的发展。

5.4 金融欺诈检测

在金融领域,AdaBoost被广泛用于欺诈检测。通过分析大量的交易数据和客户信息,AdaBoost可以识别异常模式和行为,从而及时发现潜在的欺诈行为。其高度的敏感性和准确性使其成为金融机构在面对大规模交易数据时的重要工具。

5.5 医学图像分析

在医学领域,AdaBoost被应用于医学图像分析,如肿瘤检测和分割。通过训练多个弱学习器,AdaBoost可以在医学图像中识别和标记潜在的异常区域,有助于医生更准确地进行诊断和治疗规划。

5.6 其他领域

除了以上提到的领域,AdaBoost还在自然语言处理、推荐系统、工业质检等众多应用中取得了良好的效果。其灵活性和强大的性能使得AdaBoost成为解决复杂分类问题的重要工具,为各行各业的应用提供了有力支持。

6. AdaBoost与其他算法的比较

AdaBoost是一种集成学习算法,它通过组合多个弱学习器来构建一个强学习器。在这一节中,我们将AdaBoost与其他两种常见的集成学习算法进行比较:Bagging(Bootstrap Aggregating)和Gradient Boosting。这两种算法与AdaBoost有相似之处,但在一些关键方面有着显著的不同。

6.1 AdaBoost vs. Bagging

6.1.1 相同点

- **集成思想:** AdaBoost和Bagging都是集成学习方法,通过组合多个弱学习器来提高整体模型的性能。

- **样本采样:** 两者都使用了样本的随机采样。Bagging使用自助采样(Bootstrap Sampling),允许同一个样本在多个子集中出现。AdaBoost则根据样本的权重进行采样,更关注被错误分类的样本。

6.1.2 不同点

- **样本权重调整:** AdaBoost通过调整样本的权重来关注错误分类的样本,使得每一轮训练更关注先前错误的样本。而Bagging对所有样本一视同仁,不区分错误和正确分类的样本。

- **学习器权重:** 在AdaBoost中,每个弱学习器都有一个权重,根据其性能调整样本权重。而在Bagging中,所有弱学习器的权重相等,最终结果是所有学习器的简单平均。

- **偏向于不同样本:** 由于AdaBoost关注错误分类的样本,它更容易受到噪声和异常值的影响。相反,Bagging对所有样本平等对待,相对于AdaBoost更鲁棒。

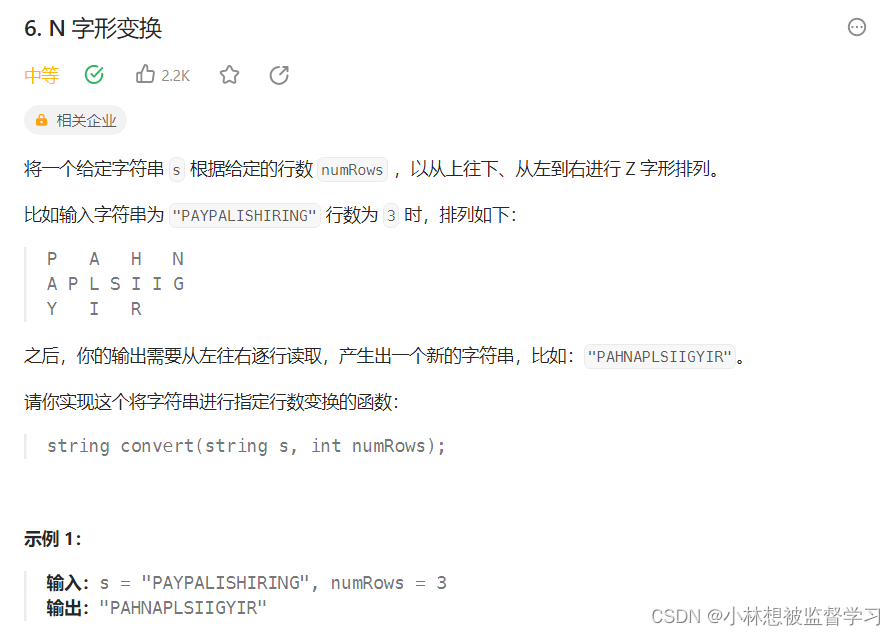

6.2 AdaBoost vs. Gradient Boosting

6.2.1 相同点

- **集成思想:** AdaBoost和Gradient Boosting都是集成学习方法,通过组合多个弱学习器来提高整体模型的性能。

- **迭代训练:** 两者都采用迭代的方式训练多个弱学习器,每一轮迭代都试图纠正上一轮的模型误差。

6.2.2 不同点

- **权重调整方式:** AdaBoost通过调整样本权重来关注错误分类的样本,从而提高模型性能。而Gradient Boosting通过拟合残差(实际值与预测值之差)来修正模型,使得每一轮的学习器关注于上一轮模型未能正确预测的样本。

- **弱学习器关注点:** AdaBoost每一轮关注的是先前被错误分类的样本,以提高对这些样本的学习能力。而Gradient Boosting每一轮关注的是模型的残差,以不断减小模型的预测误差。

- **模型结构:** AdaBoost通常使用简单的弱分类器,如决策树桩。而Gradient Boosting通常使用决策树作为弱学习器,每一棵树都在之前树的基础上进行修正,形成一个累积模型。

通过比较上述两个算法,我们可以看到它们在样本权重调整和学习器关注点上有着显著的不同,导致了它们在应对问题和数据集特性上的适用性有所差异。选择合适的算法取决于具体的问题和数据背景。

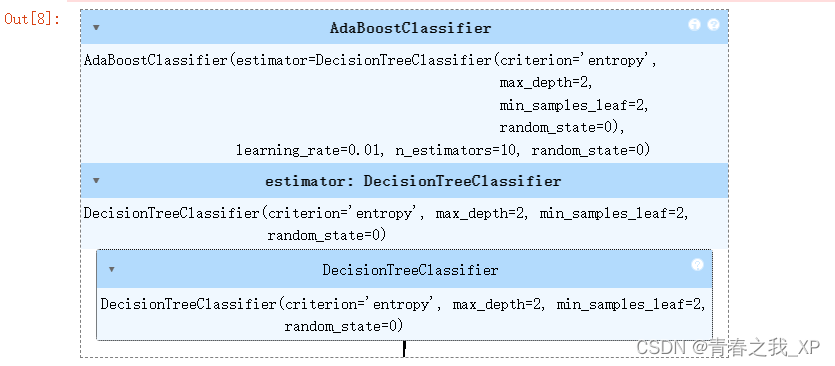

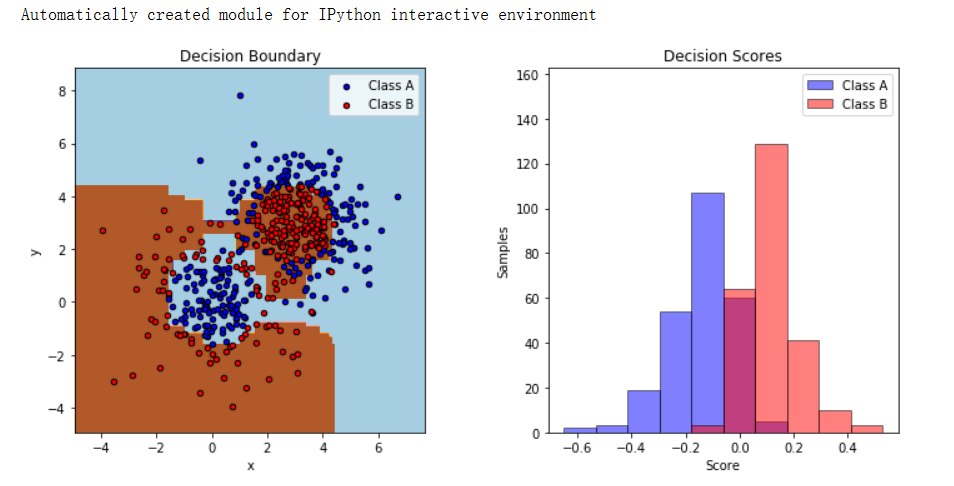

代码实现

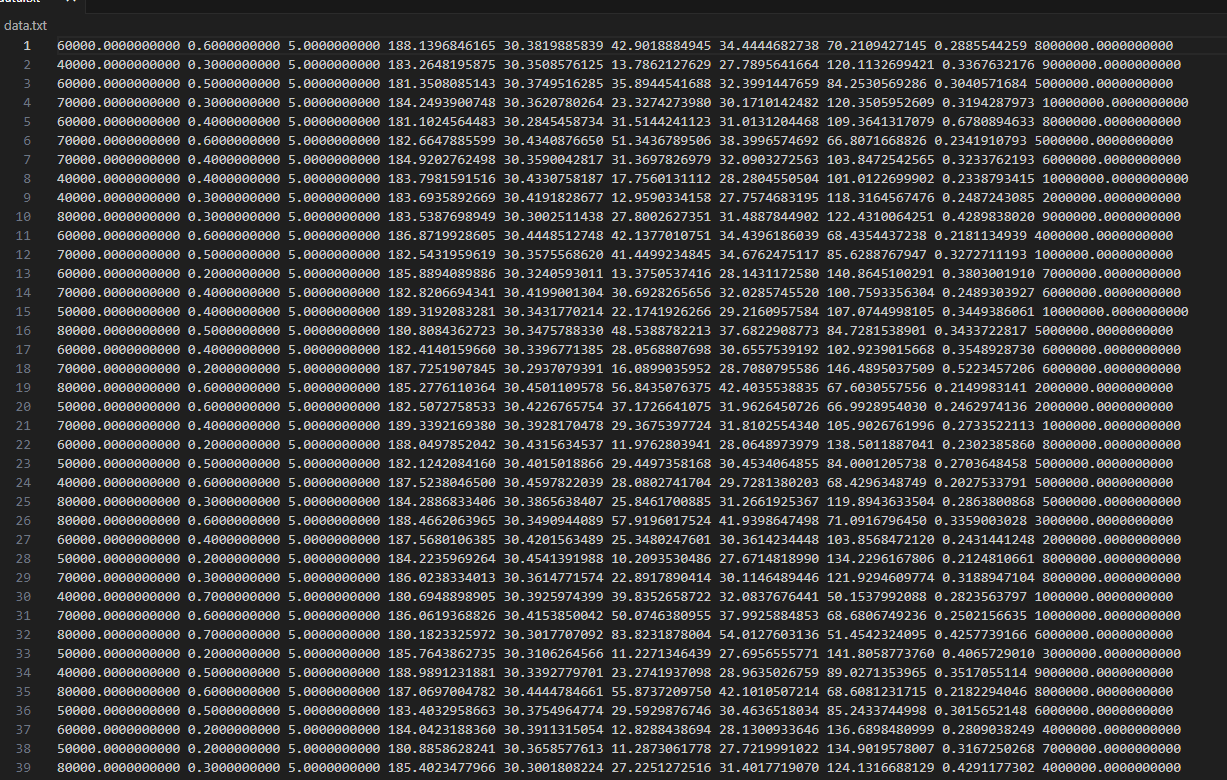

在Python中实现一个简单的AdaBoost算法涉及到多个步骤,包括初始化权重、训练弱学习器、更新样本权重和构建强学习器。在这里,我们将使用一个简单的示例问题(一个二分类问题)来演示AdaBoost的实现。

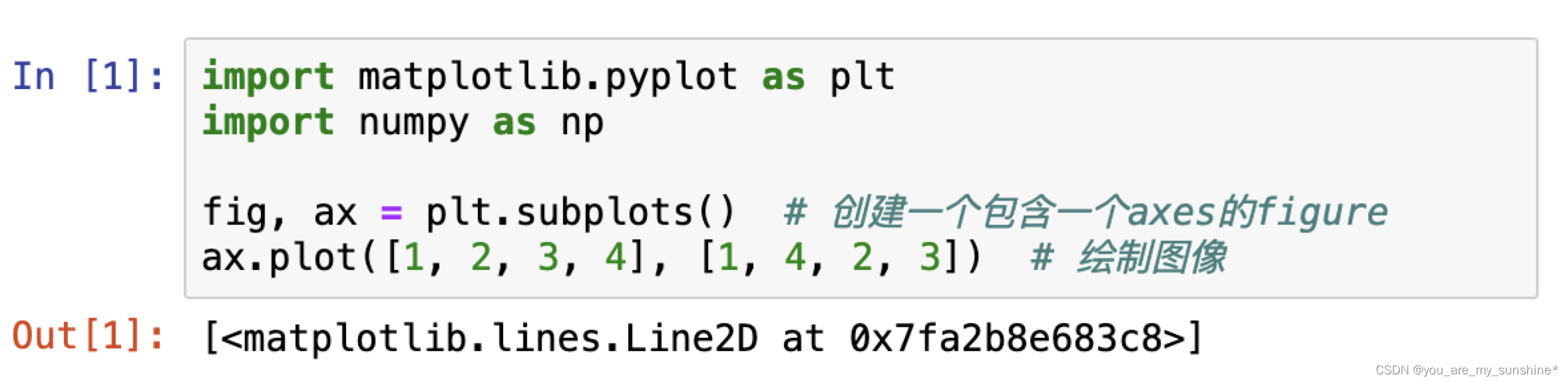

首先,让我们导入必要的库:

import numpy as np

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import make_classification

from sklearn.metrics import accuracy_score接下来,我们生成一个简单的二分类数据集:

X, y = make_classification(n_samples=100, n_features=2, n_informative=2, n_redundant=0, random_state=42)现在,让我们开始实现AdaBoost算法:

class AdaBoostClassifier:

def __init__(self, n_estimators=50):

self.n_estimators = n_estimators

self.alphas = []

self.models = []

def fit(self, X, y):

# 初始化样本权重

weights = np.ones(len(X)) / len(X)

for _ in range(self.n_estimators):

# 创建一个弱分类器,这里使用决策树桩

model = DecisionTreeClassifier(max_depth=1)

model.fit(X, y, sample_weight=weights)

# 计算模型错误率

predictions = model.predict(X)

error = np.sum(weights * (predictions != y)) / np.sum(weights)

# 计算模型权重

alpha = 0.5 * np.log((1 - error) / error)

# 更新样本权重

weights = weights * np.exp(-alpha * y * predictions)

weights /= np.sum(weights)

# 存储模型和权重

self.models.append(model)

self.alphas.append(alpha)

def predict(self, X):

# 使用所有弱分类器进行预测

predictions = np.array([model.predict(X) for model in self.models])

# 加权求和

weighted_sum = np.sum(self.alphas * predictions, axis=0)

# 使用符号函数进行分类

return np.sign(weighted_sum).astype(int)接下来,我们用这个实现的AdaBoost算法进行训练和预测,并评估其性能:

# 创建并训练AdaBoost模型

adaboost = AdaBoostClassifier(n_estimators=50)

adaboost.fit(X, y)

# 预测并计算准确性

y_pred = adaboost.predict(X)

accuracy = accuracy_score(y, y_pred)

print(f"AdaBoost 准确性: {accuracy}")这就是一个简单的AdaBoost算法的实现。需要注意的是,这里使用的是决策树桩作为弱学习器,而在实际应用中,可以选择其他类型的弱学习器。此外,这只是一个基础版本,实际应用中可能需要更复杂的调优和改进。