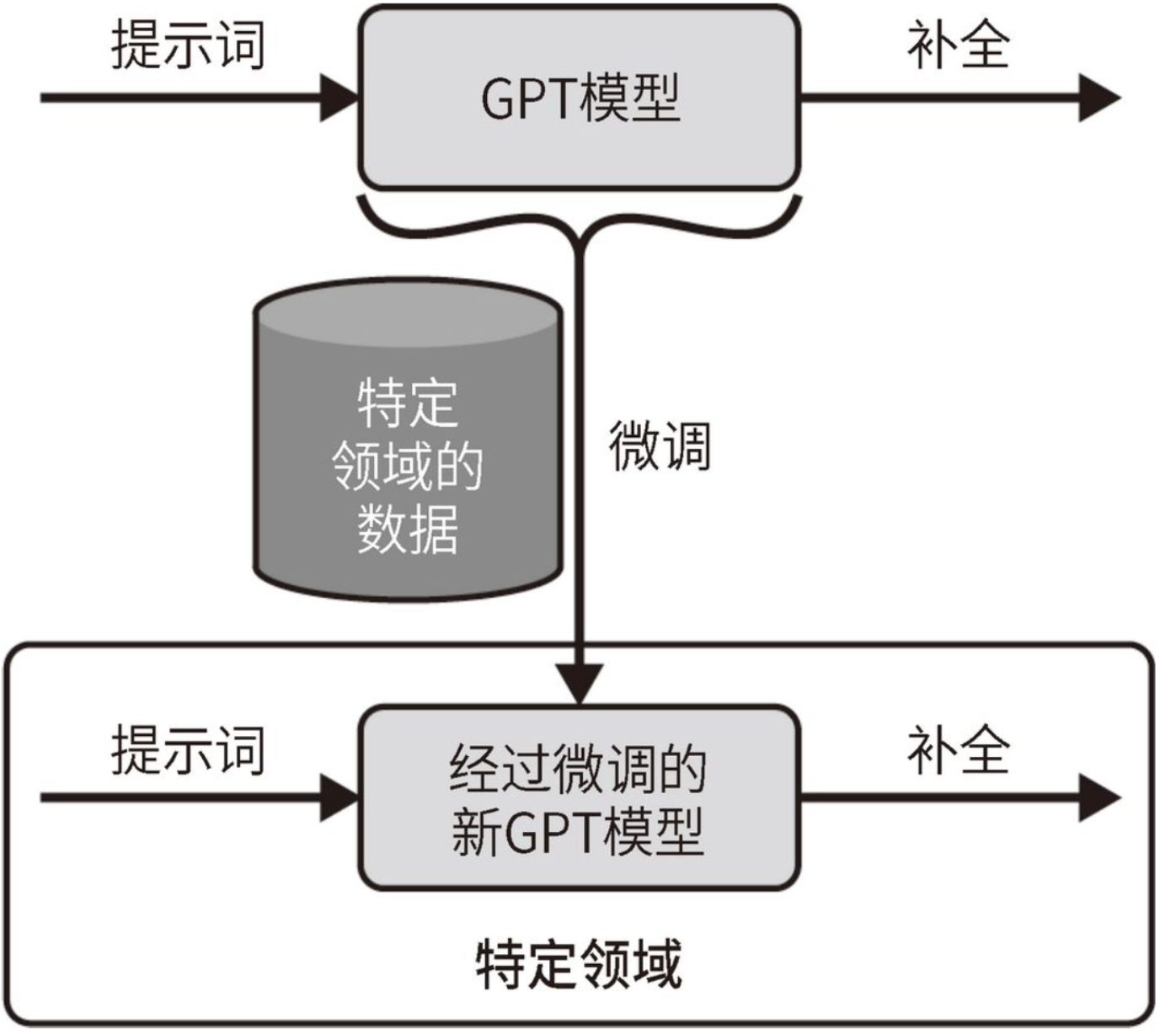

在AI Native应用中,模型微调(Fine-Tuning)是一个至关重要的步骤,它允许开发者通过特定领域的数据对预训练模型进行二次训练,以使其更好地适应特定任务或数据集。以下是对AI Native应用中的模型微调的详细解析:

一、模型微调的重要性

- 提升性能:模型微调可以显著提高模型在特定任务上的准确率和性能,使其更加适应实际应用场景。

- 高效利用资源:相比于从头开始训练模型,微调可以节省大量的计算资源和时间,因为预训练模型已经具备了一定的基础知识和特征提取能力。

- 个性化定制:通过微调,开发者可以根据用户的具体需求和行为定制模型,提供更加个性化和精准的服务。

二、模型微调的步骤

选择合适的预训练模型:

- 根据应用需求选择一个适合的预训练模型作为基础,如BERT、GPT、ResNet等。

- 这些模型在大规模数据上预训练过,具有强大的特征提取能力。

准备数据集:

- 收集和处理与目标任务相关的数据集,确保数据的质量和多样性。

- 数据集需要高质量、标注好的数据,以支持模型的进一步训练。

调整模型结构(可选):

- 根据具体任务的需求,可能需要对模型的结构进行适当的修改。

- 例如,在图像分类任务中,可以通过只微调最后一层或最后几层来进行高效微调。

配置超参数:

- 配置微调过程中的超参数,包括学习率、批量大小、训练轮数等。

- 这些参数对模型的性能有很大影响,需要通过实验进行调优。

进行微调训练:

- 使用目标任务数据对模型进行再训练,更新模型的权重以更好地适应该任务。

- 监督微调、LoRA微调方法和P-tuning v2微调方法是常见的微调方法。

评估和部署:

- 对微调后的模型进行评估,确保其性能达到预期目标。

- 使用适当的评估指标(如准确率、F1分数等)进行评估。

- 将微调后的模型部署到生产环境中,确保模型能够处理实时数据并提供可靠的预测。

三、模型微调的方法

全量微调(Full Fine-Tuning):

- 对模型的所有参数进行训练,以适应新的任务或数据。

- 需要大量的计算资源和时间,通常依赖于高性能的GPU集群。

- 能够充分挖掘预训练模型的潜力,但存在灾难性遗忘的风险。

参数高效微调(Parameter-Efficient Fine-Tuning, PEFT):

- 只更新模型的一小部分参数来实现微调,从而显著降低计算成本和时间消耗。

- 包括LoRA、Prefix Tuning、Adapter Tuning等技术手段。

- 特别适用于数据量有限、资源有限的场景。

四、模型微调的应用领域

- 自然语言处理(NLP):如文本分类、命名实体识别、问答系统等。

- 图像识别:如宠物识别、安全监控、医疗图像识别等。

- 语音识别:如多语种语音识别、语音翻译等。

五、模型微调的挑战与未来方向

- 过拟合:模型可能会过度适应训练数据,导致在新数据上的泛化能力下降。

- 数据偏差:如果微调使用的数据集存在偏差,模型可能会学习到错误的模式。

- 计算资源限制:模型微调通常需要较大的计算资源。

- 自动化微调:未来可能通过自动化的方式选择最优的微调策略和参数,提高开发效率。

- 模型压缩:为了适应资源受限的设备,模型压缩技术将得到进一步发展。

- 可解释性:随着AI伦理和透明度的要求越来越高,可解释性将成为模型微调的重要考量因素。

综上所述,模型微调在AI Native应用中扮演着至关重要的角色,通过微调可以显著提升模型在特定任务上的性能,并更好地适应实际应用场景。