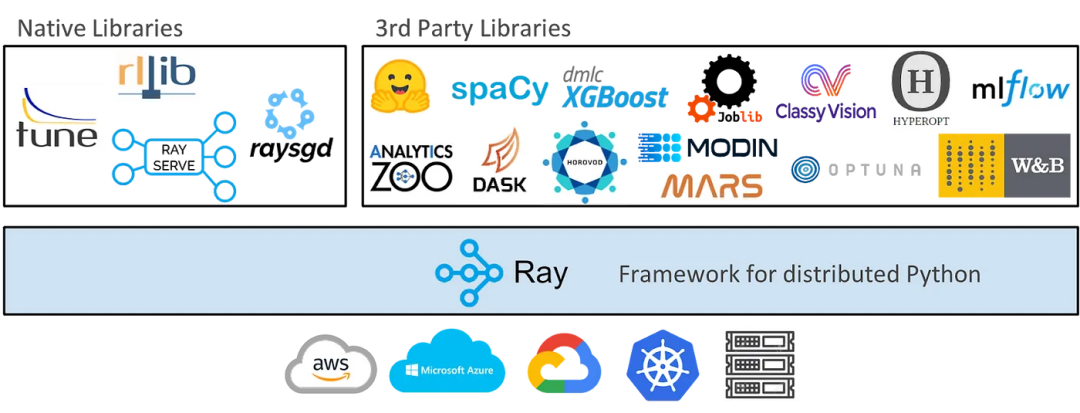

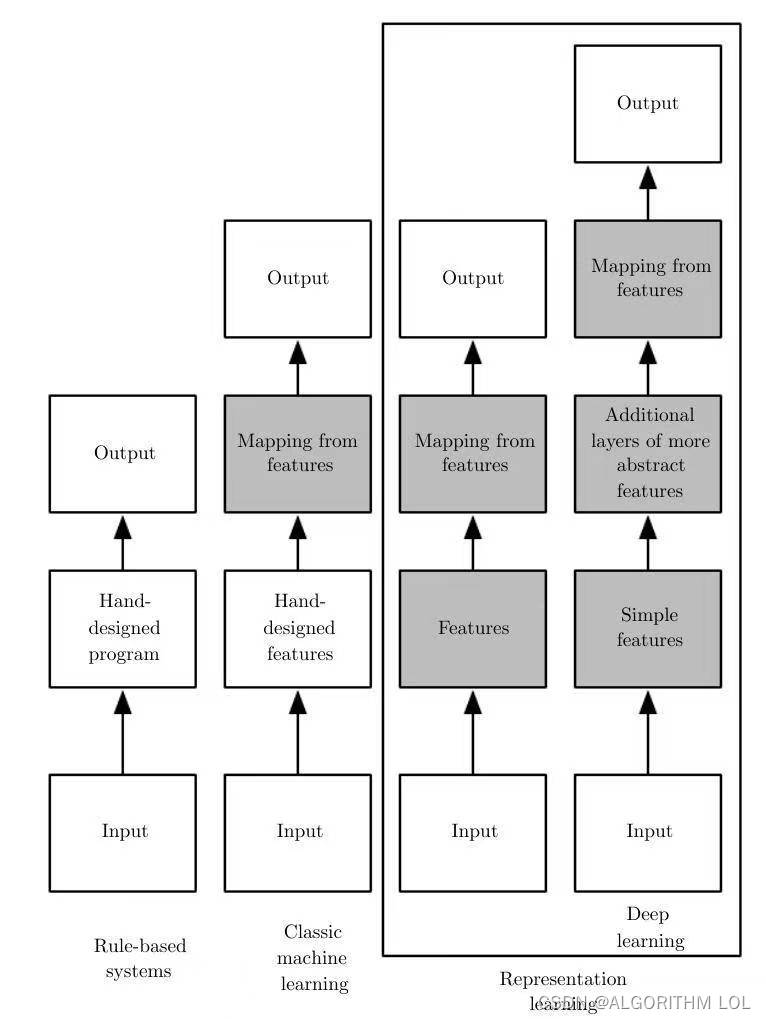

大家好,随着深度学习技术的发展,计算需求日益增长。深度学习中的矩阵运算、图像处理等任务,都可以通过并行计算来加速。

本文将介绍CUDA,一种Nvidia开发的编程模型,以及如何在PyTorch中配置CUDA环境,以实现深度学习模型的高效开发。

1.CUDA简介

CUDA(Compute Unified Device Architecture,统一计算设备架构)是由Nvidia开发的编程模型和并行计算平台。

使用CUDA,开发人员可以最大化地利用Nvidia提供的GPU,从而提高计算能力,并通过并行化任务来更快地执行操作。PyTorch提供了torch.cuda库来设置和运行CUDA操作。

利用PyTorch的CUDA功能,可以创建张量并将其分配至GPU。完成分配后,所有计算操作都将在GPU上进行,确保结果也存储于该设备。

2.安装

PyTorch在其官方网站上提供了用户友好的界面,可以选择操作系统、所需的编程语言和其他要求。

请参考官方PyTorch链接(https://pytorch.org/get-started/locally/),根据系统规格选择要求。

PyTorch为Windows和Linux操作系统提供了CUDA库。对于Windows,请使用CUDA 11.6,因为CUDA 10.2和ROCm不再支持Windows。对于Python编程语言,可以选择conda、pip和源包,而LibTorch则用于C++和Java语言。

3.在PyTorch中运行CUDA操作

成功安装后,可以使用torch.cuda接口在PyTorch中运行CUDA操作。

要确定安装是否成功,使用 torch.version.cuda 命令,如下所示:

# 导入Pytorch

import torch

# 输出CUDA版本

print("Pytorch CUDA版本是:", torch.version.cuda)

如果安装成功,上述代码会显示以下输出:

# 输出

Pytorch CUDA版本是:11.6

在使用CUDA之前,需要确保系统是否支持CUDA。

使用以下命令检查CUDA是否受系统支持:

# 导入Pytorch

import torch

# 检查CUDA是否受系统支持

print("系统是否支持CUDA:", torch.cuda.is_available())

上述命令返回以下:

# 输出

系统是否支持CUDA:True

PyTorch CUDA还提供了以下功能,以了解给定设备ID时的设备ID和设备名称:

# 导入Pytorch

import torch

# 了解CUDA设备ID和设备名称

cuda_id = torch.cuda.current_device()

print("CUDA设备ID: ", torch.cuda.current_device())

print("当前CUDA设备名称: ", torch.cuda.get_device_name(cuda_id))

上述代码会显示以下输出:

# 输出

CUDA设备ID: 0

当前CUDA设备名称: NVIDIA GeForce RTX 1650

还可以通过指定ID来更改默认的CUDA设备:

# 导入Pytorch

import torch

# 更改默认CUDA设备

torch.cuda.set_device(1)

注意:在使用CUDA时,请确定开发与设备无关的代码,因为有些系统可能没有GPU,不得不在CPU上运行,反之亦然。这可以通过在代码中添加以下行来实现:

device = ‘cuda’ if torch.cuda.is_available() else ‘cpu’

4.使用CUDA操作张量

通常,Pytorch张量与NumPy数组相同,都是用于数值计算的n维数组。二者的不同之处在于,PyTorch张量可以在CPU和GPU两种不同的设备上运行。

Pytorch CUDA提供了以下功能来处理张量:

tensor.device:返回张量所在的设备名称,默认是“CPU”。tensor.to(device_name)— 用于将张量迁移到指定的设备。设置device_name为"CPU",张量就会在CPU上;设置为"cuda",张量则会在GPU上执行。tensor.cpu()— 将张量从当前设备传输到CPU。

为了演示这些功能,我们创建一个张量,首先在CPU上进行操作,比如平方运算,然后将张量移动到GPU上,再次执行相同的运算,以此来比较两者的性能差异。

import torch

# 创建一个样本张量

x = torch.randint(1, 1000, (100, 100))

# 检查设备名称:默认将返回‘CPU’

print("设备名称: ", x.device)

# 应用张量操作

res_cpu = x ** 2

# 将张量传输到GPU

x = x.to(torch.device('cuda'))

# 检查设备名称:将返回‘cuda:0’

print("传输后的设备名称: ", x.device)

# 应用相同的张量操作

res_gpu = x ** 2

# 将张量从GPU传输到CPU

x.cpu()

5.使用CUDA运行机器学习模型

CUDA提供了一种便捷的方法,可以将机器学习模型部署到不同的计算设备上:

使用

model.to(device_name),可以创建模型的新实例,并指定它运行在CPU或支持CUDA的GPU上。其中,"CPU"代表在CPU上运行,而"cuda"则代表在GPU上运行。

为了展示这一功能,导入torchvision.models中的预训练"Resnet-18"模型,并演示如何将其部署到指定的设备上。

# 导入Pytorch

import torch

import torchvision.models as models

# 使代码与设备无关

device = 'cuda' if torch.cuda.is_available() else 'cpu'

# 实例化预训练模型

model = models.resnet18(pretrained=True)

# 将模型传输到支持CUDA的GPU

model = model.to(device)

模型成功迁移到支持CUDA的GPU之后,便可以继续执行剩余的机器学习任务。

总结来说,本文向读者展示了如何在系统中安装PyTorch CUDA库,掌握PyTorch CUDA的基本操作,并利用CUDA高效处理张量和机器学习模型。

![[米联客-安路飞龙DR1-FPSOC] FPGA基础篇连载-20 读写I2C接口的RTC时钟芯片](https://i-blog.csdnimg.cn/direct/071226e1bfcb4dbabd03279d16fa44e4.png)