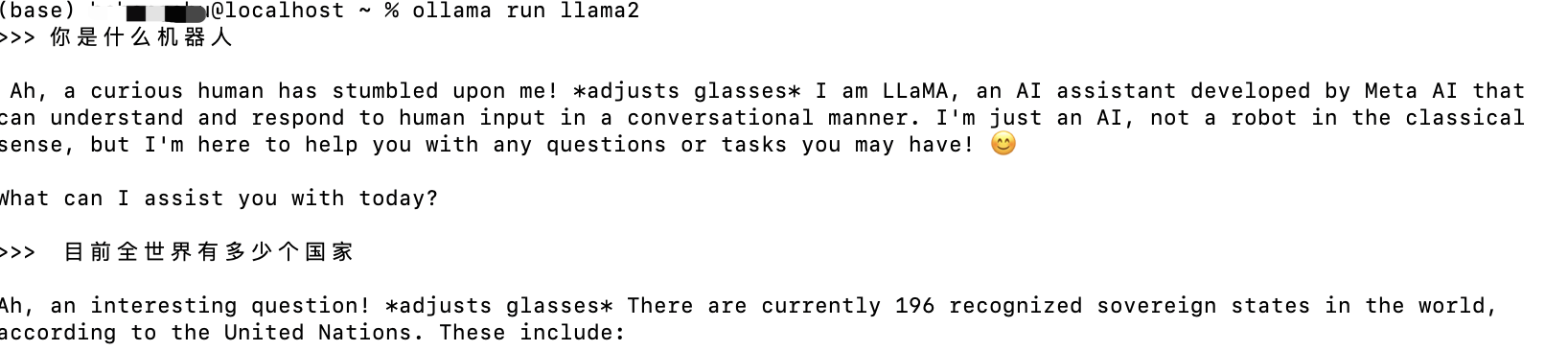

显卡是VEGA56,这个卡代号是gfx900 虽然ollama页面上写着这个卡可以,但是实际是不可以的

报错如下:

level=WARN source=amd_windows.go:97 msg="amdgpu is not supported" gpu=0 gpu_type=gfx900:xnack

它认为的GPU型号是 gfx900:xnack 但是 没有GPU叫这个!

那如何解决?

set HSA_OVERRIDE_GFX_VERSION=9.0.0

ollama serve

Ok

至于ROCM 是不用安装的,显卡驱动用游戏驱动最新版就行。

但是 必须保证 \AppData\Local\Programs\Ollama\rocm rocblas.dll 里有这个显卡,要是喜欢自己编译可以自己编译 否则去搜下 <<AMD显卡全系列解锁Ollama支持,llama3运行更优雅!>> rocBLAS-HIP5.7.1-win.rar 用人家编译好的也可以

3700X

![[240714] X-CMD 发布 v0.4.0:引入 pixi 、pkgx、scorecard、kill 和 top 模块](https://i-blog.csdnimg.cn/direct/e28ab35b455149fb929c79499cc41885.png#pic_center)