准我快乐地重饰演某段美丽故事主人

饰演你旧年共寻梦的恋人

再去做没流着情泪的伊人

假装再有从前演过的戏份

重饰演某段美丽故事主人

饰演你旧年共寻梦的恋人

你纵是未明白仍夜深一人

穿起你那无言毛衣当跟你接近

🎵 陈慧娴《傻女》

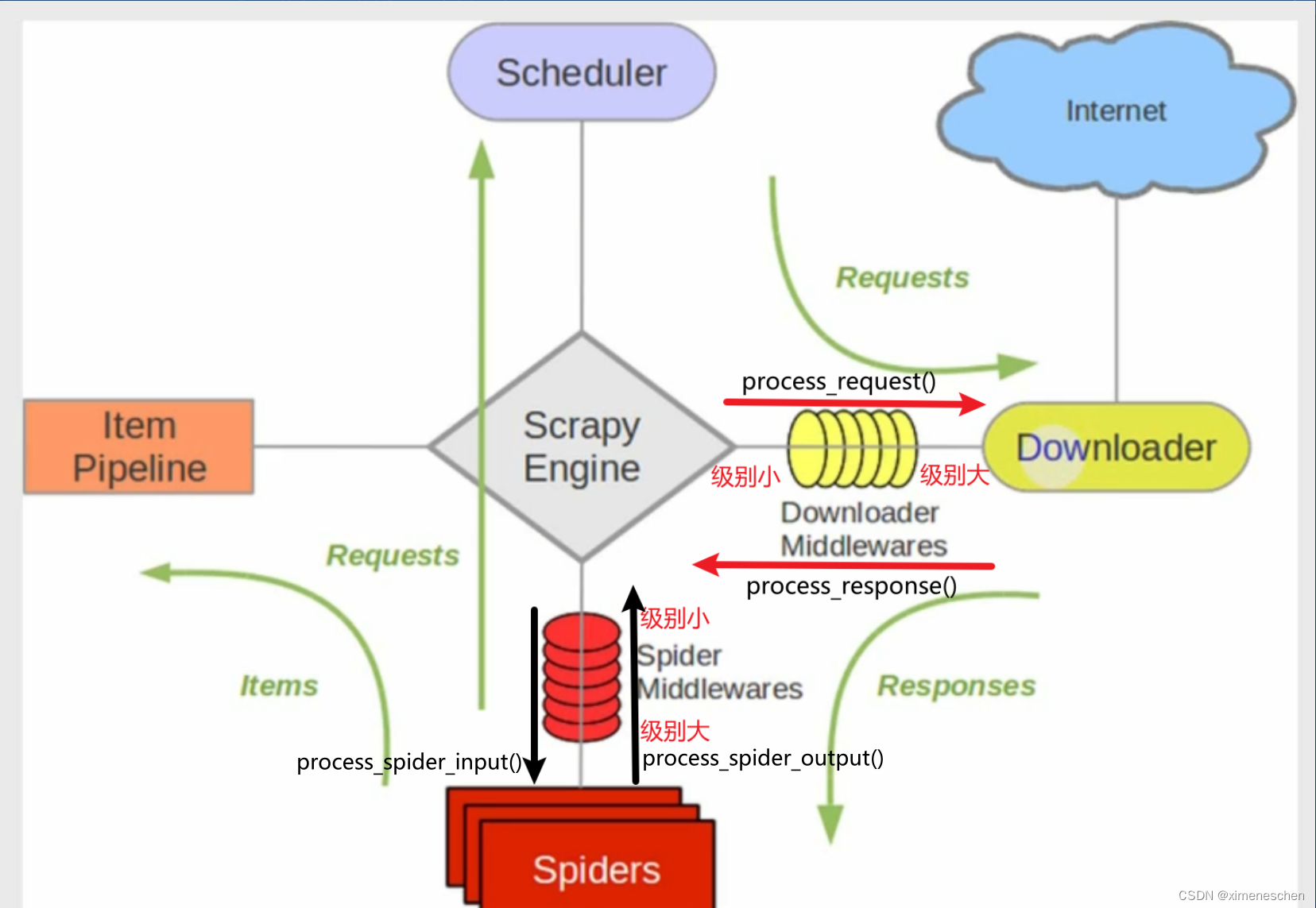

Scrapy 是一个强大且灵活的网页爬虫框架,通过中间件(middlewares)机制,允许用户对请求和响应进行自定义处理。下载中间件(Downloader Middleware)是其中的重要组件之一,主要负责在请求发送到目标网站前以及响应到达爬虫前的处理。在下载中间件中,process_response 方法用于处理从目标网站返回的响应。本文将详细介绍 process_response 方法的工作机制和应用示例。

什么是 process_response 方法?

process_response 方法是下载中间件的一部分,用于在 Scrapy 接收到响应后对响应进行处理。这个方法可以用来修改响应、进行错误处理、数据清洗等操作。其主要功能包括:

- 修改响应:更改响应内容,如修改 HTML 或 JSON 数据。

- 错误处理:根据响应状态码或内容执行相应的错误处理逻辑。

- 数据清洗:在将响应数据传递给爬虫前进行预处理,如删除不需要的标签或字段。

如何实现 process_response 方法?

实现 process_response 方法需要定义一个下载中间件,并在其中编写处理逻辑。以下是一个简单的示例,展示了如何使用 process_response 方法进行响应处理。

示例:检查响应状态码

首先,在 Scrapy 项目的 middlewares.py 文件中定义一个下载中间件:

import logging

from scrapy.exceptions import IgnoreRequest

class CheckResponseMiddleware:

def __init__(self):

self.logger = logging.getLogger(__name__)

def process_response(self, request, response, spider):

# 检查响应状态码,如果不是 200 则忽略请求

if response.status != 200:

self.logger.warning(f'Received non-200 response: {response.status} for URL: {request.url}')

raise IgnoreRequest(f'Non-200 response: {response.status}')

# 如果状态码是 200,则返回响应

return response

配置中间件

在 Scrapy 的 settings.py 文件中,启用自定义中间件:

# settings.py

# 启用自定义中间件

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.CheckResponseMiddleware': 543,

}

中间件的工作流程

- 初始化:当 Scrapy 启动时,CheckResponseMiddleware 类会被实例化。

- 处理响应:每次 Scrapy 接收到响应时,process_response 方法被调用。中间件会检查响应的状态码,如果状态码不是 200,则记录警告- 日志并忽略请求;否则,返回响应以继续处理。

处理其他响应操作

除了检查状态码,process_response 方法还可以用于其他操作。例如,修改响应内容:

class ModifyResponseMiddleware:

def process_response(self, request, response, spider):

# 修改响应内容

if 'example' in response.text:

modified_text = response.text.replace('example', 'modified_example')

response = response.replace(body=modified_text)

return response

或者,记录响应时间:

import time

class LogResponseTimeMiddleware:

def process_request(self, request, spider):

request.meta['start_time'] = time.time()

def process_response(self, request, response, spider):

start_time = request.meta.get('start_time', time.time())

duration = time.time() - start_time

spider.logger.info(f'Request to {request.url} took {duration:.2f} seconds')

return response

结论

process_response 方法是 Scrapy 下载中间件中一个非常重要的钩子,允许开发者在响应到达爬虫之前对其进行自定义处理。通过使用 process_response 方法,可以实现响应修改、错误处理、数据清洗等操作,从而增强爬虫的功能和灵活性。在实际项目中,充分利用 process_response 方法可以使爬虫更加智能和高效。