0. Abstract

很早以前就遇到了 BatchNorm 和 LayerNorm, 当时只是粗略地知道它们是对数据进行了标准化: x = x − μ σ \bm{x} = \frac{\bm{x} - \bm{\mu}}{\bm{\sigma}} x=σx−μ 这当然很简单, 但实际的数据是比较复杂的. 对于 CV 任务的数据 image 而言, 一个 batch 的数据通常是这样的: [B, C, H, W]; 对于 NLP 任务的数据 sentence 而言, 一个 batch 的数据通常是这样的: [B, T, D]. 那 XXNorm 是怎么算的? 肯定不是一下算整个 batch 的所有数的 μ \bm{\mu} μ 和 σ \bm{\sigma} σ, 且它们是有区别的.

于是查阅了很多资料:

- 《batchNormalization 与 layerNormalization 的区别》

- 《NLP 中 batch normalization 与 layer normalization》

- 《BatchNorm1d 与 BatchNorm2d》

- 《基础 | BatchNorm详解》

- 《Why do transformers use layer norm instead of batch norm?》

真是应了导师的话: 别去看那些乱七八糟的博客, 他们水平还不如你呢! 还是老外厉害, 仅仅是在评论区回答问题就把问题讲得清清楚楚.

1. 如何计算?

先从理论上说一下, 询问通义千问:

>>>>> 通义千问 >>>>>

layer norm 和 batch norm 的区别? 给出公式解释.

答: Layer Normalization (LayerNorm) 和 Batch Normalization (BatchNorm) 都是用于加速神经网络训练的技术, 通过规范化层的输入或激活值, 使网络的学习更加稳定和高效. 但是, 它们在实施方式和适用场景上有所不同.

Batch Normalization (BatchNorm)

BatchNorm 主要在训练期间对一个 mini-batch 的数据进行规范化. 它的主要目标是减少内部协变量移位(internal covariate shift), 即在网络的前向传播过程中, 中间层的输入分布随训练迭代而变化的现象. BatchNorm 通过计算当前 mini-batch 的均值和方差来规范化输入, 公式如下:

设 x \bm{x} x 是一个 mini-batch 内的输入向量, μ B \bm{\mu}_B μB 和 σ B 2 \bm{\sigma}^2_B σB2 分别是该 mini-batch 的均值和方差, 则 BatchNorm 的输出 y \bm{y} y 可以表示为: x ^ = x − μ B μ B 2 + ϵ y ^ = γ x ^ + β \begin{aligned} \hat{\bm{x}} &= \frac{\bm{x} - \bm{\mu}_B}{\sqrt{\bm{\mu}_B^2 + \epsilon}} \\ \hat{\bm{y}} &= \gamma\hat{\bm{x}} + \beta \end{aligned} x^y^=μB2+ϵx−μB=γx^+β 其中, γ \gamma γ 和 β \beta β 是可学习的参数, ϵ \epsilon ϵ 是一个很小的常数, 用于数值稳定性.

Layer Normalization (LayerNorm)

LayerNorm 目的是在每个样本级别上进行规范化, 而不依赖于 mini-batch 的统计信息. LayerNorm 更适用于序列模型(如 LSTM 或 Transformer)等, 其中样本间可能存在依赖关系或 mini-batch 大小可能不是固定的. LayerNorm 计算每个样本特征的均值和方差, 公式如下:

设 x \bm{x} x 是单个样本的特征向量, μ L \bm{\mu}_L μL 和 σ L 2 \bm{\sigma}^2_L σL2 分别是该样本特征的均值和方差, 则 LayerNorm 的输出 y \bm{y} y 可以表示为: x ^ = x − μ L μ L 2 + ϵ y ^ = γ x ^ + β \begin{aligned} \hat{\bm{x}} &= \frac{\bm{x} - \bm{\mu}_L}{\sqrt{\bm{\mu}_L^2 + \epsilon}} \\ \hat{\bm{y}} &= \gamma\hat{\bm{x}} + \beta \end{aligned} x^y^=μL2+ϵx−μL=γx^+β 这里同样, γ \gamma γ 和 β \beta β 是可学习的参数, ϵ \epsilon ϵ 是一个很小的常数.

区别

- 依赖于数据:

BatchNorm依赖于 mini-batch 的统计信息, 而LayerNorm依赖于单个样本的特征统计信息; - 应用场景:

BatchNorm更适用于计算机视觉任务, 而LayerNorm更适用于自然语言处理任务, 尤其是在处理序列数据时; - 计算效率:

BatchNorm在并行计算上可能更高效, 因为它可以利用 mini-batch 内的并行性, 而LayerNorm在每个样本上的计算独立, 更适合处理不同长度的序列数据.

这两种方法各有优劣, 选择哪种方法通常取决于具体的应用场景和数据特性.

<<<<< 通义千问 <<<<<

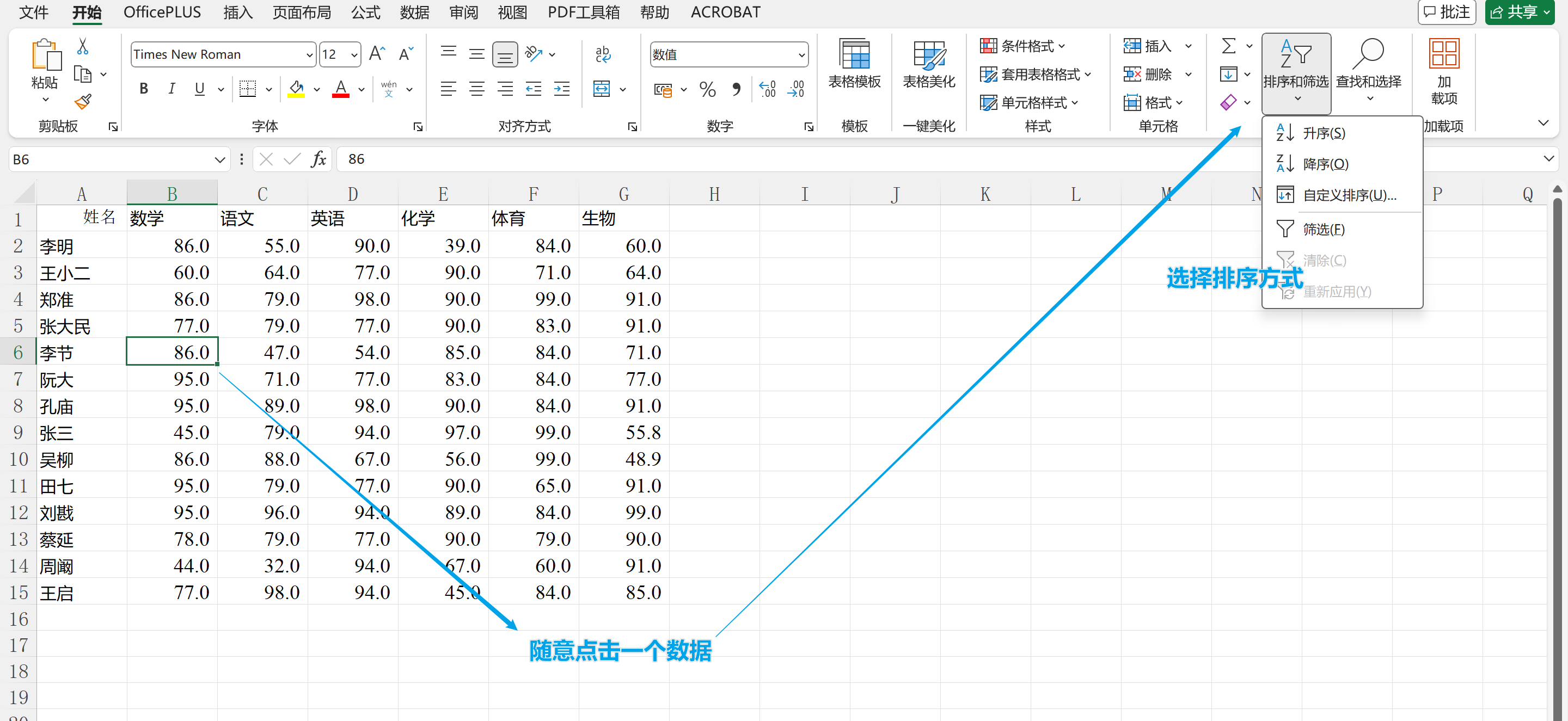

代码加图:

import torch

from torch import nn

weight = torch.ones([1, 3, 1, 1])

bias = torch.zeros([1, 3, 1, 1])

x = 10 * torch.randn(2, 3, 4, 4) + 100

mean = x.mean(dim=[0, 2, 3], keepdim=True)

std = x.std(dim=[0, 2, 3], keepdim=True, unbiased=False)

print(x)

print(mean)

print(std)

y = (x - mean) / std

y = y * weight + bias

print(y)

bnm2 = nn.BatchNorm2d(3)

z = bnm2(x)

print(z)

print(torch.norm(z - y, p=1))