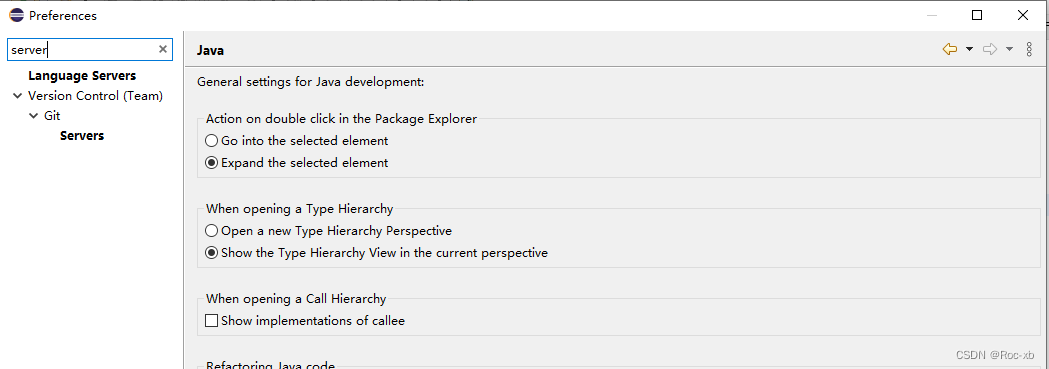

Serving a Torch-TensorRT model with Triton

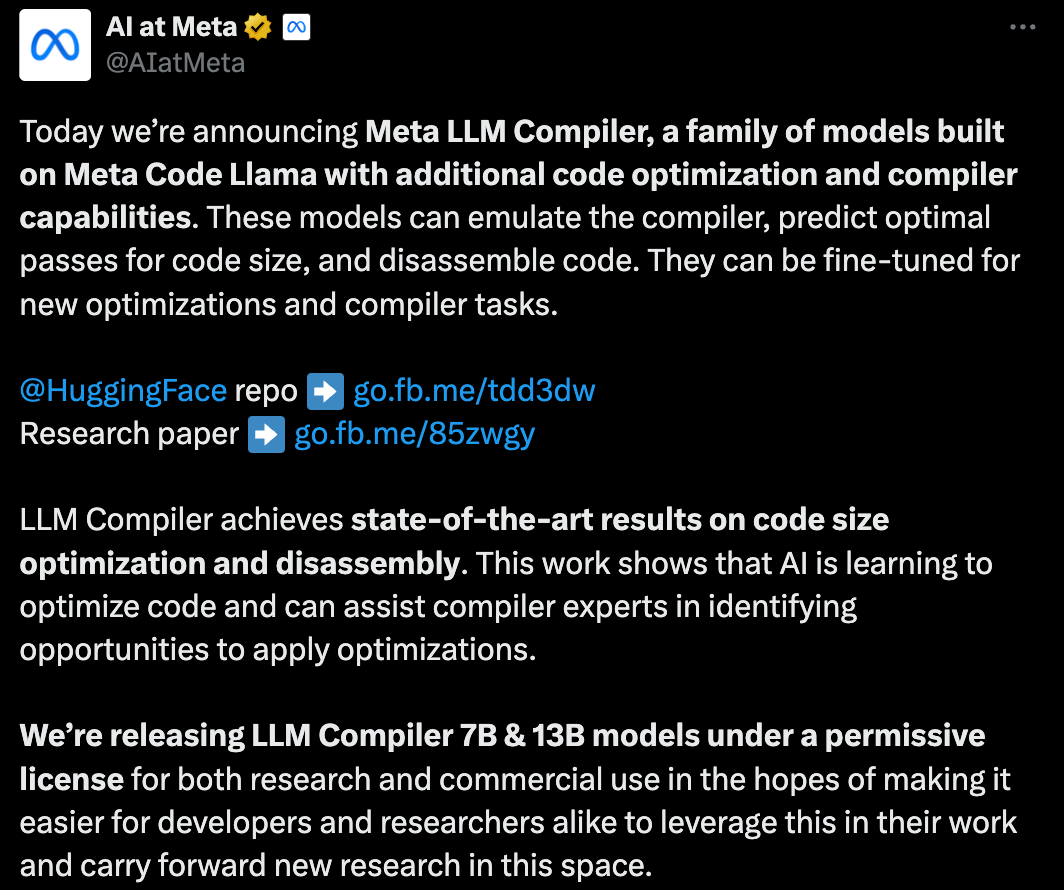

pytorch 的官方文档:

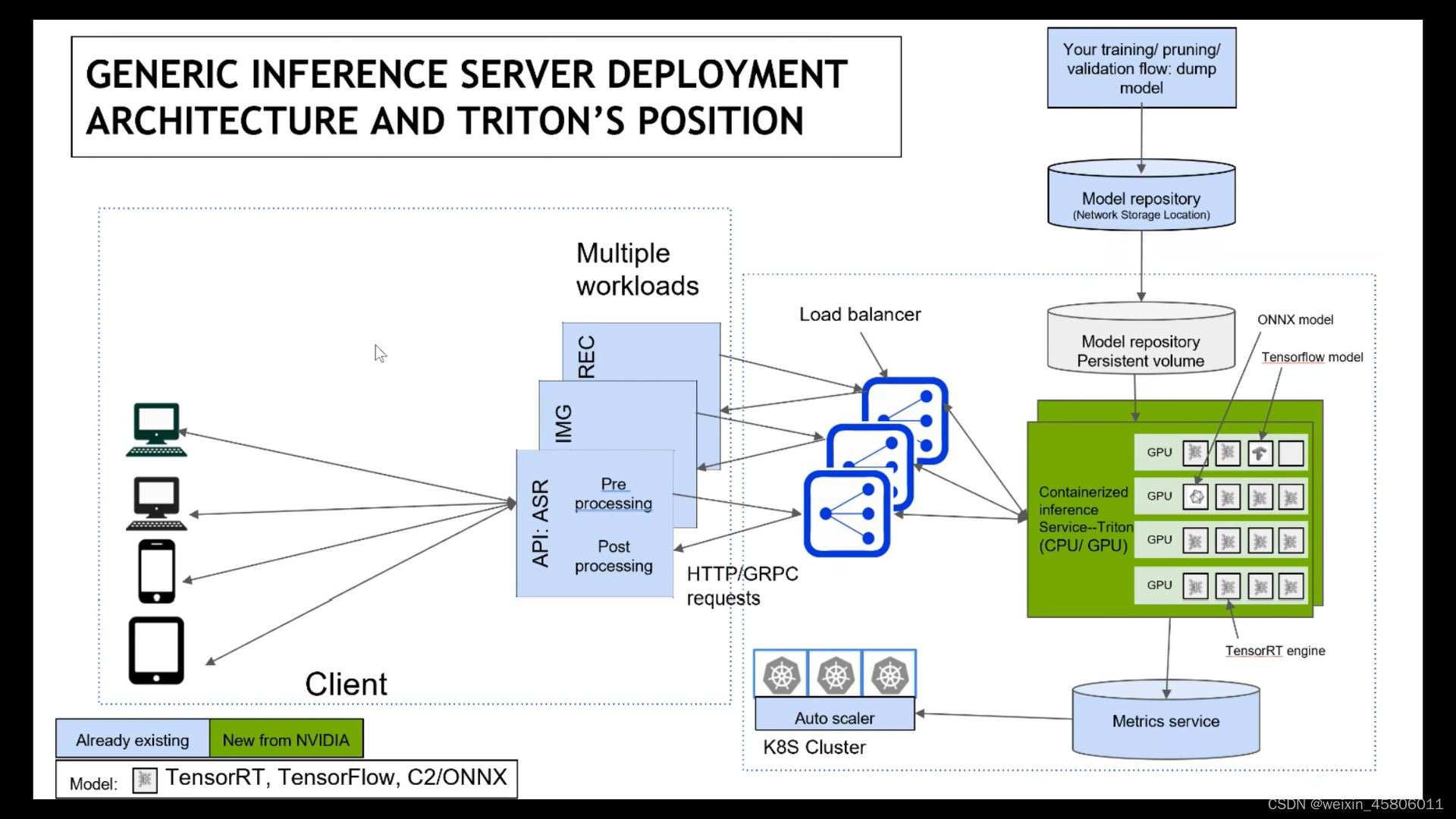

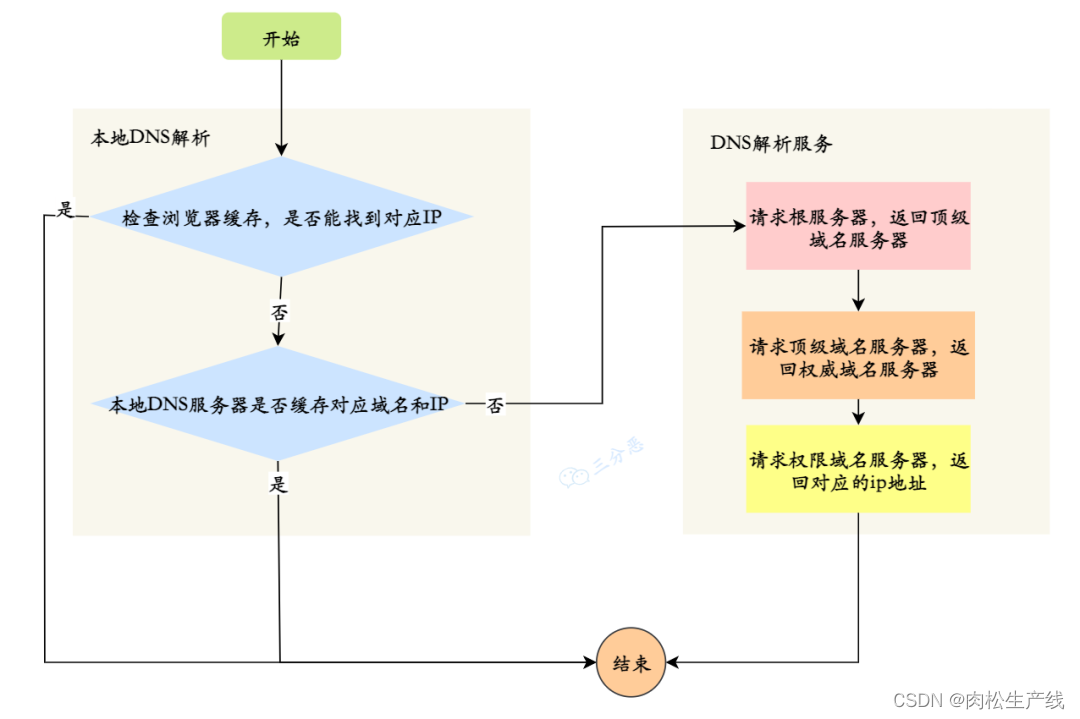

在有关机器学习基础设施的讨论中,优化和部署是密不可分的。一旦完成网络级优化以获得最大性能,下一步就是部署它。

然而,提供这种优化模型也有其自身的一系列考虑和挑战,例如:构建基础设施以支持并发模型执行、通过 HTTP 或 gRPC 支持客户端等等。

Triton推理服务器 解决了上述问题以及更多问题。让我们逐步讨论使用 Torch-TensorRT 优化模型、将其部署在 Triton 推理服务器上以及构建客户端来查询模型的过程。

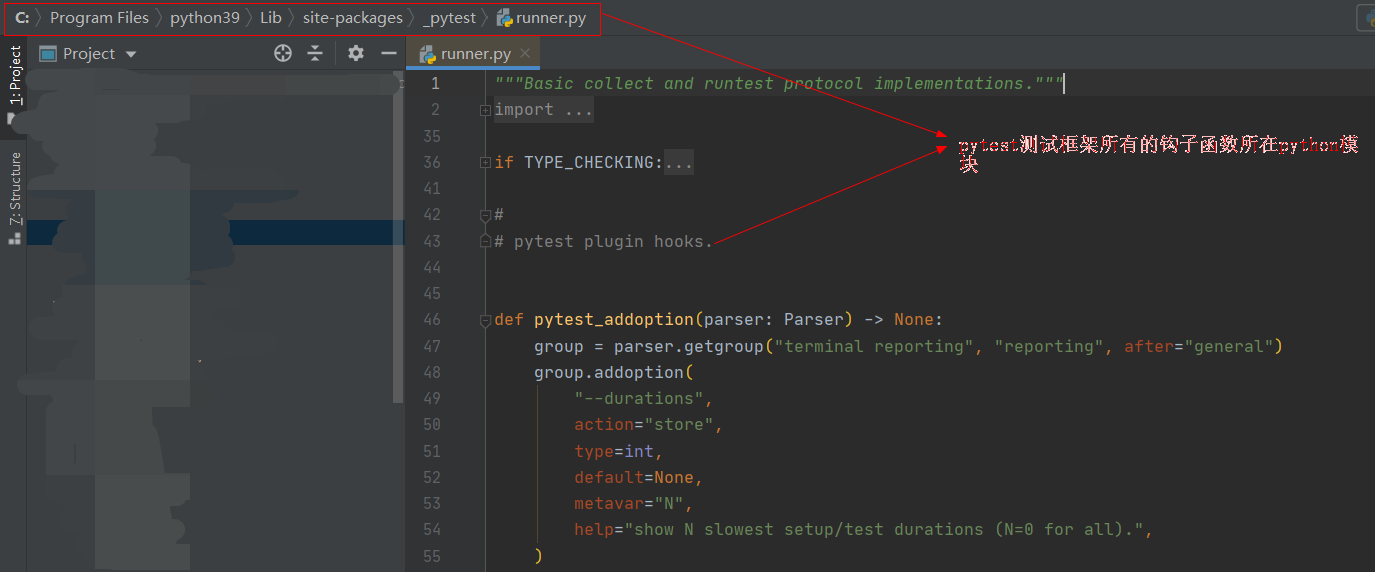

- PyTorch 提供了 TensorRT仓库: 编译以支持 TensorRT