大家好,迁移学习是一种技术,能使机器利用从以前任务中获得的知识来提高对新任务的泛化能力。作为ChatGPT和Google Gemini等模型的核心原理,迁移学习在长文档总结、复杂文章撰写、旅行规划以及诗歌和歌曲创作等重要任务中发挥着关键作用。

本文将介绍迁移学习相关知识,包括定义、与深度学习及现代生成式AI模型的紧密联系,以及所面临的挑战和局限。

1.AI迁移学习

迁移学习是一种技术,能够将针对特定任务训练的模型重新用作新任务的基础。换句话说,就是将预训练的机器学习模型组件重新用于不同的但相关的新模型。

这个概念类似于人类学习新技能的方式。举个例子:假设你是一位优秀的吉他手,决定学习尤克里里。那么你之前弹吉他的经验会加速你学习尤克里里的过程,这是因为许多弹吉他所需的技能和知识与尤克里里通用。

在AI领域,迁移学习可以利用之前的训练来更高效地解决新的相关问题,从而减少时间和计算资源。

2.迁移学习的优势

迁移学习之所以在神经网络开发中被广泛采用,是因为它带来了多方面的优势:

提升训练效率:迁移学习避免了从零开始训练模型的需要,缩短训练周期,并允许使用较小的数据集进行微调。

优化模型性能:迁移学习通过利用预训练的知识,减少过拟合,即使在数据量有限的情况下也能加快训练速度,提高训练效果。

降低运营成本:通过减少从头开始训练模型的需求,迁移学习降低了与数据采集和计算资源使用相关的成本。

增强适应性和可重用性:迁移学习是关键技术,使模型能够适应多变的场景和任务,提升模型的通用性和应用潜力。

3.工作机制

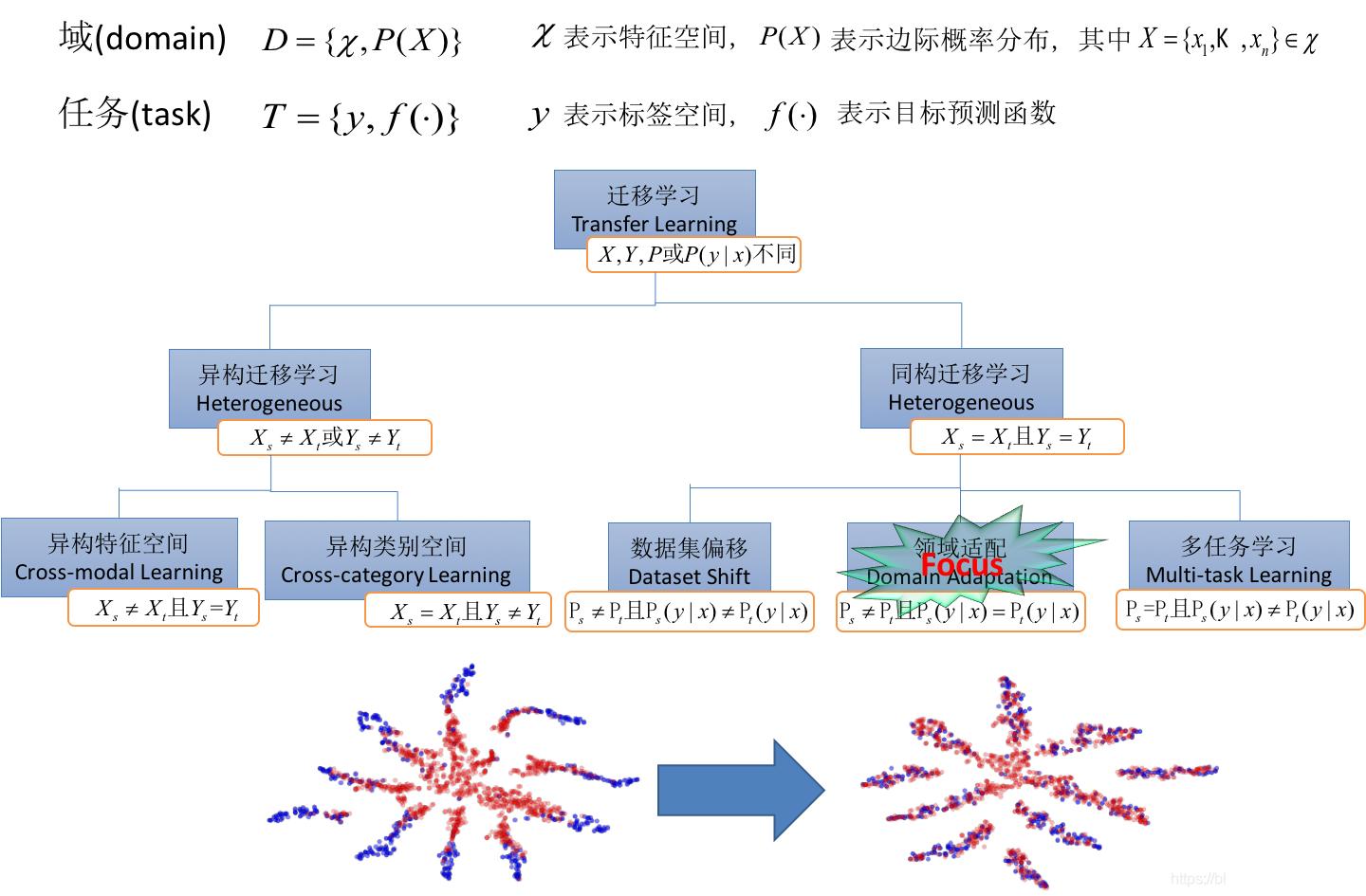

迁移学习的工作机制涉及几个核心概念,包括多任务学习、特征提取和微调:

多任务学习:这种方法通过训练单一模型同时处理多个任务,实现效率的提升。模型的早期层共享,以统一的方式处理数据,而针对每个任务则有独立的层,使模型能够同时学习通用和特定任务的特征。

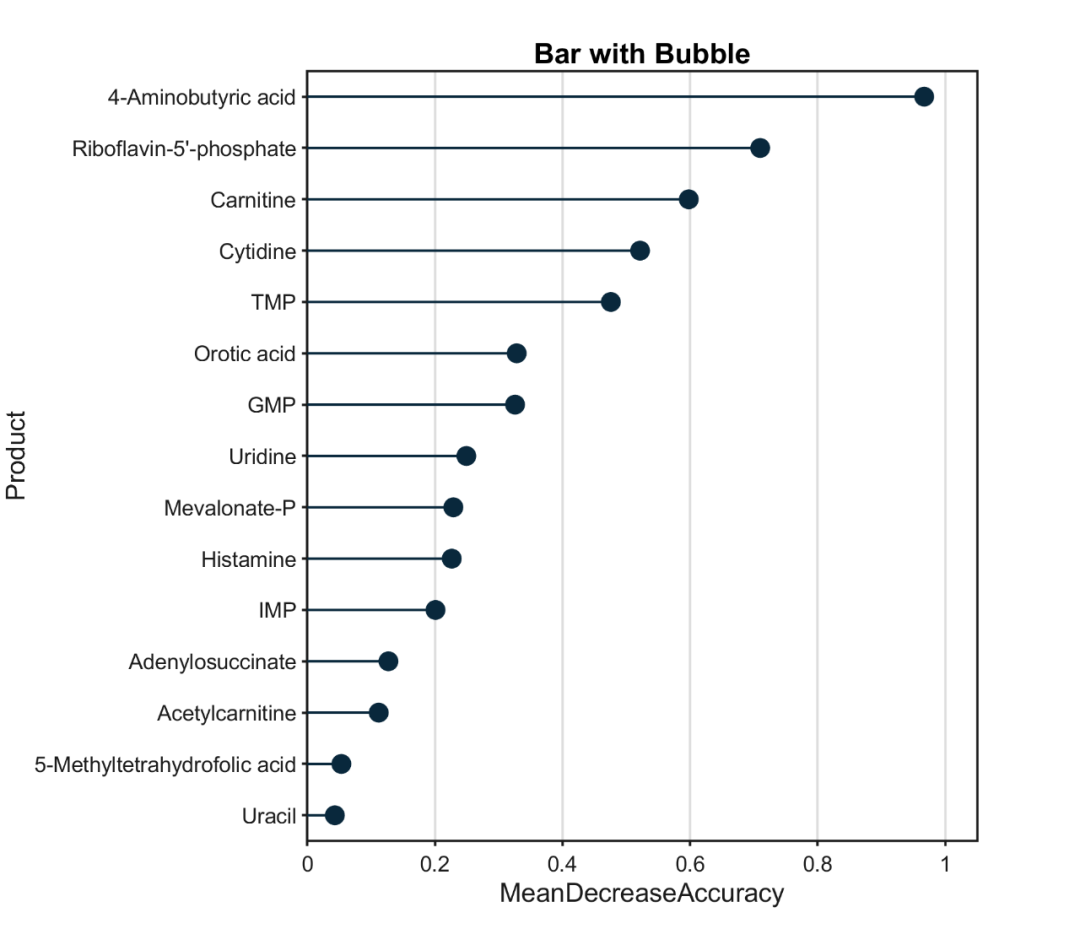

特征提取:在特征提取中,预训练模型用于从数据中抽取关键特征或表示,这些特征随后作为新模型的输入,针对特定任务进行分析和处理。

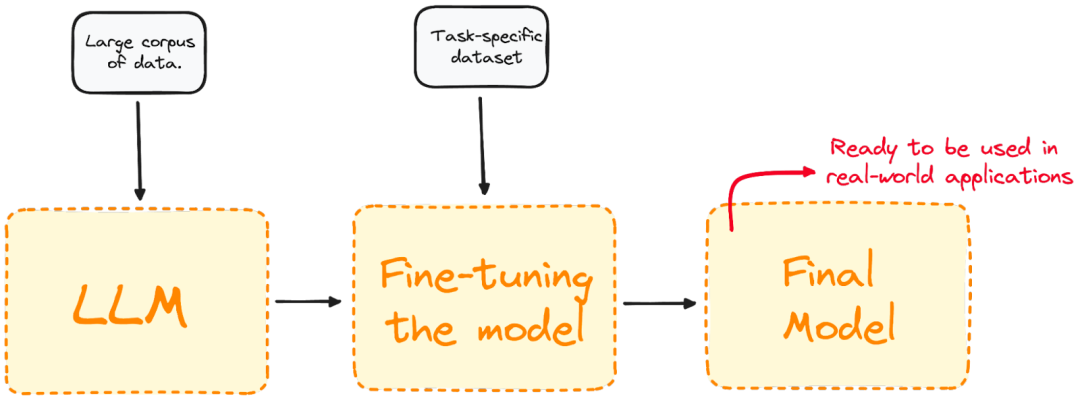

微调:微调超出了特征提取的范畴,通常用于两个任务不密切相关时。它基于预训练模型,通过在特定领域的数据集上进行进一步训练,以优化模型在特定任务上的表现。

可视化微调过程

4.应用

迁移学习是解决多个数据科学任务的常用技术,包括计算机视觉和自然语言处理领域。

4.1 计算机视觉

计算机视觉是迁移学习特别富有成效的领域之一,在这个领域开发的神经网络需要大量数据来处理目标检测和图像分类等任务。

在计算机视觉中,神经网络的初始层检测图像中的边缘,中间层识别形状和形态。最后几层针对特定任务进行定制。迁移学习允许通过仅重新训练最后几层来创建新模型,同时保持初始和中间层的权重和偏差不变。多亏了迁移学习,我们能够创建只重新训练网络最后几层的新模型,同时保持第一层和中间层的权重和偏差。

如今,在计算机视觉领域有许多预训练的公共神经网络,例如:

视觉几何组:VGG是用于图像分类的预训练模型,被广泛用作许多图像分类任务的起点。

You Only Look Once(YOLO):是预训练的最新技术模型,用于目标检测,以其速度和检测广泛对象的能力而著称。

4.2 自然语言处理

NLP是AI的一个分支,专注于通过自然语言实现计算机和人类的交互。目标是编程计算机处理和分析大量自然语言数据,无论是文本还是音频形式。

迁移学习在开发NLP模型中起着至关重要的作用。它允许利用已经用于通用语言理解或翻译的预训练语言模型,然后对它们进行微调,以解决特定的NLP问题,如情感分析或语言翻译。NLP的应用几乎是无限的,包括语音助手和语音识别。

迁移学习是一些最受欢迎的NLP模型背后的驱动力,包括:

来自Transformer的双向编码器表示:BERT,由Google研究人员在2018年创建,是基于Transformer架构的首批大型语言模型之一。它是一个公共的预训练模型,在许多NLP问题上表现出色,包括语言建模、文本分类和机器翻译。

生成预训练Transformer:GPT,由OpenAI开发,包括一系列强大的大型语言模型,处于生成性人工智能革命的前沿。像GPT-3.5和GPT-4这样的GPT模型是广为人知的ChatGPT背后的基础模型。OpenAI最近还推出了GPT-4o,这是迄今为止最强大的版本。

5.最佳实践和挑战

本质上,迁移学习是一种提高神经网络效率的设计方法。与从头开始训练模型相比——这需要大量的资源、金钱和时间,特别是在尖端的生成式AI模型中——迁移学习允许模型通过利用过去的知识,在新任务中更快、更有效地学习。

迁移学习在面对第二任务数据稀缺时展现出显著优势。通过使用预训练模型的知识,迁移学习可以帮助防止过拟合并提高整体准确性。然而,迁移学习并非没有局限,它存在一定的限制和潜在风险,需要开发者谨慎对待。

迁移学习中最常见的挑战包括:

领域不匹配:当源任务与目标任务密切相关时,迁移学习更易成功。如果新任务与原任务差异较大,原有的一般化知识可能不足以应对新任务的特定需求。

数据稀缺:迁移学习需要一定量的训练数据作为基础。数据量过少或数据质量不佳都可能导致模型欠拟合。

过拟合风险:迁移学习也不免于过拟合。如果模型在任务上微调得太多,它可能会学习到不适用于新数据的任务特定特征。

任务复杂性:面对高度复杂的目标任务,微调过程可能充满挑战,不仅成本高昂,而且耗时。

迁移学习是提升神经网络效率和拓展其应用潜力的关键策略,可以说如果没有这些成熟的迁移学习技术作为支撑,我们今天所见证的人工智能革命或许难以实现。