回归预测 | Matlab实现GA-LSSVM遗传算法优化最小二乘支持向量机多输入单输出回归预测

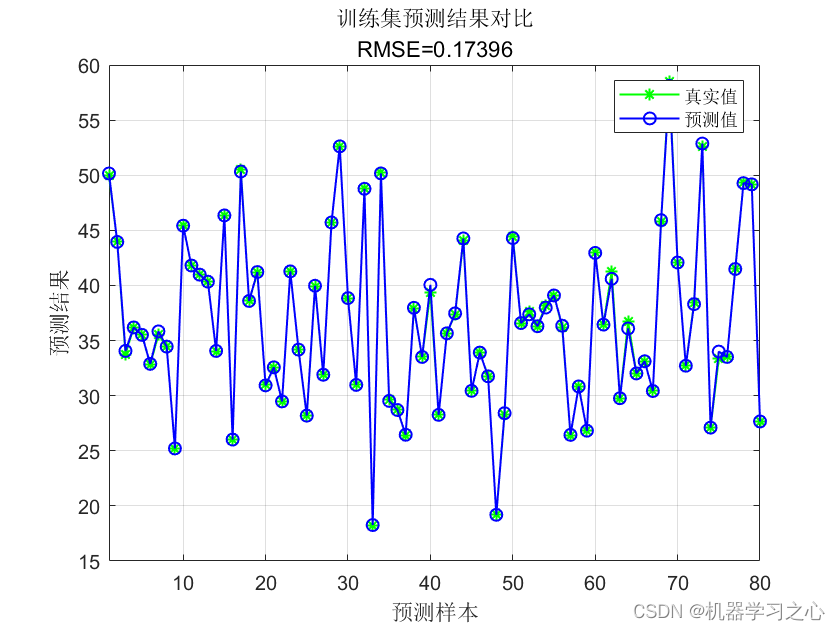

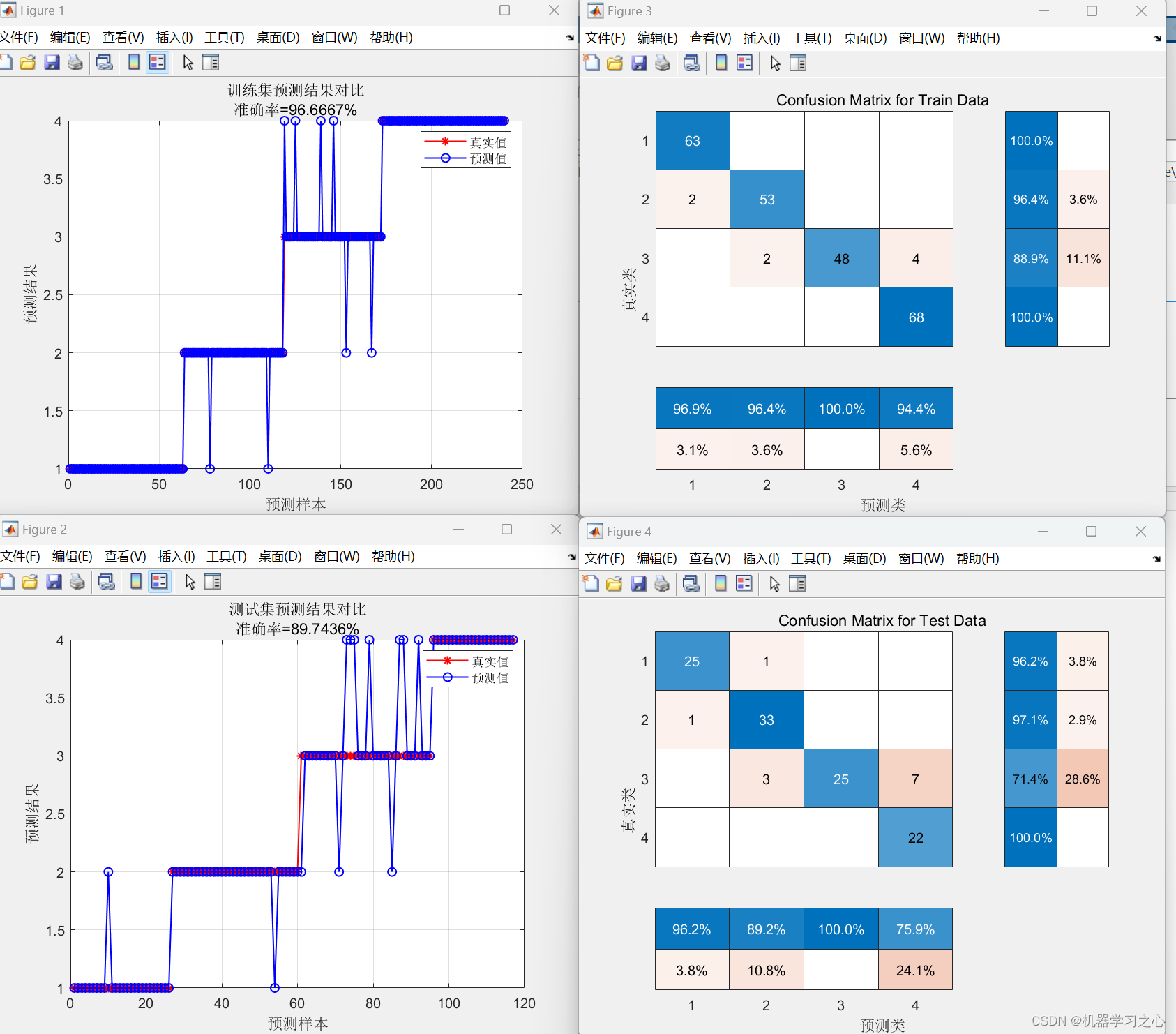

预测效果

基本介绍

Matlab实现GA-LSSVM遗传算法优化最小二乘支持向量机多输入单输出回归预测(完整源码和数据)

1.Matlab实现GA-LSSVM遗传算法优化最小二乘支持向量机多输入单输出回归预测(完整源码和数据);

2.评价指标包括:R2、MAE、MSE、RMSE和MAPE等。

3.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。

4.适用对象:大学生课程设计、期末大作业和毕业设计。

模型描述

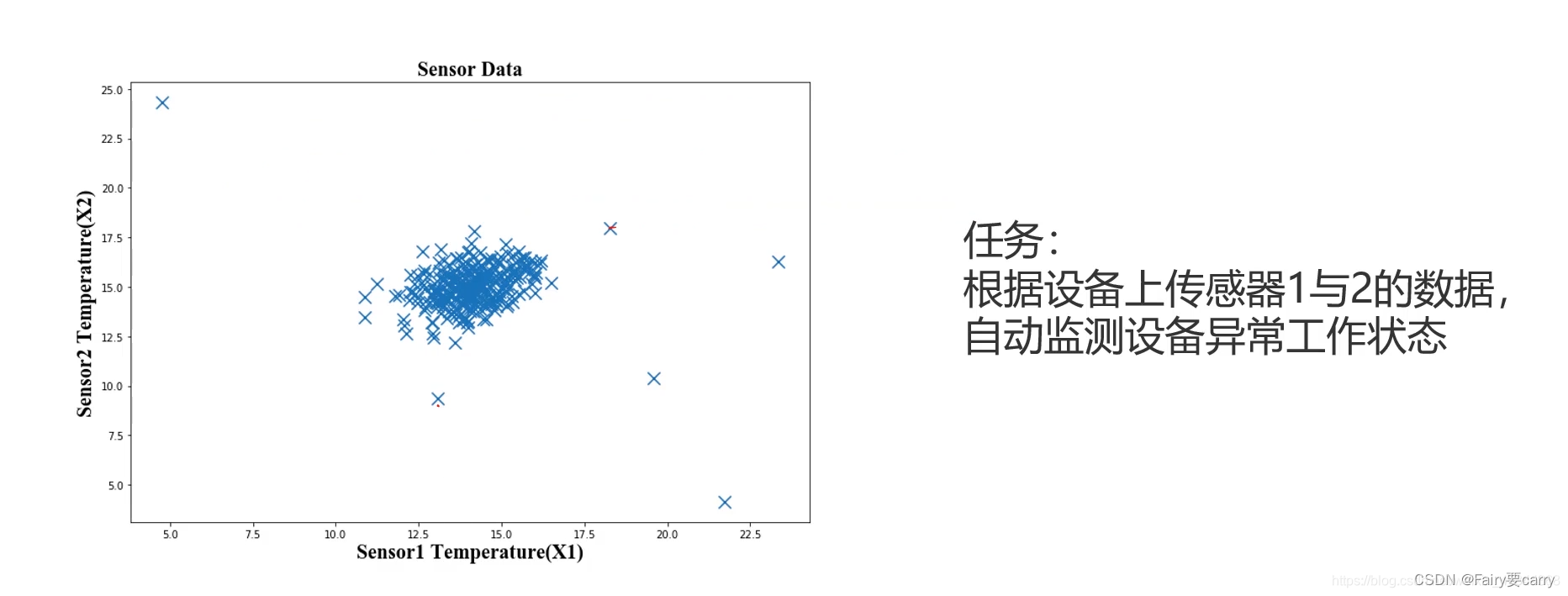

GA-LSSVM(Genetic Algorithm-Least Squares Support Vector Machine)是一种基于遗传算法优化的最小二乘支持向量机(Least Squares Support Vector Machine)用于多输入单输出回归预测的方法。

遗传算法是一种模拟自然进化过程的优化算法,它通过模拟遗传、交叉和变异等操作来搜索最优解。在GA-LSSVM中,遗传算法用于搜索最优的最小二乘支持向量机的参数配置,以使回归模型的性能最佳。

以下是GA-LSSVM的基本步骤:

初始化种群:使用遗传算法创建一个初始的个体群体,每个个体表示一个最小二乘支持向量机的参数配置。种群的大小和个体的编码方式需要根据具体问题进行设计。

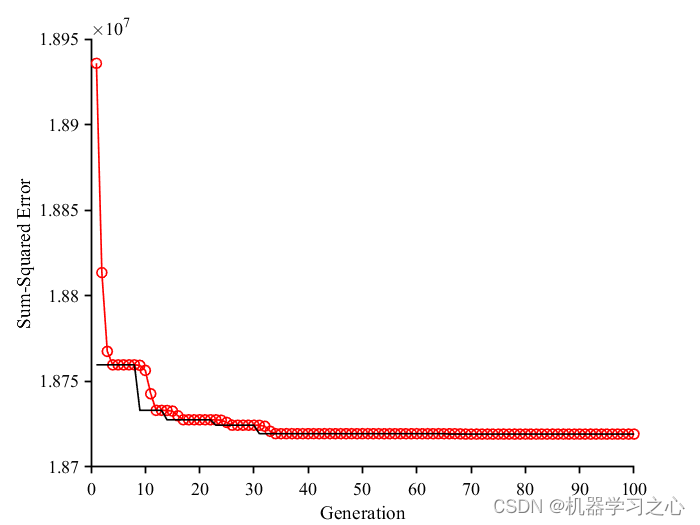

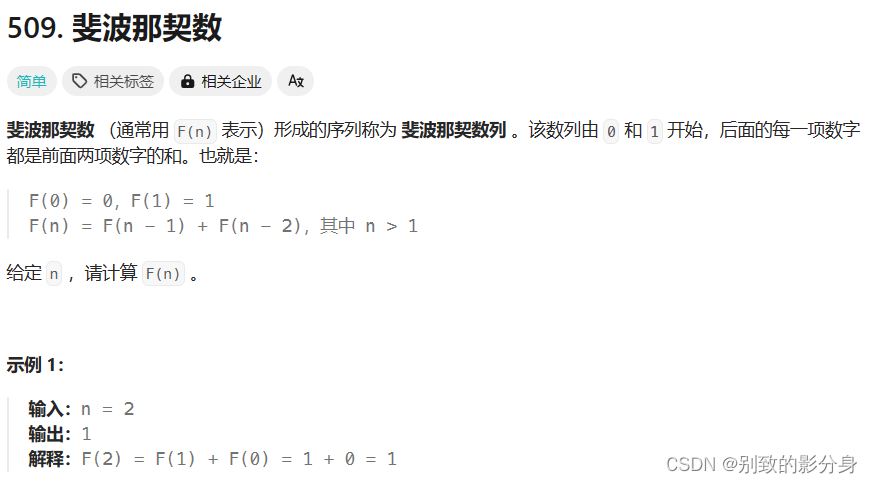

适应度评估:对于每个个体,使用最小二乘支持向量机建立回归模型,并评估其在训练集上的预测性能。适应度函数可以选择回归模型的均方误差(Mean Squared Error)或其他适当的指标。

选择操作:采用选择操作从种群中选择适应度较高的个体作为父代,用于产生下一代个体。选择操作可以使用轮盘赌选择、排名选择或其他选择算法。

交叉操作:对于选择的父代个体,使用交叉操作生成子代个体。交叉操作可以采用单点交叉、多点交叉或均匀交叉等方式。

变异操作:对于交叉后得到的子代个体,进行变异操作以增加种群的多样性。变异操作可以随机改变个体的某些参数值或者引入新的个体。

更新种群:将父代和子代个体合并,形成新的种群。

终止条件:根据预设的终止条件(如达到最大迭代次数或找到满意的解),判断是否终止算法。如果不满足终止条件,则返回第3步。

输出结果:当算法终止时,输出具有最佳适应度的个体作为最优的最小二乘支持向量机模型。

通过遗传算法的迭代优化过程,GA-LSSVM可以搜索到最优的最小二乘支持向量机模型参数,从而提高多输入单输出回归预测的性能。

程序设计

- 完整程序和数据下载方式(资源处直接下载):Matlab实现GA-LSSVM遗传算法优化最小二乘支持向量机多输入单输出回归预测

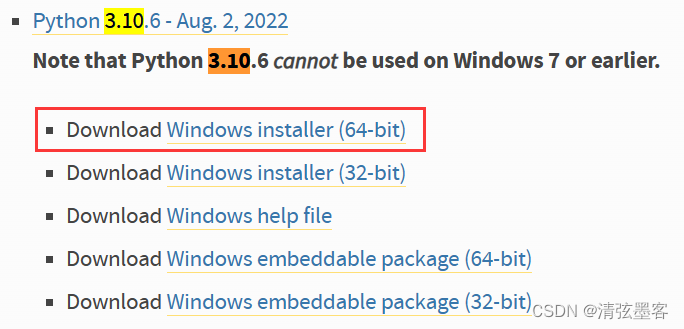

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 添加路径

addpath('LSSVMlabv\')

%% 导入数据

P_train = xlsread('data','training set','B2:G191')';

T_train= xlsread('data','training set','H2:H191')';

% 测试集——44个样本

P_test=xlsread('data','test set','B2:G45')';

T_test=xlsread('data','test set','H2:H45')';

%% 划分训练集和测试集

M = size(P_train, 2);

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 转置以适应模型

p_train = p_train'; p_test = p_test';

t_train = t_train'; t_test = t_test';

%% 参数设置

pop = 5; % 种群数目

Max_iter = 50; % 迭代次数

dim = 2; % 优化参数个数

lb = [10, 10]; % 下限

ub = [1000, 1000]; % 上限

%% 优化函数

fobj = @(x)fitnessfunclssvm(x, p_train, t_train);

%% 优化

[Best_pos, Best_score, curve] = GA(pop, Max_iter, lb, ub, dim, fobj);

%% LSSVM参数设置

type = 'f'; % 模型类型 回归

kernel = 'RBF_kernel'; % RBF 核函数

proprecess = 'preprocess'; % 是否归一化

参考资料

[1] https://blog.csdn.net/article/details/126072792?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/article/details/126044265?spm=1001.2014.3001.5502