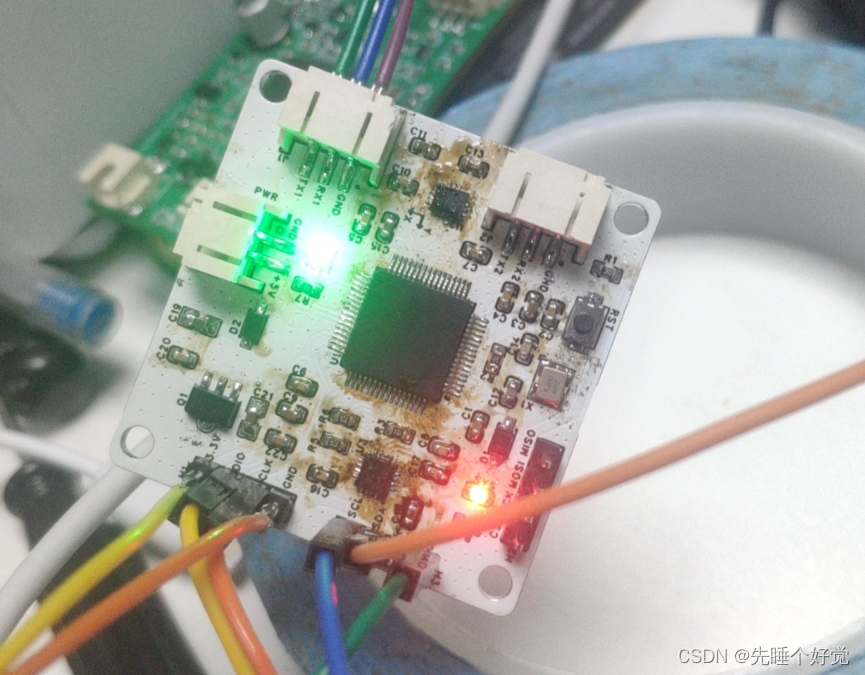

大语言模型(LLM)是目前炙手可热的话题,每个人都想体验一下大语言模型的魅力。然而如果使用云端的大语言模型服务,则不仅速度慢,而且可能泄露自己的隐私。幽兰代码本使用瑞芯微公司推出的 RK3588 SoC 芯片作为核心硬件, RK3588除了8个CPU核心,还具有ARM G610 MP4 GPU,以及高达6 TOPs算力的NPU,为本地安装大语言模型提供了可能。

我们选择了 Ollama 作为本地运行大语言模型的工具。Ollama是一个开源的大语言模型服务工具,支持Llama 3、Phi 3、Mistral、Gemma 和其他多种大语言模型,并且支持 MacOS,Linux,以及 Windows 多种操作系统。Ollama通过一个配置文件极大地简化了管理LLM的过程,使得用户能够快速地在本地运行大型语言模型。Ollama安装步骤极其简单,使用时执行一条命令即可。

详细的安装和配置步骤请参考这里:

https://www.nanocode.cn/wiki/docs/youlan/ai_Ollama

运行命令

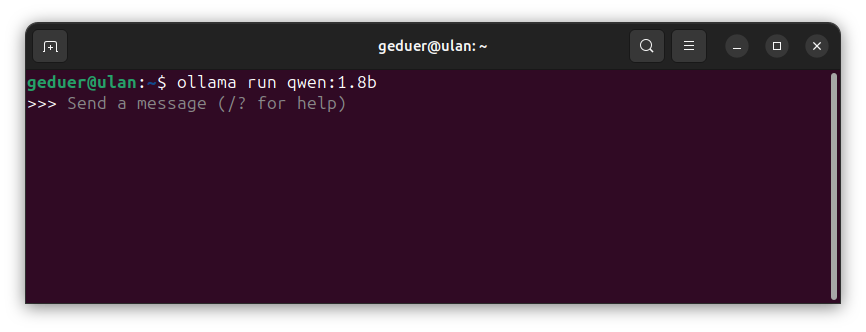

大语言模型我们选择了阿里开发的 Qwen 1.8b,你也可以尝试其他版本或者其他模型。使用下面的命令即可:

ollama run qwen:1.8b

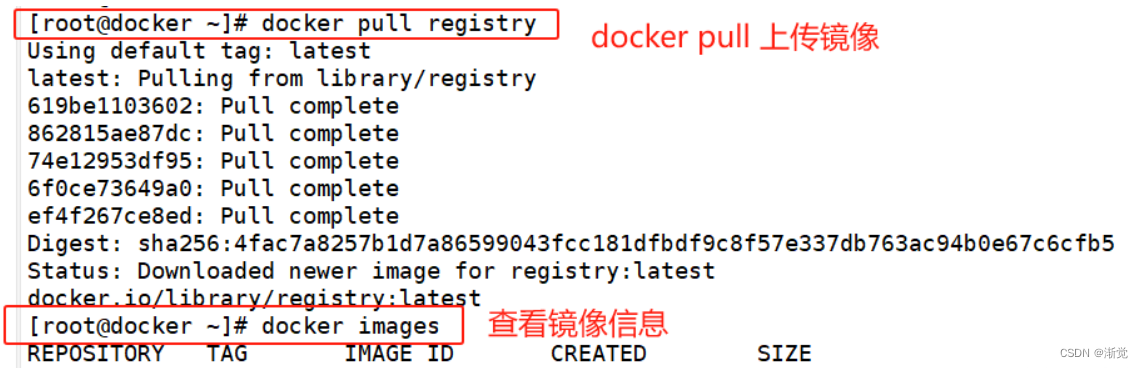

第一次运行该命令时,由于要下载模型文件,所以时间较长,但一旦下载成功,后续使用就不再需要下载,而是直接进入会话模式:

当看到这个画面时,我们就可以跟它对话了。

人机对话

我先从简单的问题开始。我问的第一个问题是,请计算 25+35。它很快给出答案 60。

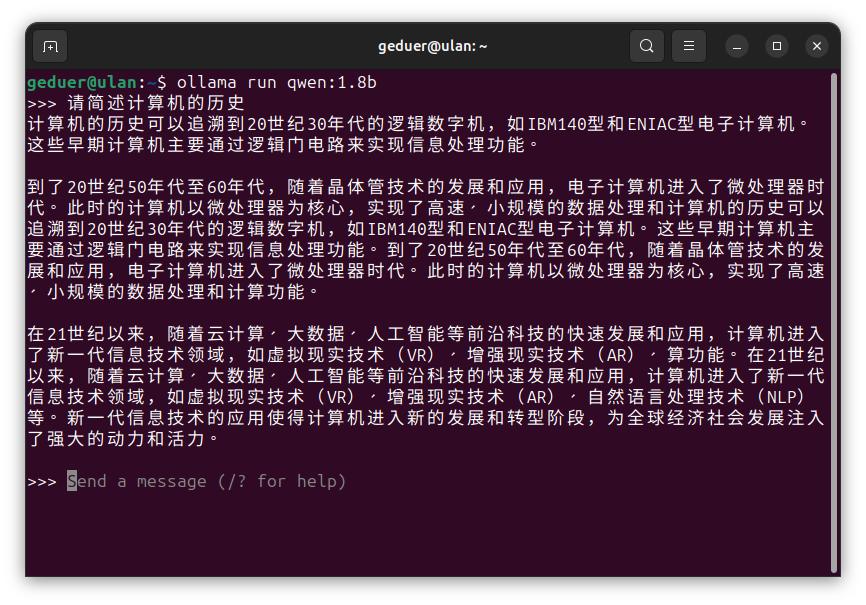

我的第二个问题是 “请简述计算机的历史”,它的回答涵盖了几个大的阶段,从 逻辑数字机,到 晶体管计算机,再到 云计算、大数据、人工智能,可以说,这的确涵盖了整个计算机的历史。但如果仔细看就会发现,中间还是有一小段的重复 ^_^

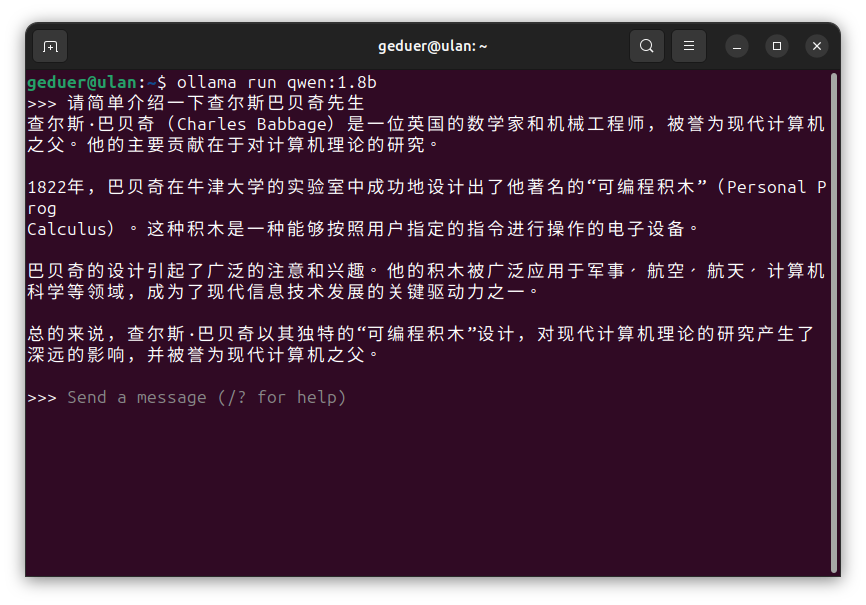

接下来,我想了解一下它对历史人物的掌握程度,我想让它介绍一下查尔斯·巴贝奇(Charles Babbage)先生。之所以想到这个人物,因为巴贝奇对计算机的发明做出了极其重要的贡献,但现实生活中却很少有人提到他,所以我想看看这个大模型是否了解这个人物。它给出的答案是相当简洁的,并没有提到他发明了差分机和分析机等重要的仪器,答案中提到的 “可编程积木”(Personal Prog Calculus),似乎也不太准确。我查阅了一些文献,并没有看到这个东西。

得出结论

我还问了很多其他的问题。总的来说速度不是问题,基本都能在2~3秒内回答。但就正确率而言,不得不说,大语言模型,或者更一般的说,人工智能,还有很长的一段路要走,因为有些问题,它的回答存在严重的错误。比如,我让它用C语言写一段冒泡排序的代码,它几次给出的答案都不完全一样,而且每次都有很明显的错误。这也从一个侧面再次印证了,AI 要能完全代替人类,还有很长的路要走,那些认为现在学习编程已经过时的想法是完全错误的。

但不管怎么说,AI 和大语言模型已经离我们很近,尽管存在瑕疵,但依然充满希望。能够在本机体验大模型,真的很方便、很有趣。

关于幽兰本的介绍,请看这里。

![[MRCTF2020]Ez_bypass1 and [网鼎杯 2020 青龙组]AreUSerialz1()php语言基础学习,以及序列化概念的基本了解](https://img-blog.csdnimg.cn/direct/3ee6f226719f439091011e1f7c6de2d1.png)