在深度学习领域,Transformer模型因其卓越的性能而广受欢迎,但其复杂的架构也带来了训练时间长和参数数量多的挑战。ETH Zurich的研究人员Bobby He和Thomas Hofmann在最新研究中提出了一种简化的Transformer模型,通过移除一些非必要的组件,不仅减少了模型的参数数量,还提高了训练速度,同时保持了与传统Transformer相当的性能。

传统Transformer模型自从2017年由Vaswani等人提出后,已成为深度学习中的重要基石,尤其在自然语言处理(NLP)领域发挥着举足轻重的作用。这种模型通过堆叠多个相同的构建块来形成深层网络,每个构建块内部则由多个精密排列的组件构成,包括用于捕捉序列内依赖关系的注意力机制、用于增加模型表达能力的多层感知机(MLP)子块、用于辅助训练的跳跃连接,以及用于稳定训练过程的标准化层。

然而,这些复杂的组件也带来了一些挑战。首先,模型的参数数量庞大,导致训练和部署成本较高。其次,复杂的结构可能导致训练过程不稳定,需要精心设计的优化策略和超参数调整。针对这些问题,ETH Zurich的Bobby He和Thomas Hofmann在他们的研究中提出了一种简化的Transformer模型,旨在通过移除一些组件来降低模型的复杂性,同时保持或提升训练效率和性能。

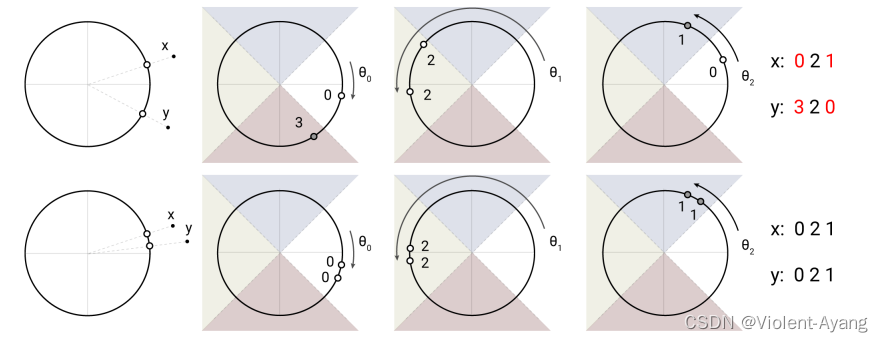

他们的工作基于两个主要的理论基础和实证发现:信号传播理论和实验观察。信号传播理论研究了在神经网络初始化时,层间表示的信息如何演化,这对于理解网络深度和宽度对训练动态的影响至关重要。He和Hofmann利用这一理论来指导他们对Transformer块的简化,特别是关注了如何通过调整注意力矩阵和MLP子块来改善信号传播。

在实证观察方面,他们发现在训练过程中,一些组件(如跳跃连接、投影/值参数)并没有被充分利用,或者可以通过其他方式(如下权重的残差连接或改变注意力矩阵的初始化)来替代其功能。基于这些发现,他们提出了一种简化的Transformer块,该块去除了以下组件:

- 跳跃连接:在标准的Transformer块中,跳跃连接有助于信号绕过一些层直接传播,但研究发现可以通过调整注意力机制和MLP的初始化来补偿去除跳跃连接后的影响。

- 投影/值参数:在自注意力机制中,通常包含可训练的查询(Q)、键(K)和值(V)参数。He和Hofmann的研究表明,可以将值和投影参数固定为恒等矩阵,从而简化模型并减少参数数量。

- 序列子块:标准Transformer块中的注意力和MLP子块是顺序执行的。通过并行化这些子块,可以进一步提高训练的吞吐量。

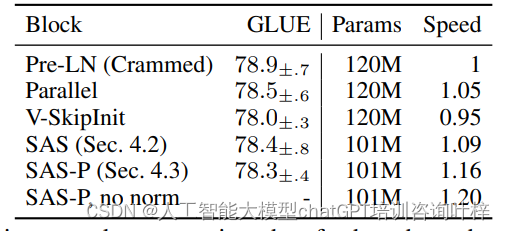

- 标准化层:虽然标准化层对于稳定训练过程至关重要,但研究表明,在某些情况下可以去除标准化层,而通过对其他参数的适当初始化和调整来保持训练的稳定性。 通过这些简化,He和Hofmann的模型在保持与标准Transformer相当的性能的同时,大幅减少了参数数量和训练时间。在自回归解码器仅模型和BERT编码器仅模型上的实验结果表明,简化后的模型在每次更新的训练速度上与传统模型相当,训练吞吐量提高了15%,使用的参数减少了15%。 这项工作的意义在于,它不仅为设计更高效的深度学习模型提供了新的思路,而且通过减少模型的复杂性和计算成本,有助于推动深度学习技术在更广泛的应用场景中的部署。此外,这项研究还为理解深度神经网络训练动态提供了新的见解,可能会激发未来在深度学习理论和实践方面的进一步创新。

实验验证 研究人员在自回归解码器仅模型和BERT编码器仅模型上进行了实验,结果表明,简化后的Transformer模型在每次更新的训练速度和性能上与标准Transformer相当,同时训练吞吐量提高了15%,使用的参数减少了15%。

简化Transformer模型的工作不仅在理论上具有重要意义,有助于缩小深度学习理论与实际应用之间的差距,而且在实际应用中具有潜在的节省成本的优势。这项研究可能会促使更简单的架构在实践中得到应用,从而降低大型Transformer模型的部署成本。

未来研究方向 尽管简化的Transformer模型在中小规模模型上表现出色,但其在更大规模模型上的性能尚未得到验证。此外,研究中提到的简化模型是否能够与更优化的硬件实现和超参数调整相结合以获得更好的性能,也是一个值得进一步探索的方向。