在人工智能领域,大模型(Large Language Models,简称LLM)因其强大的语言理解和生成能力而备受关注。然而,这些模型的下载通常面临两大挑战:访问限制和文件体积庞大。本文将介绍几种快速下载大模型的方法,并提供相应的下载链接。

对于国内的用户来说,直接从Hugging Face官网下载大模型可能会遇到访问困难,加之模型文件巨大,下载过程缓慢且耗流量。为了解决这一问题,我们可以考虑以下几种替代方案。

1. 阿里魔搭社区下载

阿里魔搭社区提供了一个下载模型的途径,但需要注意的是,并非所有模型都能在魔搭社区中找到。如果模型存在于魔搭社区,可以通过以下代码进行下载:

from modelscope.hub.snapshot_download import snapshot_download

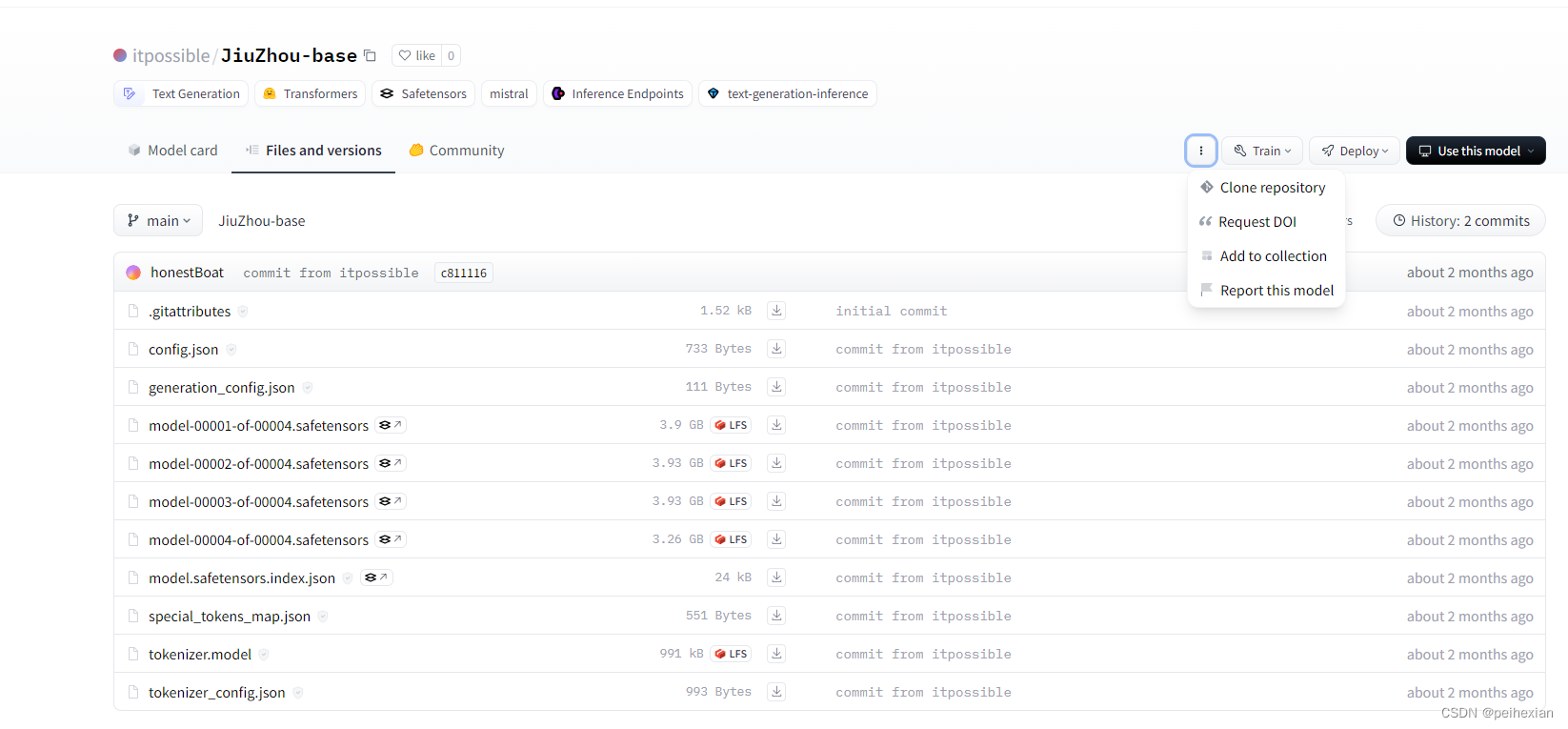

model_dir = snapshot_download('qwen/Qwen-7B', cache_dir='./model_dir', revision='master')2. Huggingface镜像网站下载

除了官方渠道外,还可以通过Huggingface的镜像网站进行下载。一个推荐的镜像网站是:https://hf-mirror.com。使用镜像网站下载前,需要设置环境变量以指定镜像站点地址:

export HF_ENDPOINT=https://hf-mirror.com然后,可以使用Huggingface的snapshot_download函数来下载模型:

from huggingface_hub import snapshot_download

snapshot_download(repo_id='Qwen/Qwen-7B', repo_type='model', local_dir='./model_dir', resume_download=True)3. 通过代码下载大模型的整体方法

如果需要通过编程方式下载大模型,可以使用Huggingface的Python库。首先,确保安装了transformers库,然后使用以下代码:

from transformers import AutoModel

model = AutoModel.from_pretrained('model_repo_id')以上就是快速下载大模型权重文件的几种方法。使用阿里魔搭社区或Huggingface镜像网站可以有效地解决访问和速度问题。希望这些信息能够帮助到需要下载和使用大模型的研究人员和开发者。