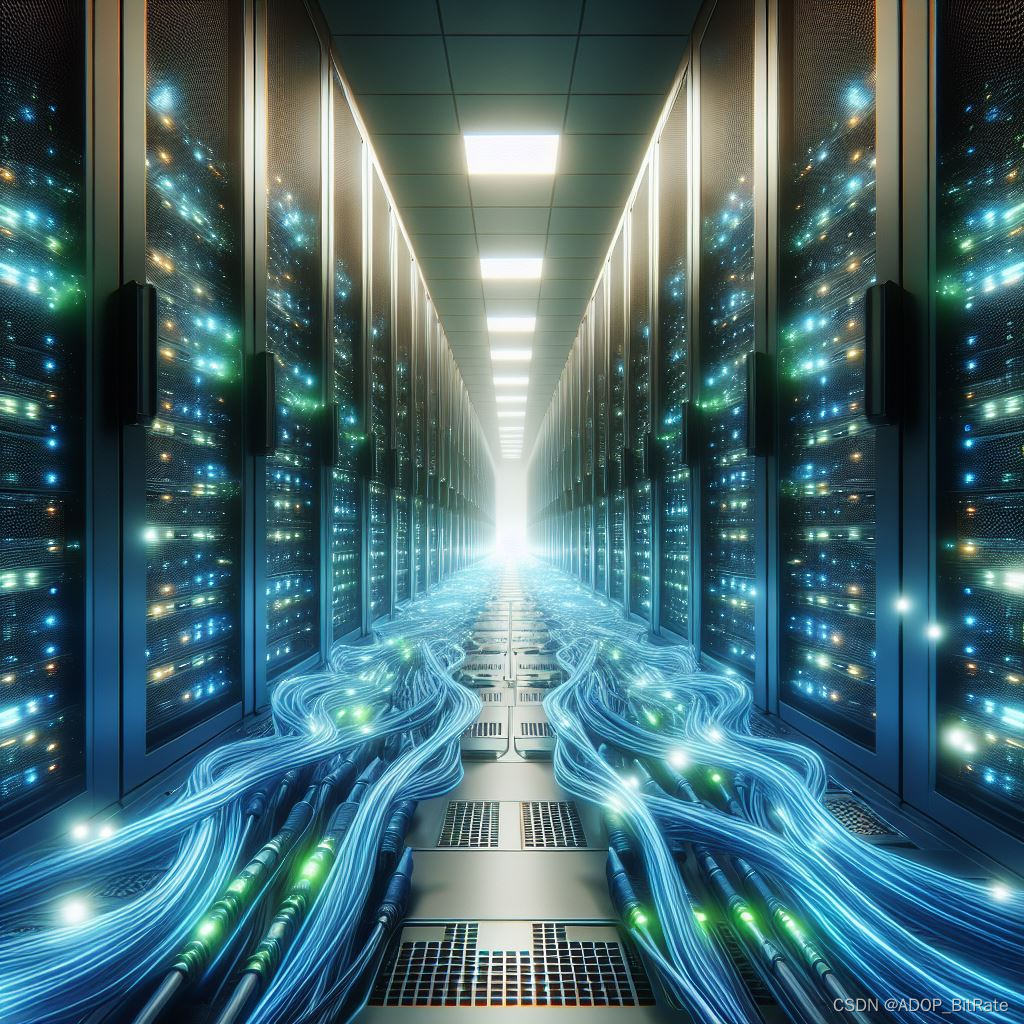

InfiniBand(简称IB)是一种用于高性能计算的计算机网络通信标准,它具有极高的吞吐量和极低的延迟。它不仅用于计算机之间的数据互连,也用作服务器与存储系统之间,以及存储系统之间的直接或交换互连。

InfiniBand的主要特点包括:

🔊高吞吐量:InfiniBand提供的带宽远高于传统以太网,适合大规模数据传输。

🔊低延迟:InfiniBand的设计优化了数据传输的延迟,对于延迟敏感的应用非常重要。

🔊可扩展性:InfiniBand支持构建大型和复杂的网络拓扑结构,适合高性能计算和数据中心。

🔊网络计算:InfiniBand支持网络计算功能,可以卸载部分计算任务到网络硬件,减轻主机CPU的负担。

InfiniBand广泛应用于超级计算机、科学研究、人工智能和云数据中心等领域,尤其是在那些对性能要求极高的环境中

InfiniBand的工作原理是什么?

InfiniBand(IB)的工作原理涉及到高速数据传输、低延迟和可扩展性。以下是InfiniBand的一些关键特点和工作原理:

🔊物理层:InfiniBand使用高速电缆(光纤或铜线)来连接计算机节点。这些电缆支持高吞吐量和低延迟的数据传输。

🔊拓扑结构:InfiniBand支持多种拓扑结构,包括点对点、树状、环形和网状。这使得它适用于不同规模的计算机集群。

🔊交换式网络:InfiniBand网络采用交换式网络拓扑,其中交换机负责路由数据包。这有助于减少网络拥塞和提高性能。

🔊RDMA(远程直接内存访问):InfiniBand支持RDMA,允许计算机节点直接访问其他节点的内存,而无需CPU的干预。这降低了延迟并提高了吞吐量。

🔊虚拟化支持:InfiniBand可以在虚拟化环境中使用,支持虚拟机之间的高性能通信。

🔊子网管理:InfiniBand网络可以划分为多个子网,每个子网可以有自己的拓扑结构和管理策略。

总之,InfiniBand通过高速数据传输、低延迟和灵活的拓扑结构,为高性能计算和数据中心提供了一种强大的互连技术。

InfiniBand作为一种高性能计算和数据中心互连技术,具有一些优点和缺点:

优点:

🔊高吞吐量和低延迟:InfiniBand的设计目标之一是提供高速数据传输和极低的延迟。这使其在大规模计算机集群中表现出色。

🔊RDMA支持:远程直接内存访问(RDMA)允许节点之间直接访问彼此的内存,无需CPU干预。这降低了通信延迟并提高了吞吐量。

🔊灵活的拓扑结构:InfiniBand支持多种拓扑结构,包括点对点、树状、环形和网状。这使其适用于不同规模和需求的系统。

🔊虚拟化支持:InfiniBand可以在虚拟化环境中使用,支持虚拟机之间的高性能通信。

🔊子网管理:InfiniBand网络可以划分为多个子网,每个子网可以有自己的拓扑结构和管理策略。

缺点:

🔊成本较高:InfiniBand设备和基础设施的成本通常较高,这可能限制了一些小型系统的采用。

🔊市场份额较小:尽管在超级计算机领域有一定份额,但InfiniBand在通用数据中心中的市场份额相对较小。

🔊不适用于所有应用:InfiniBand适用于高性能计算、大规模数据处理和存储系统,但对于一般企业应用,以太网可能更常见。

总之,InfiniBand在高性能计算和特定数据中心场景下具有明显的优势,但在其他情况下,需要权衡其成本和性能。

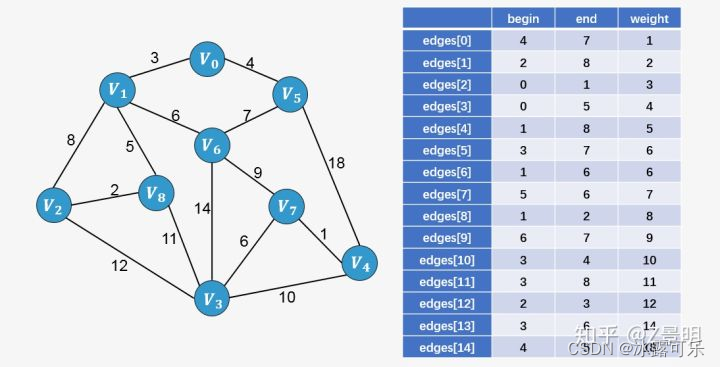

关于InfiniBand的拓扑结构:

InfiniBand的拓扑结构非常灵活,支持多种不同的配置,以适应各种规模和需求的网络环境。以下是一些常见的InfiniBand拓扑结构:

🔊树状拓扑 (Tree Topology):

树状拓扑是一种层次化的结构,由一个或多个中心节点(根节点)向下分支,形成树枝状的网络。

这种结构易于管理和扩展,但中心节点可能成为性能瓶颈。

🔊星型拓扑 (Star Topology):

星型拓扑中,所有节点都直接连接到一个中心交换机。

这种结构简化了网络设计,但中心交换机的故障会影响整个网络。

🔊网状拓扑 (Mesh Topology):

网状拓扑中,节点之间有多条路径连接,可以提供多个数据传输路径,增加了网络的容错能力。

这种结构适合于要求高可靠性的环境。

🔊全局互连网络 (Fat-Tree Topology):

全局互连网络是一种特殊的树状拓扑,它通过增加交换机之间的链接数量来提高带宽和降低延迟。

这种结构在大型高性能计算环境中非常常见。

🔊扁平结构 (Flat Topology):

扁平结构中,所有节点都在同一层级上,每个节点都可以与其他任何节点直接通信。

这种结构在小型网络或特定应用中使用。

InfiniBand的拓扑结构可以根据应用需求和规模进行灵活配置和扩展,从而优化性能和成本。

InfiniBand 是一种高性能网络通信技术,它以极低的延迟而闻名。InfiniBand的延迟可以低至 0.7微秒1,这比传统以太网的延迟要低得多。例如,特定类型的以太网交换机的端口到端口延迟为 230纳秒,而具有相同端口数量的InfiniBand交换机的延迟仅为 100纳秒2。

此外,InfiniBand网卡的收发时延(write,send)大约在 600纳秒,而基于Ethernet上的TCP/UDP应用的收发时延会在 10微秒左右,相差十几倍之多。

这种低延迟特性使得InfiniBand非常适合于需要快速数据传输和处理的应用场景,如高性能计算、人工智能、数据中心和科学研究等领域。