笔记整理:郭荣辉,天津大学硕士,研究方向为知识图谱

链接:https://aclanthology.org/2023.acl-long.597/

1、引言

本文发现基于消息传递机制的模型在KGC任务中,消息传递并不是KGC性能提升的最主要原因。

由于KGs固有的图结构,图神经网络( Graph Neural Networks,GNNs )被用来学习实体和关系的嵌入,从而促进KGC。现有的基于MPNN的GNN模型通过在图上的消息传递( Message Passing,MP )过程来更新节点特征,其中每个节点从其邻居收集并转换特征。本文发现,将RGCN、CompGCN和KBGAT模型中的MP替换为简单的MLP,仍然达到了相当的性能。更进一步的,本文仔细研究了这些基于MPNN的模型,发现它们在其他关键组件,如评分函数和损失函数方面也有所不同。为了更好地研究这些组件对模型的贡献,本文进行了综合实验来证明每个组件的有效性。结果表明,评分函数和损失函数的影响更大,而 MP 几乎没有贡献。基于此研究结果,本文开发了建立在 MLP 基础上的集合模型,与基于 MPNN 的模型相比,这些模型能够获得更好的性能;考虑到 MLP 相对于 MPNN 在可扩展性方面的优势,这些研究结果在实践中具有强大的意义。

2、什么影响了MPNN-based KGC?

为了探究MPNN-based中MP、scoring function和loss function对模型表现的影响,本文设计了精心的实验,在多个数据集中消融 RGCN、CompGCN 和 KBGAT 中对这些成分的选择,以了解它们的作用。

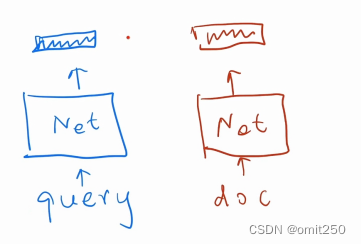

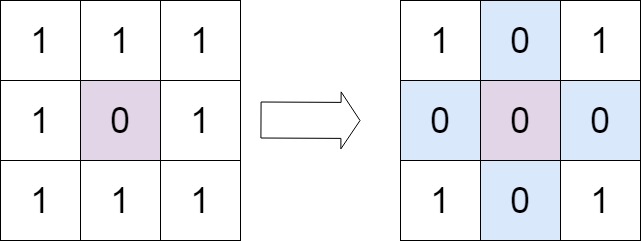

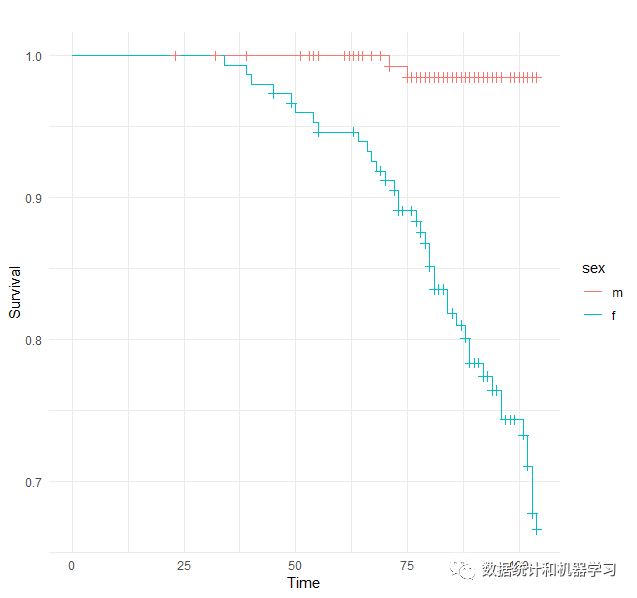

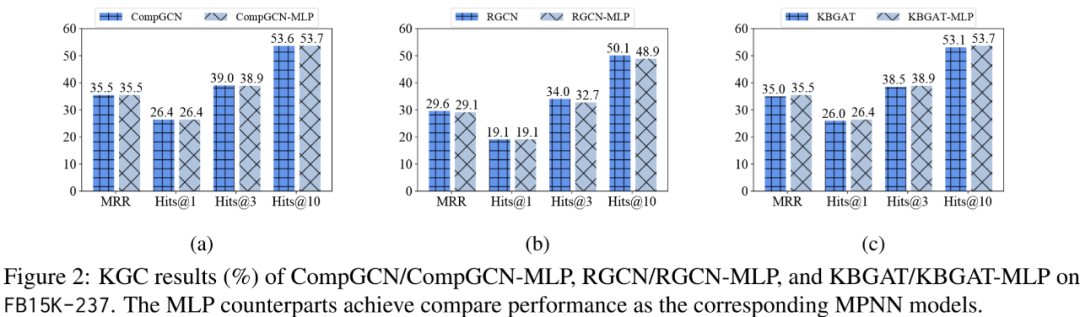

MP的影响

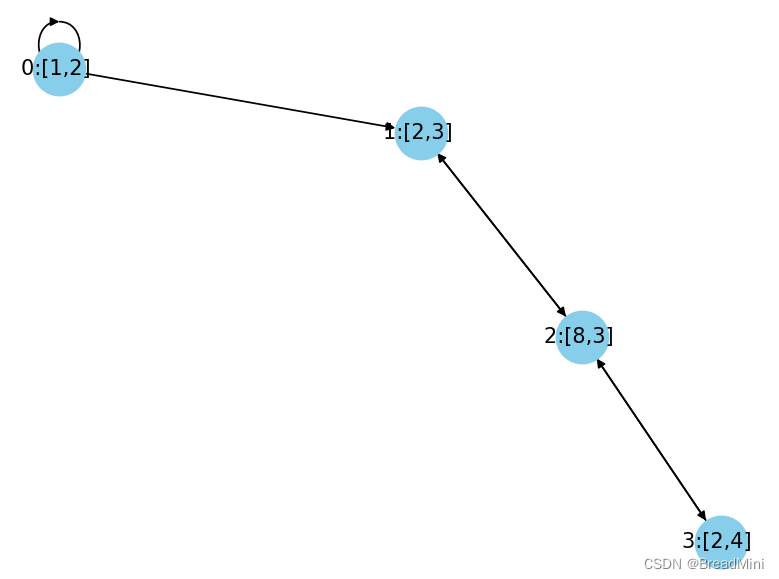

首先探索MP的影响,将MP中的邻接矩阵替换为恒等矩阵,实现结果如下。

可以看出,有无MP对于实验结果影响不大。

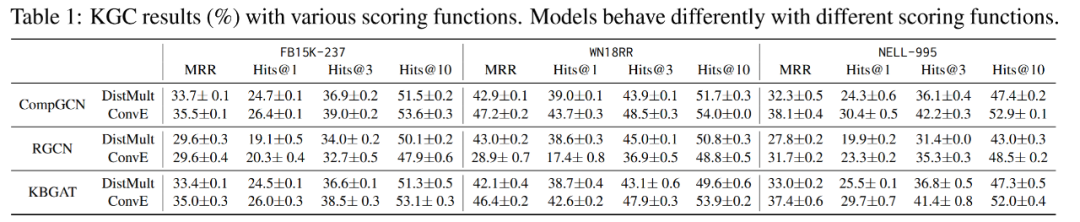

Scoring Function的影响

将不同的模型与不同评分函数组合,结果如下。

可以看出,评分函数对于模型表现有较大的影响。但是在某些场景下影响不大,也侧面反映出评分函数并不是影响模型性能的唯一因素。

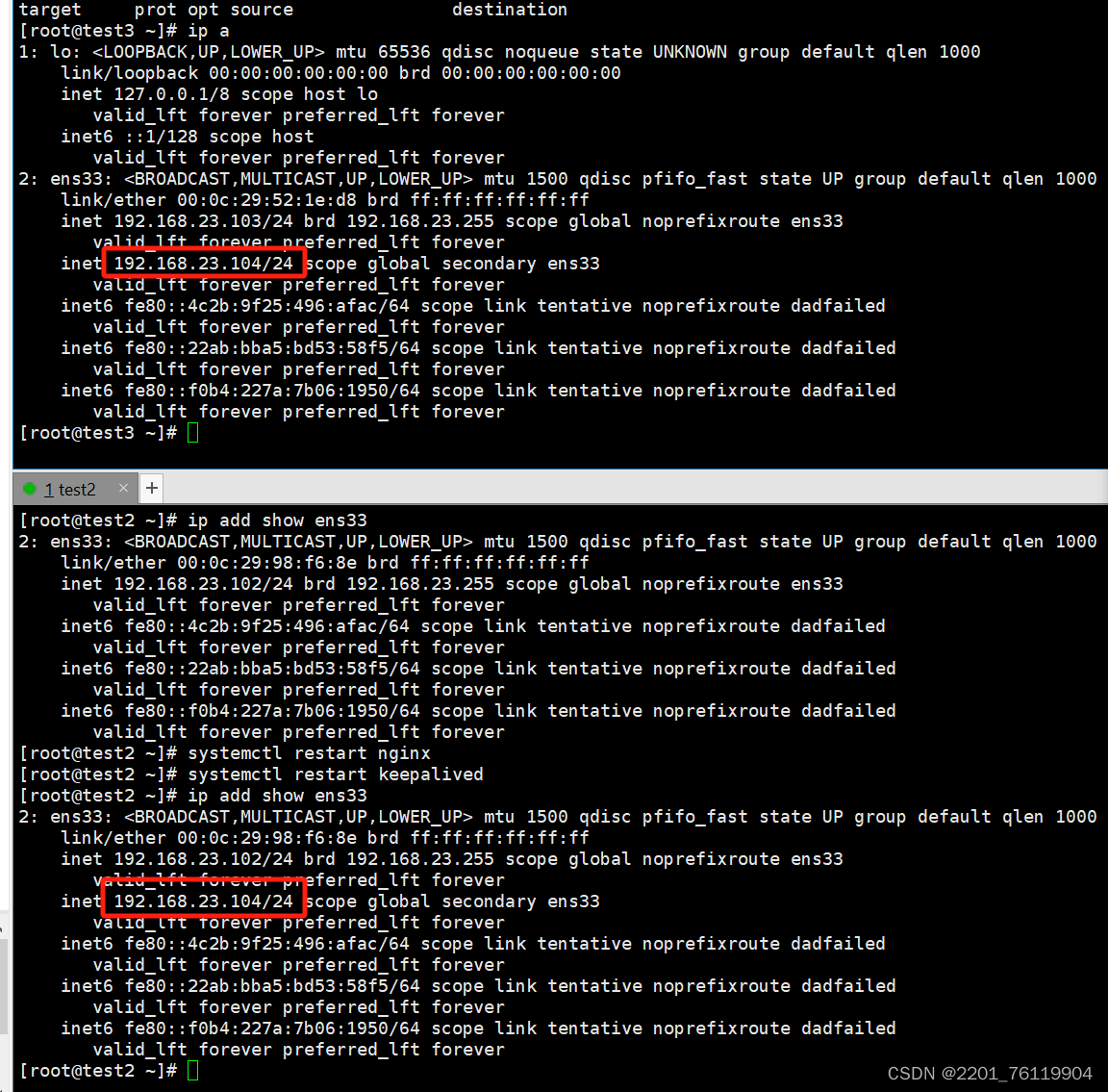

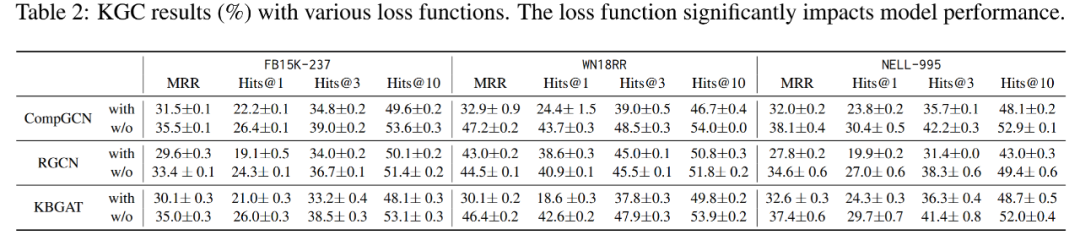

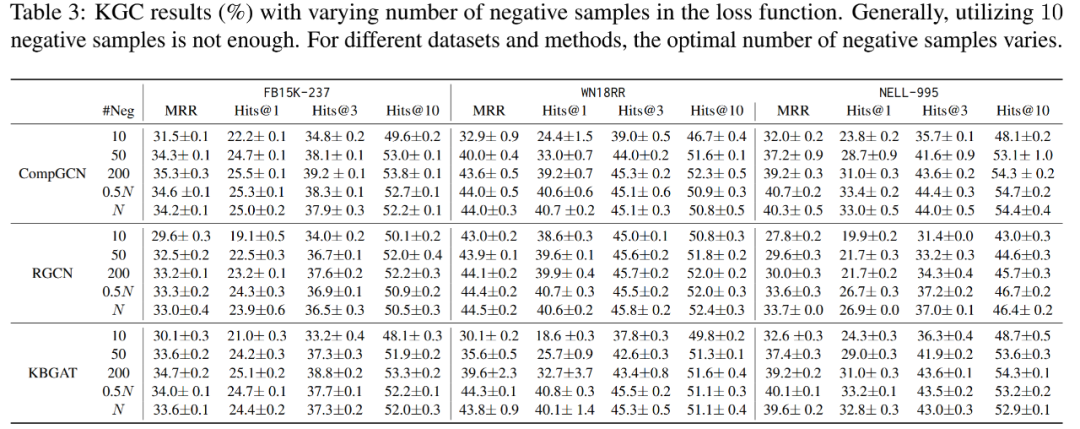

Loss Function的影响

在CompGCN, RGCN和KBGAT的原文设定中,都采用BCE loss,主要的区别在于不同数量负样本,因此探索了损失函数和不同数量负样本下的模型表现。

可以看出,不同的策略对于模型的表现影响非常大。

3、无信息传递的KGC

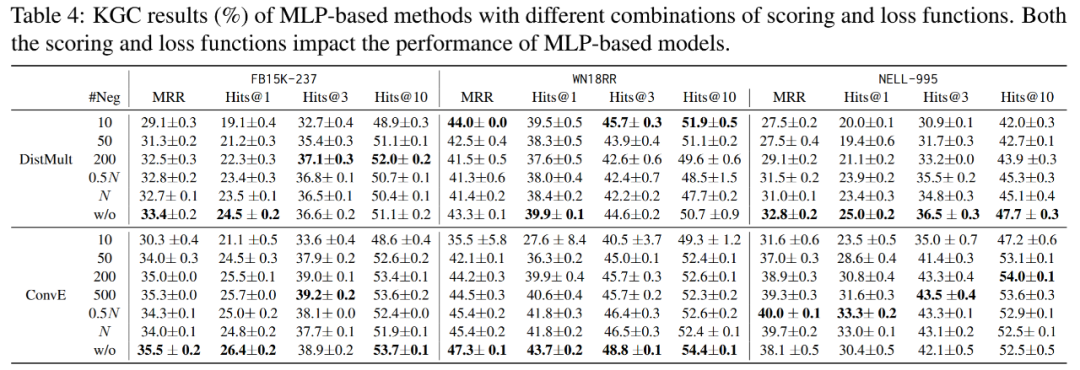

MP 是将 MPNN 扩展到大型图的关键瓶颈,且前文分析表明MP对KGC可能没有帮助。因此,本节主要研究基于MLP的KGC方法,从而获得与现有MPNN方法相当甚至更好的性能。此外,基于MLP方法相比于MPNN更加高效。下面分别研究评分和损失函数对基于MLP方法的影响。

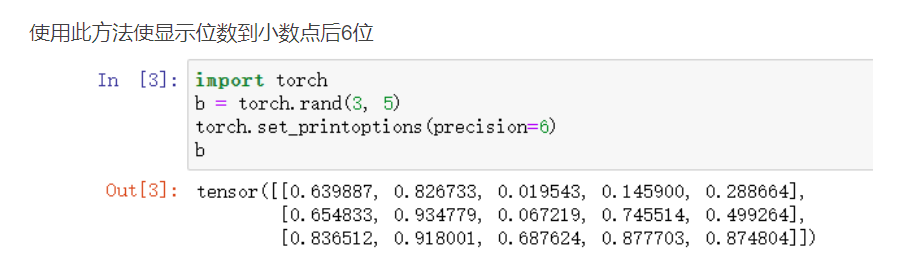

组合各种评分和损失函数的MLP方法

将不同的评分函数与不同的负采样方式组合,得到如下表格。

可能有以下观察(1)MP对于KGC来说是不必要的,基于MLP的模型可以达到与GNN模型相当甚至更好的表现(2)评分和损失函数在KGC的性能中起着至关重要的作用。

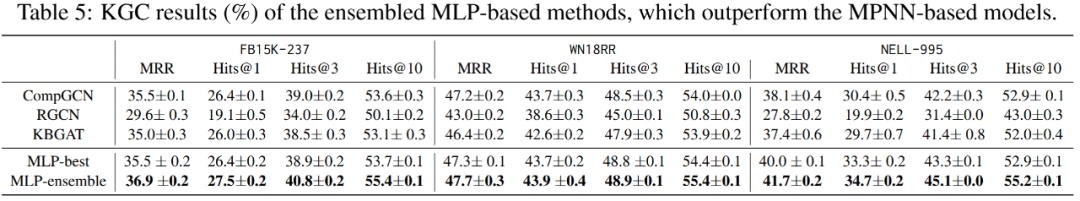

鉴于此,下面探究了一种简单的集成策略来组合不同的基于MLP的模型,以探索是否可以获得一个强大且复杂度有限的模型,同时其可以在没有MP的情况下对各种数据集表现良好。

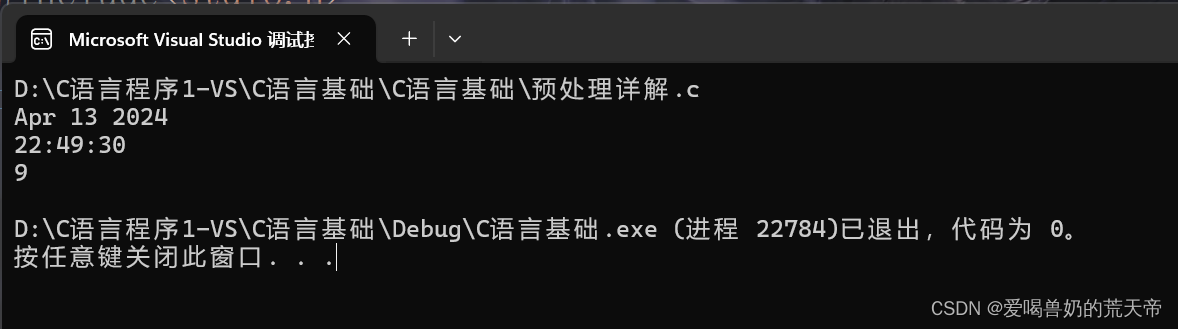

Ensembling MLPs

基于MLP的模型受到评分和损失的影响,表明这些具有不同得分函数和损失函数组合的模型可以从不同角度捕获重要信息。因此,这些模型的集成可以提供一个机会来组合来自不同模型的信息,以获得更好的性能。因此,本文选择了一些在验证集上表现出相对较好性能的基于MLP的模型,并将它们集成用于最终的预测。这些选择的模型先被单独训练,然后组装在一起进行推理。

从表中我们可以清楚地看到,MLP-best 的性能与基于 MPNN 的方法相当,甚至略胜一筹。此外,MLP-ensemble 比基于 MLP 的最佳单个方法和基于 MPNN 的模型都能获得更好的性能,尤其是在 FB15K-237 和 NELL-995 上。这些观察结果进一步证明了 MP 组件并非必要。它们还表明,这些评分和损失函数具有潜在的互补性,因此,即使是简单的集合方法也能产生更好的性能。

4、讨论

关键发现

1.基于MPNN的方法中的MP成分对KGC的性能没有显著的贡献,而基于MLP的方法在没有MP的情况下可以达到相当的性能。

2.在基于MPNN和基于MLP的方法中,评分和损失函数(即负抽样选择)的设计都起着至关重要的作用。

3.这些影响都显著依赖于数据集。

4.评分和损失函数的选择是互补的,在基于MLP的方法中结合它们的简单策略可以产生更好的KGC性能。

实验启发

1.基于 MLP 的模型不涉及复杂的 MP 过程,因此比基于 MPNN 的模型更高效。

2.基于 MLP 的模型的简单性和可扩展性使集合变得容易、可行和有效。

3.采用基于 MLP 的模型使我们能够更方便地应用现有技术来推进 KGC,如Neural Architecture Search (NAS)。

对未来研究的影响

1.研究更好的评分和损失函数设计是(目前)改善 KGC 的一条捷径。为完成这项任务,需要在基于 MPNN 的模型中开发合适的 MP 。

2.基于 MLP 的模型应作为未来 KGC 研究的默认基准。

3.评分和损失函数的选择具有互补性影响,设计更好的策略将它们结合起来是很有前景的。

4.由于 KGC 是一种链接预测,而许多研究在排序和推荐等重要场景中采用了 MPNN 设计,因此本文的工作促使人们迫切需要了解 MP 组件在这些应用中的作用。

5、总结

本文发现,与基于 MPNN 的三种模型(即 CompGCN、RGCN 和 KBGAT)相比,基于 MLP 的模型能够在各种数据集上实现具有竞争力的性能。这表明这些模型中的消息传递操作并不是实现强劲性能的关键因素。为了探索哪些组件对模型性能有潜在贡献,本文对评分函数和损失函数等其他关键组件进行了大量实验,发现这两个部分都起着至关重要的作用,而且它们对不同数据集的影响也大不相同。基于这些发现,本文进一步提出了建立在基于 MLP 模型基础上的集合方法,这种方法能取得比基于 MPNN 模型更好的性能。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。