淡淡相思 都写在脸上

沉沉离别背在肩上

泪水流过脸庞

所有的话 现在还是没有讲

看那青山 荡漾在水上

看那晚霞吻着夕阳

我用一生的爱 去寻找那一个家

今夜你在何方

转回头 迎着你的笑颜

心事全都被你发现

梦里遥远的幸福 它就在我的身旁

🎵 于春洋《梦里水乡》

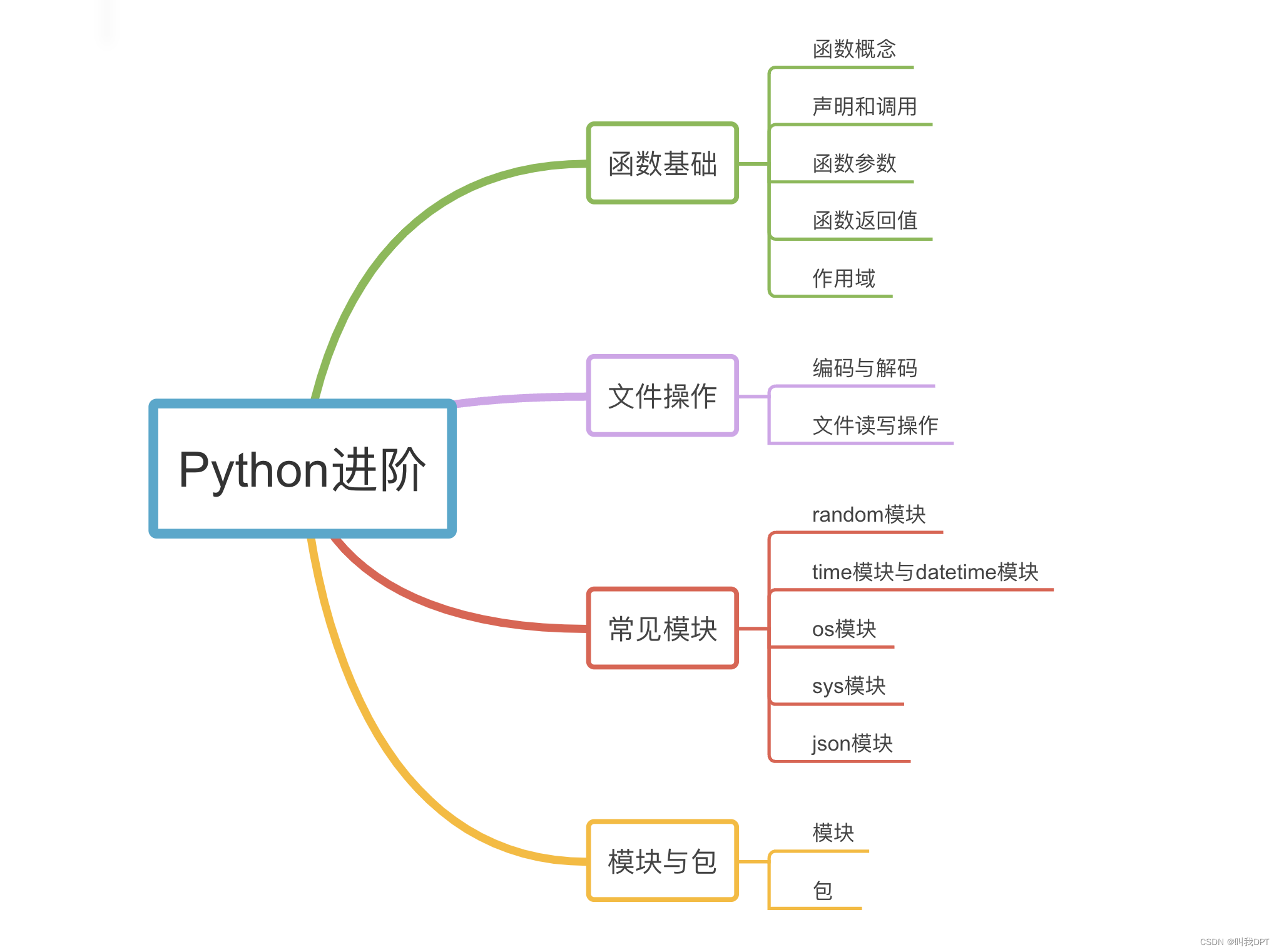

在数据科学、日志分析或任何需要处理大量数据的场景中,我们经常会遇到需要处理的文件大小超过了内存限制。幸运的是,Python提供了多种处理大文件的策略,让我们可以有效地读取、处理并切割这些文件。本文将探讨一些常用的大文件处理技术,并提供具体的Python示例代码。

为什么需要切割大文件

处理大文件时,最直观的挑战是内存限制。当文件大小超过可用内存时,尝试一次性加载整个文件将导致程序崩溃或性能下降。此外,切割大文件还有其他几个原因:

- 提高处理效率:通过并行处理多个较小的文件,可以显著提高数据处理的速度。

- 数据分析:在某些情况下,我们可能只对大文件中的一部分数据感兴趣。切割文件可以帮助我们更快地定位和分析这部分数据。

易于共享和传输:较小的文件比大文件更容易共享和传输。

切割文本文件

假设我们有一个大文本文件,每行一个记录,我们希望将其切割成多个小文件,每个文件包含一定数量的行。

示例代码

def split_text_file(file_path, line_count):

"""

将大文本文件切割成多个小文件,每个小文件包含指定行数的数据。

:param file_path: 大文件的路径

:param line_count: 每个小文件的行数

"""

with open(file_path, 'r') as file:

file_number = 1

current_line = 0

for line in file:

if current_line % line_count == 0:

if current_line > 0:

output_file.close()

output_file = open(f"{file_path}_part{file_number}.txt", 'w')

file_number += 1

output_file.write(line)

current_line += 1

output_file.close()

# 调用函数

split_text_file('large_file.txt', 1000) # 假设我们想每1000行切割一次

处理大JSON文件

对于大JSON文件,尤其是那些以JSON Lines格式存储的(每行一个JSON对象),我们可以采取类似的方法进行切割。

示例代码

import json

def split_json_file(file_path, object_count):

"""

将大JSON文件切割成多个小文件,每个小文件包含指定数量的JSON对象。

:param file_path: 大文件的路径

:param object_count: 每个小文件的JSON对象数量

"""

with open(file_path, 'r') as file:

file_number = 1

current_count = 0

output_file = open(f"{file_path}_part{file_number}.json", 'w')

for line in file:

if current_count >= object_count:

output_file.close()

file_number += 1

current_count = 0

output_file = open(f"{file_path}_part{file_number}.json", 'w')

output_file.write(line)

current_count += 1

output_file.close()

# 调用函数

split_json_file('large_file.json', 1000) # 假设我们想每1000个JSON对象切割一次

总结

处理和切割大文件是数据处理中常见的需求。Python通过提供对文件的逐行或逐个对象的读取能力,使得处理这类问题变得简单高效。通过上述示例,我们可以看到,无论是文本文件还是JSON文件,切割大文件的基本思路都是逐步读取并根据需求写入到新的文件中。掌握这些

![[C语言]——动态内存经典笔试题分析](https://img-blog.csdnimg.cn/direct/ef03f5a22f4d461fb62302cffb7d86a5.png)