目前国内大语言模型犹如雨后春笋一样在神州大地生长,结合目前的政策形势,人工智能将迎来爆发式增长,目前发展状况通用大语言模型的部署将越来越容易,且能力将越来越强。但通用大模型如何赋能各行各业打造垂直大模型的应用呢?我想谈谈我对大语言模型本地化部署的几个思路:

一、直接部署大语言模型

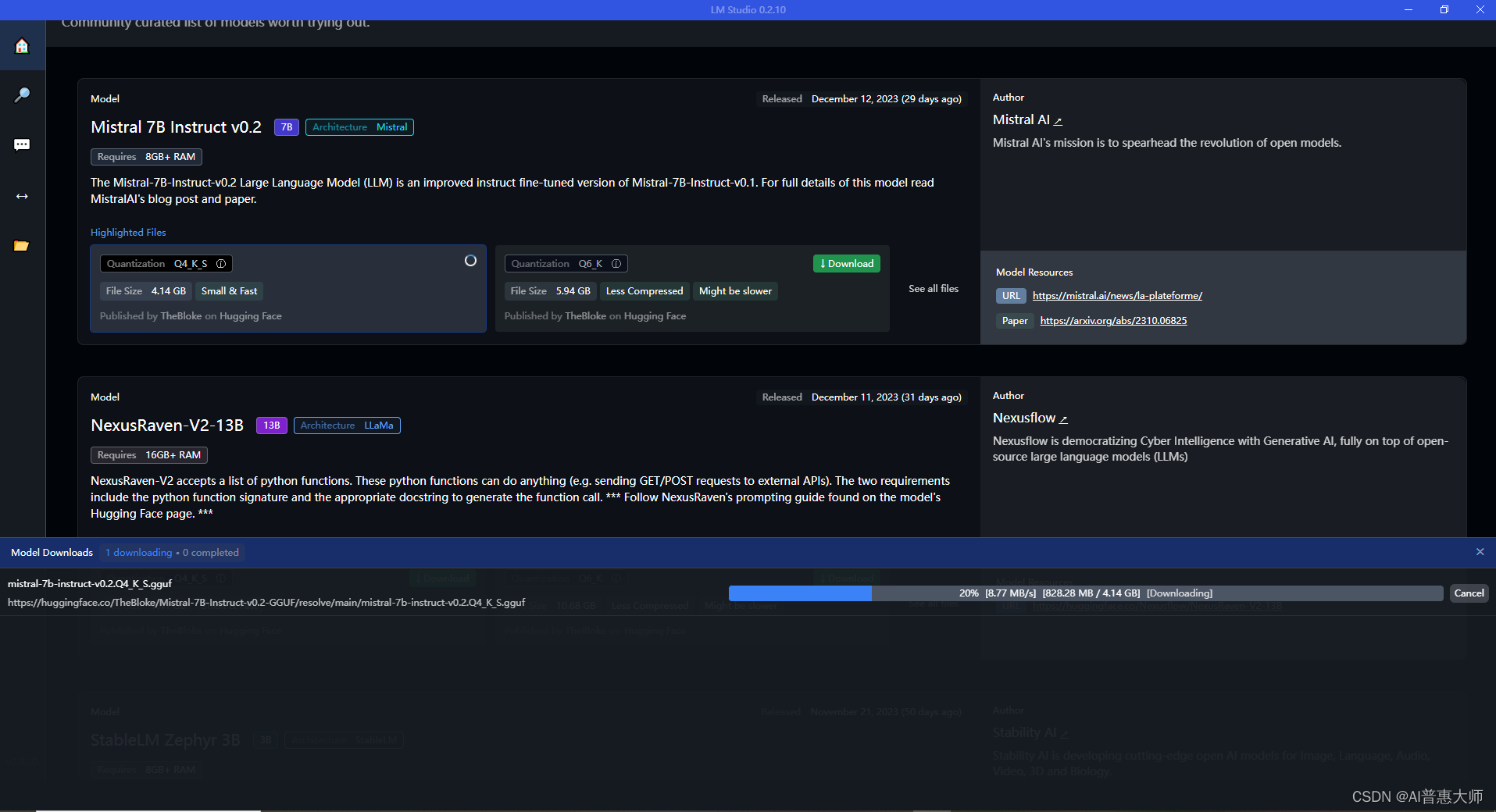

这种部署比较容易,我们通过Huggface,或者魔搭平台(ModelScope)下载对应的模型,然后通过python的虚拟环境就可以快速的部署大语言模型。相比之下这样的部署没多大意义,因为通用大语言模型目前很多都是免费开放的,可以直接使用,所以建议使用大厂免费的服务直接使用。

二、对大语言模型进行全量调参

这种模式如果做好了,最终效果最好,但是其代价也是最高的,毕竟一般的大模型的参数动辄都是以“十亿”为计量单位,如果需要调参,需要大量的原始数据且要对数据进行标准化,因为数据质量直接影响大模型的最终效果。并且在训练的时候需要的硬件成本也是非常的高。所以该方法不是大厂基本不建议使用

三、结合本地知识库部署大语言模型

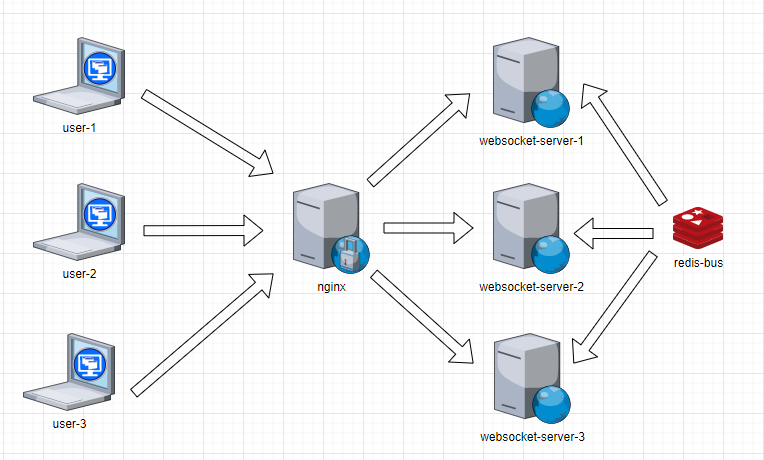

这种模式是使用的大语言模型对本地知识库内容的总结归纳能力,比如,我们本地文档特别多,但是我们的问题来自多个文档,获得数据比较零散,我们需要通过大语言模型对零散的知识进行归类总结。常用的方法 LangChain + chromadb + 大模型 ,这类方法比较适合企业存在大量的零散知识文档,我们的问题通常基于多个文档内容的,使用大模型的能力对找到的内容进行总结提升。

四、微调大语言模型

这种模式也比较适合搭建本地知识库,其原理是使用lora在大语言模型transformer的神经网络基础上,训练一个旁路网,本地问题可以通过旁路网络进行回答,效果较好。

ps:训练旁路网络的意义:因为预训练的大语言模型本身数据量较大,如果将本地一些知识放入大语言模型神经网络中,其实对大语言模型影响较小(毕竟数据量较少),所以我们考虑训练一个旁路网络,这样权重就在新的旁路网络中实现,可以实现堪比全量调参的效果