请解释TensorFlow中的占位符(Placeholder)和它们的作用。

在TensorFlow 1.x版本中,占位符(Placeholder)是一个非常重要的概念。占位符是一个特殊的操作,它表示计算图中的一个位置,这个位置将在运行时被实际的数据所替代。换句话说,占位符允许我们定义计算图的结构,而不必立即提供所有输入数据。

占位符的主要作用如下:

动态输入数据:在构建计算图时,我们通常不知道所有输入数据的具体值。占位符允许我们在运行时动态地提供这些输入数据。这使得TensorFlow模型能够处理不同大小和形状的数据集。

定义输入接口:占位符是模型输入数据的接口。当我们在TensorFlow中构建模型时,我们需要定义哪些变量是模型的参数(通过tf.Variable),哪些变量是模型的输入(通过tf.placeholder)。这样,在训练或评估模型时,我们可以将实际的数据通过占位符传递给模型。

配合会话(Session)使用:在TensorFlow 1.x中,计算图是在会话中运行的。当运行会话时,我们需要通过feed_dict参数将实际数据传递给占位符。这样,数据就可以被计算图使用,并参与到计算过程中。

例如,以下是一个简单的TensorFlow 1.x代码片段,展示了如何使用占位符:

import tensorflow as tf

# 定义占位符,用于输入数据和标签

x = tf.placeholder(tf.float32, shape=[None, 784]) # 假设输入是784维的向量

y = tf.placeholder(tf.float32, shape=[None, 10]) # 假设有10个类别的标签

# 定义模型的其他部分(例如权重、偏置项、计算层等)

# ...

# 定义损失函数和优化器

loss = ...

optimizer = tf.train.AdamOptimizer().minimize(loss)

# 初始化变量

init = tf.global_variables_initializer()

# 创建会话并运行图

with tf.Session() as sess:

sess.run(init)

# 在这里,我们传入实际的数据到占位符中

for epoch in range(num_epochs):

for batch_x, batch_y in data_iterator:

_, loss_value = sess.run([optimizer, loss], feed_dict={x: batch_x, y: batch_y})

# 评估模型时,同样需要传入数据到占位符中

predictions = sess.run(some_output_tensor, feed_dict={x: test_data})

在上面的代码中,x和y是占位符,它们表示模型的输入数据和目标标签。在训练循环中,我们通过feed_dict参数将实际的数据传递给这些占位符。

然而,在TensorFlow 2.x中,由于启用了即时执行(Eager Execution)模式,占位符的概念被弃用。在TensorFlow 2.x中,我们可以直接使用Python变量和函数来定义和调用模型,而无需显式地创建占位符和会话。这使得代码更加直观和易于调试。但是,理解TensorFlow 1.x中的占位符对于理解TensorFlow的计算图模型和历史发展仍然是有帮助的。

如何使用TensorFlow构建和训练一个简单的神经网络模型?

在TensorFlow中构建和训练一个简单的神经网络模型可以通过几个关键步骤完成。下面是一个基本的示例,展示了如何使用TensorFlow 2.x(推荐版本)来构建和训练一个简单的神经网络模型用于分类任务。

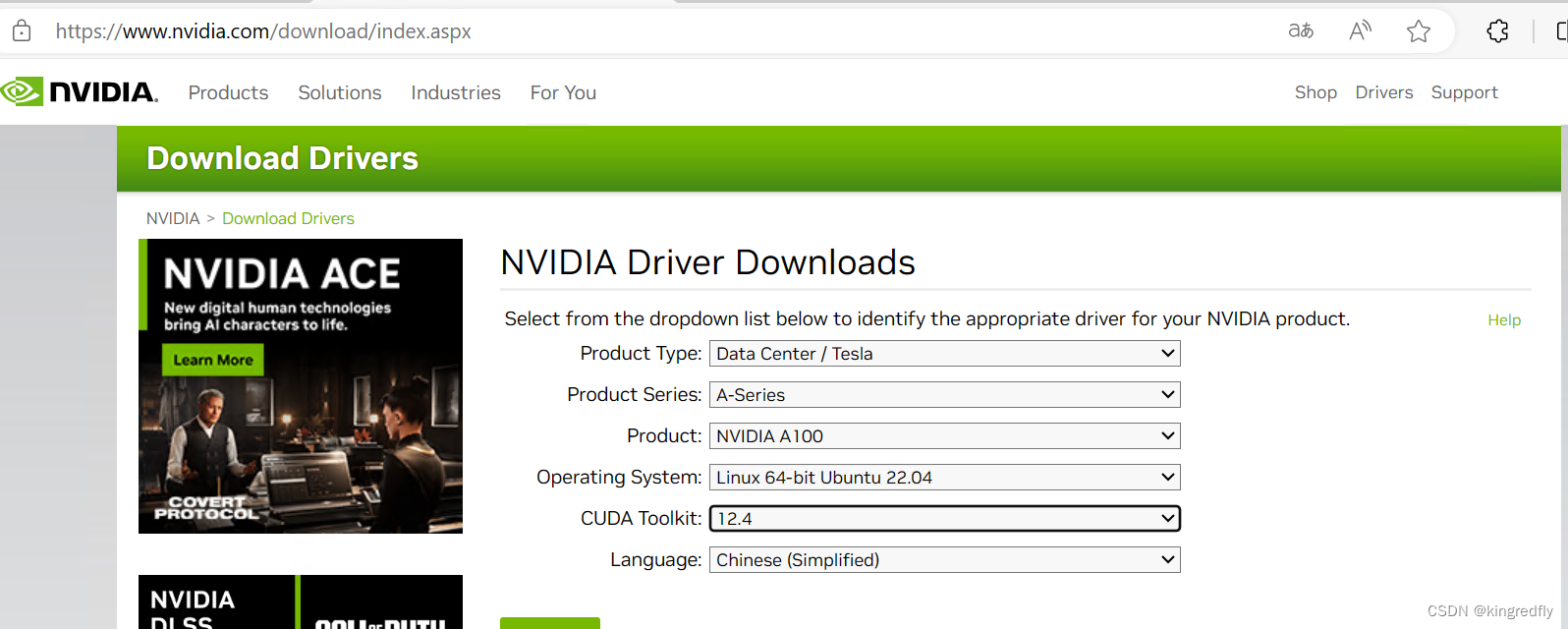

首先,确保你已经安装了TensorFlow 2.x。你可以通过pip来安装:

pip install tensorflow

接下来,我们将使用TensorFlow构建一个简单的全连接神经网络模型来解决分类问题。这里以MNIST手写数字分类任务为例。

python

import tensorflow as tf

from tensorflow.keras import datasets, layers, models

# 加载MNIST数据集

(train_images, train_labels), (test_images, test_labels) = datasets.mnist.load_data()

# 将像素值缩放到0到1之间

train_images, test_images = train_images / 255.0, test_images / 255.0

# 构建模型

model = models.Sequential()

model.add(layers.Flatten(input_shape=(28, 28))) # 将28x28的图像展平

model.add(layers.Dense(128, activation='relu')) # 添加一个全连接层,128个神经元,使用ReLU激活函数

model.add(layers.Dense(10)) # 输出层,10个神经元(对应10个数字类别)

# 编译模型

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

# 训练模型

model.fit(train_images, train_labels, epochs=5)

# 评估模型

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print('\nTest accuracy:', test_acc)

在这个例子中,我们使用了Sequential模型,它是一个线性堆叠层的简单模型。我们添加了一个Flatten层来将28x28的图像展平,然后添加了一个具有128个神经元和ReLU激活函数的全连接层,最后是一个输出层,有10个神经元(因为我们有10个数字类别)。

编译模型时,我们指定了优化器(这里是adam)、损失函数(SparseCategoricalCrossentropy,因为我们使用的是整数标签而不是one-hot编码)以及评估指标(这里是准确率)。

model.fit函数用于训练模型。我们传入训练数据和标签,并指定训练的轮数(epochs)。

最后,我们使用model.evaluate来评估模型在测试集上的性能。

这只是一个非常基础的例子。在实际应用中,你可能需要调整网络结构(比如添加更多的层、改变神经元的数量或使用不同的激活函数),调整训练参数(比如学习率、批次大小或训练轮数),以及使用更复杂的优化器和损失函数。此外,你还可以使用诸如数据增强、正则化、早停等技术来防止过拟合,以及使用模型保存和加载功能来持久化模型。

![[开源] 基于transformer的时间序列预测模型python代码](https://img-blog.csdnimg.cn/direct/78027b0756f34233a336a2dd518c5f43.png)